mask2former专题

mask2former利用不确定性采样点选择提高模型性能

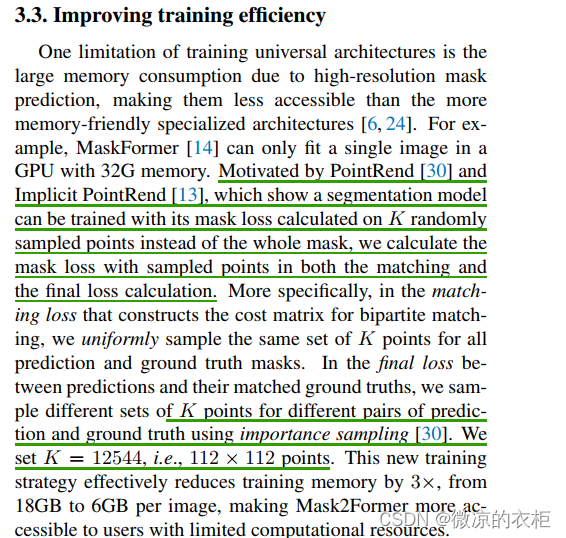

在机器学习和深度学习的训练过程中,不确定性高的点通常代表模型在这些点上的预测不够可靠或有较高的误差。因此,关注这些不确定性高的点,通过计算这些点的损失并进行梯度更新,可以有效地提高模型的整体性能。确定性高的点预测结果已经比较准确,相应地对模型的训练贡献较小,所以可以减少对这些点的关注或完全忽略它们的损失计算。 代码复现参考仓库:https://github.com/NielsRogge/Tra

Mask2former代码详解

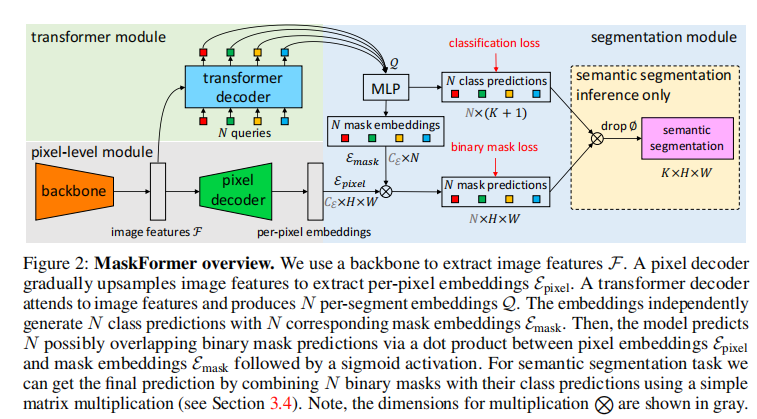

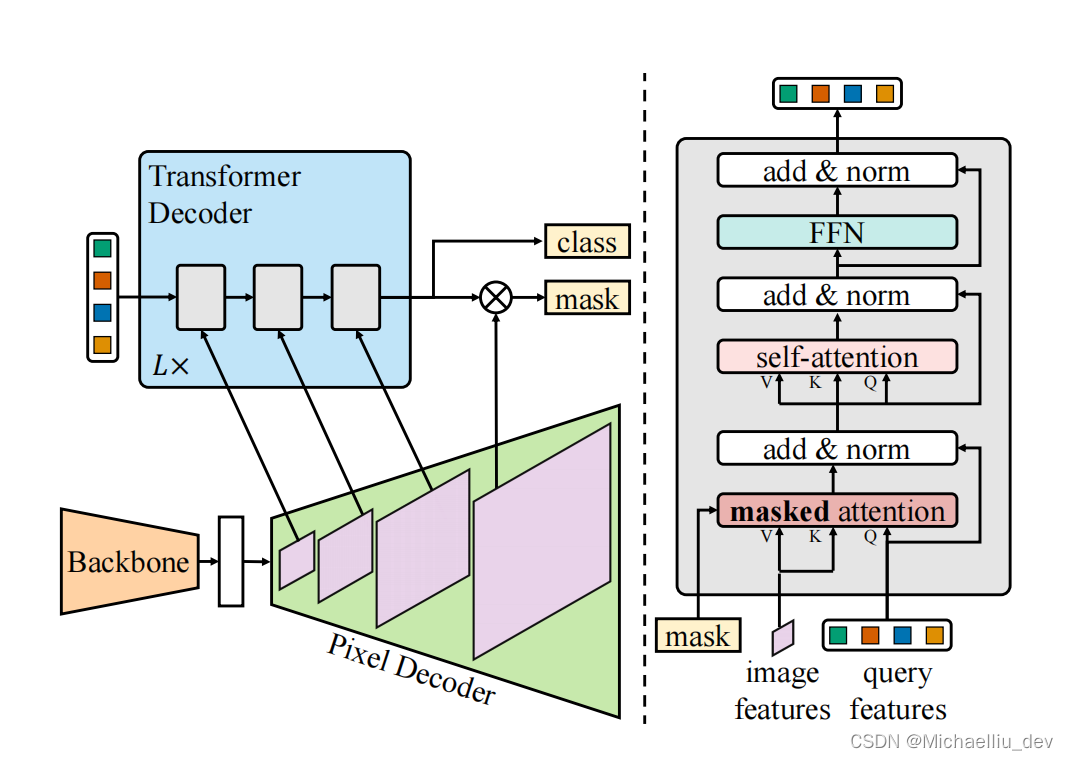

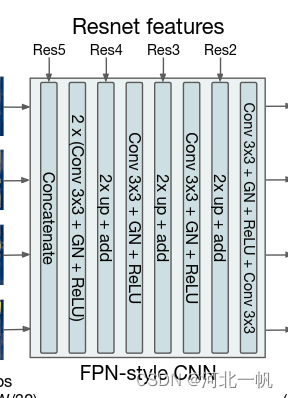

1.整体流程 Mask2former流程如图所示,对于输入图片,首先经过Resnet等骨干网络获得多层级特征,对于获得的多层级特征,一个方向经过pixel decoder(基于DetrTransformerEncoderLayer)得到per-pixel embedding,另外一个方向经过transformer decoder,得到mask embedding,矩阵乘法得到ma

《Mask2Former》算法详解

文章地址:《Masked-attention Mask Transformer for Universal Image Segmentation》 代码地址:https://github.com/facebookresearch/Mask2Former 文章为发表在CVPR2022的一篇文章。从名字可以看出文章像提出一个可以统一处理各种分割任务(全景分割、语义分割、实例分割)的网络。 这里稍微

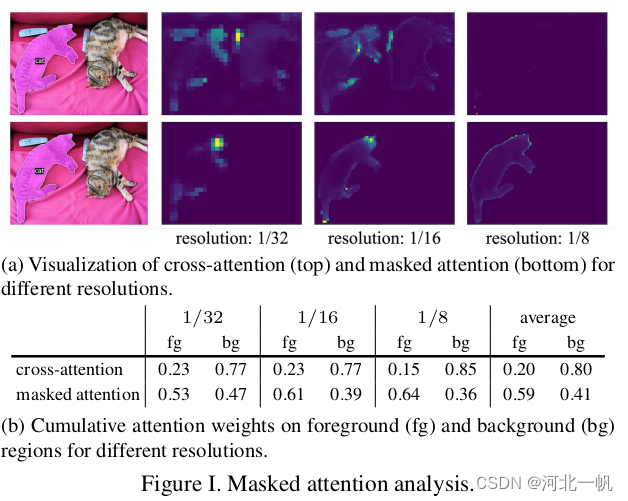

从DETR到Mask2Former(3):masked attention的attention map可视化

Mask2Former的论文中有这样一张图,表示masked attenion比cross attention效果要好 那么这个attention map是怎么画出来的? 在mask2attention的源代码中 CrossAttentionLayer这个类中,在forward_post函数中做如下修改: def forward_post(self, tgt, memory,me

从DETR到Mask2Former(1):DETR-segmentation结构全解析

网上关于DETR做的detection的解析很多,但是DETR做Segmentation的几乎没有,本文结合DETR的论文与代码,对DETR做一个详细的拆解。理解DETR是理解Mask2Former的基础。 首先得把DETR-segmentation给run起来。Github上DETR的repository,下载了也只能run起来detection,run不起来segmentation功能,但还

利用MMSegmentation微调Mask2Former模型

前言 本文介绍了专用于语义分隔模型的python库mmsegmentation,github项目地址,运行环境为Kaggle notebook,GPU为P100针对环境配置、预训练模型推理、在西瓜数据集上微调新sota模型mask2former模型,数据说明由于西瓜数据集较小,我们最后在组织病理切片肾小球数据集上微调了mask2former模型,数据说明该教程有部分参考github项目MMSeg