inputformat专题

大数据技术之_05_Hadoop学习_02_MapReduce_MapReduce框架原理+InputFormat数据输入+MapReduce工作流程(面试重点)+Shuffle机制(面试重点)

大数据技术之_05_Hadoop学习_02_MapReduce 第3章 MapReduce框架原理3.1 InputFormat数据输入3.1.1 切片与MapTask并行度决定机制3.1.2 Job提交流程源码和切片源码详解3.1.3 FileInputFormat切片机制3.1.4 CombineTextInputFormat切片机制3.1.5 CombineTextInputForma

InputFormat的作用

InputFormat: 从文件中读取数据,转化成key-value格式。 对于常用的数据类型,hadoop已经有了这个接口的实现。 特殊文件格式的话,只有你自己知道怎么读取这种文件格式,你可以自己来定义。 method: 1. get InputSplit 框架调用此方法获得有几个逻辑块, 这样就知道需要多少个mapper了, 数据产生地点产生Mapper的实例。 2.c

MapReduce数据输入中InputFormat类源码解析

http://www.iteblog.com/archives/1407 在MapReduce作业中的数据输入和输出必须使用到相关的InputFormat和OutputFormat类,来指定输入数据的格式,InputFormat类的功能是为map任务分割输入的数据。 InputFormat类中必须指定Map输入参数Key和Value的数据类型,以及对输入的数据如何进行分割。我们

MapReduce的自定义inputFormat(合并小文件)

需求 无论hdfs还是mapreduce,对于小文件都有损效率,实践中,又难免面临处理大量小文件的场景,此时,就需要有相应解决方案 分析(小文件的优化无非以下几种方式:) 1、 在数据采集的时候,就将小文件或小批数据合成大文件再上传HDFS 2、 在业务处理之前,在HDFS上使用mapreduce程序对小文件进行合并 3、 在mapreduce处理时,可采用combineInputFormat提

学习笔记 - Hadoop InputFormat 浅谈

在执行一个Job的时候,Hadoop会将输入数据划分成N个Split,然后启动相应的N个Map程序来分别处理它们。 数据如何划分?Split如何调度(如何决定处理Split的Map程序应该运行在哪台TaskTracker机器上)?划分后的数据又如何读取?这就是本文所要讨论的问题。 先从一张经典的MapReduce工作流程图出发: 1、运行mapred程序; 2、本次运行将生成一个Job,于是Job

MapReduce高级编程之自定义InputFormat

InputFormat是MapReduce中一个很常用的概念,它在程序的运行中到底起到了什么作用呢? InputFormat其实是一个接口,包含了两个方法: public interface InputFormat<K, V> { InputSplit[] getSplits(JobConf job, int numSplits) throws IOException; Recor

大数据【五十四】【转】Hadoop系列之InputFormat,OutputFormat用法

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。 本文链接:https://blog.csdn.net/u011734144/article/details/60773786 -----------------------------------------------------------------------------------

大数据【五十六】【转】自定义 hadoop MapReduce InputFormat 切分输入文件

一、原理: InputFormat是MapReduce中一个很常用的概念,它在程序的运行中到底起到了什么作用呢? InputFormat其实是一个接口,包含了两个方法: public interface InputFormat<K, V> {InputSplit[] getSplits(JobConf job, int numSplits) throws IOException;Record

hadoop中inputFormat类

org.apache.hadoop.mapreduce.InputFormat 是一个抽象类, 关于这个抽象类的功能描述如下: 1、首先为Job验证输入; 2、将输入的文件分成逻辑上的splits,每个split会被应用到一个单独的mapper上; 3、提供RecorderReader的实现,用来从逻辑split中一点一点的收集数据到mapper中。 这个抽象类中,有两个抽象

Hive自定义分隔符InputFormat

Hive默认创建的表字段分隔符为:\001(ctrl-A),也可以通过 ROW FORMAT DELIMITED FIELDS TERMINATED BY 指定其他字符,但是该语法只支持单个字符,如果你的分隔符是多个字符,则需要你自定义InputFormat来实现,本文就以简单的示例演示多个字符作为分隔符的实现。 [一]、开发环境 Hadoop 2.2.0Hive 0.12.0Java1.6+M

自定义InputFormat和OutputFormat案例

一、自定义InputFormat InputFormat是输入流,在前面的例子中使用的是文件输入输出流FileInputFormat和FileOutputFormat,而FileInputFormat和FileOutputFormat它们默认使用的是继承它们的子类TextInputFormat和TextOutputFormat,以Text的方式去读取数据。 当我们遇到许多小文件,要将他们

HIVE 处理日志,自定义inputformat 完整版

网上找了很多材料都是写了部份代码的,今天在峰哥的帮助下实现了此功能。 为何要设置此功能是由于 hive fields terminated by '||||' 不支持 字符串导致 将你的inputformat类打成jar包,如MyInputFormat.jar 将MyInputFormat.jar放到 hive/lib里,然后就可以建表了 假设你的inputFormat类路径是com.

【Hadoop】5.MapReduce框架原理-自定义InputFormat

说明 自定义InputFormat一般应用于hadoop自带的InputFormat类型不能满足某个应用场景中,需要我们自定义来解决 自定义步骤 自定义Inputformat步骤如下: 自定义一个类继承InputFormat改写RecordReader,实现一次读取一个完成的文件封装为KV在输出时使用SequenceFileOutPutFormat输出合并文件SequenceFile文件

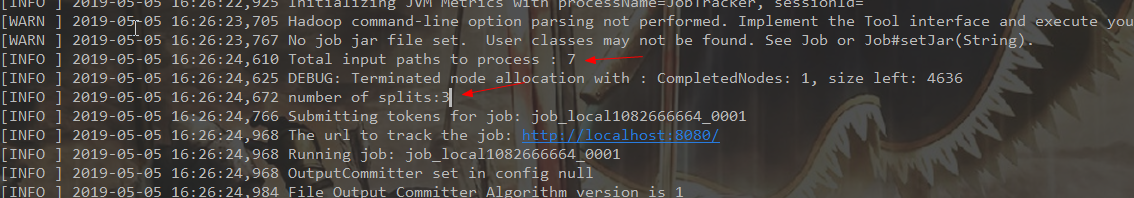

【Hadoop】4.MapReduce框架原理-InputFormat数据输入

InputFormat数据输入 切片与MapTask并行度决定机制 MaskTask的并行度决定Map阶段的任务处理并发度,进而影响整个job的处理速度。在这里并不是MapTask越多越好,也不是越少越好。 首先说一下MapTak并行决定机制: 一个Job的Map阶段并行度由客户端提交Job时的切片数决定的每一个Split切片分配一个MapTask并行实例处理默认情况下,切片大小=Bloc