hf专题

关于 export HF_ENDPOINT=https://hf-mirror.com

# 使用 Hugging Face Hub 镜像:设置和应用场景 ## 引言 Hugging Face 是一个流行的机器学习模型托管平台,它提供了大量的预训练模型和易于使用的API。为了提高访问速度和降低延迟,Hugging Face 提供了镜像服务,用户可以通过设置环境变量 `HF_ENDPOINT` 来指定使用特定的镜像地址。本文将介绍如何设置 `HF_ENDPOINT` 环境变量,并探讨

btstack协议栈实战篇--HFP HF - Hands-Free

btstack协议栈---总目录_bt stack是什么-CSDN博客 目录 1.Main Application Setup 2.hci_packet_handler 3.hfp_hf_packet_handler 4.log信息 这个HFP免提示例演示了如何从远程HFP音频网关(AG),并且如果定义了HAVE BTSTACK STDIN,如何控制HFP A

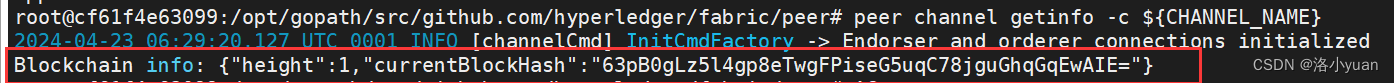

分步搭建HF区块链网络--部署fabric区块链--加入channel

一.搭建网络规划 采用容器环境,搭建1个排序节点(Orderer)、2个对等节点(Peer),另外用 一个fabric-cli容器。实训中的绝大部分命令是通过该容器执行的。 容器名称设置 二. 配置HF网络证书 首先docker ps 检查镜像,确保镜像为空 1.生成crypto-config.yaml 使用showtemplate显示默认配置信息,并重定向保存到confi

分步搭建HF区块链网络

一.搭建网络规划 采用容器环境,搭建1个排序节点(Orderer)、2个对等节点(Peer),另外用 一个fabric-cli容器。实训中的绝大部分命令是通过该容器执行的。 容器名称设置 二. 配置HF网络证书 首先docker ps 检查镜像,确保镜像为空 1.生成crypto-config.yaml 使用showtemplate显示默认配置信息,并重定向保存到confi

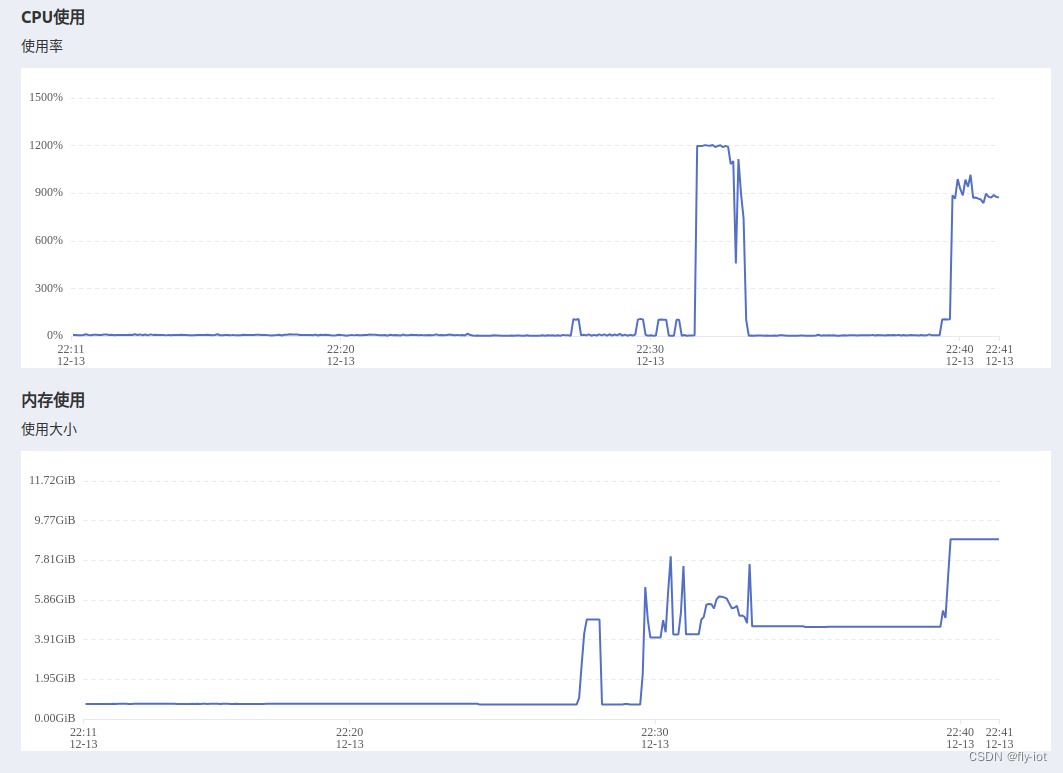

Trl SFT: llama2-7b-hf使用QLora 4bit量化后ds zero3加上flash atten v2单机多卡训练(笔记)

目录 一、环境 1.1、环境安装 1.2、安装flash atten 二、代码 2.1、bash脚本 2.2、utils.py 注释与优化 2.3、train.py 注释与优化 2.4、模型/参数相关 2.4.1、量化后的模型 2.4.1.1 量化后模型结构 2.4.1.2 量化后模型layers 2.4.2

《HF经理》:二认知误区

一、管理者掌握重要权力: 二、全力来自管理者的职位: 三、管理者必须控制自己的直接下属: 对策:展示自己的品质,能力和影响力 四、管理者必须建立良好的个人关系: 五、管理这必须确保一切运行正常:

Trl: llama2-7b-hf使用QLora 4bit量化后ds zero3加上flash atten v2单机多卡训练(笔记)

目录 一、环境 1.1、环境安装 1.2、安装flash atten 二、代码 2.1、bash脚本 2.2、utils.py 注释与优化 2.3、train.py 注释与优化 2.4、模型/参数相关 2.4.1、量化后的模型 a) 量化后模型结构 b) 量化后模型layers 2.4.2、参数

huggingface学习 | 云服务器使用hf_hub_download下载huggingface上的模型文件

系列文章目录 huggingface学习 | 云服务器使用git-lfs下载huggingface上的模型文件 文章目录 系列文章目录一、hf_hub_download介绍二、找到需要下载的huggingface文件三、准备工作及下载过程四、全部代码 一、hf_hub_download介绍 hf_hub_download是huggingface官方支持(Downloa

【candle】(2):使用hf-mirror镜像下载TheBloke/Llama-2-7B-GGML的q4_0.bin文件,并设置HF_HOME,example模块可以识别下载的模型

1,视频演示地址 https://www.bilibili.com/video/BV1Dc41117wT/?vd_source=4b290247452adda4e56d84b659b0c8a2 【candle】(2):使用hf-mirror镜像下载TheBloke/Llama-2-7B-GGML的q4 2,安装rust到其他目录 默认的安装模式: curl --proto

Triton + HF + Qwen 推理经验总结

1. 简介 Triton介绍参考:GitHub - triton-inference-server/tutorials: This repository contains tutorials and examples for Triton Inference Server 2. 实现方案 2.1. docker部署 # 拉取docker镜像git clone -b r23.10 http

通往AGI的大模型MultiAgent的RL是对的但HF有上限

OpenAI高管Mira Murati周三告诉员工,一封关于AI取得突破的信件促使董事会采取了解雇行动。一位消息人士透露,OpenAI在Q*项目上取得了进展,内部人士认为这可能是OpenAI在超级智能领域的突破。这名消息人士称,虽然Q*的数学成绩只是小学生的水平,但在测试中取得优异成绩让研究人员对它未来的成功非常乐观 有人说:奥特曼不用斯派修姆光线把解雇他的OpenAI给消灭吗? 人类终将

通往AGI的大模型MultiAgent的RL是对的但HF有上限

OpenAI高管Mira Murati周三告诉员工,一封关于AI取得突破的信件促使董事会采取了解雇行动。一位消息人士透露,OpenAI在Q*项目上取得了进展,内部人士认为这可能是OpenAI在超级智能领域的突破。这名消息人士称,虽然Q*的数学成绩只是小学生的水平,但在测试中取得优异成绩让研究人员对它未来的成功非常乐观 有人说:奥特曼不用斯派修姆光线把解雇他的OpenAI给消灭吗? 人类终将

【HF-Net】From Coarse to Fine Robust Hierarchical Localization at Large Scale

Abstract 稳健和准确的视觉定位是许多应用的基本能力,如自动驾驶、移动机器人或增强现实。然而,这仍然是一项具有挑战性的任务,**特别是对于大规模环境和外观发生重大变化的情况。现有技术的方法不仅难以应对这些场景,而且对于某些实时应用程序来说往往过于资源密集。**在本文中,我们提出了HFNet,这是一种基于单片CNN的分层定位方法,它同时预测局部特征和全局描述符,以实现精确的6-DoF

decapoda-research/llama-7b-hf 的踩坑记录

使用transformers加载decapoda-research/llama-7b-hf的踩坑记录。 ValueError: Tokenizer class LLaMATokenizer does not exist or is not currently imported. 解决办法: https://github.com/huggingface/transformers/issues/2

特别活动丨HuggingFace工程师教你HF的正确打开方式

主题: HuggingFace的正确打开方式时间: 2022年12月15日(周四) 20:30-21:30 由北京智源人工智能研究院主办的2022大模型创新论坛正如火如荼进行中,论坛包含训练营、峰会、创业大赛、黑客马拉松、闭门研讨会、创新应用榜单6个环节,邀请关注AI大模型技术与应用创新的研究员、产业专家、创业者、投资人、学生共同参与,围绕当前学术、产业、投资、公众、媒体等最关注的相关话题展开讨