grounded专题

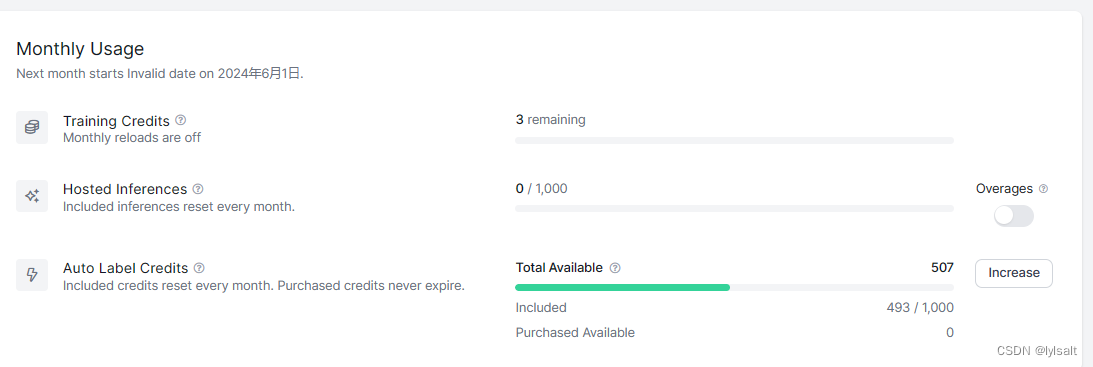

Grounded-Segment-Anything实现自动文本标注

项目地址:IDEA-Research/Grounded-Segment-Anything: Grounded-SAM: Marrying Grounding-DINO with Segment Anything & Stable Diffusion & Recognize Anything - Automatically Detect , Segment and Generate Anything

EMNLP 2020 BiST: Bi-directional Spatio-Temporal Reasoning for Video-Grounded Dialogues

动机 基于视频的对话是非常具有挑战性的,这是因为(i)包含空间和时间变化的视频的复杂性,以及(ii)用户在视频或者多个对话轮中查询不同片段和/或不同目标的话语的复杂性。然而,现有的基于视频的对话方法往往关注于表面的时间级视觉线索,而不是从视频中获取更细粒度的空间信号。作者的方法旨在通过双向推理框架从视频中检索细粒度信息来挑战基于视频的对话来解决这一问题。与视频对话相关的任务是视频问答和视频c

ACL 2020 Video-Grounded Dialogues with Pretrained Generation Language Models

动机 预训练好的语言模型在改善各种下游NLP任务方面已显示出显著的成功,这是由于它们能够在文本数据中建立依赖关系和生成自然反应。本文利用预训练好的语言模型来提高视频对话的效果。基于Transformer的预训练好的语言模型的神经结构已经被用来学习视觉-文本NLP任务的跨模态表征。它可以应用于捕捉不同类型输入模式(文本和图像)之间的各种依赖关系,并具有适当的客观损失函数。这些模型的多头attent

AAAI 2021 Structured Co-reference Graph Attention for Video-grounded Dialogue

动机 基于视频的对话系统(VGDS)允许AI引擎“观察”((即理解一个视频)和“对话”(即,在一个对话中交流理解)。具体地说,给定一个视频,由一系列QA对组成的对话历史,以及一个关于视频的后续问题,目标是推断一个自由形式的自然语言回答问题。近年来,基于视频的对话系统被提出来推进VQA以基于视频与人类进行有意义的对话。虽然最近的努力在提高反应的质量方面取得了很大的进展,但业绩仍然远远不能令人满意。

论文阅读-(GLIP)Grounded Language-Image Pre-training (目标检测+定位)

Paper:Grounded Language-Image Pre-training Code:https://github.com/microsoft/GLIP 简介: 定位任务与图像检测任务非常类似,都是去图中找目标物体的位置,目标检测为给出一张图片找出bounding box,定位为给出一个图片和文本,根据文本找出物体。GLIP 模型统一了目标检测(object detection)

Grounded-Segment-Anything本地部署

Grounded-Segment-Anything本地部署 1.本地部署源码1.1 克隆源码1.2 下载初始参数 2. 创建虚拟环境3. 测试相关文件3.1 运行`grounding_dino_demo.py`文件3.2 运行`grounded_sam_demo.py`文件3.3 运行`grounded_sam_simple_demo.py`文件3.4 `grounded_sam_inpai