gradients专题

论文翻译 BING: Binarized Normed Gradients for Objectness Estimation at 300fps

BING: Binarized Normed Gradients for Objectness Estimation at 300fps Ming-Ming Cheng, Ziming Zhang, Wen-Yan Lin, Philip Torr, IEEE CVPR, 2014 基于二值化赋范梯度特征的一般对象估计 摘要: 通过训练通用的对象估计方法来产生一组候选对象窗口,能够加速传

Histograms of Oriented Gradients (HOG)描述子理解

HOG descriptors 是应用在计算机视觉和图像处理领域,用于目标检测的特征描述器。这项技术是用来计算局部图像梯度的方向信息的统计值。这种方法跟边缘方向直方图(edge orientation histograms)、尺度不变特征变换(scale-invariant feature transform descriptors) 以及形状上下文方法( shape contexts)有很

2013_CVPR_BoF meets HOG Feature Extraction based on Histograms of Oriented p.d.f Gradients for Imag

最近看到一篇较新的基于BOF的改进的特征提取算法,来自cvpr'2013,从大的方面来讲,这篇paper的算法改进主要包括以下几个方面: 1.BOF算法采用把特征映射到word上达到降维的目的,然后统计图像的word直方图,这篇文献采用计算特征的pdf(概率密度函数)的方法获得特征的表达,其中计算pdf采用KDE(核密度估计)的算法。一幅图像用一个pdf来表示。 2.求pdf的梯度:对p

论文学习 Generative Modeling by Estimating Gradients of the Data Distribution

论文学习 Generative Modeling by Estimating Gradients of the Data Distribution 前言前情提要分数匹配朗格文动力学 核心问题流形假设产生的问题 文章的解决方案 前言 个人认为,这篇Song Yang大佬的文章虽然被网上很多人吹,然而我们还是应该避免捧杀,认真了解一下其文章的内容和思想,以及试图理解他是如何想到这种思

TensorFlow梯度求解tf.gradients

import tensorflow as tf w1 = tf.Variable([[1,2]]) w2 = tf.Variable([[3,4]]) res = tf.matmul(w1, [[2],[1]]) grads = tf.gradients(res,[w1]) with tf.Session() as sess: tf.global_variables_initiali

猫头虎分享已解决Bug || ValueError: No gradients provided for any variable

博主猫头虎的技术世界 🌟 欢迎来到猫头虎的博客 — 探索技术的无限可能! 专栏链接: 🔗 精选专栏: 《面试题大全》 — 面试准备的宝典!《IDEA开发秘籍》 — 提升你的IDEA技能!《100天精通鸿蒙》 — 从Web/安卓到鸿蒙大师!《100天精通Golang(基础入门篇)》 — 踏入Go语言世界的第一步!《100天精通Go语言(精品VIP版)》 — 踏入Go语言世界的第二步!

Tensorflow利用函数修饰符@tf.custom_gradients自定义函数梯度

Tensorflow学习笔记(1) 利用函数修饰符@tf.custom_gradients自定义函数梯度_寂乐居士的博客-CSDN博客_tf.custom_gradientpython中的修饰符以及@tf.custom_gradient用法_Huang_Fj的博客-CSDN博客 tf.custom_gradient | TensorFlow Core v2.3.0

Achieving High Accuracy with PINNs via Energy Natural Gradients

论文阅读:Achieving High Accuracy with PINNs via Energy Natural Gradients Achieving High Accuracy with PINNs via Energy Natural Gradients问题自然梯度现有方法总结方法提出H-NG 和 E-NG 的复杂性 实验结果方法描述泊松问题高维度的例子热方程深度里兹法的非线性示例

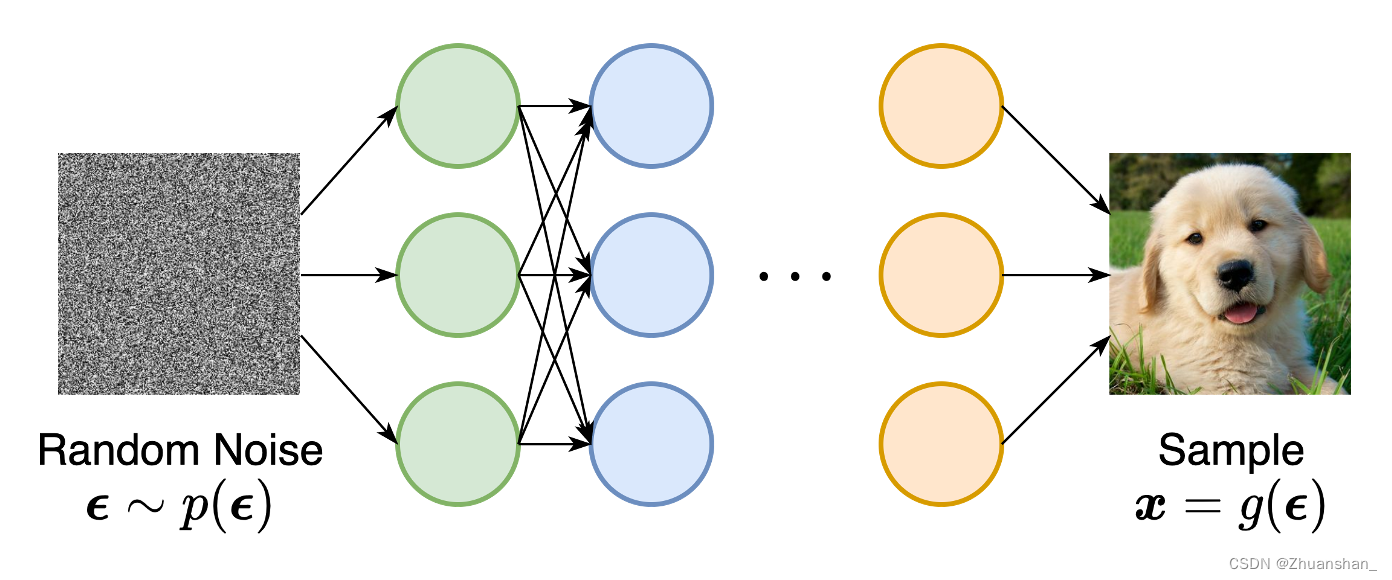

Re8 Generative Modeling by Estimating Gradients of the Data Distribution

宋扬博士的作品,和DDPM同属扩散模型开创工作,但二者的技术路线不同 Introduction 当前生成模型主要分成两类 基于似然模型 通过近似最大似然直接学习分布的概率密度,如VAE 隐式生成模型 概率分布由其抽样过程的模型隐式表示,如GAN GAN隐式表示了生成器网络可以产生的所有对象的分布。 二者的局限:基于似然的模型需要对模型架构进行严格限制,以确保似然计算的可处理性;而隐

Axiomatic Attribution for Deep Networks (Integrated Gradients) 论文阅读笔记

Axiomatic Attribution for Deep Networks 会议:ICLR 时间:2017年 本文首先提出两个可解释性模型的基本公理(fundamental axioms),敏感性(Sensitivity)和实现不变性(Implementation Invariance)。之后提出一个全新的可解释性算法积分梯度(Integrated Gradients),能有效解决现有梯度

[论文阅读] 2019 NeurIPS - Generative modeling by estimating gradients of the data distribution

📑[阅读笔记]Generative modeling by estimating gradients of the data distribution 本文创造性的使用积分函数来学习训练数据的分布,并提出sliced score matching解决了传统score matching中存在的性能问题。 🙋♂️张同学 📧zhangruiyuan@zju.edu.cn 有问题请联系我~

执行 convolutional_network 时报No gradients provided for any variable

在学习Tensorflow 执行convolutional_network的脚本时 报,其他几个也一样 ValueError: No gradients provided for any variable, check your graph for ops that do not support gradients 将 tf.reduce_mean(tf.nn.softmax_cros

Lecture 7: Vanishing Gradients and Fancy RNNs

文章目录 梯度消失直觉具体的推导Why is vanishing gradient a problem?Why is exploding gradient a problem?Gradient clipping: solution for exploding gradient How to fix vanishing gradient problem?Long Short-Term Mem

![[论文阅读] 2019 NeurIPS - Generative modeling by estimating gradients of the data distribution](https://zhangruiyuan.oss-cn-hangzhou.aliyuncs.com/picGo/images/image-20211215211224364.png)