gpus专题

【论文分享】Graviton: Trusted Execution Environments on GPUs 2018’OSDI

目录 AbstractIntroductioncontributions BackgroundGPUSoftware stackHardwareContext and channel managementCommand submissionProgramming modelInitializationMemory allocationHost-GPU transfersKernel dis

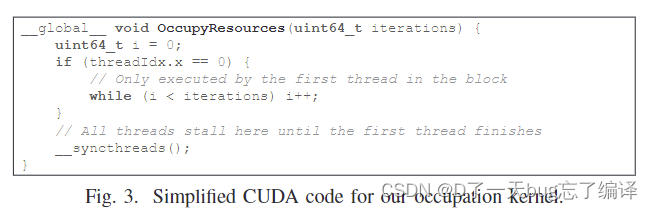

操作系统论文导读(二十):Making Powerful Enemies on NVIDIA GPUs

RTSS-2022: Making Powerful Enemies on NVIDIA GPUs 目录 一、文章核心 二、文章背景 背景介绍 干扰通道 研究问题 文章的创新点 方法论 三、必要知识与相关工作 A 背景知识 CUDA 基础 GPU 硬件 并发和干扰通道 干扰通道 SM 内部干扰通道 B 相关工作 CPU时间分析 GPU时间分析 GPU共享 四

docker创建容器时使用--gpus all报错解决

报错信息: docker: Error response from daemon: could not select device driver "" with capabilities: [[gpu]]. 解决方法: 我们在通过 --gpus 参数来使用宿主机的 GPU 时,需要先安装一个英伟达的容器运行时 1,任意路径下创建nvidia-container-runtime-scri

[linux] GPUS=${1:-4} 如果$1为空,则使用其后的默认值

这行代码GPUS=${1:-4}是一个Bash shell中的参数扩展语法,用于设置环境变量GPUS的值。 其中: $1表示传递给脚本的第一个位置参数。:-是一个参数扩展操作符,表示如果$1为空或未设置,则使用其后的默认值。4是默认值,如果没有传递位置参数或$1为空,则GPUS的值会被设置为4。 因此,这行代码的作用是: 1..如果在运行脚本时提供了位置参数(如script.shsh8)并

Chart 6 Adreno GPUs内核优化建议

文章目录 前言6.1 工作组性能优化6.1.1 获取最大工作组大小6.1.2 设定工作组大小6.1.3 影响最大工作组大小的因素6.1.4 没有屏障的内核(流模式, steaming mode)6.1.5 工作组大小和形状调优6.1.5.1 避免使用默认工作组大小6.1.5.2 工作组大小和性能6.1.5.3 工作组大小 fixed vs. dynamic6.1.5.4 1D/2D/3D k

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

Modeling Deep Learning Accelerator Enabled GPUs

Modeling Deep Learning Accelerator Enabled GPUs 发表在 ISPASS 2019 上。文章研究了 NVIDIA 的 Volta 和 Turing 架构中张量核的设计,并提出了 Volta 中张量核的架构模型。 基于 GPGPU-Sim 实现该模型,并且支持 CUTLASS 运行。发现其性能与硬件非常吻合,与 Titan V GPU 相比,获得了99.6

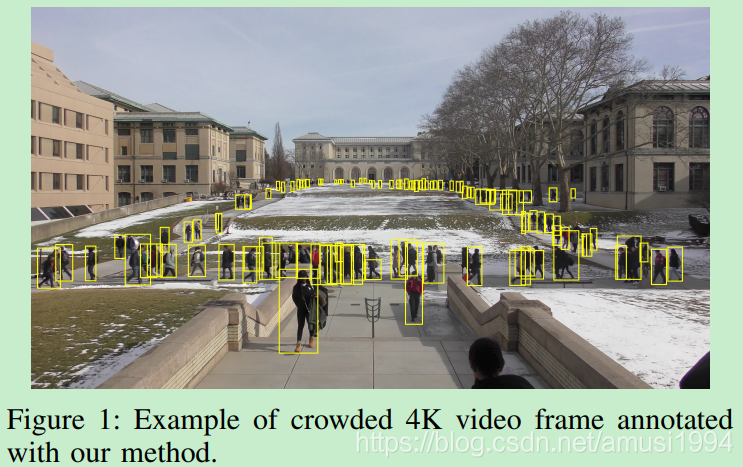

Fast and accurate object detection in high resolution 4K and 8K video using GPUs 论文笔记

文章目录 一、基本信息二、研究背景三、创新点3.1 概述3.2 详解3.2.1 问题分析3.2.2 Attention pipeline3.2.3 Implementation of the client-server version 四、实验结果五、结论与思考5.1 作者结论5.2 记录该工作的亮点,以及可以改进的地方 参考 一、基本信息 标题:《Fast and accur

Server - PyTorch Lighting Warning 的 seed_everything、gpus、max_epochs、checkpoint 等解决方案

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/132673146 PyTorch Lightning 是一个用于简化 PyTorch 代码的高级框架,可以帮助你快速构建、训练和部署深度学习模型。核心思想是将模型的逻辑和工程分离,只需要关注模型的核心部分,而不

![[linux] GPUS=${1:-4} 如果$1为空,则使用其后的默认值](/front/images/it_default.jpg)