glm4专题

vllm 部署GLM4模型进行 Zero-Shot 文本分类实验,让大模型给出分类原因,准确率可提高6%

文章目录 简介数据集实验设置数据集转换模型推理评估 简介 本文记录了使用 vllm 部署 GLM4-9B-Chat 模型进行 Zero-Shot 文本分类的实验过程与结果。通过对 AG_News 数据集的测试,研究发现大模型在直接进行分类时的准确率为 77%。然而,让模型给出分类原因描述(reason)后,准确率显著提升至 83%,提升幅度达 6%。这一结果验证了引入 reas

GLM4-9B-Chat模型LoRA微调

文本记录GLM4-9B-Chat模型进行LoRA微调的过程。 一、环境: 操作系统: Ubuntu 22.04CUDA: 12.1GPU: 3090 x 2 创建conda环境: conda create -n glm4 python=3.10.14conda activate glm4cd /home/data/chatglm4-finetune 二、数

GLM4-Chat-1M(号称可以输入200万字)的长文本测试结果(推理时间,推理效果)

GLM4-Chat-1M(号称可以输入200万字)的长文本测试结果(推理时间,推理效果) 测试方法 使用如下prompt,让模型提取小说(测试数据)中出现的人物名,数字表示用到的内容章节数目: test_f=['3-这游戏也太真实了.txt','6-这游戏也太真实了.txt','9-这游戏也太真实了.txt','20-这游戏也太真实了.txt','50-这游戏也太真实了.txt','10

【机器学习】GLM4-9B-Chat大模型/GLM-4V-9B多模态大模型概述、原理及推理实战

目录 一、引言 二、模型简介 2.1 GLM4-9B 模型概述 2.2 GLM4-9B 模型架构 三、模型推理 3.1 GLM4-9B-Chat 语言模型 3.1.1 model.generate 3.1.2 model.chat 3.2 GLM-4V-9B 多模态模型 3.2.1 多模态模型概述 3.2.2 多模态模型实践 四、总结 一、引

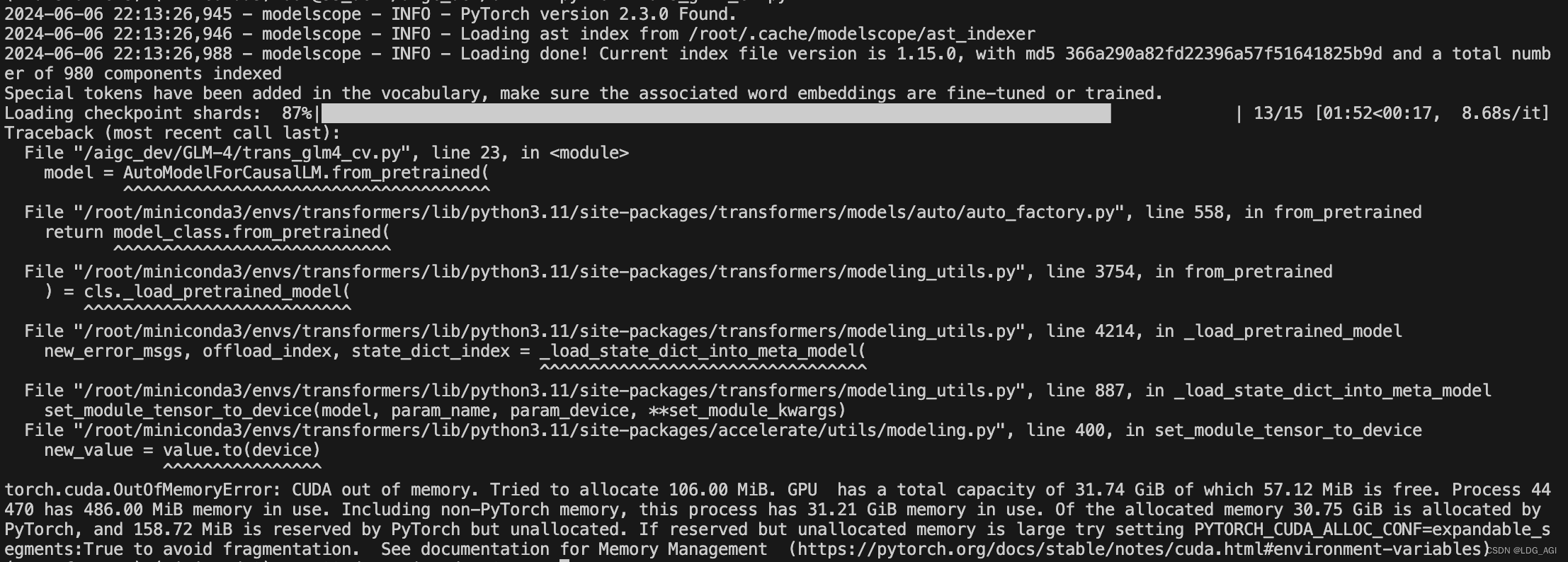

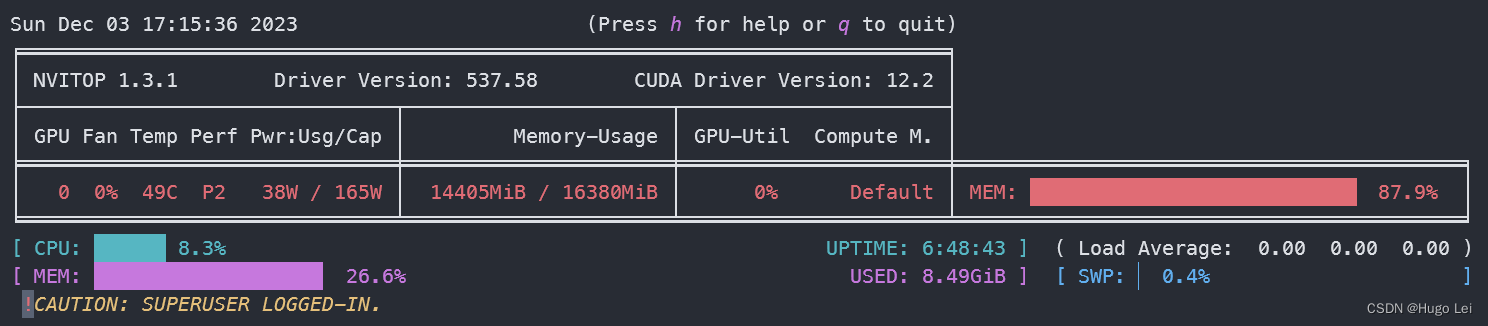

LLM大语言模型(十六):最新开源 GLM4-9B 本地部署,带不动,根本带不动

目录 前言 本机环境 GLM4代码库下载 模型文件下载:文件很大 修改为从本地模型文件启动 启动模型cli对话demo 慢,巨慢,一个字一个字的蹦 GPU资源使用情况 GLM3资源使用情况对比 前言 GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。 在语义、数学、推理、代码和知识等多方面的数据集测评中, GLM-4-9B