gaitset专题

GaitSet学习笔记(不包括三元数损失,仅含主干网络)

论文 1 Introduction 1.1 旧方法 ① 将步态轮廓压缩为一张图(损失了时序信息与细粒度系信息) ② 直接从原始步态轮廓序列中提取特征(极易受到外部条件影响) 1.2 我们提出的方法 步态序列可以看做一个周期,而特定帧有其特定的步态形态,人类很容易可以复原打乱的步态序列的顺序。因此,顺序信息不必需提供给网络,而将步态序列帧看做一个个具有位置信息的帧组成

读gaitset代码

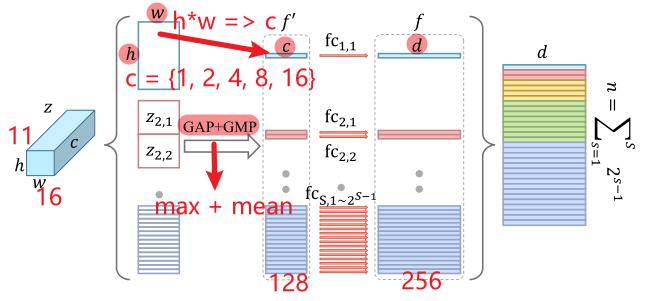

输入:128个30,64,64预处理后ipts[128, 30, 64, 44]->sils[128,1, 1186, 64, 44]GaitSet((set_block1): SetBlockWrapper(sils先transpose且reshape成torch.Size([3840, 1, 64, 44])(forward_block): Sequential((0): BasicCon

读《Gaitset: Regarding gait as a set for cross-view gait recognition》

2019在AAAI(还有一版叫GaitSet: Regarding Gait as a Set for Cross-View Gait Recognition,大体上一样) 摘要 现有的步态识别方法要么利用步态模板,难以保存时间信息,要么利用保持不必要的顺序约束的步态序列,从而失去步态识别的灵活性。在本文中,我们提出了一种新的视角,利用步态作为深度集,这意味着一组步态帧由全局局部融合深度网络