forpanoptic专题

论文精读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

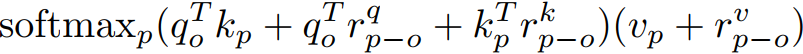

论文地址:https://arxiv.org/abs/2003.07853 Abstract 卷积利用局部性来提高效率,但代价是缺少长期上下文。自我注意已经被用来通过非局部的交互作用来增强cnn。最近的研究证明,通过将注意力限制在一个局部区域,可以通过叠加自注意层来获得一个完全的注意网络。本文试图通过将二维自注意分解为两个一维自注意来消除这一约束。这降低了计算的复杂度,并允许

论文解读:Axial-DeepLab: Stand-Alone Axial-Attention forPanoptic Segmentation

论文是一个分割任务,但这里的方法不局限于分割,运用到检测、分类都可以。 论文下载 https://www.yuque.com/yuqueyonghupjh9oc/ovceh4/onilw42ux6e9n1ne?singleDoc# 《轴注意力机制》 一个问题 为什么transformer一开始都有CNN:降低H、W,降低self-attention计算规模O(特征点的个数^2,即(H*W)