forgetting专题

【论文笔记】ResRep: Lossless CNN Pruning via Decoupling Remembering and Forgetting

Abstract 提出了ResRep,一种无损通道修剪的新方法,它通过减少卷积层的宽度(输出通道数)来缩小CNN的尺寸。 建议将CNN重新参数化为记忆部分和遗忘部分,前者学习保持性能,后者学习修剪。通过对前者使用常规 SGD 进行训练,对后者使用带有惩罚梯度的新颖更新规则进行训练,实现了结构化稀疏性,然后等效地将记忆和遗忘部分合并到层数更窄的原始架构中。 github仓库 1 Introdu

持续学习动态架构算法LwF(Learning without Forgetting )解读总结与代码注释

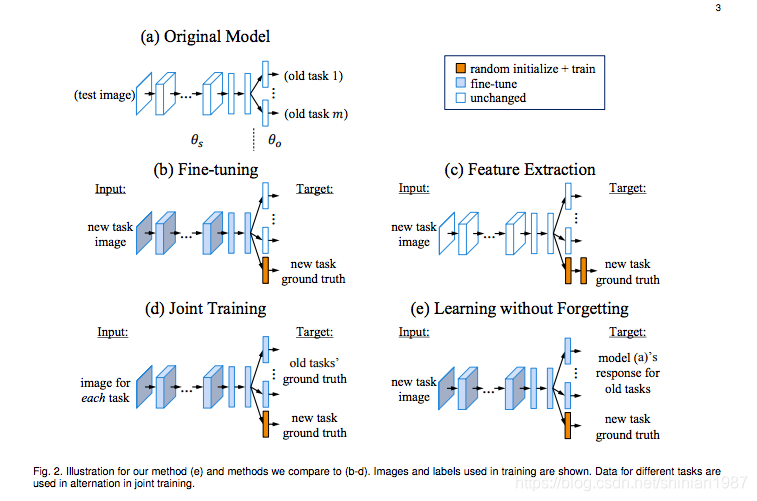

0.持续学习 持续学习相关文章汇总,包含论文地址、代码地址、具体分析解读地址 1.LwF算法相关链接 论文地址代码地址 2.基本想法 针对问题:在无法获得原始任务训练数据的情况下,适合使视觉系统适应新任务,并且保证其在旧任务上的性能问题建模:学习对新任务具有判别能力的参数,同时保留训练数据上原始任务的输出将网络分为所有任务共享部分和特定任务独享部分,网络架构如下: 图片 3.损失函数

机器学习:Leaning without Forgetting -- 增量学习中的抑制遗忘

传统的机器学习中,训练数据的类别都是固定的,这里也有一个假设,就是测试集也是类别固定的,这也是为什么现在很多模型在人类看来非常白痴的原因,套用一句非常经典的话来说,就是对于一个只见过猫狗的模型来说,那么这个世界在这个模型眼里里,只有猫狗两种可能。 所以很多研究人员开始探索增量学习这种技术,这种技术是模拟人的认知过程的,虽然我们无法见过这世界所有的东西,但是随着我见过的物体种类越来越多,那我们能够

[Retentive R-CNN] Generalized Few-Shot Object Detection without Forgetting(CVPR. 2021)

1. Motivation 本文关注于fine-tune后的FSOD模型会在base classes上性能下降的问题。这篇文章构建了Retentive R-CNN,创新点在于Bias-Balance RPN Re-detector,用来在识别novel classes的同时,不降低原有的base classes的精度 However, the majority focus merely o

![[Retentive R-CNN] Generalized Few-Shot Object Detection without Forgetting(CVPR. 2021)](https://img-blog.csdnimg.cn/img_convert/4bcbc45017520ab67cc009f6c89c79cb.png)