fluentd专题

构建Python中的分布式日志系统:ELK与Fluentd的结合

👽发现宝藏 前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。【点击进入巨牛的人工智能学习网站】。 在现代软件开发中,日志系统是至关重要的组成部分。它们不仅用于故障排查和性能监控,还可以提供关键业务洞察。本文将介绍如何利用ELK(Elasticsearch、Logstash和Kibana)与Fluentd结合,构建一个高效的分布式日志系统,并提供Pyth

使用docker搭建Fluentd的教程

使用Docker搭建Fluentd的教程 步骤 1: 拉取Fluentd镜像 首先,需要从Docker Hub上拉取Fluentd的官方镜像: docker pull fluent/fluentd:v1.14-debian-1 这里使用的是基于Debian的Fluentd 1.14版本的镜像,可以根据需要选择其他版本。 步骤 2: 运行Fluentd容器 使用以下命令运行Fluent

docker日志采集elk efk fluentd采集

第一步: Create docker-compose.yml 创建docker-合成.yml对于Docker Compose。Docker Compose是一个用于定义和运行多容器Docker应用程序的工具。通过下面的YAML文件,您可以通过一个命令创建和启动所有服务(在本例中是Apache、Fluentd、Elasticsearch、Kibana): version: '3'service

Fluentd-ElasticSearch配置两三(糗)事

上周末在家闲来无事,于是乎动手帮项目组搭建日志收集的EFK环境,最终目标的部署是这个样子的: 在每个应用机器上部一个Fluentd做为代理端,以tail方式读取指定的应用日志文件,然后Forward到做为汇聚端的Fluentd,汇聚端对日志内容加工、分解成结构化内容,再存储到ElasticSearch。日志内容的展现由Kinana实现。 Fluentd是什么? Fluentd是一个完全免费

详解日志采集工具--Logstash、Filebeat、Fluentd、Logagent对比

概述 常见的日志采集工具有Logstash、Filebeat、Fluentd、Logagent、rsyslog等等,那么他们之间有什么区别呢?什么情况下我们应该用哪一种工具? Logstash Logstash是一个开源数据收集引擎,具有实时管道功能。Logstash可以动态地将来自不同数据源的数据统一起来,并将数据标准化到你所选择的目的地。 优势 Logstash 主要

Docker通过EFK(Elasticsearch + Fluentd + Kibana)查询日志

一、概述 Elasticsearch是一个开源搜索引擎,以易用性着称。kibana是一个图形界面,可以在上面条件检索存储在ElasticSearch里数据,相当于提供了ES的可视化操作管理器。 fluentd fluentd是一个针对日志的收集、处理、转发系统。通过丰富的插件系统,可以收集来自于各种系统或应用的日志,转化为用户指定的格式后,转发到用户所指定的日志存储系统之中。 fluentd 常

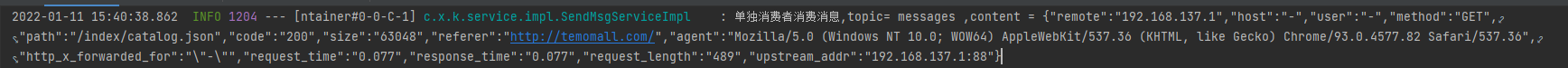

基于fluentd实现读取nginx日志输出到kafka

基于fluentd实现读取nginx日志输出到kafka 一、浅谈fluentd1.1、什么是Fluentd?1.2、应该选择 fluentd 还是 td-agent? 二、安装td-agent服务器2.1、安装td-agent2.2、启动td-agent服务2.3、使用http post请求测试 三、怎么去使用这个td-agent3.1、了解td-agent的内部结构1)Input Plu

【官方文档】Fluentd 输出插件(elasticsearch)

原文 文章目录 0. 要求1. 安装2. 使用3. 插件助手4. 参数 4.1. @type(必须的)4.2. host(可选的)4.3. port(可选的)4.4. cloud_id4.5. cloud_auth4.6. emit_error_for_missing_id4.7. hosts(可选的)4.8. user,password(可选的)4.9. path(可选的)4.10. sc

大数据工程师入门系列 - 常用数据采集工具(Flume、Logstash 和 Fluentd)

作者:幻好 来源: 恒生LIGHT云社区 大数据的价值在于把数据变成某一行为的结论,这一重要的过程成为数据分析。提到数据分析,大部分人首先想到的都是 Hadoop、流计算、机器学习等数据加工的方式。具体从整个过程来看,数据分析其实可以大致分为四个步骤:数据采集,数据存储,数据计算,数据可视化。 其中大数据的数据采集这一过程是最基础,也是最重要的部分。针对具体的场景使用合适