epoch专题

[nlp] epoch、batchsize、batchnumber、iterations

参考:https://blog.csdn.net/wills798/article/details/89326343 epoch 一个epoch是指 所有的数据 传入网络 完成一次前向计算以及反向传播的过程。 由于一个epoch常常太大,计算机无法负荷。 batch_size 所谓batch就是每次送入网络中训练的一部分数据, 而 batch_size 是 每个batch中训练样本

keras训练模型时绘出每个epoch的accuracy和loss

keras训练模型时绘出每个epoch的accuracy和loss 一、绘制模型训练过程中的accuracy和loss二、绘制训练好的模型测试过程中的accuracy和loss1.交叉熵损失函数2.评估accuracy_score 一、绘制模型训练过程中的accuracy和loss # 绘制图形以确保准确性# 训练集准确率plt.plot(history.history['

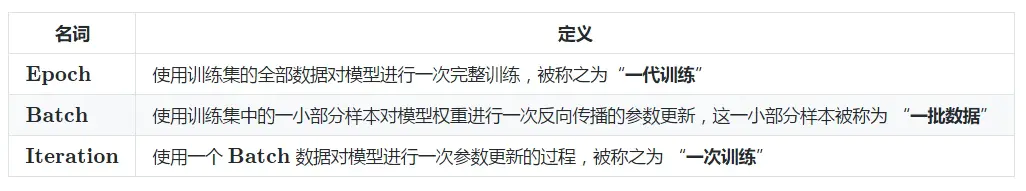

深度学习中Epoch,Batchsize,Iterations

Epoch,Batchsize,Iterations,这三个都是深度学习训练模型时经常遇到的概念。你一定有过这样的时刻,面对这几个词傻傻分不清楚,这三个概念究竟是什么,它们又有什么区别? 深度学习,梯度下降,Epoch,Batchsize,Iterations 深度学习中的Epoch,Batchsize,Iterations,都是什么意思 梯度下降法 一切的一切,要从机器学习中的

2024-04-03 问AI: 在深度学习中,什么是训练中的epoch?

文心一言 在深度学习中,一个“epoch”指的是整个数据集被模型完整地遍历和学习一次的过程。换句话说,当模型已经看过数据集中的所有样本一次时,我们就说已经完成了一个epoch。 理解epoch的概念对于训练深度学习模型非常重要。在训练过程中,模型会多次遍历整个数据集,每次遍历都称为一个epoch。在每个epoch中,模型会尝试通过调整其内部参数(即权重和偏置)来最小化预测误差。这种调整是通过反

【CenterFusion】run_epoch()函数-训练一轮epoch-CenterFusion/src/lib/trainer.py

文件位置:CenterFusion/src/lib/trainer.py run_epoch作用:CenterFusion 项目训练一轮epoch过程 在 main.py 函数中,生成了训练器,然后再使用训练器训练一个 epochrun_epoch()函数的定义在src\lib\trainer.py150行左右,它的主要过程如下所示: def run_epoch(self, phase,

pytorch模型参数--start-epoch 和 --resume的区别与使用

--start-epoch和--resume在训练模型时有关联但并不完全一样。具体分析如下: --start-epoch:这个参数通常用于指定从哪个epoch开始训练。当你想从之前的某个点继续训练模型时,可以设置--start-epoch为你上次训练结束时的epoch数。这在你需要从特定阶段恢复训练时非常有用,例如当你发现模型在某个epoch后开始过拟合,你可能希望从那个点重新开始训练并调整超参

GraphSAIL 贝叶斯公式 epoch batch iteration区别 GD与SGD 一些代码问题

目录 2021.05.25 看论文GraphSAIL2021.05.26 写论文2021.05.27 论文注意点题目摘要本机安装包 2021.07.02 论文审稿回顾代码 贝叶斯公式2021.07.05函数epoch batch iteration 2021.07.06GD和SGD 2021.07.072021.07.132021.07.18看论文 随手记英文 2021.08.02

详解step、iteration、batch_size、epoch

大家好,我是herosunly。985院校硕士毕业,现担任算法研究员一职,热衷于机器学习算法研究与应用。曾获得阿里云天池比赛第一名,CCF比赛第二名,科大讯飞比赛第三名。拥有多项发明专利。对机器学习和深度学习拥有自己独到的见解。曾经辅导过若干个非计算机专业的学生进入到算法行业就业。希望和大家一起成长进步。 今天给大家带来的文章是详解step、batch_size、iteration、ep

深度学习中的Epoch

深度学习中的Epoch 大家好,我是免费搭建查券返利机器人赚佣金就用微赚淘客系统3.0的小编,也是冬天不穿秋裤,天冷也要风度的程序猿!今天,让我们一同探讨深度学习领域中不可或缺的概念之一——Epoch。 1. 什么是Epoch? 在深度学习中,Epoch(中文译为“时代”或“纪元”)是指模型训练过程中所有训练样本都被正向和反向传播过一次的次数。简而言之,一个Epoch表示整个训练数据集被模型

【超分辨率MSRN代码问题/PyTorch-二】中断训练后从停止的epoch继续训练

当我不小心中断训练后,想继续训练时,发现MSRN代码有挺多问题啊。。 1. 首先想继续训练的话,运行主文件时的参数要从原来给的 python main.py --template MSRN --save MSRN_X2 --scale 2 --reset --save_results --patch_size 96 --ext sep_reset 修改成 python main.py --

27高水位和leader epoch

1.leader epoch是如何在broker之间同步的 2.已经写入的消息不一定发送成功,消息发送成功的判断依据是什么? 高水位前的消息为已提交的消息,配置acks为all的生产者会等待ISR副本中的所有副本都同步了该消息才会认为消息已经成功提交。副本同步消息有时间延迟,如果生产者同步发送消息则会等待一段时间。 3.leader和follow副本同步存在错配,在这段高水位未同步的时间里如果

在pytorch中将数据打包为DataLoader后每个epoch中的打乱策略

在pytorch中将数据打包为DataLoader后每个epoch中的打乱策略 1、利用shuffle2、利用SubsetRandomSampler 有两种打乱策略: 1、利用shuffle 在 PyTorch 中,当使用 DataLoader 并设置 shuffle=True 时,数据会在每个 epoch 开始时被重新打乱。这意味着在每个 epoch,数据加载的顺序都会不同

神经网络模型训练中的相关概念:Epoch,Batch,Batch size,Iteration

神经网络模型训练中的相关概念如下: Epoch(时期/回合):当一个完整的数据集通过了神经网络一次并且返回了一次,这个过程称为一次 epoch。也就是说,所有训练样本在神经网络中都进行了一次正向传播和一次反向传播。一个 epoch 是将所有训练样本训练一次的过程。Batch(批 / 一批样本):将整个训练样本分成若干个 batch。每个 batch 中包含一部分训练样本,每次送入网络中进行训练的

kafka ISR设计及水印与leader epoch副本同步机制深入剖析-kafka 商业环境实战

版权声明:本套技术专栏是作者(秦凯新)平时工作的总结和升华,通过从真实商业环境抽取案例进行总结和分享,并给出商业应用的调优建议和集群环境容量规划等内容,请持续关注本套博客。版权声明:禁止转载,欢迎学习。QQ邮箱地址:1120746959@qq.com,如有任何商业交流,可随时联系。 1 帽子理论(Gilbert 和 Lynch ) 一致性 any read operation that

【深度学习】神经网络术语:Epoch、Batch Size和迭代

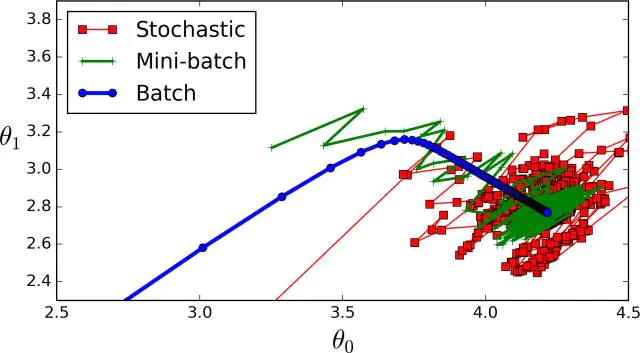

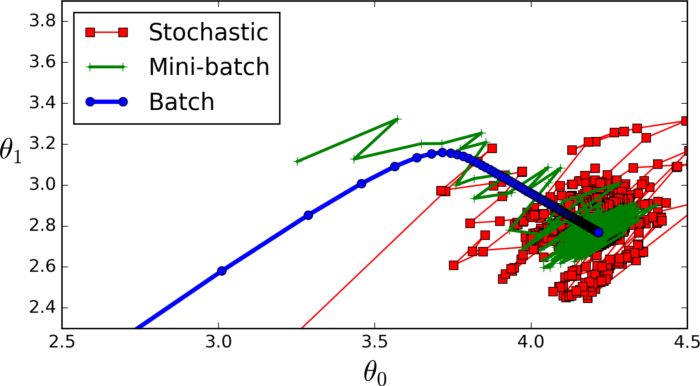

batchsize:中文翻译为批大小(批尺寸)。 简单点说,批量大小将决定我们一次训练的样本数目。 batch_size将影响到模型的优化程度和速度。 为什么需要有 Batch_Size : batchsize 的正确选择是为了在内存效率和内存容量之间寻找最佳平衡。 Batch_Size的取值: 全批次(蓝色) 如果数据集比较小我们就采用全数据集。全数据集确定的方向能够更好地

神经网络训练多个epoch,写论文的时候可以取最好的效果那一个epoch作为结果吗?

论文中一般都是用在**验证集上效果最好的模型去预测测试集,多次预测的结果取平均计算准确率或者mAP值而不是单纯的取一次最好的结果作为论文的结果。**如果你在写论文的过程中,把测试集当做验证集去验证的话,这其实是作假的,建议不要这样,一旦有人举报或者复现出来你的结果和你论文中的结果相差很大的话,是会受到很大处分的。 我之前曾遇到过这种情况,我在图像分类的过程中曾经用过CutMix增强方式,CutM

怎么推算max_step和epoch之间关系,例如多少step一个epoch

怎么推算max_step和epoch之间关系,例如多少step一个epoch max_step(最大训练步数)和 epoch(轮次)之间的关系取决于您的训练流程和超参数设置。通常情况下,一个step通常表示对一个batch的训练,而epoch则表示一次完整的数据集训练。因此,它们之间的关系可以用以下方式估算: max_step与epoch的关系:通常,您可以通过以下公式估算max_step与e

epoch训练时间不同_26秒单GPU训练CIFAR10,Jeff Dean也点赞的深度学习优化技巧

选自myrtle.ai 机器之心编译 机器之心编辑部 26 秒内用 ResNet 训练 CIFAR10?一块 GPU 也能这么干。近日,myrtle.ai 科学家 David Page 提出了一大堆针对数据预处理、模型架构、训练和测试方面的优化方法,有了它们,加速训练你也可以。 运行速度和算力一直是制约深度学习模型发展的瓶颈。研究人员一直在研究如何能够进一步提升模型的训练和推断速度,并减少对

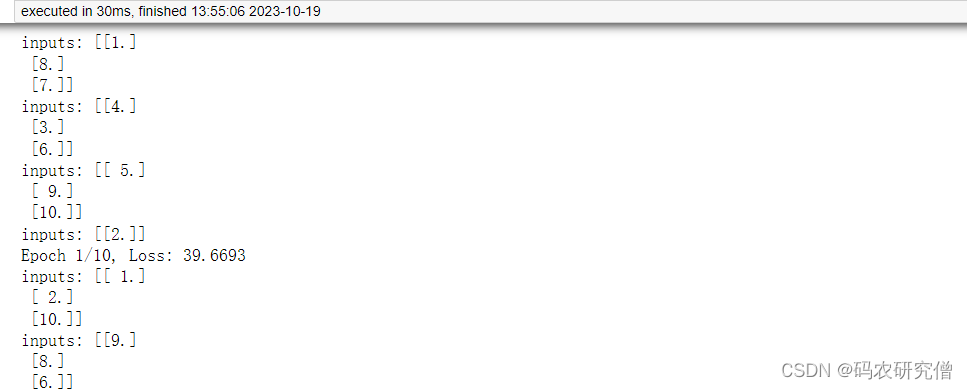

剖析深度学习中的epoch与batch_size关系、代码

目录 前言1. 定义2. 代码 前言 为了区分深度学习中这两者的定义,详细讲解其关系以及代码 1. 定义 在 PyTorch 中,“epoch”(周期)和 “batch size”(批大小)是训练神经网络时的两个重要概念 它们用于控制训练的迭代和数据处理方式。 一、Epoch(周期): Epoch 是指整个训练数据集被神经网络完整地遍历一次的次数。在每个 epoch 中

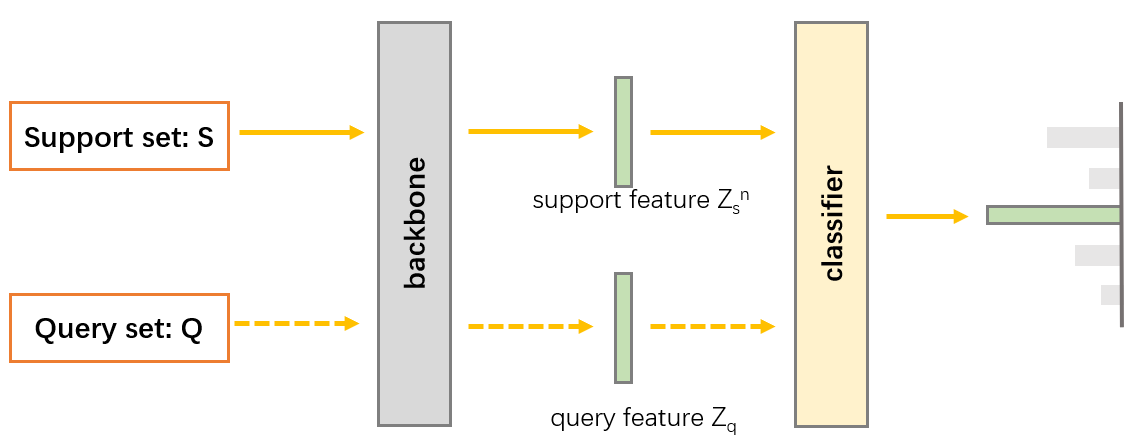

深度学习batch、batch_size、epoch、iteration以及小样本中episode、support set、query set关系

batch、batch_size、epoch、iteration关系: epoch:整个数据集 batch: 整个数据集分成多少小块进行训练 batch_size: 一次训练(1 batch)需要 batch_size个样本 iteration: 整个数据集需要用batch_size训练多少轮 例如:训练集1000个样本,分成100小块batch,batch_size=10,则itera

![[nlp] epoch、batchsize、batchnumber、iterations](/front/images/it_default.gif)