dstream专题

DSTREAM系列产品差异分析及最新DSTREAM-HT

DSTREAM-HT是ARM公司开发的一款高速占用引脚少的仿真调试器,更快速更少的引脚:非常适合收集大量追踪数据,其中SoC引脚数排除了并行追踪。捕获多个高速串行追踪通道(HSSTP)以启用软件分析,配合arm DS-5可对所有的ARM内核芯片进行开发。 优势功能 快速的数据传输:高达12.5 Gbps的单通道线路速率(60 Gbps组合通道速率),可配置和捕获CoreSight和自

SparkStreaming编程-DStream输出

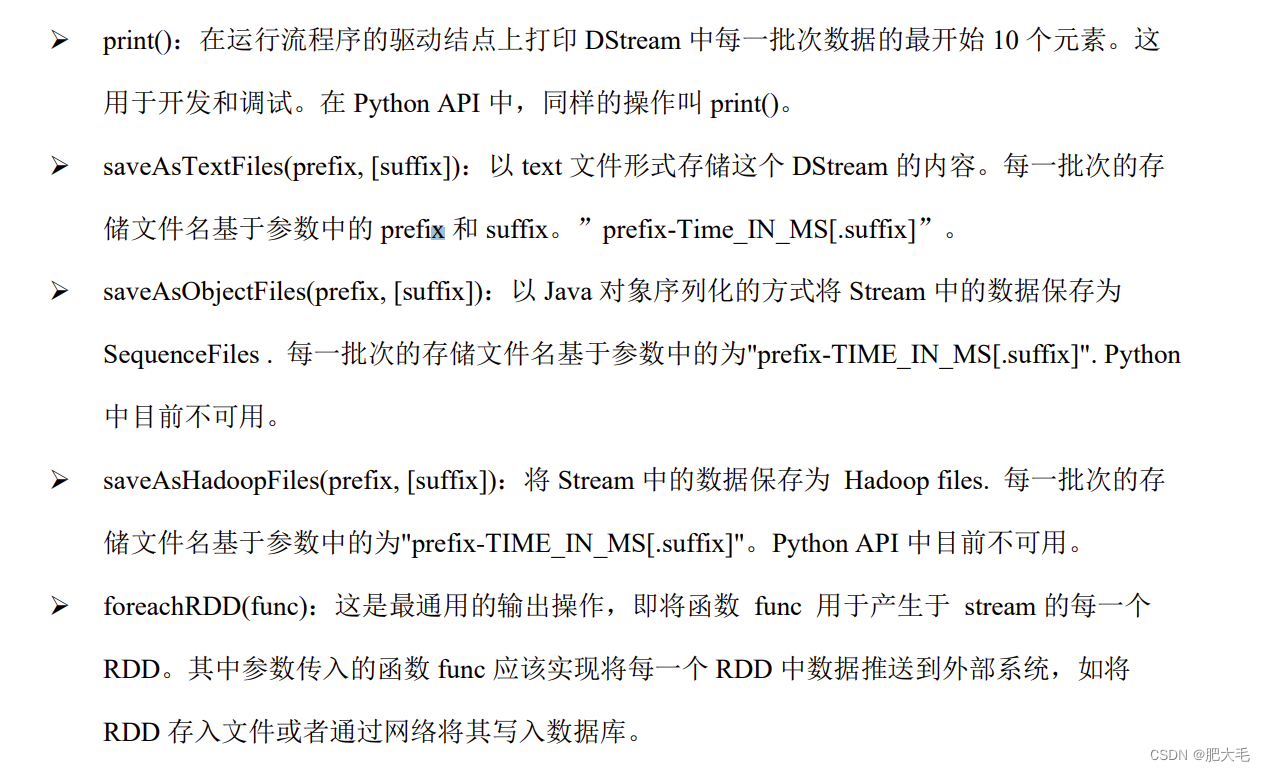

输出操作指定了对流数据经转化操作得到的数据所要执行的操作(例如把结果推入外部数据库或输出到屏幕上)。与RDD中的惰性求值类似,如果一个DStream及其派生出的DStream都没有被执行输出操作,那么这些DStream就都不会被求值。如果StreamingContext中没有设定输出操作,整个context就都不会启动。 常见的输出操作函数如下:print()、saveAsTextFil

Spark2.x 入门:RDD队列流(DStream)

在调试Spark Streaming应用程序的时候,我们可以使用streamingContext.queueStream(queueOfRDD)创建基于RDD队列的DStream。 下面是参考Spark官网的QueueStream程序设计的程序,每隔1秒创建一个RDD,Streaming每隔2秒就对数据进行处理。 新建一个TestRDDQueueStream.scala文件,在该文件中输入以下

######好好好#######DStream 生成 RDD 实例详解

DStream 生成 RDD 实例详解 [酷玩 Spark] Spark Streaming 源码解析系列 ,返回目录请 猛戳这里 「腾讯·广点通」技术团队荣誉出品 本系列内容适用范围:* 2016.12.28 update, Spark 2.1 全系列 √ (2.1.0)* 2016.11.14 update, Spark 2.0 全系列 √ (2.0.0, 2.0.1, 2.0.

####好#####DStream中的转换(transformation)

DStream中的转换(transformation) 和RDD类似,transformation允许从输入DStream来的数据被修改。DStreams支持很多在RDD中可用的transformation算子。一些常用的算子如下所示: TransformationMeaningmap(func)利用函数func处理原DStream的每个元素,返回一个新的DStreamflatMap(func

Spark Streaming DStream

Spark Streaming DStream DStream 即Discretized Stream,中文叫做离散流,Spark Streaming提供的一种高级抽象,代表了一个持续不断的数据流。 DStream可以通过输入数据源来创建,比如Kafka、Flume,也可以通过对其他DStream应用高阶函数来创建,比如map、reduce、join、window。 DStream的内部,

使用ARM DS-5与Dstream StreamLine进行Android底层性能分析的一个实例

前言 一个类似于Android的OS,只使用了BT机能的状态下,CPU的占有率超过20%,于是我们想看看是什么原因。本篇文章注意介绍了使用Dstream StreamLine来进行性能分析的过程和实例以及可能需要注意的地方。 StreamLine准备 使用StreamLine来分析性能主要包含以下几个过程 配置内核使得内核可以产生一些性能相关的数据,以及一些设施用以支持gator,

Spark Streaming(二十七)DStream的转换、输出、缓存持久化、检查点

定义 所谓DStream的转换其实就是对间隔时间内DStream数据流的RDD进行转换操作并返回去一个新的DStream。 DStream转换 其实DStream转换语法跟RDD的转换语法非常类似,但DStream有它自己的一些特殊的语法,如updateStateByKey()、transform()、以及各种Window语法。 转换意思map(func)将DStream上的每个RDD通过

Spark Streaming(二十六)DStream基本数据源、高级数据源

输入DStream和Receiver 输入DStream其实就是从数据源接收到的输入数据流的DStream。每个DStream都与一个Receiver对象一一对应。SparkStreaming提供了两种内置数据源支持。 基本的数据源:Streaming API中直接提供的数据源。例如文件系统和套接字连接。高级数据源:Kafka、Flume、Kinesis等数据源,这种高级数据源需要提供额外Ma

Spark Streaming(二十五)初始化StreamingContext、初识DStream

初始化StreamingContext 初始化一个SparkStreaming程序,必须创建StreamingContext对象,因为它是SparkStreaming处理流式数据的入口。 def main(args: Array[String]): Unit = {//初始化SparkConfval conf = new SparkConf().setMaster("local[2]").s

SparkStreaming---DStream

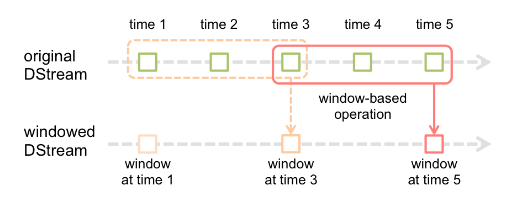

文章目录 1.DStream是什么2.DStream创建2.1 RDD队列2.2 自定义数据源 3.DStream转换3.1 无状态转换3.1.1 Transformations3.1.2 join 3.2 有状态转换操作3.2.1 UpdateStateByKey3.2.2 WindowOperations 4.DStream输出 1.DStream是什么 参考博文Spark

根本:详解receiver based Dstream

使用注意事项 1. receiver 会像正常task一样,由driver调度到executor,并占用一个cpu,与正常task不同,receiver是常驻线程 2. receiver个数 KafkaUtils.createStream调用次数决定,调用一次产生一个receiver 3. al topicMap = Map("page_visits" -> 1) map的value对应的数值

RDD的join和Dstream的join有什么区别?

有人在知识星球里问: 浪院长,RDD的join和Dstream的join有什么区别? 浪尖的回答: DStream的join底层就是rdd的join。 下面,我们就带着疑问去验证以下,我们的想法。 2. DStream -> PairDStreamFunctions Dstream这个类实际上支持的只是Spark Streaming的基础操作算子,比如: map, filter 和win