distributeddataparallel专题

多进程并行(如 PyTorch 的 DistributedDataParallel,DDP)和多 GPU 并行(如 DataParallel)的对比

多进程并行(如 PyTorch 的 DistributedDataParallel,DDP)和多 GPU 并行(如 DataParallel)确实有很大的区别,但并不能简单地说多 GPU 并行效果一定更好。让我们比较一下这两种方法: 多进程并行(DistributedDataParallel): 每个 GPU 对应一个独立的 Python 进程。每个进程有自己的模型副本和优化器。梯度同步是通过

DistributedDataParallel后台单机多卡训练

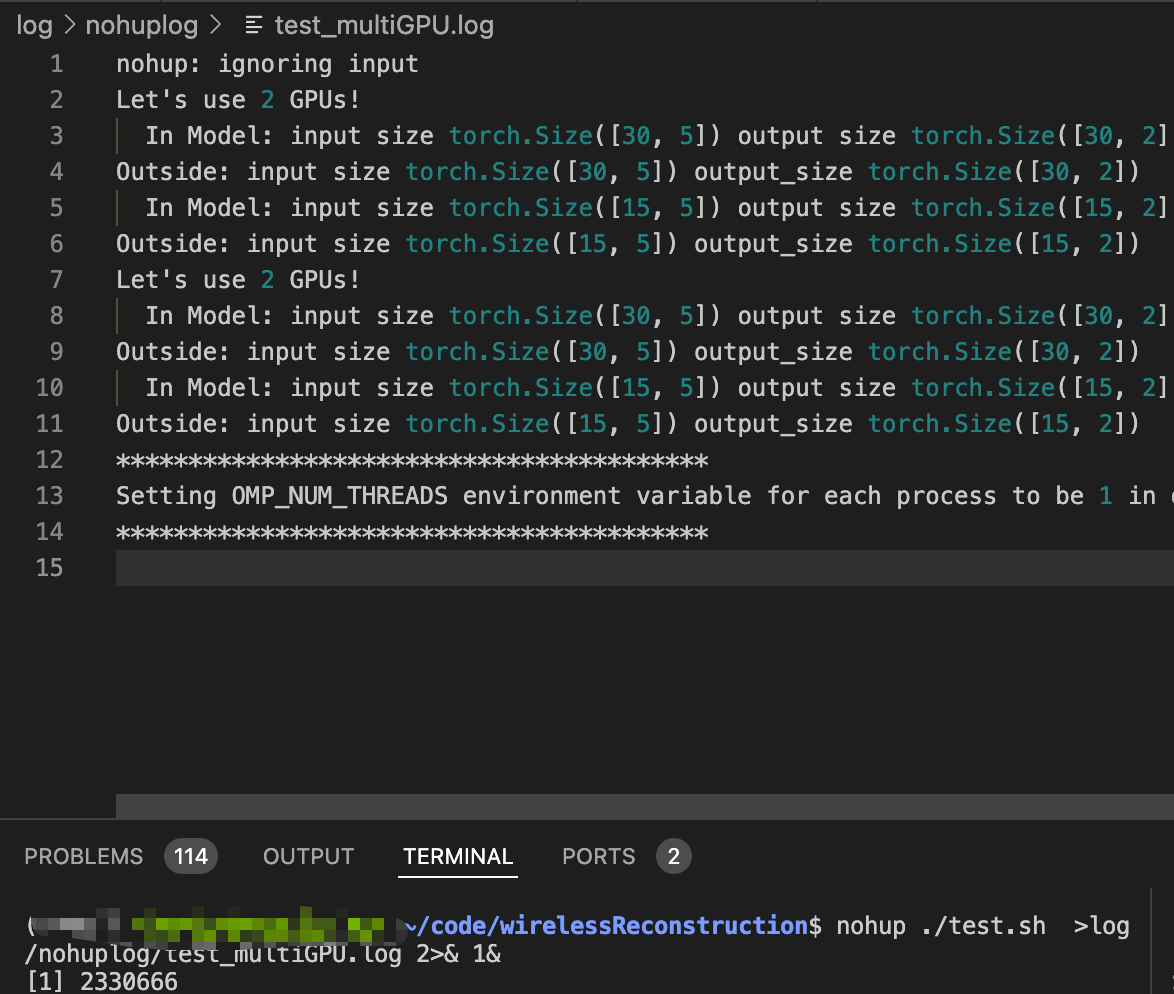

后台单机多卡训练 文章目录 后台单机多卡训练参考链接如何单机多卡DistributedDataParallel 如何后台训练screen ......nohup train.sh ..... 参考链接 Pytorch分布式训练(单机多卡)Linux screen命令Linux使用screen执行长时间运行的任务 如何单机多卡 一种是torch.nn.DataPara

pytorch DistributedDataParallel 分布式训练踩坑记录

目录 一、几个比较常见的概念:二、踩坑记录2.1 dist.init_process_group初始化2.2 spawn启动(rank怎么来的)2.3 loss backward2.4 model cuda设置2.5 数据加载 一、几个比较常见的概念: rank: 多机多卡时代表某一台机器,单机多卡时代表某一块GPUworld_size: 多机多卡时代表有几台机器,单机多卡时

DistributedDataParallel数据不均衡

背景 在使用 DistributedDataParallel 进行数据并行训练时,每次反向传播都需要执行 all_reduce 操作以同步各个进程的梯度。all_reduce 需要进程组中的所有进程参与,如果某一个进程没有执行 all_reduce(一个进程的输入较其他进程少),那么其他进程将会挂起或出错(取决于后端,nccl 后端会挂起,gloo 后端会报错)。 问题 在进行模型训练时,由

DistributedDataParallel数据不均衡

背景 在使用 DistributedDataParallel 进行数据并行训练时,每次反向传播都需要执行 all_reduce 操作以同步各个进程的梯度。all_reduce 需要进程组中的所有进程参与,如果某一个进程没有执行 all_reduce(一个进程的输入较其他进程少),那么其他进程将会挂起或出错(取决于后端,nccl 后端会挂起,gloo 后端会报错)。 问题 在进行模型训练时,由