dbrx专题

在AMD GPU上使用DBRX Instruct

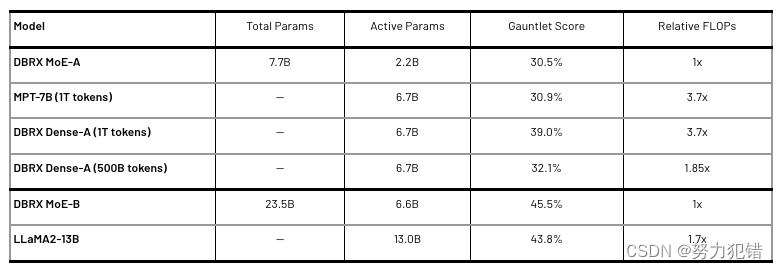

DBRX Instruct on AMD GPUs — ROCm Blogs 在这篇博客中,我们展示了DBRX Instruct,这是由Databricks开发的一个专家混合大型语言模型,在支持ROCm的系统和AMD GPU上运行。 关于DBRX Instruct DBRX是一个基于Transformer的仅解码大型语言模型,拥有1320亿参数,采用了细粒度的专家混合(MoE)架构。

Databricks发布MoE大模型DBRX:1320亿参数开源模型,推理速度提升2倍,评测超越ChatGPT和LLama

前言 在人工智能领域,大型语言模型(LLM)的研发一直是技术竞争的前沿。最近,Databricks公司推出的DBRX模型,以其1320亿参数的规模和创新的细粒度MoE(混合专家)架构,成为开源社区的焦点。本文将深入探讨DBRX模型的关键技术细节、性能评测、以及它在推理速度、成本效率和多模态处理能力上的显著优势。 DBRX模型简介 DBRX是一种基于Transformer架构的混合专家模型

1320亿参数,性能超LLaMA2、Grok-1!开源大模型DBRX

3月28日,著名数据和AI平台Databricks在官网正式开源大模型——DBRX。 DBRX是一个专家混合模型(MoE)有1320亿参数,能生成文本/代码、数学推理等,有基础和微调两种模型。 根据DBRX在MMLU、HumanEval和 GSM8K公布的测试数据显示,不仅性能超过了LLaMA2-70B和马斯克最近开源的Grok-1,推理效率比LLaMA2-70B快2倍,总参数却只有Grok-