contiguous专题

Meta Llama 3 .transpose().contiguous().view

Meta Llama 3 .transpose().contiguous().view() flyfish 参考地址 https://pytorch.org/docs/stable/generated/torch.transpose.html transpose美[træn'spoʊz] 英[træns'pəʊz;trɑːns-;-nz-] v. 使换位 / 转移 / 转换 / 调换n.

pytorch | torch.contiguous()方法

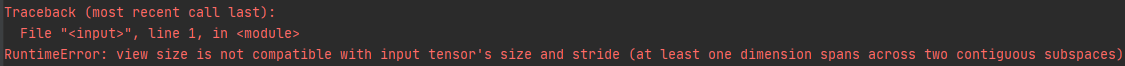

torch.contiguous()方法语义上是“连续的”,经常与torch.permute()、torch.transpose()、torch.view()方法一起使用,要理解这样使用的缘由,得从pytorch多维数组的低层存储开始说起: touch.view()方法对张量改变“形状”其实并没有改变张量在内存中真正的形状,可以理解为: view方法没有拷贝新的张量,没有开辟新内存,与原张

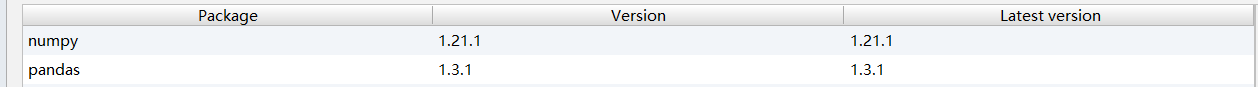

解决python报错:ValueError: ndarray is not contiguous

文章目录 初探解决方案再探索其他问题获取文件编码感想 本篇博客是主要是为:python 3.x实现特征选择ReliefF算法博友遇到的问题进行解答。 首先要对之前的对部分博友误导性回复说句抱歉。 之前由于自己懒,我自己电脑能跑通就没有去深究真正原因,就简单的以为是数据没有处理好的原因。 当我发现越来越多博友向我反馈这个问题时,我就开始怀疑之前对待这个问题的看法的正确性。 最

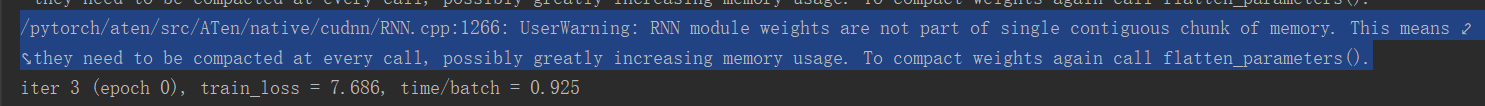

UserWarning: RNN module weights are not part of single contiguous chunk of memory.

最近几天的代码用到了gru,但是当代码使用DataParallel时,就会报下边图片的问题。使用单GPU训练时就不存在下述警告。 查阅资料以后,发现作者https://blog.csdn.net/feifei3211/article/details/102998288的解决方法非常有效地解决了该警告。为了便于查阅,我还是将问题及问题的解决方法记录下来。解决方法如下: class en_GR

Contiguous Repainting(贪心+思维)

5616: Contiguous Repainting 时间限制: 2 Sec 内存限制: 256 MB 提交: 70 解决: 23 [ 提交][ 状态][ 讨论版][命题人: admin] 题目描述 There are N squares aligned in a row. The i-th square from the left contains an integer

Lintcode 994 · Contiguous Array (presum + hashmap好题

994 · Contiguous Array Algorithms The length of the given binary array will not exceed 50,000. Example Example 1: Input: [0,1] Output: 2 Explanation: [0, 1] is the longest contiguous subarray with

[LeetCode] Contiguous Array | 转化为找和为0的最长子段

https://leetcode.com/problems/contiguous-array/?tab=Solutions 先把所有的0变成-1,问题就变成找最长的和为0的子段(设长度为ret,初始化为0)。然后扫描一次数组,计算前缀和并存入一个哈希表,每计算一个位置i的前缀和prefix_sum, 判断是否等于0,等于0的话,ret = max(ret, i + 1)否则在哈希表里找是否存过和

Leetcode 525. Contiguous Array

文章作者:Tyan 博客:noahsnail.com | CSDN | 简书 1. Description 2. Solution class Solution {public:int findMaxLength(vector<int>& nums) {int length = 0;int sum = 0;unordered_map<int, int> m({{0, -1}}

Linux内存管理:什么是CMA(contiguous memory allocation)连续内存分配器?可与DMA结合使用

目录 1. 概述 1.1.为什么在默认版本中使用它 2. 数据结构 3. 流程分析 3.1 CMA区域创建 3.1.1 方式一 根据dts来配置 3.1.2 方式二 根据参数或宏配置 3.2 CMA添加到Buddy System 3.3 CMA分配/释放 3.4 DMA使用 4.CMA利弊 4.1.优点 4.2.缺点 5.为什么要摆脱CMA 5.1.如何摆脱CMA

Pytorch:transpose、view、t()、contiguous()

日萌社 人工智能AI:Keras PyTorch MXNet TensorFlow PaddlePaddle 深度学习实战(不定时更新) 1.view(*args) → Tensor返回一个有相同数据但大小不同的tensor。 返回的tensor必须有与原tensor相同的数据和相同数目的元素,但可以有不同的大小。一个tensor必须是连续的contiguous()才能被查看。2