connectors专题

Elastic Connectors:增量同步对性能的影响

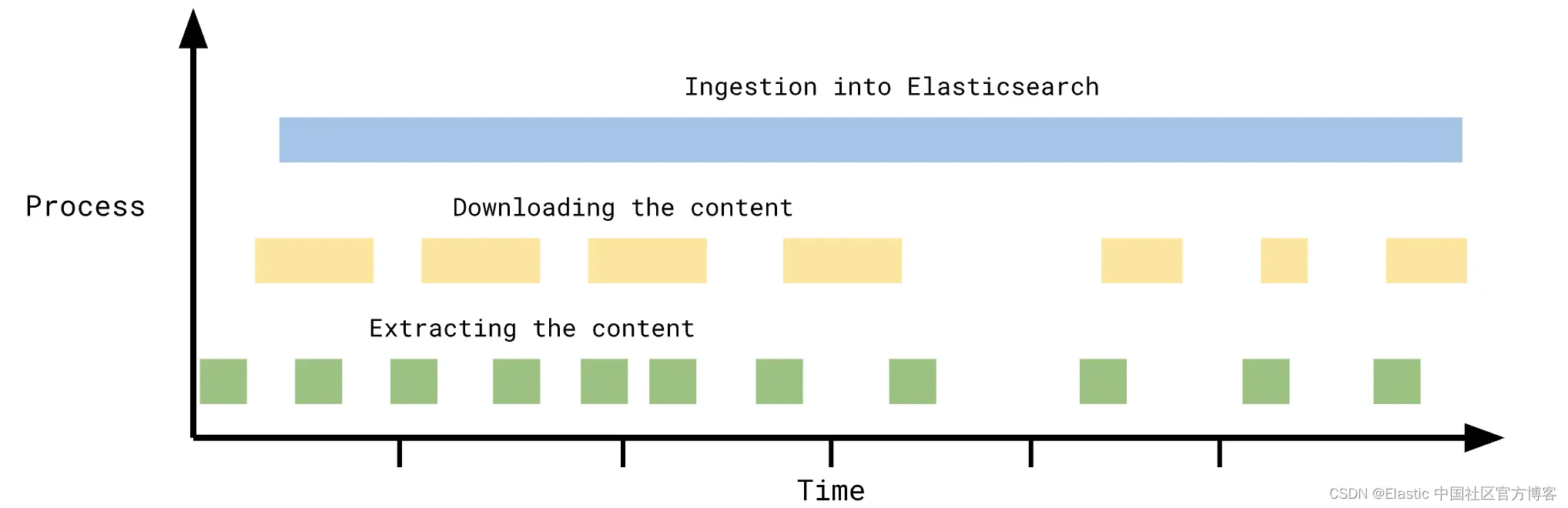

作者:Artem Shelkovnikov Elastic 连接器是一种 Elastic 集成,可将数据从原始数据源同步到 Elasticsearch 索引。连接器使你能够创建可搜索的只读数据源副本。 有许多连接器支持各种第三方,例如: MongoDB各种 SQL DBMS,例如 MySQL、PostgreSQL、MSSQL 和 OracleDBSharepoint OnlineAmaz

Flink 常用的 Source 和 Sink Connectors 介绍

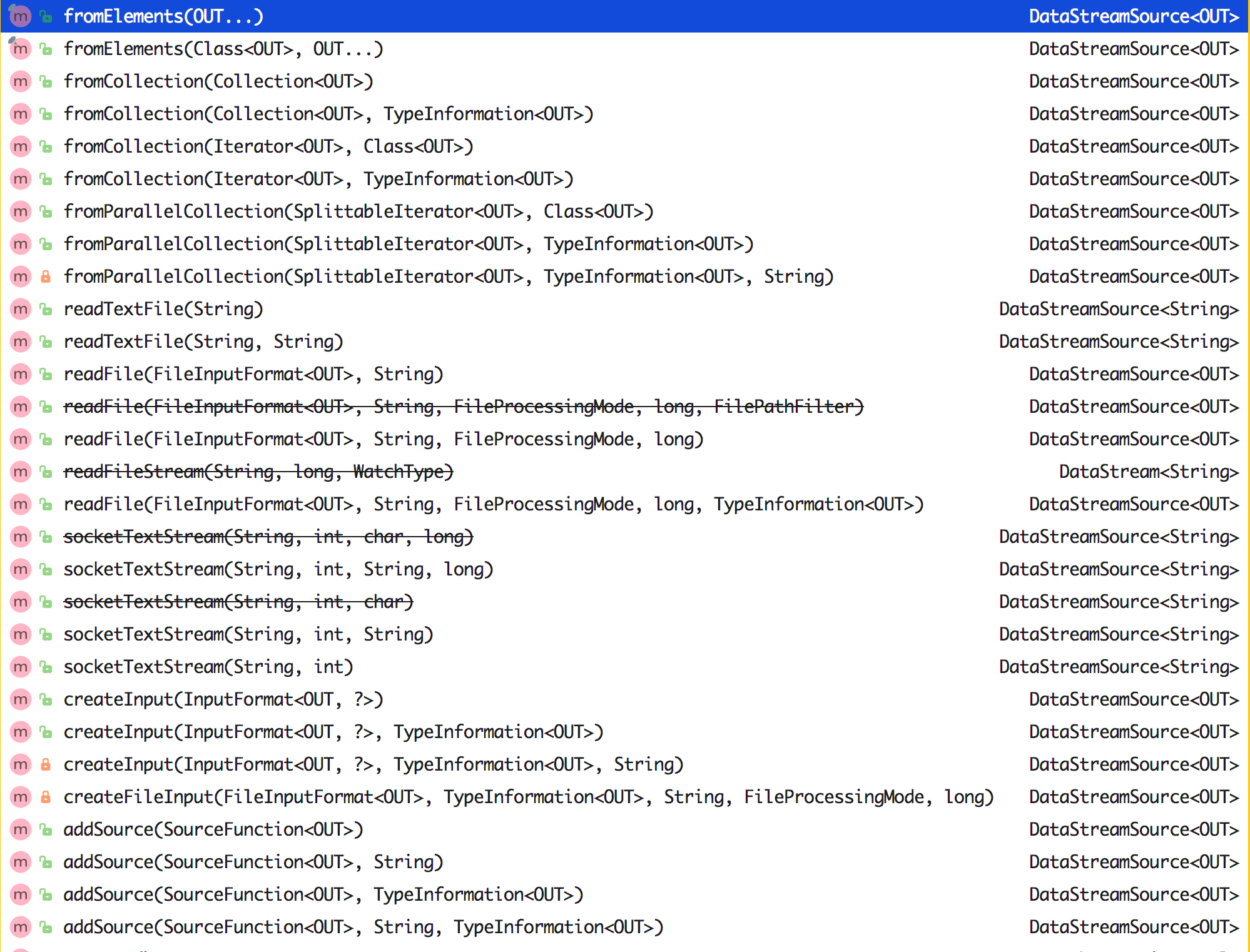

通过前面我们可以知道 Flink Job 的大致结构就是 Source ——> Transformation ——> Sink。 那么这个 Source 是什么意思呢?我们下面来看看。 Data Source 介绍 Data Source 是什么呢?就字面意思其实就可以知道:数据来源。 Flink 做为一款流式计算框架,它可用来做批处理,即处理静态的数据集、历史的数据集;也可以用来做流

如何自定义 Flink Connectors(Source 和 Sink)?

在前面文章 3.6 节中讲解了 Flink 中的 Data Source 和 Data Sink,然后介绍了 Flink 中自带的一些 Source 和 Sink 的 Connector,接着我们还有几篇实战会讲解了如何从 Kafka 处理数据写入到 Kafka、ElasticSearch 等,当然 Flink 还有一些其他的 Connector,我们这里就不一一介绍了,大家如果感兴趣的话可以去官

如何使用 Flink Connectors —— ElasticSearch?

准备环境和依赖 ElasticSearch 安装 因为在 2.1 节中已经讲过 ElasticSearch 的安装,这里就不做过多的重复,需要注意的一点就是 Flink 的 ElasticSearch Connector 是区分版本号的。 所以添加依赖的时候要区分一下,根据你安装的 ElasticSearch 来选择不一样的版本依赖,另外就是不同版本的 ElasticSearch 还会导

如何使用 Flink Connectors —— HBase?

准备环境和依赖 HBase 安装 如果是苹果系统,可以使用 HomeBrew 命令安装: brew install hbase HBase 最终会安装在路径 /usr/local/Cellar/hbase/ 下面,安装版本不同,文件名也不同。 配置 HBase 打开 libexec/conf/hbase-env.sh 修改里面的 JAVA_HOME: # The java impl

web server apache tomcat11-20-connectors 连接器

前言 整理这个官方翻译的系列,原因是网上大部分的 tomcat 版本比较旧,此版本为 v11 最新的版本。 开源项目 从零手写实现 tomcat minicat 别称【嗅虎】心有猛虎,轻嗅蔷薇。 系列文章 web server apache tomcat11-01-官方文档入门介绍 web server apache tomcat11-02-setup 启动 web serve

配置ActiveMQ的Transport Connectors

一、概念 从broker的角度来看,transport connector是用于接受和监听来自客户端的连接请求的一种机制。比如在”conf/activemq.xml“这个配置文件中可以找到: [html] view plain copy <!-- The transport connectors ActiveMQ will listen to --> <

Flink系列之:Table API Connectors之Debezium

Flink系列之:Table API Connectors之Debezium 一、Debezium二、依赖三、使用Debezium Format四、可用元数据五、Format参数六、重复的变更事件七、消费 Debezium Postgres Connector 产生的数据八、数据类型映射 一、Debezium Debezium 是一个 CDC(Changelog Data Cap

Flink系列之:Table API Connectors之JSON Format

Flink系列之:Table API Connectors之JSON Format 一、JSON Format二、依赖三、创建一张基于 JSON Format 的表四、Format 参数五、数据类型映射关系 一、JSON Format JSON Format 能读写 JSON 格式的数据。当前,JSON schema 是从 table schema 中自动推导而得的。 二、依赖