connectionist专题

一文读懂CRNN+CTC(Connectionist Temporal Classification)文字识别

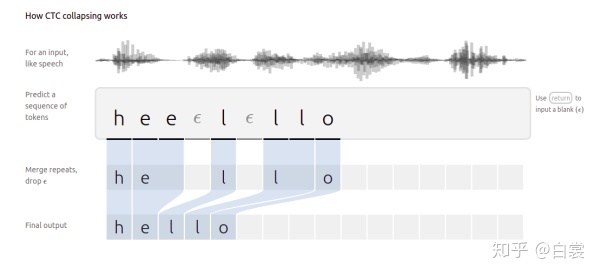

先总结一把CTC,下面文档太长: CTC是一种Loss计算方法,用CTC代替Softmax Loss,TF和pytorch都有对CTC的实现,从而解决OCR或者语音识别中序列对齐的问题。CTC特点: 引入blank字符,解决有些位置没有字符的问题通过递推,快速计算梯度 - CTC在递推最终概率的时候, 使用前向后向算法,类似HMM中的前向后向算法 - CTC在最终求解的时候,使用bea

CTC(Connectionist Temporal Classification)论文笔记

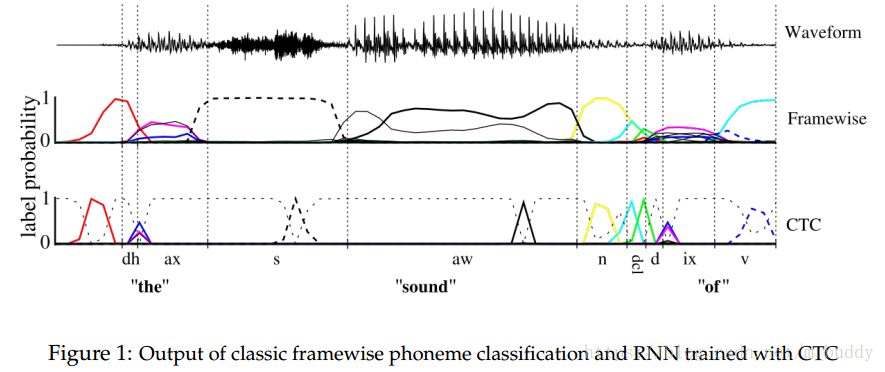

1. 思想 序列学习任务需要从未分割的输入数据中预测序列的结果。HMM模型与CRF模型是序列标签任务中主要使用的框架,这些方法对于许多问题已经获得了较好的效果,但是它们也有缺点: (1)需要大量任务相关的知识,例如,HMM中的状态模型,CRF中的输入特征选择; (2)需要有独立性假设作为支撑; (3)对于标准的HMM模型,它是生成式的,但是序列标签时判别式的。 RNN网络除了出入与输出的表达方

CTC Loss 数学原理讲解:Connectionist Temporal Classification

文章目录 1、CTC Loss 出现的背景例1:用于图像文本识别的CRNN网络例2:语音识别 2、CTC Loss 的总体思想3、Forward-Backward 算法3.1 合法路径的约束条件3.2 Forward-Backward 算法的数学推导 4、CTC 的训练(目标函数求导)5、解码算法6、CTC Loss 的优缺点 CTC Loss 是一种不需要数据对齐的,广泛用于图

Speech Recognition模型:Connectionist Temporal Classification(CTC)

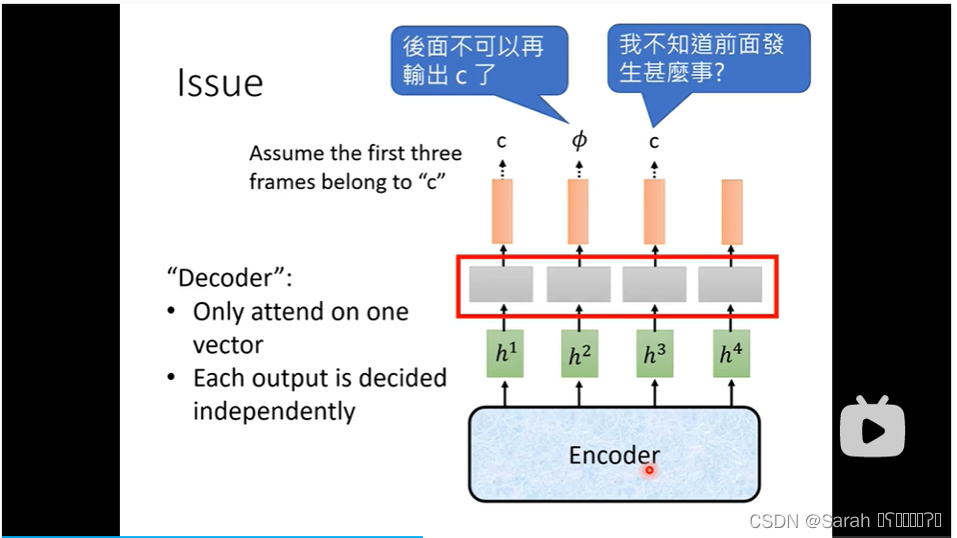

在上一篇讲的speech recognition模型 LAS 中,我们提到,LAS由encoder 和 decoder 组成,其在做speech recognition任务时,有一个很大的缺点,即:无法做到“边听边翻译”,换言之,在使用LAS做翻译时,需要将“原文"全部输入模型,才可得到译文(这里的译文 指 将 语音 转为 文字)。 本节所讲的模型CTC很好的克服了LAS的这一弱点,它可以实时的