cdh专题

物联网架构之CDH详解

💝💝💝欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。 推荐:Linux运维老纪的首页,持续学习,不断总结,共同进步,活到老学到老 导航剑指大厂系列:全面总结 运维核心技术:系统基础、数据库、网路技术、系统安全、自动化运维、容器技术、监控工具、脚本编程、云服务等。 常用运维工具系列:

CDH集群中Impala 使用的端口

下表中列出了 Impala 是用的 TCP 端口。在部署 Impala 之前,请确保每个系统上这些端口都是打开的。 组件 服务 端口 访问需求 备注 Impala Daemon Impala 守护进程前端端口 21000 外部 被 impala-shell, Beeswax, Cloudera ODBC 1.2 驱动 用于传递命令和接收结果。参见 Confi

物联网架构之CDH集群部署

💝💝💝欢迎来到我的博客,很高兴能够在这里和您见面!希望您在这里可以感受到一份轻松愉快的氛围,不仅可以获得有趣的内容和知识,也可以畅所欲言、分享您的想法和见解。 推荐:Linux运维老纪的首页,持续学习,不断总结,共同进步,活到老学到老 导航剑指大厂系列:全面总结 运维核心技术:系统基础、数据库、网路技术、系统安全、自动化运维、容器技术、监控工具、脚本编程、云服务等。 常用运维工具系列:

Hadoop,Zookeeper,Hbase,Hive,Spark,Kafka,CDH中webui常用端口

Hadoop: 50070:HDFS WEB UI端口 8020 : 高可用的HDFS RPC端口 9000 : 非高可用的HDFS RPC端口 8088 : Yarn 的WEB UI 接口 8485 : JournalNode 的RPC端口 8019 : ZKFC端口 Zookeeper: 2181 : 客户端连接zookeeper的端口 2888 : zookeeper集群内

cdh kerberos 安装

重建数据库:kdb5_util -r AQ.COM destroy 建数据库:kdb5_util create -r AQ.COM –s master 安装 yum install krb5-server krb5-workstation krb5-libs krb5-devel krb5-authdialog–y worker安装 yum install krb5-workstati

Hive学习系列:maven+springboot+CDH环境下,连接Hive进行操作

文章目录 场景环境正文确定Hive版本新建项目,并引入hive-jdbc依赖demo示例结果 总结随缘求赞 场景 在当前项目中,因为之前使用数据库查询,而随着数据的增多,查询速度会越来越慢,所以需要使用Java来调用hive进行数据统计。本篇博文主要是使用springboot+hive来查询hive数据,并返回查询的数据结果。 环境 软件版本springboot2.1.8.R

阿里云的oss上传到cdh的hdfs集群

1.oss可以上传到hdfs,支持emr集群还支持其他开源的hdfs版本。 emr-tools兼容Hadoop 2.4.x、2.5.x、2.6.x、2.7.x版本,如果有其他Hadoop版本兼容性的需求,请提交工单给阿里云。 下载https://helpcdn.aliyun.com/document_detail/63822.html tar jxf emr-tools.tar.bz2 2

hive-1.1-CDH永久注册UDF

第1种、创建临时函数。如在hive CLI执行下面命令 hive> add jar ipudf.jar; hive> create temporary function iptocc as 'com.wct.hive.udf.IptoccUDF'; hive> select iptocc(t.col1) from t limit 10; hive> drop tem

CDH安装配置zeppelin-0.7.3以及配置spark查询hive表

1.下载zeppelin http://zeppelin.apache.org/download.html 我下载的是796MB的那个已经编译好的,如果需要自己按照环境编译也可以,但是要很长时间编译,这个版本包含了很多插件,我虽然是CDH环境但是这个也可以使用。 2.修改配置文件 cd /zeppelin-0.7.3-bin-all/conf cp zeppelin-env.s

CDH修改HDFS以及存储的副本数量由备份3到备份2

首先第一个问题,我们修改CDH的HDFS副本设置后,历史的备份3数据是否会删除,还是从设置后才开始遵守备份2的?都需要操作哪些? 好的,我们带着问题来具体操作一下; 1.首先在CDH,HDFS中配置找到复制因子(dfs.replication),如下: 将原有dfs.replication的值 3 改为 2。 2.然后所有服务列表会出现如下显示: 3.我们只需要点击随意的一个fl

Can't Add Hdfs and Reported Cannot Find CDH's bigtop-detect-javahome

初次尝试,在CDH的使用中,遇到各种错误。让人无助的是,这些错误不好找解决方法。 我在启动CDH中的HDFS服务的时候,遇到这个错误: Can't Add Hdfs and Reported Cannot Find CDH's bigtop-detect-javahome 说找不到bigtop-detect-javahome文件,这个文件我在CDH部署的目录下找到的,而且我就是用它部署的呀

CDH远程监控所有HDFS节点磁盘空间和自动清除日志

目录 1. SSH协议的重要性 2. JSch库简介 3. 项目依赖配置 4. 亲测可用的代码实现 5. 实际应用场景 6. 安全性和最佳实践 在大数据运维领域,自动化是一项至关重要的技能。随着集群规模的扩大和业务的复杂化,手动检查和操作各个服务器上的Hadoop分布式文件系统(HDFS)状态、磁盘空间以及清理日志文件等工作变得越来越繁琐且容易出错。因此,开发一种能够远程、自

Kyuubi 实践 | Apache Kyuubi on Spark 在CDH上的深度实践

Kyuubi 简介 Kyuubi 是网易有数的大数据开源项目,于2021年6月全票通过进入世界顶级开源基金会 Apache Software Foundation 孵化器。 Kyuubi 的命名源自中国神话《山海经》,意为“九尾狐”。狐会喷火,象征Spark;狐有九尾,类比多租户,在Spark上实现多租户是系统设计之初的主要目的。然后取了动漫《火影忍者》中角色九尾的罗马音['kju:bi:],

CDH 5.x 调优

问题一: mapreduce 分配的内存太小 原因: 由于CDH 默认启用 DRF 计划策略。 DRF: Dominant Resource Fairness,根据CPU和内存公平调度资源。CDH动态资源池默认采用的DRF计划策略。简单的理解就是内存不够的时候,多余的CPU就不会分配任务了,就让他空着;CPU不够的时候,多出来的

cdh中的zookeeper怎么配置zoo.cfg

你手动改了zoo.cfg目录是不会生效的,因为是cdh在管控,所以只能通过cdh修改。 首先打开cdh。 xxx:7180 点击zookeeper 选配置,然后选高级 在右边找,有一个就是zoo.cfg,可以点击右边的感叹号。然后在里面编辑的就会直接写到zoo.cfg里。

[bigdata-030] cdh 5.9的impyla操作hiveserver2

参考文献:http://www.aichengxu.com/view/11094184 1. cdh 5.9 2. 开发机已经安装了impyla pip install thrift_sasl pip install sasl 3. 在cdh集群的一个节点启动hiveserver2 3.1 修改/etc/hive/conf.cloudera.hive/hive-sit

cdh集群迁移 ip更改

#---1.修改每个用户的hosts vi /etc/hosts #127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 172.6.10.20

6.2 Cloudera Manager(CDH)安装

前提:前面安装前准备步骤没有出错 1、安装Cloudera Manager Server、Agent 上传cloudera-manager-el6-cm5.4.3_x86_64.tar.gz 包 mkdir /opt/cloudera-manager tar xvzf cloudera-manager*.tar.gz -C /opt/cloudera-manager

6.1 CDH介绍安装安装前准备

CDH 是hadoop的发行版,是hadoop分支中的一种,由cloudera维护,基于稳定版的hadoop构建,提供hadoop核心 CDH3:是最早版本,对应hadoop1.x版本 开始免费版只支持50个机器 CDH4,CDH5,对应hadoop2.X版 安装方式: clouder Manager 是一个管理CDH端到端的应用,管理监控,诊断,集成 Yum

CDH服务红,查看日志发现host有问题

看host后,发现里面节点ip都是127.0.0.1然后全部改成对应的ip, 1.在/etc/hosts里面全部加上了 ip以及对应的角色名称 2然后注释了127.0.0.1 hostname 3.然后重启所有的机器agent和server,在重新登录,点击重新部署。 重启agent systemctl restart cloudera-scm-agent 重启server syst

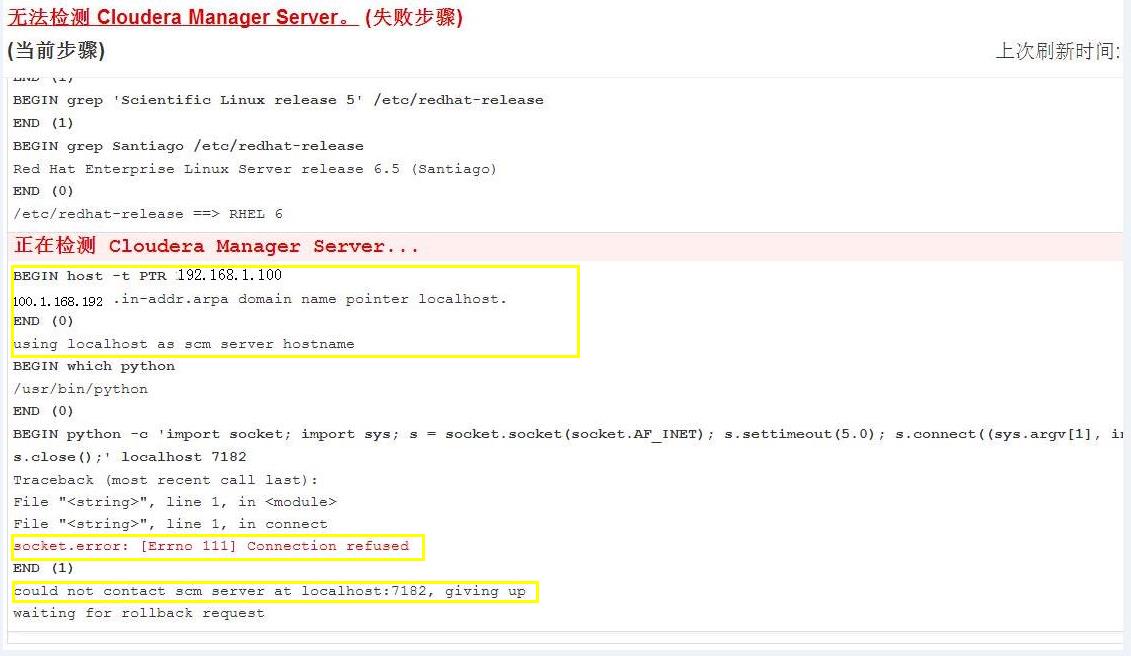

记录CDH安装的一个坑:could not contact scm server at localhost:7182, giving up

错误: 在web界面安装 agent那一步,抛错,单击信息查看如下初步分析: 是用localhost:7182 无法连接scm server 尝试解决办法: 1.检查关闭防火墙 2.检查python版本2.6.6 3.检查/etc/hosts文件,重启网络service network restart 4.检查/etc/sysconfig/network文件,重启网络serv

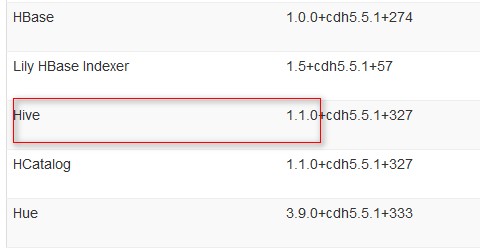

CDH管理界面查看各框架的版本(hive为例)

安装好的CDH如果查看hive的版本呢, 1、官网 2、管理界面中 官网查看一般看到的都是CDH系统默认自带的版本,如果你的CDH在运行的过程中升级过,那再参考官网的版本就会出现错误。 参考:http://www.cloudera.com/documentation/enterprise/release-notes/topics/cdh_vd_cdh5_maven_repo_5

Cloudera Manager CDH 集成 Kerberos

Cloudera Manager5.11.1 集成Kerberos Kerberos 安装配置 Cloudera提供了非常简便的Kerberos集成方式,基本做到了自动化部署。 系统:CentOS 7.3 操作用户:admin 角色分布如下: 角色部署节点KDC, AS, TGS192.168.0.200Kerberos Agent192.168.0.[201-206] 假设sl