bugged专题

论文略读:Window Attention is Bugged: How not to Interpolate Position Embeddings

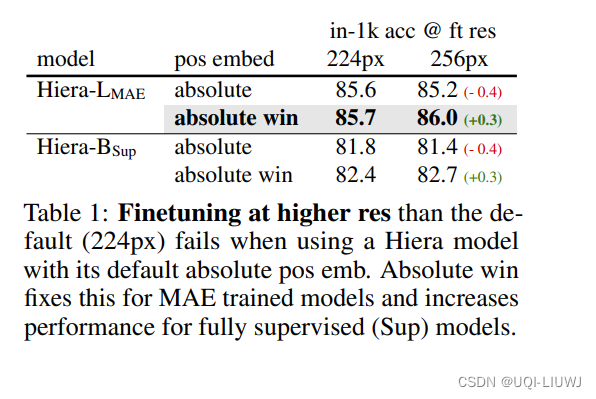

iclr 2024 reviewer 打分 6666 窗口注意力、位置嵌入以及高分辨率微调是现代Transformer X CV 时代的核心概念。论文发现,将这些几乎无处不在的组件简单地结合在一起,可能会对性能产生不利影响问题很简单:在使用窗口注意力时对位置嵌入进行插值是错误的 相对位置嵌入直接添加到注意力矩阵——>不仅速度慢,而且无法从最近的创新中受益理想情况下,希望只使用简单快速的绝对位