本文主要是介绍ffmpeg关于读取av_read_frame音频数据时,AVPacket字段的说明,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

用ffmpeg读取系统声音时,如下所示

av_read_frame(pFormatCtx_Audio, &packet) ;

packet中pts,dts,duration都是基于pFormatCtx_Audio里面对应AVStream的time_base。

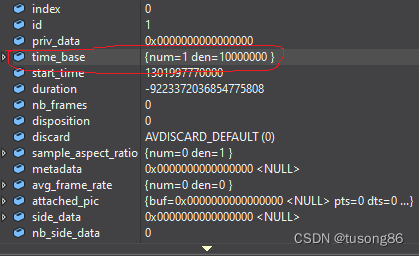

下面我们看下AVStream里面的time_base是1000 0000,即1千万一秒。

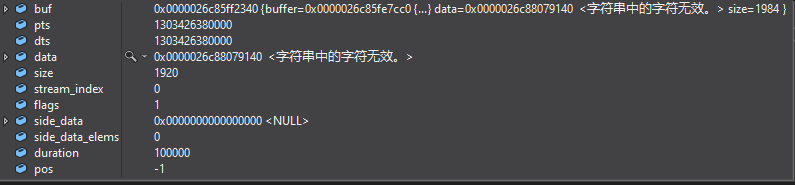

然后我们读取一个packet,其值如下所示:

pts和dts都是1303426380000,这个值太大,我们先不管,我们看下duration字段,值100000,1千万的百分之一,所以读取到的这个音频包是10ms的长度。

我们再通过下面的语句对packet进行解码,解码器的time_base是48000(根据解码器的采样率进行设置)

ret = avcodec_send_packet(pReadCodecContext, &packet);

ret = avcodec_receive_frame(pReadCodecContext, pFrame);

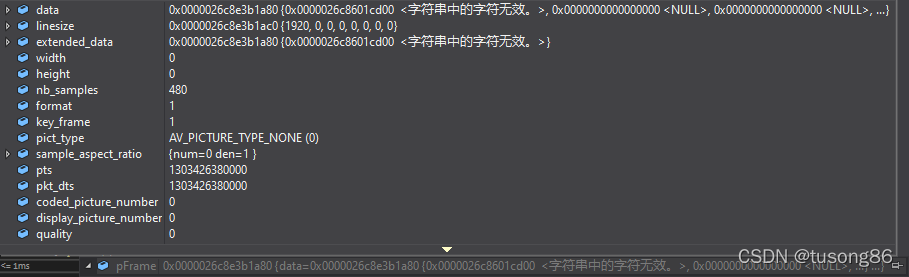

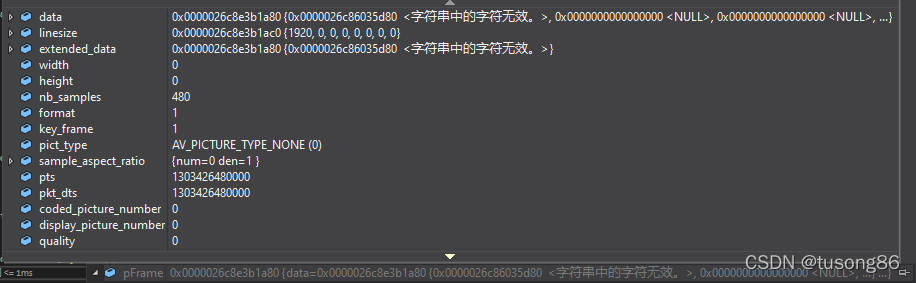

我们观察下pFrame的值,如下:

可以看到转换成AVFrame结构后的样例数nb_samples为480,而解码器的time_base是48000,故AVFrame中的480个样例数刚好代表着10ms,与AVPacket中的duration能够对应上。

同时,我们可以看到,pts和dts相对于AVPacket没有发现变化,都是以AVStream的time_base为时间基。

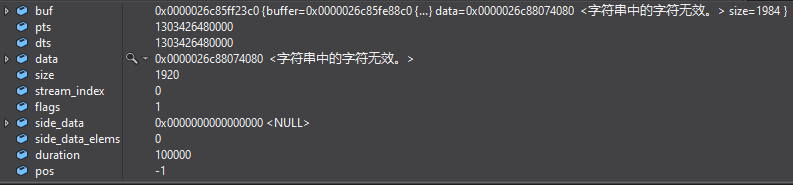

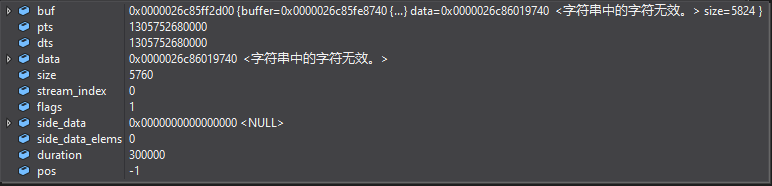

我们接着取第二包数据,AVPacket的数据如下所示:

同样根据duration为100000,判断其为10ms。pts和dts的值为1303426480000,而第一包AVPacket的pts为1303426380000,两者相减,值刚好为100000,代表着10ms,即两个包间距为10ms。

接着用下面语句进行解码。

ret = avcodec_send_packet(pReadCodecContext, &packet);

ret = avcodec_receive_frame(pReadCodecContext, pFrame);

我们观察下pFrame的值,如下:

很明显,样例数还是480,这个是正常的,pts的值跟AVPacket的值一样。

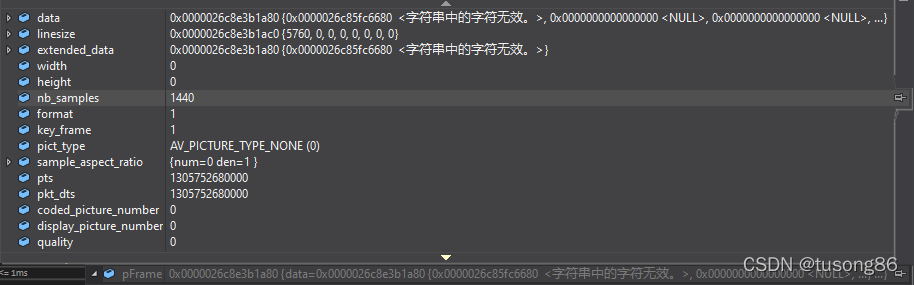

我们接着取第三包数据,AVPacket的数据如下所示:

此时的duration为300000,代表着30ms,pts为1305752680000。与第二包的pts 1303426480000相减,并不是30ms的差值,这个跟我调试时,时间过去太长有关,导致系统对中间停顿的地方没有采集相关声音。

接着用下面语句进行解码。

ret = avcodec_send_packet(pReadCodecContext, &packet);

ret = avcodec_receive_frame(pReadCodecContext, pFrame);

我们观察下pFrame的值,如下:

可以看到nb_samples为1440,相对于采样率48000,刚好也代表着30ms。

这篇关于ffmpeg关于读取av_read_frame音频数据时,AVPacket字段的说明的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!