本文主要是介绍四、K8s etcd相关操作,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

概述:

etcd作为k8s的数据库(键值对形式),记录了用户的操作和数据,只要etcd保存完好,其他pods信息即可根据etcd记录的内容进行回复。在k8s集群初始化后,etcd默认就以pods的形式存在,可以使用命令kubectl get pods -n kube-system查看。

etcd集群是一个分布式系统,使用Raft协议来维护集群内各个节点状态的一致性。主机状态 Leader, Follower, Candidate。默认数据会发送到Leader(2379端口),然后Leader通过Raft协议(2380端口)同步到Follower。当集群初始化时候,每个节点都是Follower角色,通过心跳与其他节点同步数据,当Follower在一定时间内没有收到来自主节点的心跳,会将自己角色改变为Candidate,并发起一次选主投票。

配置etcd集群,建议尽可能是奇数个节点,而不要偶数个节点,否则在一定情况下可能会导致选举Leader出现故障,导致集群无法简历。

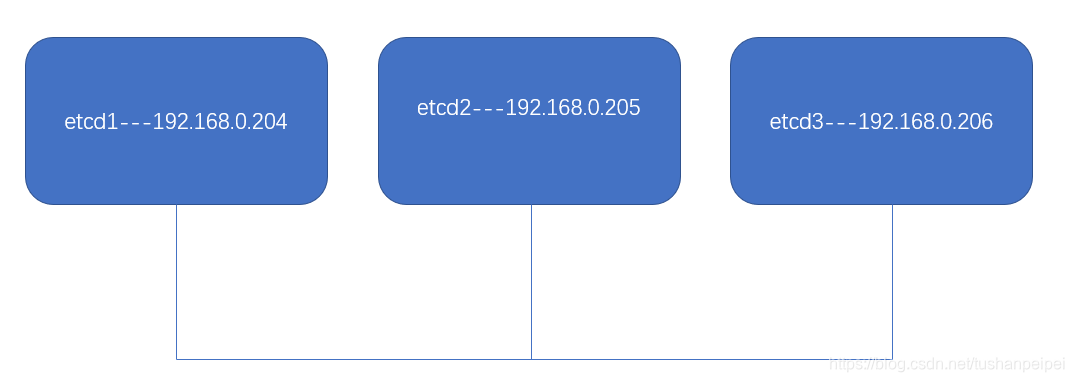

本笔记为了记录etcd的工作方式,于是单独设置了3台设备安装etcd,而不是在k8s集群中使用,拓扑如下:

一:配置单节点集群

步骤1:在etcd1上设置yum云和安装etcd

wget ftp://ftp.rhce.cc/k8s/* -P /etc/yum.repos.d/

yum install -y etcd

步骤2:修改etcd配置文件

cd /etc/etcd/

cp etcd.conf etcd.conf.bakvim etcd.conf

修改的位置为:增加监听自己与外网通信接口(192.168.0.204)。

ETCD_LISTEN_PEER_URLS="http://localhost:2380,http://192.168.0.204:2380"

ETCD_LISTEN_CLIENT_URLS="http://localhost:2379,http://192.168.0.204:2379"

开启etcd服务:

systemctl enable etcd --now

步骤3:查看etcd集群相关信息

查看集群里的etcd节点:

[root@vms204 etcd]# etcdctl member list

8e9e05c52164694d: name=default peerURLs=http://localhost:2380 clientURLs=http://192.168.0.204:2379,http://loca lhost:2379 isLeader=true

查看集群的健康状态:

[root@vms204 etcd]# etcdctl cluster-health

member 8e9e05c52164694d is healthy: got healthy result from http://localhost:2379

cluster is healthy

步骤4:配置远程etcd访问

etcdctl是etcd的客户端工具,不仅可以在本机上查看信息,也可以远程到集群的其他节点查看。

首先需要在etcd1上修改配置文件,允许远程访问:

vim /etc/etcd/etcd.conf

修改内容如下:

ETCD_ADVERTISE_CLIENT_URLS="http://localhost:2379,http://192.168.0.204:2379"

重启etcd服务:

systemctl restart etcd

在etcd2上以同样的方式安装etcd,并执行如下的命令连接到etcd1上,并查看能够执行哪些操作:

etcdctl --endpoints http://192.168.0.204:2379 --help

默认etcdctl使用的是版本2来管理etcd,可以通过设置环境变量的方式,指定使用版本3来管理etcd,功能更加丰富,在etcd1和etcd2节点上:

export ETCDCTL_API=3

设置后再执行,则可以看到更多的操作:

etcdctl --endpoints http://192.168.0.204:2379 --help

如果需要取消环境变量设置,可以使用如下命令:

unset ETCDCTL_API

步骤5:向etcd内写数据,并查看

在etcd1上(etcd2上远程也可以,主要保证etcd1和etcd2上的版本一致,两个版本不可混用):设置键为name1,值为xxxx

[root@vms204 etcd]# etcdctl put name1 xxxx

OK

[root@vms204 etcd]# etcdctl get name1

name1

xxxx

二:配置双节点集群

步骤1:删除掉etcd1现有的集群,并删除数据

systemctl stop etcd

rm -rf /var/lib/etcd/*

步骤2:修改etcd1和etcd2的配置文件

etcd1:

ETCD_DATA_DIR="/var/lib/etcd/cluster.etcd"

ETCD_LISTEN_PEER_URLS="http://192.168.0.204:2380,http://localhost:2380"

ETCD_LISTEN_CLIENT_URLS="http://192.168.0.204:2379,http://localhost:2379"

ETCD_NAME="etcd-204"

ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.0.204:2380"

ETCD_ADVERTISE_CLIENT_URLS="http://localhost:2379,http://192.168.0.204:2379"

ETCD_INITIAL_CLUSTER="etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

其中,ETCD_DATA_DIR定义了数据存放位置;ETCD_INITIAL_CLUSTER设置了集群中的节点数量;ETCD_NAME定义了本etcd的名称;ETCD_INITIAL_CLUSTER_TOKEN需要确保所有节点相同;ETCD_INITIAL_CLUSTER_STATE可以设置为 new 或者 existing,new表示初始化集群,而existing则是加入现有集群。

etcd2:

TA_DIR="/var/lib/etcd/cluster.etcd"

ETCD_LISTEN_PEER_URLS="http://192.168.0.205:2380,http://localhost:2380"

ETCD_LISTEN_CLIENT_URLS="http://192.168.0.205:2379,http://localhost:2379"

ETCD_NAME="etcd-205"

ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.0.205:2380"

ETCD_ADVERTISE_CLIENT_URLS="http://localhost:2379,http://192.168.0.205:2379"

ETCD_INITIAL_CLUSTER="etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

步骤3:启动etcd服务

在etcd1和etcd2上:

systemctl start etcd

systemctl enable etcd

步骤4:查看集群状况

在etcd1查看集群信息:

[root@vms204 etcd]# etcdctl member list

193cd579a601f16a, started, etcd-204, http://192.168.0.204:2380, http://192.168.0.204:2379,http://localhost:2379

591f7e324267e48a, started, etcd-205, http://192.168.0.205:2380, http://192.168.0.205:2379,http://localhost:2379

在etcd1上创建一个目录,并在etcd2上查看是否已经同步:

[root@vms204 etcd]# etcdctl put name1 /aa

OK[root@vms205 etcd]# etcdctl get name1

name1

/aa

三:往现有集群里添加或删除一个节点

步骤1:准备工作

在etcd3上以同样的方法安装etcd,并设置etcdctl版本为3。

步骤2:在etcd1上添加etcd3入集群

etcdctl member add etcd-206 --peer-urls="http://192.168.0.206:2380"

步骤3:修改etcd3的配置文件:

vim /etc/etcd/etcd.conf

编辑的内容:

TA_DIR="/var/lib/etcd/cluster.etcd"

ETCD_LISTEN_PEER_URLS="http://192.168.0.206:2380,http://localhost:2380"

ETCD_LISTEN_CLIENT_URLS="http://192.168.0.206:2379,http://localhost:2379"

ETCD_NAME="etcd-206"

ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.0.206:2380"

ETCD_ADVERTISE_CLIENT_URLS="http://localhost:2379,http://192.168.0.206:2379"

ETCD_INITIAL_CLUSTER="etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380,etcd-206=http://192.168.0.206:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="existing"

修改完成后,在etcd3上启动etcd服务:

systemctl start etcd

然后再etcd1上查看集群内节点,发现etcd3已经加入

[root@vms204 etcd]# etcdctl member list

193cd579a601f16a, started, etcd-204, http://192.168.0.204:2380, http://192.168.0.204:2379,http://localhost:2379

5239dce97489ead4, started, etcd-206, http://192.168.0.206:2380, http://192.168.0.206:2379,http://localhost:2379

591f7e324267e48a, started, etcd-205, http://192.168.0.205:2380, http://192.168.0.205:2379,http://localhost:2379

步骤4:在etcd1上删除节点etcd3

etcdctl member remove 5239dce97489ead4

5239dce97489ead4为etcd3的ID。然后继续查看节点:

[root@vms204 etcd]# etcdctl member list

193cd579a601f16a, started, etcd-204, http://192.168.0.204:2380, http://192.168.0.204:2379,http://localhost:2379

591f7e324267e48a, started, etcd-205, http://192.168.0.205:2380, http://192.168.0.205:2379,http://localhost:2379

在etcd3上停止etcd并删除掉数据信息:

systemctl stop etcd

rm -rf /var/lib/etcd/*

四:给etcd做快照并恢复数据

注意:做快照仅能在etcdctl 3版本中来完成。

步骤1:在etcd1上创建数据

[root@vms204 ~]# etcdctl put name1 aa

OK

[root@vms204 ~]# etcdctl put name2 bb

OK

[root@vms204 ~]# etcdctl get name1

name1

aa

[root@vms204 ~]# etcdctl get name2

name2

bb

步骤2:在etcd1上做快照

[root@vms204 ~]# etcdctl snap save snap1

Snapshot saved at snap1

可以看到备份的文件:

[root@vms204 ~]# ls

anaconda-ks.cfg calico_3_14.tar calico.yaml list_image_from_reg.sh one-client-install.sh set.sh snap1

如果有证书的话,需要加上相关的参数:

etcdctl snap save --cacert=domain1.crt --cert=node1.pem --key=node1.key --endpoints=https://127.0.0.1:2379 snap1

步骤3:删除数据并恢复

在etcd1上删除name1和name2:

[root@vms204 ~]# etcdctl del name1

1

[root@vms204 ~]# etcdctl del name2

1

在etcd1上将快照传输在集群另外两个节点上去:

scp snap1 192.168.0.205:~

scp snap1 192.168.0.206:~

在所有节点上停止etcd并删除数据:

systemctl stop etcd

rm -rf /var/lib/etcd/*

在三个节点上给snap1设置权限:

chown etcd.etcd snap1

在三个节点上恢复数据,etcd1:

etcdctl snapshot restore snap1 --name etcd-204 --initial-cluster etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380,etcd-206=http://192.168.0.206:2380 --initial-advertise-peer-urls http://192.168.0.204:2380 --data-dir /var/lib/etcd/cluster.etcd

etcd2:

etcdctl snapshot restore snap1 --name etcd-205 --initial-cluster etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380,etcd-206=http://192.168.0.206:2380 --initial-advertise-peer-urls http://192.168.0.205:2380 --data-dir /var/lib/etcd/cluster.etcd

etcd3:

etcdctl snapshot restore snap1 --name etcd-206 --initial-cluster etcd-204=http://192.168.0.204:2380,etcd-205=http://192.168.0.205:2380,etcd-206=http://192.168.0.206:2380 --initial-advertise-peer-urls http://192.168.0.206:2380 --data-dir /var/lib/etcd/cluster.etcd

把所有节点/var/liv/etcd的所有者和所属租改为etcd:

chown -R etcd.etcd /var/lib/etcd/

三个节点分别启动etcd:

systemctl start etcd

在etcd1上查看是否还存在之前保存的数据:

[root@vms204 ~]# etcdctl get name1

name1

aa

[root@vms204 ~]# etcdctl get name2

name2

bb

整理资料来源:

《老段CKA课程》

这篇关于四、K8s etcd相关操作的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!