本文主要是介绍MongoDB磁盘空间占满,导致数据库被锁定,如何清理数据和磁盘空间,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、问题

1、我在实际项目中,遇到一个问题,随着数据每天的不断增加,导致mongodb的磁盘空间站满了,数据库被锁了,无法使用。

2、故障表现

-

部署的应用程序突然无法将数据写入数据库,但是可以正常读取数据。

-

管理人员通过客户端连接数据库进行排查时,可以写入一条数据,返回错误信息:

not authorized on xxxx to execute command

3、检查磁盘空间是否被耗尽

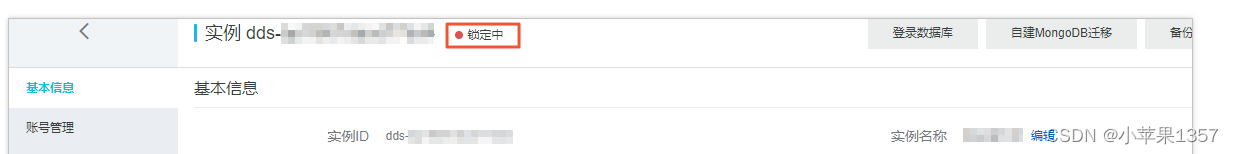

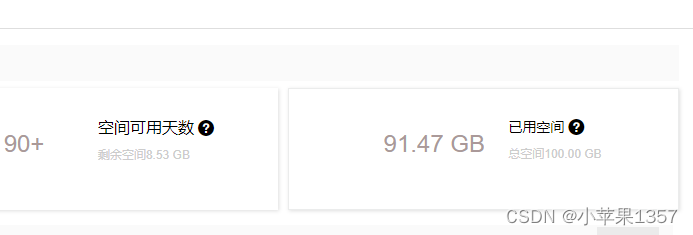

登录mongodb管理控制台,查看实例的状态,会发现已被锁定,并且磁盘空间占用已经100%

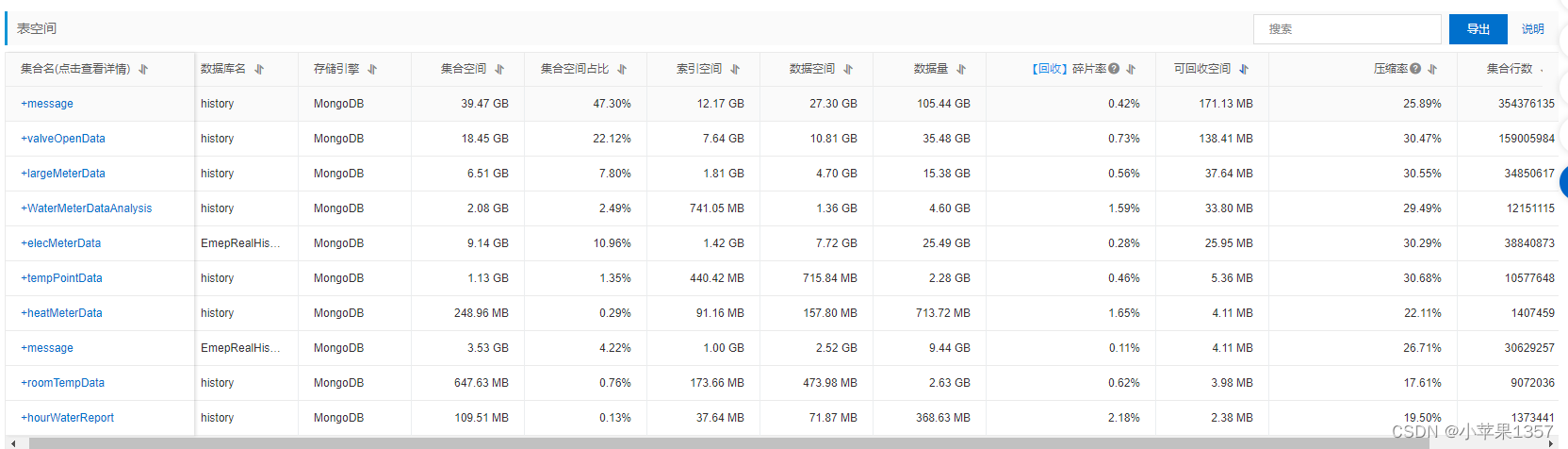

优化之前数据和磁盘情况:

二、解决方案

1、两种方案:

(1)通过变更配置方案,扩充磁盘空间,来提升实例的磁盘空间

(2)删除数据库中的数据,回收磁盘碎片以提升磁盘利用率,来减少数据存储空间,降低磁盘占用空间

我选择了第二种方案,因为我的数据库中,有很多非必要的数据可以删除,可以腾出不少磁盘空间。

2、注意问题

这里一定要注意,并不是在MongoDB实例数据库中删除数据,就能够释放MongoDB实例的磁盘空间。在删除云数据库MongoDB实例的数据后,这些被删除数据使用的存储空间会被标记为空闲,随后写入的新数据可能会被直接存储到这部分空闲的存储空间中,也可能会先扩展文件的存储空间再存储到文件末尾。上述情况将导致一部分空闲的存储空间不会被使用,这些未被使用的空闲存储空间被称之为磁盘碎片,磁盘碎片越多,磁盘利用率就越低。

3、背景信息

(1)执行db.runCommand({collStats: <collection_name>}) 命令访问节点时,返回结果有两个关键字:size和storageSize。其中,size表示集合的逻辑存储大小,storageSize表示集合的物理存储大小。在执行remove命令删除文档后,size的值会减少,但是,storageSize的值不一定会减少。当storageSize大于size时,表示已产生磁盘碎片。

(2)compact是云数据库MongoDB的压缩命令,执行compact命令可以回收删除数据后产生的磁盘碎片,实现压缩磁盘空间的目的,从而提升磁盘利用率。

4、删除数据库数据

这里以表valueOpenData为例子,针对主节点,进行演示操作,之前已经清理了一部分表的磁盘空间,现已经不是100%。

删除数据,是不会减少磁盘空间的,这个一定要注意。

执行删除方案,删除某一段时间之前的数据:

db.valveOpenData.deleteMany({ "dataReadTime": { "$lte": ISODate("2022-12-30T23:59:59Z") }

})5、查看集合需回收的磁盘碎片空间

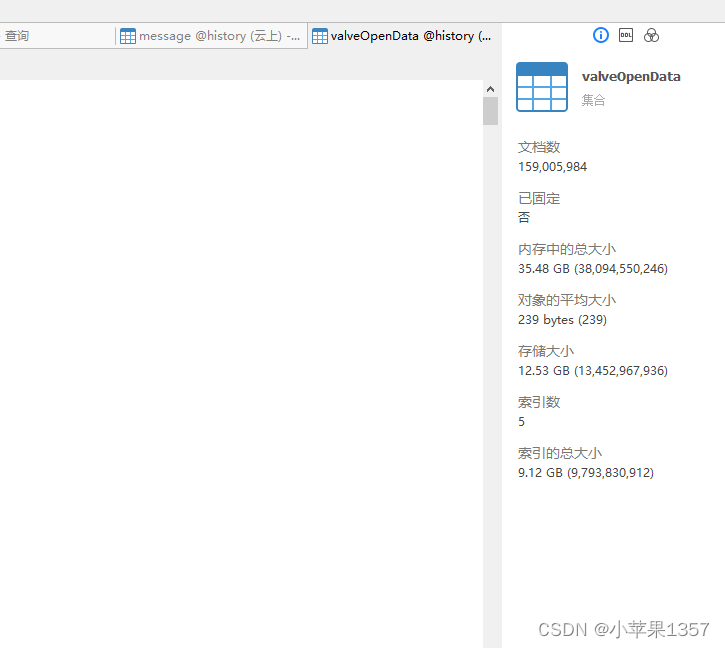

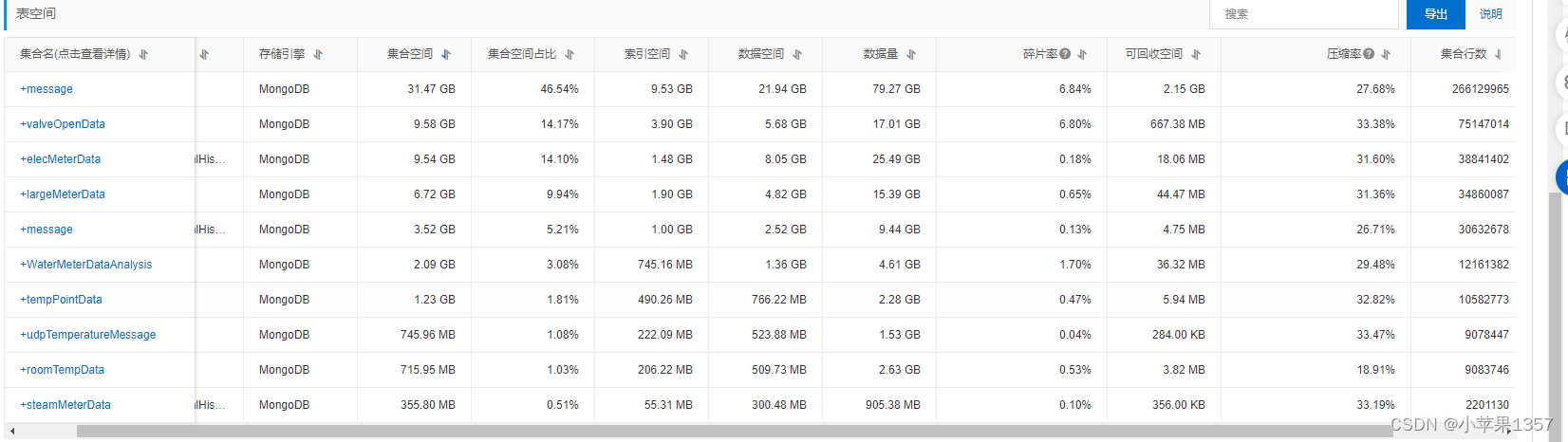

删除数据 清理磁盘之前的总磁盘占用情况

删除数据清理磁盘之前的磁盘占用空间

删除数据清理磁盘之前的数据库情况

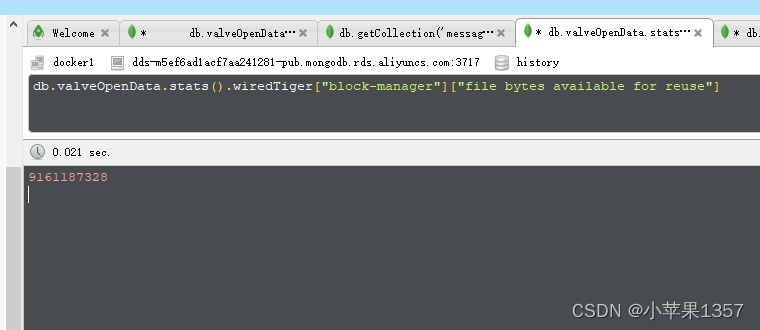

执行查看集合需回收的磁盘碎片空间语句

db.valveOpenData.stats().wiredTiger["block-manager"]["file bytes available for reuse"]结果:可清理磁盘碎片 9161187328 byte

6、回收单节点或副本集实例的磁盘碎片

单节点实例只有一个StandAlone节点,您只需要连接主节点(Primary节点),执行compact命令回收主节点(Primary节点)的磁盘碎片。

副本集实例具有多个节点,您需要分别连接主节点(Primary节点)和从节点(Secondary节点),在不同节点上执行compact命令回收相应节点的磁盘碎片,执行的回收命令相同。

我这里回收的是主节点(Primary节点)磁盘碎片。

执行语句

db.runCommand({compact:"valveOpenData"})强制执行语句

db.runCommand({compact:"valveOpenData",force:true})执行成功的返回结果如下:{ "ok" : 1 } ,清理磁盘空间完成,你也可以多执行几次清理。

执行查看集合需回收的磁盘碎片空间语句

db.valveOpenData.stats().wiredTiger["block-manager"]["file bytes available for reuse"]结果:清理过后磁盘碎片 1072041984 byte

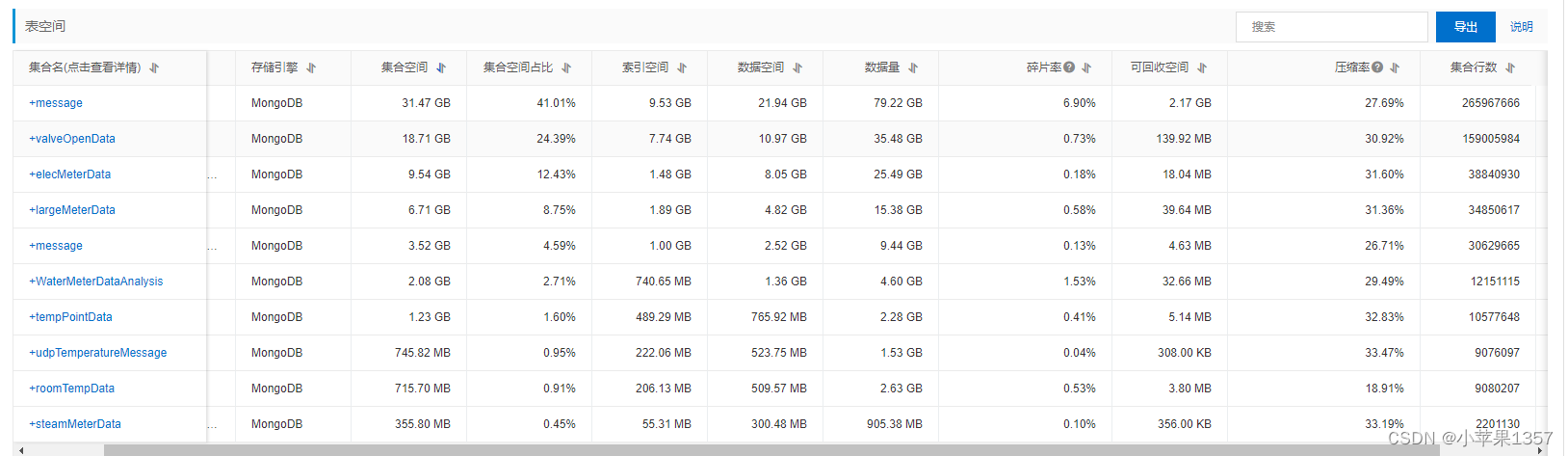

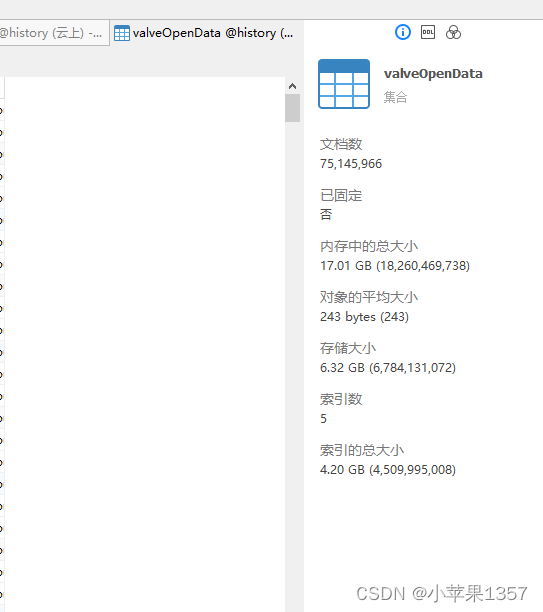

删除数据清理磁盘之后的总磁盘占用情况

删除数据清理磁盘之后的磁盘占用空间

删除数据清理磁盘之后的数据库情况

最终结果:一个表删除数据、清理磁盘,清理出来差不多10G的磁盘空间

三、总结

对于不重要的数据,为了防止数据量过大,占满磁盘空间,需要定时清理过期或者不需要的数据。

最好写个定时器定时删除数据比较合适,但是要记得执行回收磁盘碎片空间,只有执行了回收后,才是真正回收了磁盘空间。

这篇关于MongoDB磁盘空间占满,导致数据库被锁定,如何清理数据和磁盘空间的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!