本文主要是介绍论文笔记:Are Human-generated Demonstrations Necessary for In-context Learning?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

iclr 2024 reviewer 评分 6668

1 intro

- 大型语言模型(LLMs)已显示出在上下文中学习的能力

- 给定几个带注释的示例作为演示,LLMs 能够为新的测试输入生成输出

- 然而,现行的上下文学习(ICL)范式仍存在以下明显的缺点:

- 最终性能极度敏感于选定的演示示例,到目前为止,还没有公认的完美演示选择标准

- 制作演示可能是劳动密集型的,麻烦的甚至是禁止性的

- 在许多 ICL 场景中,演示不仅包含输入和相应的标签,还包括由注释者生成的推理过程

- 对于许多任务(例如,摘要),人类难以表达决策背后的推理过程。

- 论文提问:我们真的需要人类为 LLMs 提供演示吗,还是 LLMs 可以自己生成演示?

- ——>提出了自我反思提示策略(简称 SEC)

- 不使用手工制作的示例作为演示,而是要求 LLMs 首先自行创建演示,基于这些演示生成最终输出

- SEC 有效地解决了 ICL 的缺点:它不仅可以节省制作演示的繁重劳动,更重要的是,消除了人工制作提示的不稳定性

- ——>提出了自我反思提示策略(简称 SEC)

2 方法

2.1 Vanilla SEC

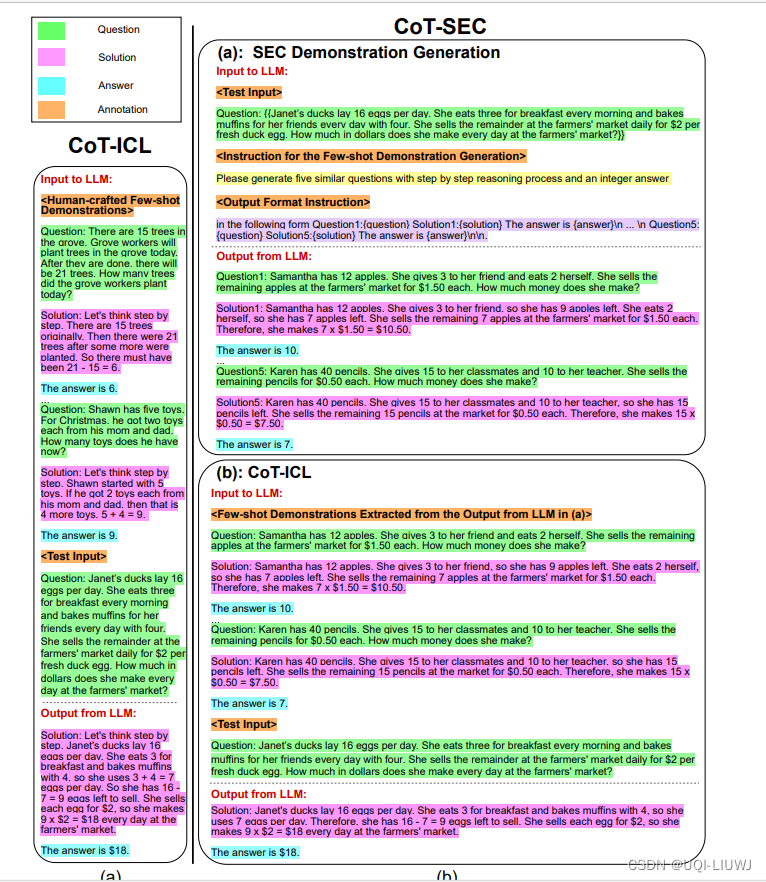

2.2 COT-SEC

原理和2.1是一样的,之不多这边让大模型同时给出推导和答案的样例

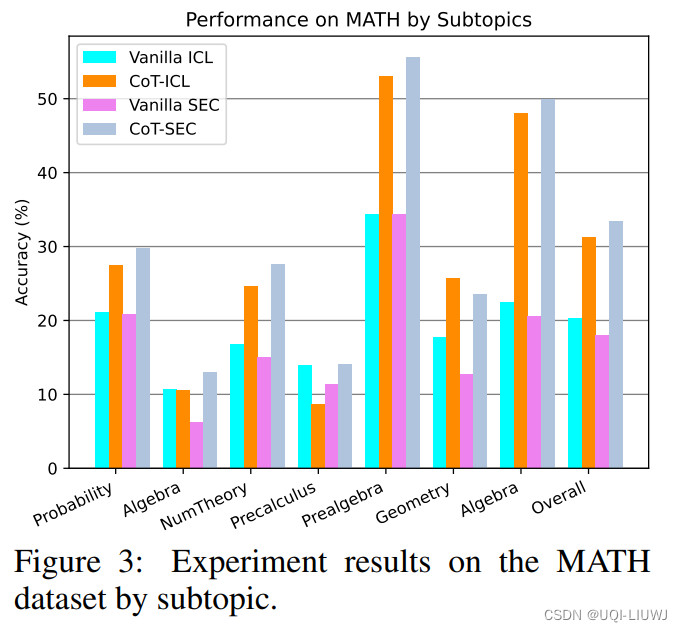

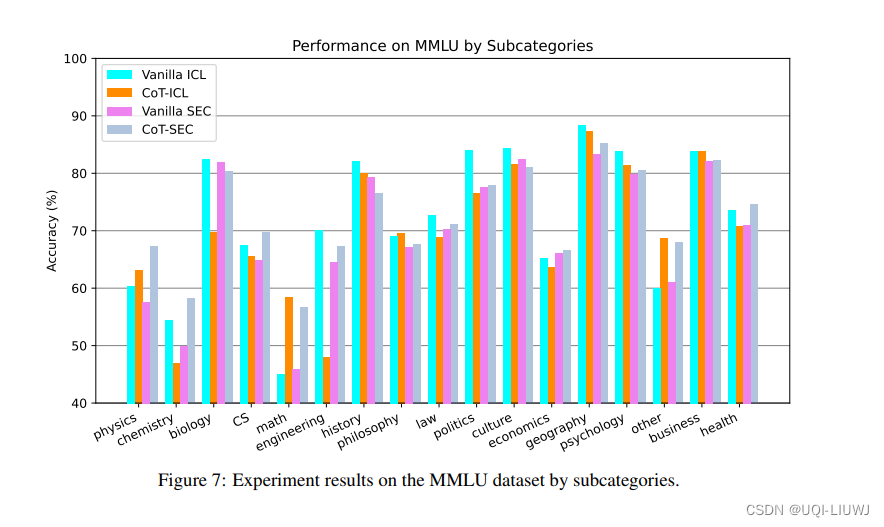

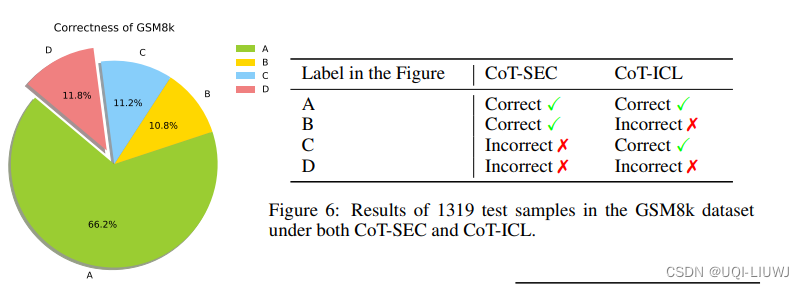

3 实验

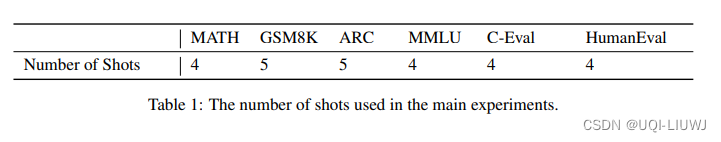

3.1 不同数据集希望LLM 生成的案例数量

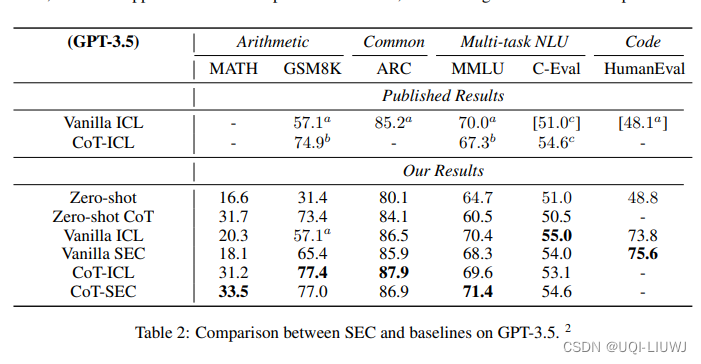

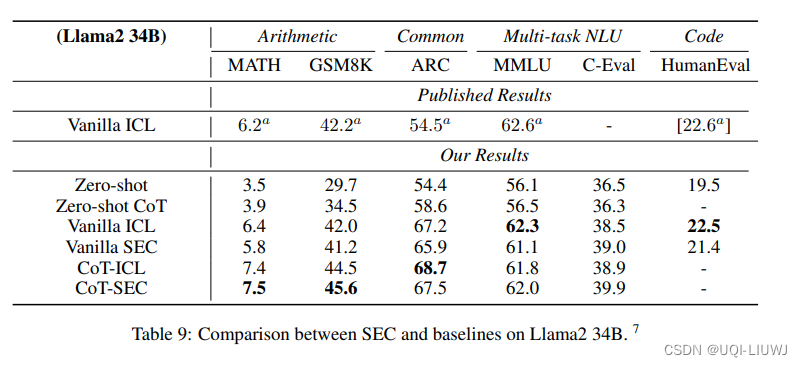

3.2 结果比较

3.2 生成的案例数量的影响

3.3 prompt举例

4 reviewer 意见整理

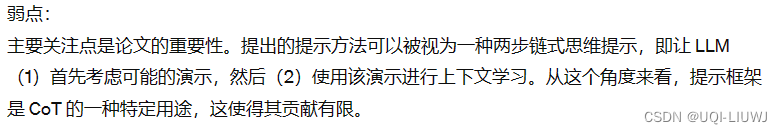

4.1 reviewer1 (6)

4.2 reviewer2(6)

4.3 reviewer3(6)

4.4 reviewer4(8)

这篇关于论文笔记:Are Human-generated Demonstrations Necessary for In-context Learning?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!