本文主要是介绍火山方舟大模型服务平台调用Demo测试(豆包),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

豆包得后台大模型支持为字节得火山方舟,所以想使用豆包的API,直接从这里就可以。

一、首先注册账号:

火山引擎-云上增长新动力

注册完成之后,控制台-账户-API访问密钥

二、找到API测试用例:

二、找到API测试用例:

Skylark-chat API调用说明--火山方舟大模型服务平台-火山引擎

参考python测试用例:

'''

Usage:1. python3 -m pip install --user volcengine

2. VOLC_ACCESSKEY=XXXXX VOLC_SECRETKEY=YYYYY python main.py

'''

import os

from volcengine.maas import MaasService, MaasException, ChatRoleaccess_key = "AKLTND**************Q2OTkxYTgyOGQ"

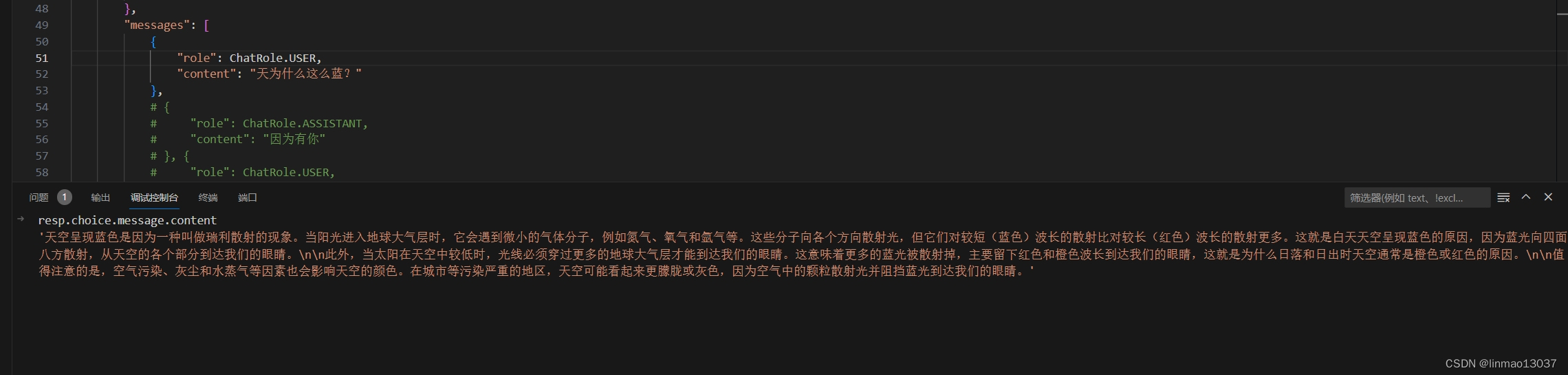

secret_key = "WXpNNU16ZG1PRE*************************NU9EQQ=="def test_chat(maas, req):try:resp = maas.chat(req)print(resp)print(resp.choice.message.content)except MaasException as e:print(e)def test_stream_chat(maas, req):try:resps = maas.stream_chat(req)for resp in resps:print(resp)print(resp.choice.message.content)except MaasException as e:print(e)if __name__ == '__main__':maas = MaasService('maas-api.ml-platform-cn-beijing.volces.com', 'cn-beijing')maas.set_ak(access_key)maas.set_sk(secret_key)# document: "https://www.volcengine.com/docs/82379/1099475"req = {"model": {"name": "skylark-chat",},"parameters": {"max_new_tokens": 1000, # 输出文本的最大tokens限制"temperature": 0.7, # 用于控制生成文本的随机性和创造性,Temperature值越大随机性越大,取值范围0~1"top_p": 0.9, # 用于控制输出tokens的多样性,TopP值越大输出的tokens类型越丰富,取值范围0~1 "top_k": 0, # 选择预测值最大的k个token进行采样,取值范围0-1000,0表示不生效},"messages": [{"role": ChatRole.USER,"content": "天为什么这么蓝?"}, # {# "role": ChatRole.ASSISTANT,# "content": "因为有你"# }, {# "role": ChatRole.USER,# "content": "花儿为什么这么香?"# },]}test_chat(maas, req)test_stream_chat(maas, req)测试结果:

具体更多更详细的说明请参考官方文档!

火山方舟大模型服务平台-火山引擎

这篇关于火山方舟大模型服务平台调用Demo测试(豆包)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!