本文主要是介绍Chen et al. Deep Association Learning for Unsupervised Video Person Re-identification论文翻译,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

原文:https://arxiv.org/pdf/1808.07301.pdf

有些地方翻译地不是很准确,加上DAL系列的paper就只看了这一篇,其它还要去补。不知道它这个为什么要用TensorFlow来训练模型用matlab来评估。其code在:https://github.com/yanbeic/Deep-Association-Learning

Deep Association Learning for Unsupervised Video Person Re-identification

1.简介

深度学习方法开始主导基于视频的人再识别的研究进展。然而,现有的方法主要考虑的是监督学习,这需要详尽的手工工作来标记跨视图对数据。因此,在实际的视频监督应用中,严重缺乏可扩展性和实用性。在这项工作中,为了解决视频人物再识别任务,我们制定了一个新的深度学习方案(DAL),这是第一种在模型初始化和训练中不使用任何身份标签的端到端的深度学习方法。DAL通过在端到端的联合优化两个基于边缘的关联损失,学习了一个深度学习再识别匹配的模型,这有效地约束了每个帧的关联到最佳匹配的相机内表示和跨相机表示。现有的标准CNNs可以很容易地用于我们的DAL方案中。试验结果表明,我们提出的DAL方法在三个基准测试上明显优于目前最先进的无监督视频视频人再识别的方法:PRID 2011、iLIDS-VID、MARS。

2.相关工作

无人监督的基于视频的人再识别在今年来已经开始引起越来越多的研究兴趣。

现在的大多数方法的共同之处在于发现摄像机之间的轨迹之间的匹配相关性。例如,Ma等人提出了一个时移动态变换模型,通过匹配所有时移产生的每个轨迹的部分片段来自动对交叉摄像机轨迹进行匹配。Ye等人提出了一种动态图匹配的方法来挖掘相机标签,迭代学习一种距离度量模型。Liu等人开发了一种逐步度量学习方法来逐步估计跨相机标签,但是它需要严格的视频过滤,以获得一个轨迹、一个ID、每个相机,以区分模型初始化。本文提出的深度关联学习方法在三个方面与以往的研究有明显的不同。(1)不像[26,27],我们的DAL不需要额外的手工工作来选择用于模型初始化的tracklets,这将使大规模视频数据具有更好的可伸缩性。(2)现在所有的方法都依赖于一个良好的外部特征提取器来进行度量学习,而我们的DAL共同学习了一个具有完全端到端的区分表示的重新识别匹配模型。(3)我们的DAL独特地利用了相机内的局部时空一致性和相机间的全局循环排序一致性,以较低的计算成本制定了学习目标。

深度度量学习的目标是一种非线性映射,将输入图像转换为特征表示空间,在这种映射中,同一个类的距离必须很小,而不同的类之间的距离必须保持比较大。一个多样的深度距离度量学习方法能够解决行人再识别的问题,其中最流行的学习约束是两两比较或者三值比较(也成为相对距离比较)。对于两两比较,通常才用二进制分类学习目标或具有相似度度量目标的Siamese网络(孪生网络https://blog.csdn.net/qq_15192373/article/details/78404761)来学习输出两两相似度得分的非线性映射。对于三值比较,一个基于边缘的铰链(hinge)损耗和一个三值组生成的批量构建策略经常部署以最大化匹配对和未匹配对输入之间的相对距离。与大多数监督式深度度量学习学习方法不同的是,我们的DAL学习了一种非监督式的深度嵌入表示。而不是基于少数标记样本的两两或者三方面比较建立学习目标,例如,三个样品作为一个三元组,我们的DAL独特地学习了两组锚点作为相机内部和跨相机轨迹的表示,这允许测量每个图像帧和所有轨迹表示之间的两两相似度,以制定无监督学习目标。

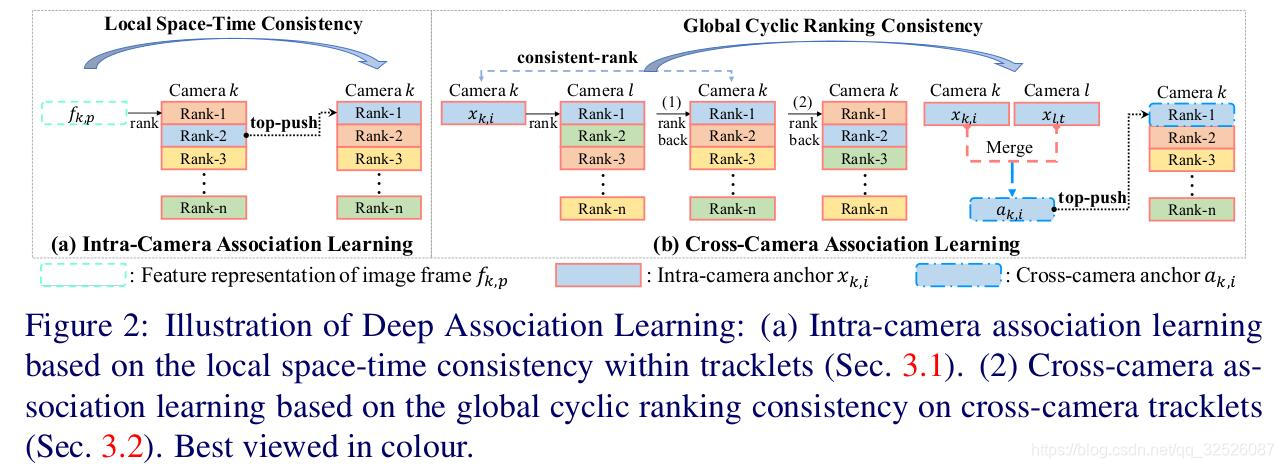

3.深度联系学习

方法概述。我们的目标是学习一个再识别匹配模型来区分外观差异,并可靠地在不适用任何ID标签的情况下跨不相交的摄像机视图来关联视频轨迹。为了实现这一目标,我们提出了新颖的深层联想学习(DAL)方案,基于两种一致性的学习目标派生的深度CNN模型进行优化。如图2所示,我们探索了局部时空一致性和全局循环一致性,以形成两个基于顶推边际的关联损失。特别是在我们损失公式的训练过程中,有两套锚是逐步学习的。他们是(1)一组摄像机间的锚点{xk,i}i=1Nk表示相机内的特征为Nk视频流在相机k(2)一组交叉摄像机的锚点{ak,i}i=1Nk,每一个跨相机特征表示,合并两个高度关联的轨迹从分离的相机视图相机内部特征表示。总之,DAL计划包括两个分批迭代过程(a)相机内关联学习(b)相机间关联学习,如下所示。

3.1相机内关联学习

相机内关联学习的目的是识别相机内的视频轨迹。为此,我们一铰链损耗的形式,根据关联的每一帧图像与同一摄像机视图中所有视频轨迹的排名关系,建立了就顶推边缘的相机内关联损耗。这中损失分为一下三个步骤。

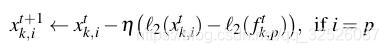

**(1)学习相机内的锚。**根据图一所示的局部时空一致性,每个视频跟踪器可以简单地通过使用特定的时间池策略(如最大池和平均池)来表示单一的序列级特征。然而,在每个小批量学习迭代中这个计算是很耗时的,因为它需要通过深度模型潜亏每个视频轨迹的所有图像帧。为了克服这个问题,我们采用了来自相机K的视频流作为相机内的锚点xk,i,这是在训练过程中,由同一个源轨迹的任何组成图像帧的帧表示fk,p,增量更新的相机内轨迹表示。具体来说,采用指数移动平均(EMA)策略更新每个锚点xk,i,如图1所示。

其中η为更新率,l2(.)是l2正则化,t是小批量学习迭代。作为Xk,i初始化为每个tracklet的帧表示的平均值,并以Eq(1)的形式递增更新,始终在模型学习过程中学习摄像机内锚点来表示每个tracklet。

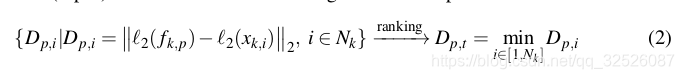

**(2)Tracklet 联系排序。**给定一组相机K增量更新的相机内锚点{xk,i}i=1Nk,基于两两相似度测度,可以生成帧表示fk,p与同一摄像机内所有锚点的关联关系。

我们使用l2距离来测量批内帧表示fk,p和所有相机内锚点{xk,i}i=1Nk。因此,通过fk,p w.r.t{xk,i}i=1Nk的两两相似度进行排序,得到排序列表,其中Rank-1(top-1)相机内的两两距离最小。

其中{Dp,i}是fk,p和{xk,i}i=1Nk两两之间的距离,Dp,t是fk,p和rank-1 tracklet Xk,t之间的距离。

**(3)Intra-Camera Association Loss。**给定帧表示的排序列表fk,p,相机内Rank-1 tracklet xk,t最好与源tracklet xk,p 相对应,后者由于局部时空一致性二包含相同的组成帧。因此,我们定义了一种基于顶推边缘的相关内关联丢失,以强制每个帧与源轨迹的适当关联,以便区分模型学习。

其中[.]+=max(0,.),Dp,p是 fk,p 和 xk,p之间的距离,

其中[.]+=max(0,.),Dp,p是 fk,p 和 xk,p之间的距离,

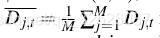

是微型批量中M个采样图像帧与相机K之间的平均Rank-1对距离。m是强制深度模型将tracklet 赋值为top-rank的裕度(margin)。更具体地说,如果rank-1 不是源轨迹(即p≠t),L1将通过施加一个较大的惩罚来修正模型,将源轨迹推到最高位。否则,L1将进一步减小微批量的平均rank-1对距离。由于L1是基于采样的图像帧和每个小批量中最新的相机内锚点进行计算的,因此它可以通过标准的随机梯度下降法有效地优化,迭代地调整CNN参数。总之,L1鼓励学习相机内部轨迹上的区别,以促进更具有挑战性的跨相机联系,将会在下面介绍。

3.2Cross-Camera Association Learing

视频重新识别的关键是利用跨相机ID对信息进行模型学习。然而,这种信息在非监督学习中是缺失的。我们克服了这个问题,通过在模型训练过程中逐步发现交叉摄像机轨迹关联。为了允许从分离的相机视图中学习到相关轨迹对固有的跨相机外观变化的表达表示不变量,我们用与Eq(3)相同的形式建立了另一个基于顶推边缘的相机内关联损失。至关重要的是,我们通过增量学习一组交叉摄像机锚点来扩展轨迹表示,以携带跨摄像机外观变化的信息。这种相机内的关联损失由以下三个步骤构成。

(1)循环排列

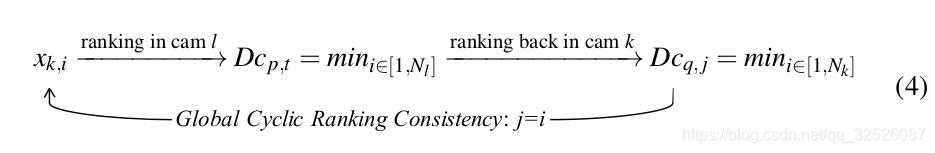

考虑到增量更新的相机内锚点(Eq.1),我们建议利用tracklets之间的潜在关系来发现不同相机tracklets之间的联系。具体来说,我们进行了一个循环的排序过程获得两个高度相关的摄像机内锚,如下所示。

其中Dcp,t表示两个摄像机内锚点之间的相对距离,xk,p来自摄像机K,xl,t来自另一个摄像机l。Dcp,t和Dcq,j表示rank-1对距离。与式2计算两两距离和排序,式4中,我们的目标实在全局循环排序一致性准则下,发现各摄像机之间关联最大的内锚点:xk,p和xl,t是相互的Rank-1匹配对,当其中一个作为查询给出,已在另一个摄像机视图中搜索最匹配的摄像机内锚时。这个循环排序过程在概念上与为加强相似实例之间的两两对应关系而制定的循环一致性约束相关。特别地,在这个过程中,我们的全局循环排名一致性的目的是利用传递性引起的相互一致性,从而在模型训练过程中发现在不相交的摄像机视图之间高度相关的轨迹。

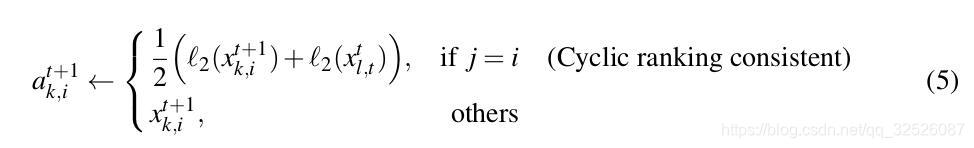

(2)Learning Cross-Camera Anchors.

基于全局循环一致性,我们将跨摄像机cross-Camera作为cross-Camera锚点ak,i 通过合并两个高度相关的摄像机锚点如图2,并将其详细描述如下。

其中,ak,i只是xk,i的副本。如果满足一致性条件(j=i),则每个摄像机内锚点更新为两个摄像机内锚点的算术平均值,否则与摄像机内锚相同。随着深度模型不断更新以区分轨迹间的外观差异,越来越多的相机内锚点被发现高度相关。也就是说,在整个训练过程中,通过合并高度相关的摄像机内锚点来逐渐更新更多的跨摄像机锚点,以携带来自分离摄像机视图但可能描述相同身份的tracklet对引起的跨摄像机外观变化信息。

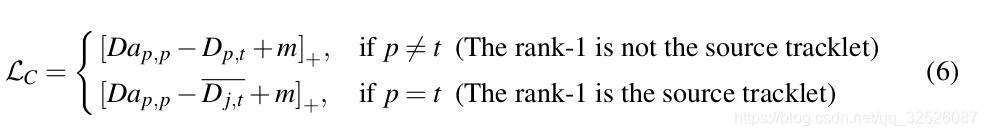

**(3)Cross-Camera Association Loss。**考虑到不断更新的交叉摄像机锚{ak,i}i=1Nk,我们定义了另一种基于顶推边缘的跨相机关联损失,其形式与Eq3相同,以便从跨相机外观变化中学习。

式中Dap,p为帧表示fk,p与交叉摄像机ak,p的两两距离。Dp,t 和非Dj,t都与式(3)中的L1相同。如图2所示,与L1一样,交叉相机联系损失Lc强制深度模型将最好的交叉相机作为top-rank,从而使帧表示fk,p趋向于相应的跨相机表示。

3.3模型训练

**总体学习目标。**DAL最终的学习目标是联合优化两个关联的损失Eq3,Eq6,如下所示。

其中λ是一个权衡参数,设置为1,以确保两个损失项对学习过程的贡献相等。在我们的实验中,式3和式6中的margin m都被经验的设置为0.2。算法1总结了模型训练的算法概况。我们的实现可在https://github.com/yanbeic/Deep-Association-Learning

**复杂度分析。**分析了每批每样本的复杂性成本DAL。在关联排序Eq2中,计算每对的距离每台相机都有批量内的图像帧和Nk内的摄像机的锚,这导致了距离计算的Ο(Nk)和排名的Ο(Nklog(Nk))的计算复杂度。同样,在循环排序Eq4,这个计算复杂度是Ο(Nk+Nl)+Ο(Nllog(Nl))+Nklog(Nk)。为了提高计算效率,所有的距离测量都是在GPU上通过矩阵运算简单计算出来的,单浮点精度。

Algorithm1 DAL

Input:从不同的摄像机捕获的未标记的视频轨迹

output:一个用于重新ID匹配的深度模型

for t=1 to max_iter do

随机抽样的一小批图像帧

网络向前传播

在相机内部的锚定上排列的轨迹线联系Eq2

计算两个基于边际的关联损失项Eq3、Eq6

根据EMA策略更新相应的摄像机内锚点Eq1

根据循环排序Eq4Eq5更新相应的交叉摄像机锚点

通过反向传播更新网络更新Eq7

4.实验

4.1非监督视频人物身份的评价

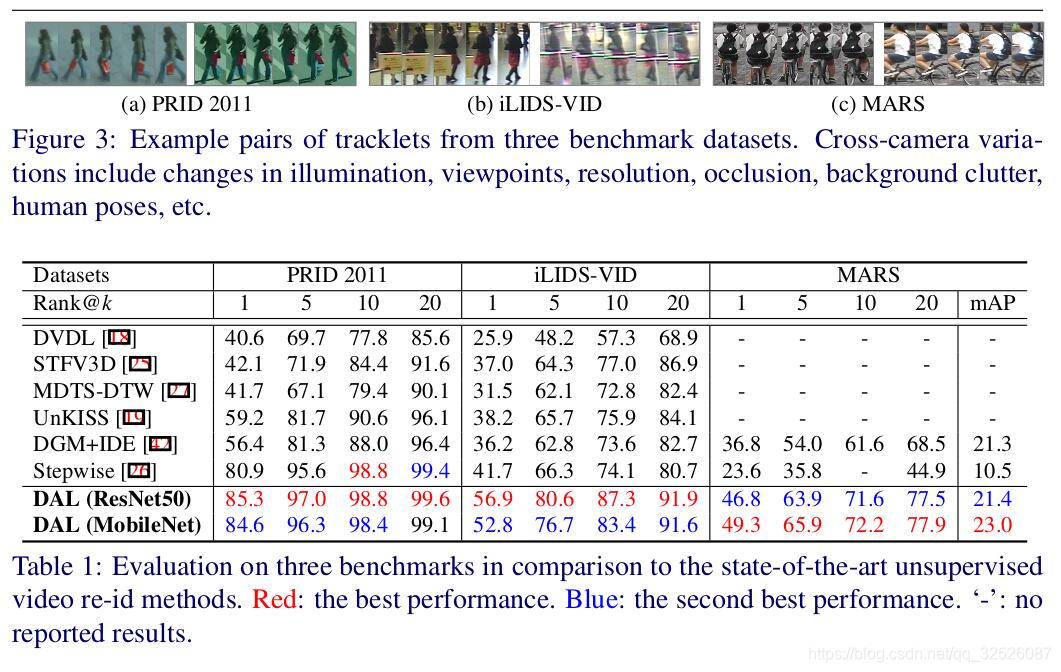

数据集。我们使用了在三个视频人重新识别数据集,包括PRID2011、iLIDS-VID和MARS(Figure3)。PRID2011数据集包含了从两个分离的监控摄像头中捕捉到的1134tracklet轨迹,其中385个和749 个轨迹来自第一和第二摄像头。在所有的视频轨迹中,两个摄像头都捕捉到了200人。iLIDS-VID数据集包含了300人的600个视频轨迹。在机场到达大厅,每个人都有两个轨道,来自两个不重叠的镜头视图。MARS共有20478条轨迹,由1261人组成,这些轨迹都是在大学校园里用近乎同步的摄像头拍摄的。所有的tracklet都由DPM检测器和GMMCP检测器自动生成。

评估协议。对于PRID2011我们使用了[26,37,42]的tracklet对来自178人,每个tracklet包含超过27帧。这178个人被随机地分为两等分用于训练和测试。iLIDS-VID,所有的300个人也被分为两等分用于训练和测试。我们重复10次随机训练/测试ID分割为[37],确保统计稳定的结果。采用平均累计匹配特征(CMC)作为性能指标。对于MARS,我们遵循标准培训/测试分割[45],所有625人的轨迹进行培训,其余636人的轨迹(tracklet)进行测试。平均CMC(Cumulated Matching Characteristics)和平均精度(mAP)都被用来测量MARS上的重新识别性能。注意,我们的方法不适用任何ID标签用于模型初始化或训练。

实现细节。我们在TensorFlow[1]中实现了我们的DAL方案。为了评估其与不同架构相结合的推广能力,我们采用两个标准的CNNs作为骨干网络:ResNet50和MobileNet。这两个深度模型都是在ImageNet上预先训练的权重初始化。在小规模数据中(PRID2011和iLIDS-VID),我们使用RMSProp优化器来训练DAL,20000次迭代,最初学习速率为0.045和衰减指数为0.94/2 epochs。在大规模数据集(MARS),我们采用标准随机梯度下降法(SGD)训练DAL105次,最初的学习率为0.01,衰减指数为0.001在过去的5*104迭代。batch设置为64。在测试时,我们通过图像帧特征上的最大池化层来获得tracklet表示L2正则化。我们计算L2的距离之间的跨相机轨迹表示作为相似度测量的最终视频重新ID匹配。

与最先进的方法比较。我们比较了最先进的基于视频监督的再识别方法:DVDL,STFV3D,MDTS-DTW,UNKISS,DGM+IDE,和Stepwise。在所有的方法中,DAL是唯一一个以端到端方式优化的无监督深度再识别模型。表1展现了在三个基准数据集上,DAL比其他所有竞争对手具有明显的性能优势。特别值得一提的是,PRID 2011的rank-1匹配准确率提高了4.4%(85.3-80.9),在iLIDS-VID上提高了15.2%(56.9-41.7),在MARS上(提高了12.5%)。这一致地表明,与现有的无监督视频重新识别方法相比,DAL的优势在于通过优化两个关联的损失的联合效应,使学习特征表示不变量能够跨相机外观变化,同时区分外观差异。现有强大的模型DGM+IDE额外使用来自一个摄像机视图的ID标签信息进行模型初始化,而逐步通过隐式地使用ID标签,假设每个相机每个ID有一个tracklet。相反,DAL并没有使用这些额外的标签信息进行模型初始化或训练。更重要的是,在不同的网络框架下(ResNet和MobileNet),这表明了它对它现有标准CNNs的适用性。

4.2组件分析和进一步讨论

两个关联损失的有效性。基于两种关联损失的联合效应,DAL训练了深度CNN模型:(1)相机内关联丢失L1(Eq3);(2)跨相机关联丢失Lc(Eq3)。我们通过从整体学习目标中剔除另一项来评估每个损失项的个人效果Eq7。如表2所示,共同优化两个损失导致最佳模型性能。这两种损失项在判别特征学习中的互补优势。此外,与表1中最先进的方法相比,单独使用Lc已经取得了更好的性能。与L1+Lc,单独使用Lc只会降低Rank-1分别在PRID2011、iLIDS—VID、MARS的准确率降低了3.0%(84.6-81.6)\5.4%(52.8-47.4)、1.2%(49.3-48.1)。这表明,即便只优化跨相机关联损失,仍然可以产生具有竞争力的重新识别性能,这是由于它通过在训练过程中可靠地将不同相机视图之间的tracklet关联起来,从而增强相机不变表示学习的额外效果。

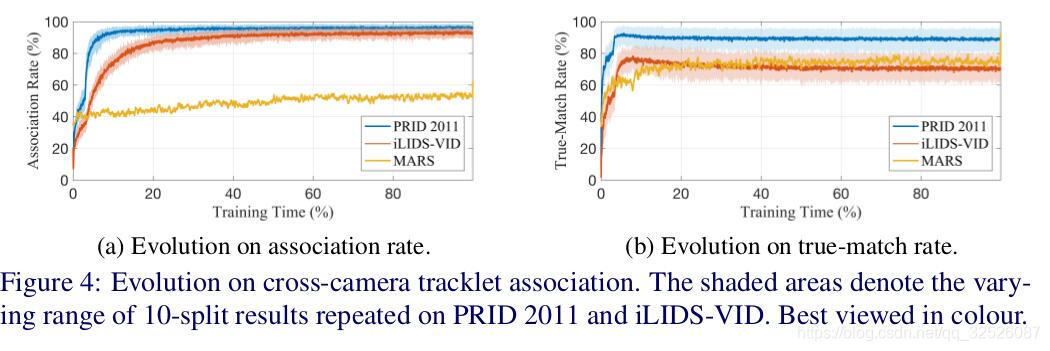

跨相机轨迹(tracklet)关联的演化。如上所述,学习对跨摄像机变化的鲁棒表示是学习有效的是重新识别模型的关键。为了理解在训练过程中利用循环排序一致性发现高度相关的tracklet的效果,我们通过合并两个高度相关的tracklet(相机内锚点)来跟踪更新后表示交叉摄像机锚点的比例。图4显示在PRID 2011和iLIDS—VID上,90%以上tracklet在训练结束时在另一个摄像头下找到高度相关的tracklets。相比之下,DAL并没有使用这些额外的标签信息进行模型初始化或训练。在noiser的大型MARS数据集中,DAL仍然可以在摄像机之间连接超过一半的tracklet(>50%)。重要的是,如图4(b)所示,在自我发现的相关跨相机tracklet对中的,在PRID 2011上真实匹配对的百分比约为90%,在iLIDS—VID上为75%,在MARS上为77%。这令人信服地显示了DAL在自我发现未知的跨相机tracklet关联方面的强大能力,而无需从手动标记的数据中学习。

与监督对等物的比较。我们进一步将DAL与使用ID标记的数据与相同的CNN体系结构(MobileNet),记为ID监督,进行训练的受监督对等者进行比较。这个ID监督室友ID标签上的计算的交叉熵损失训练出来的。表3的结果表示:(1)在PRID 2011和iLIDS—VID上,DAL与ID监督同样出色。这与我们在图4中观察到的高tracklet关联率高度一致,这表明发现更多的跨相机高度关联的tracklet可以帮助我们学习一个对跨相机变化更强的识别性重新识别模型。(2)在MARS上,监督模型和非监督模型之间存在明显的性能差距。这在很大程度上是由于在嘈杂的tracklet中,在一个更大的身份群体中发现跨摄像机tracklet关联的困难导致了一个相对较低的tracklet关联率,如图4a所示。

5.conclusion

在本研究中,我们提出了一种新的深度关联方案(DAL),利用从监控视频数据中提取的未标记的视频tracklet重新识别无监控视频的人。我们的DAL允许在没有任何训练数据ID标签的情况下训练再识别模型,因此与基于监督学习的模型相比,这种模型更适合部署在大型监控视频数据上。与现有的无监督视频再识别方法不同,这种方法要么需要更严格的单摄像头ID标签,要么需要对每个摄像头的tracklet进行过滤,DAL能够在不使用ID标签的情况下自动发现更可靠的跨相机tracklet关联,已处理视频再识别任务。这是通过联合优化两个基于局部时空一致性和全局循环一致性的基于边缘的关联损失来实现的。在三个视频人再识别基准上的广泛比较实验令人信服地显示了提议的DAL方案相对于各种最先进的无监督视频人再识别方法的明显优势。我们HIA提供了详细的组件分析,以进一步讨论我们的方法设计的每个部分如何对整体模型性能做出贡献。

[26] Zimo Liu, Dong Wang, and Huchuan Lu. Stepwise metric promotion for unsupervised video person re-identification. In IEEE International Conference on Computer Vision,

[27] Xiaolong Ma, Xiatian Zhu, Shaogang Gong, Xudong Xie, Jianming Hu, Kin-Man Lam,and Yisheng Zhong. Person re-identification by unsupervised video matching. Pattern Recognition, 2017.

这篇关于Chen et al. Deep Association Learning for Unsupervised Video Person Re-identification论文翻译的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!