本文主要是介绍python3进行中文分词和词性标注,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

配置python环境(win10)

- 下载python3,网址:https://www.python.org/

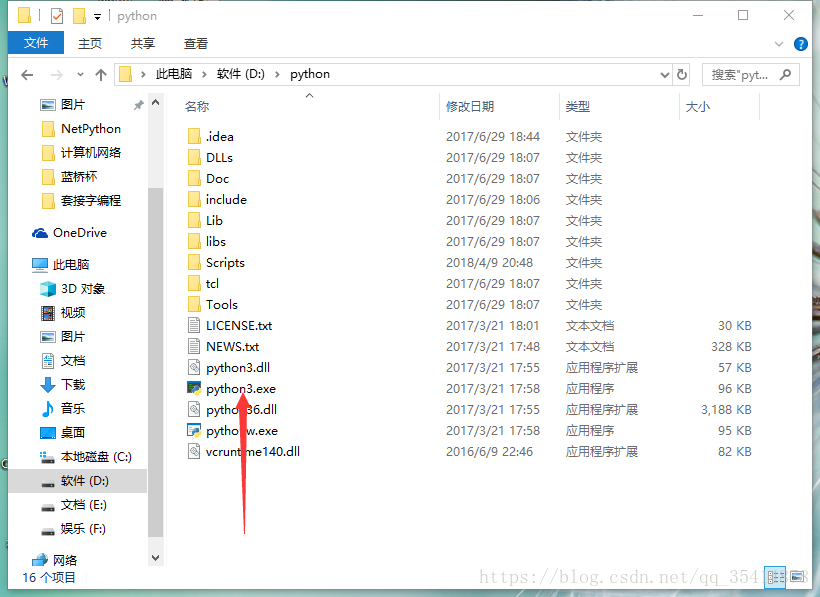

- 双击安装,我安装在了

D:\python中。 - 添加环境变量。

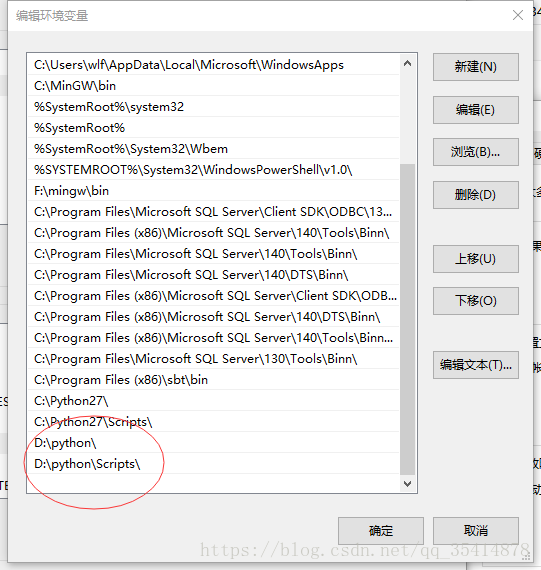

在我的电脑处右键->高级系统设置->环境变量->系统变量->双击path->新建->看下图->确定

- 因为我的电脑已经安装了python2.7(硬要安装python3是因为后面中文分词简便一点),所以这里我把python改成了python3

D盘->python->把python.exe改成python3.exe

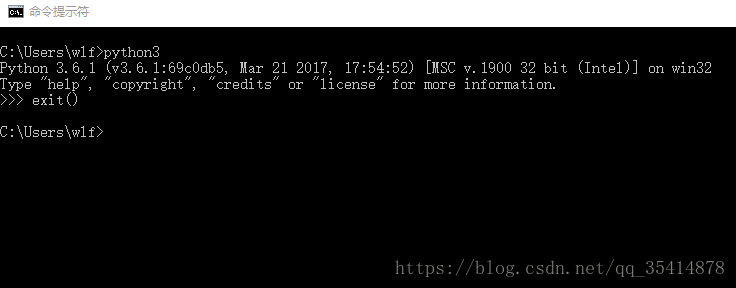

- 验证:在cmd输入python3,进入解释器,然后exit()退出

安装pip

- 下载get-pip.py

- 链接:https://pan.baidu.com/s/1Esd6cgWc8k4wsNmlXh2Cng 密码:uf2o

- cmd切换到get-pip.py的目录,然后输入下面语句安装成功

python3 get-pip.py安装jieba包

- 我这里有个问题,就是python2和python3的pip冲突的问题,所以我在安装时出现了问题,如果没有python2,那么直接

pip install jieba即可,如果和我一样已经给python2安装了pip,那么解决方法,转自知乎匿名用户

python3 -m pip install jieba写代码

我没用pycharm,直接就用sublime text写了,保存为fenci.py ,我用了文件输入输出。如果是python2,读取中文文件可能会出问题解决方法:jingyi130705008博客

#encoding=utf-8

import jieba

import jieba.posseg as psegp = open(r'1.txt', 'r', encoding = 'gbk') //这个在python2中语法错误

q = open(r'2.txt', 'w', encoding = 'gbk')

for line in p.readlines():words = pseg.cut(line)for word, flag in words:q.write(str(word) + str(flag) + " ")q.write('\n')1.txt:我爱北京天安门

2.txt:我r 爱v 北京ns 天安门ns

这篇关于python3进行中文分词和词性标注的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!