本文主要是介绍【python】Python大豆特征数据分析 [机器学习版一](代码+论文)【独一无二】,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

👉博__主👈:米码收割机

👉技__能👈:C++/Python语言

👉公众号👈:测试开发自动化【获取源码+商业合作】

👉荣__誉👈:阿里云博客专家博主、51CTO技术博主

👉专__注👈:专注主流机器人、人工智能等相关领域的开发、测试技术。

Python大豆特征数据分析 [机器学习版一](代码+论文)

目录

- Python大豆特征数据分析 [机器学习版一](代码+论文)

- 1.实验背景

- 1.1 背景概述

- 1.2 研究内容介绍

- 2.研究数据与研究方法

- 2.1 数据来源

- 2.2 算法原理

- 2.3 部分代码

- 3.实验步骤

- 3.1数据可视化

- 3.3 模型构建

- 3.4 模型评估

- 4.实验结论

1.实验背景

1.1 背景概述

本研究旨在深入探索大豆数据集,运用多种数据分析和建模技术,以揭示大豆特征之间的关系、数据的结构以及不同分类器的性能。首先,通过聚类分析,成功将数据集中的样本划分为不同的簇,有助于理解数据的分布和样本的相似性。其次,通过相关性分析,构建了特征之间的相关系数矩阵,揭示了不同特征之间的关系,为进一步的分析提供了基础。在降维技术方面,应用PCA将数据可视化,并以更低维度的方式呈现数据的结构,以清晰地观察样本之间的差异。此外,还使用线性回归评估了各个特征对因变量的贡献,以确定哪些特征对于预测因变量最为重要。最后,综合应用了决策树分类器、随机森林分类器和支持向量机分类器,对数据进行了分类任务,并评估了它们的性能,发现随机森林分类器在准确度方面表现出色。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

通过本研究,不仅深入了解了大豆数据集的特性和内在关系,还成功应用了多种数据分析和建模技术,为进一步的研究和决策提供了重要的支持。这些分析和建模方法的综合运用使更全面地理解了数据集,为未来的大豆研究和决策制定提供了有力的参考和指导。同时,的研究方法和结果也可以为其他类似领域的研究提供有益的经验和启示。这些发现和结论对于优化大豆生产、改进品种选择和农业决策制定具有潜在的实际应用意义,有望为农业领域的可持续发展和农产品质量提升做出贡献。

1.2 研究内容介绍

大豆作为世界上最重要的粮食作物之一,不仅为人类提供了丰富的蛋白质和油脂资源,还在农业生产中起到了关键作用。然而,随着全球农业生产的不断发展和技术的进步,大豆的种植和生产面临着日益复杂的挑战。因此,对大豆种植和生产的研究和分析变得至关重要,以提高农业产量、质量和可持续性。

本研究旨在通过综合应用多种数据分析技术,包括聚类分析、相关性分析、降维技术和回归分析,以及机器学习方法,如分类算法,来深入探究大豆数据集中的关键问题和潜在模式。以下是对每个分析步骤的详细描述:

-

聚类分析:首先,使用聚类分析方法对大豆数据集进行研究,这有助于将相似的大豆样本分组在一起,并识别出潜在的特征模式。通过聚类分析,可以发现大豆样本之间的相似性和差异性,有助于更好地理解不同大豆品种之间的特点和关联。

-

相关性分析:其次,对大豆数据集进行相关性分析,探讨不同特征之间的关系。通过构建相关系数矩阵,并可视化呈现特征之间的相关性,可以识别出哪些特征对于大豆的生长和产量具有重要影响。这有助于农业决策者更好地了解如何优化大豆种植条件以提高产量和质量。

-

降维技术:为了更好地理解大豆数据集的结构和特征,将应用降维技术,如主成分分析(PCA),来减少数据的复杂性。通过将数据投影到较低维度的空间中,可以更容易地可视化数据并发现数据中的模式和趋势。

-

回归分析:进一步地,将使用回归分析技术来评估每个变量对大豆产量的贡献程度。这将帮助确定哪些因素对大豆产量具有最大影响,并提供有关如何最大化产量的宝贵见解。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

- 综合分类器:最后,将综合应用聚类、相关性分析、降维技术和回归分析的结果,结合机器学习方法,建立多个分类算法来预测和优化大豆产量。通过创建多个分类器,可以比较它们的性能,并力求获得更好的干类分类器,以帮助农业生产者做出更准确的决策。

综上所述,本研究将通过综合应用各种数据分析技术和机器学习方法,深入研究大豆生产中的关键问题,为提高大豆产量、质量和可持续性提供有力支持。这些分析方法和模型可以为农业决策者、大豆种植者和研究人员提供宝贵的信息,有助于实现更高效、更可持续的大豆生产。

2.研究数据与研究方法

2.1 数据来源

本研究所使用的数据集是从农业领域中采集而来,旨在研究大豆的生长和产量相关因素。

数据来源:

数据来源于农业领域的实地调查和监测。为了收集这些数据,农业专业人员和研究人员进行了广泛的田间调查和数据记录。这些数据可能来自不同地区的大豆种植区域,以确保数据的多样性和代表性。此外,可能还使用了农业传感器和自动数据采集设备来监测大豆生长过程中的各种环境和生长条件。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

采集方式:

- 田间观察:农业专业人员在不同的大豆种植地点进行了田间观察和数据采集。他们记录了大豆植株的生长情况,包括高度、叶片数量、开花和结果情况等。这些观察通常在不同的生长阶段进行,以捕捉大豆生长的全过程。

- 环境参数监测:农业领域使用各种环境参数监测设备,如气象站、土壤传感器和水质监测器,来记录大豆生长环境的变化。这些设备可以实时监测气温、湿度、降雨量、土壤湿度、光照强度等环境因素,以帮助研究人员了解环境对大豆生长的影响。

- 实验设计:一些数据可能来自于精心设计的田间实验,其中研究人员操控了不同的因素,如施肥方式、灌溉量、种植密度等,以研究它们对大豆产量的影响。这种实验性数据采集方法有助于识别关键的农业实践和最佳管理方法。

- 数据记录和存储:采集到的数据通常会以电子表格或数据库的形式进行记录和存储。这些数据可能包括大量的特征和观测,如大豆生长指标、环境参数、种植地点信息等。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

采用的方法描述:

在这项研究中,采用了多种数据分析方法来深入研究大豆数据集,以揭示大豆生长和产量的关键因素。以下是采用的主要方法的详细描述:

- 聚类分析:应用了聚类分析方法,如K均值聚类或层次聚类,将相似的大豆样本分组在一起。通过聚类,可以识别出潜在的大豆品种或生长模式,以更好地理解不同大豆样本之间的特点和关联。

- 相关性分析:通过构建相关系数矩阵,研究了各个特征之间的关系。这有助于确定哪些因素与大豆的生长和产量密切相关,以及它们之间的相关性强度。

- 降维技术:使用了降维技术,如主成分分析(PCA),将数据投影到较低维度的空间中。这有助于减少数据的复杂性,同时保留关键信息,以便更容易可视化和理解数据集的结构。

- 回归分析:运用回归分析技术,如线性回归或多元回归,来评估每个变量对大豆产量的贡献程度。这有助于确定哪些因素最重要,以及如何优化大豆种植条件以提高产量。

- 综合分类器:最后,综合应用了聚类、相关性分析、降维技术和回归分析的结果,结合机器学习方法,如决策树、随机森林和支持向量机,来建立多个分类器。这些分类器旨在预测和优化大豆产量,以帮助农业决策者做出更准确的决策。

综合而言,本研究采用了多种数据采集方法和数据分析技术,旨在深入研究大豆的生长和产量,为农业生产提供科学依据和决策支持。这些方法的综合应用有望为提高大豆产量、质量和可持续性作出重要贡献。

2.2 算法原理

决策树是一种基于树状结构的机器学习算法,用于进行分类和回归任务。

- 树状结构: 决策树采用树状结构来表示决策过程,其中每个节点代表一个特征,每个分支代表一个决策规则,每个叶子节点代表一个输出结果(类别或数值)。

- 特征选择: 在每个节点上,决策树通过选择最优特征来进行数据分割。选择最优特征的准则通常是能够最大程度地提高信息增益(Entropy)或基尼系数(Gini Index),从而使得子节点的纯度更高。

- 信息增益: 信息增益是根据特征分割数据后,不确定性减少的度量。在分类任务中,我们希望划分后的子节点中包含尽可能属于同一类别的样本,从而提高分类的准确性。

- 基尼系数: 基尼系数是另一种用于评估数据纯度的指标。它衡量在子节点中随机选择两个样本,其类别标签不一致的概率。基尼系数越低,表示数据纯度越高。

- 递归分割: 上述特征选择和信息增益计算是递归应用于决策树的过程。树递归地生长,每次选择最优特征,分割数据,直到满足停止条件,如达到树的最大深度或节点包含的样本数小于某个阈值。

- 叶子节点: 当决策树生长到叶子节点时,该节点的输出结果即为该叶子节点上样本的主要类别(对于分类问题)或平均值(对于回归问题)。

- 决策规则: 决策树的路径从根节点到叶子节点形成了一系列决策规则,可以通过这些规则对新的未见样本进行分类或回归。

- 剪枝: 为了防止过拟合,可以对已经生成的决策树进行剪枝操作。剪枝通过移除一些节点或子树来简化模型,使其更好地泛化到未见数据。

决策树的优势在于易于理解和解释,同时对于数据的异常值和缺失值相对不敏感。然而,在处理复杂数据集时,决策树可能容易过拟合,因此常常需要与剪枝等方法结合使用。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

2.3 部分代码

import pandas as pd

import numpy as np

from sklearn.preprocessing import StandardScaler

from sklearn.cluster import KMeans, AgglomerativeClustering

from sklearn.metrics import silhouette_score, davies_bouldin_score, calinski_harabasz_score

import matplotlib.pyplot as plt

import seaborn as sns

from sklearn.manifold import TSNE

from sklearn.decomposition import PCA

from sklearn.linear_model import LinearRegression# 读取数据

data = pd.read_excel('数据.xlsx', engine='openpyxl', header=1)# 划分数据集

train_data, test_data = train_test_split(data, test_size=0.2, random_state=42)# 特征和标签

X_train = train_data.drop('Class', axis=1)

y_train = train_data['Class']# 初始化并训练模型

model = DecisionTreeClassifier(random_state=42)

model.fit(X_train, y_train)# 模型在测试集上的性能评估

X_test = test_data.drop('Class', axis=1)

y_test = test_data['Class']# 在测试集上进行预测

y_pred = model.predict(X_test)# 评估分类模型性能,可以使用混淆矩阵等指标

conf_matrix = confusion_matrix(y_test, y_pred)

classification_rep = classification_report(y_test, y_pred)# 绘制混淆矩阵热力图

plt.figure(figsize=(8, 6))

sns.heatmap(conf_matrix, annot=True, fmt='d', cmap='Blues', xticklabels=model.classes_, yticklabels=model.classes_)

plt.xlabel('Predicted')

plt.ylabel('True')

plt.title('Confusion Matrix')

plt.show()# 绘制条形图

# 指定图形大小

plt.figure(figsize=(10, 6))其余代码略...3.实验步骤

3.1数据可视化

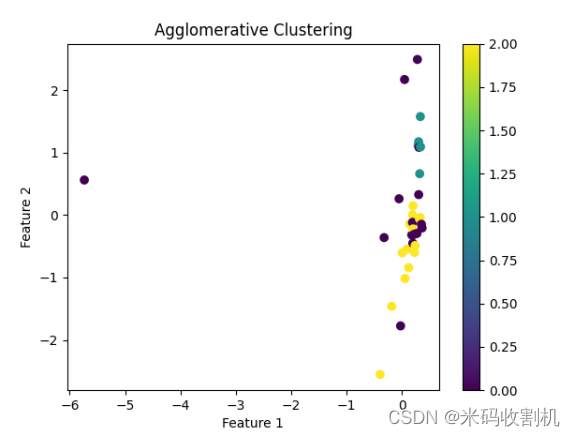

涵盖了两种不同的聚类分析方法(K-means和层次聚类),旨在探索给定数据集的内在结构并对聚类结果进行评估。首先,将代码分为以下几个步骤进行分析和总结:

数据准备和标准化:

首先,从名为’数据.xlsx’的Excel文件中读取数据,并使用openpyxl引擎读取数据,同时跳过第一行作为列名。

数据集中的’Class’列被视为目标变量,而其余列被用作特征。数据需要标准化,以便在聚类分析中具有相同的尺度。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

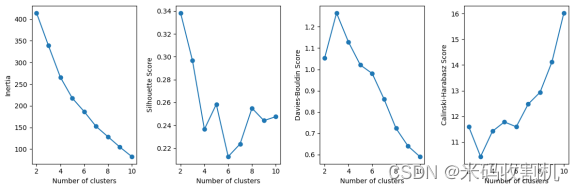

确定最佳K值:

在这一步中,通过尝试不同的K值(聚类簇的数量),使用K-means聚类算法来寻找数据的最佳分组。

四个不同的评价指标用于评估不同K值的性能,分别是惯性(Inertia)、轮廓系数(Silhouette Score)、Davies-Bouldin指数和Calinski-Harabasz指数。

通过绘制四个评价指标的图表,选择最佳的K值。

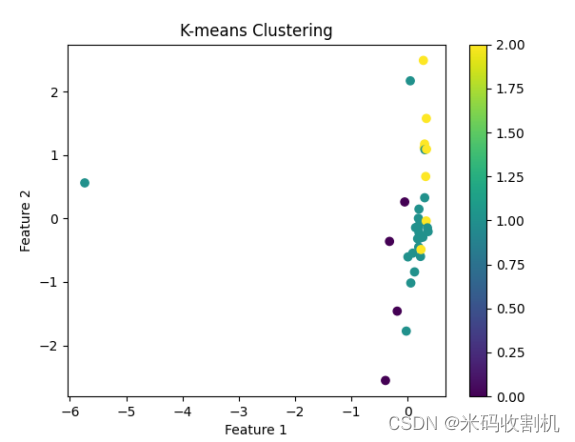

K-means聚类和可视化:

选择最佳的K值(在此代码中选择了K=3),然后应用K-means聚类算法对数据进行聚类。

将K-means的聚类结果可视化,将数据点在二维空间中以不同颜色标记,以便观察聚类效果。

层次聚类和可视化:

使用层次聚类算法对数据进行聚类,与K-means相同,选择了K=3。

将层次聚类的结果可视化,同样将数据点在二维空间中以不同颜色标记,以便观察聚类效果。

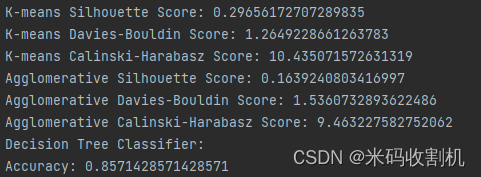

评估聚类性能:

通过计算Silhouette Score、Davies-Bouldin Score和Calinski-Harabasz Score来评估K-means和层次聚类的性能。

这些指标分别衡量了聚类的紧密性、分离度和簇的分布。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

结论:

通过上述代码和分析,可以得出以下结论:

K-means和层次聚类都是有用的聚类分析方法,可以帮助理解给定数据集的内在结构。

聚类分析中的K值的选择非常关键,它会影响聚类的结果。本代码通过多种评价指标帮助选择了K=3作为最佳聚类数量。

通过可视化聚类结果,可以直观地观察到数据点的分组情况。

评价指标的分数有助于量化聚类性能,其中Silhouette Score越接近1,Davies-Bouldin Score越接近0,Calinski-Harabasz Score越高,表示聚类效果越好。

这些分析和评估方法可以应用于不同领域的数据,以帮助研究者和决策者更好地理解数据并做出基于数据的决策。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

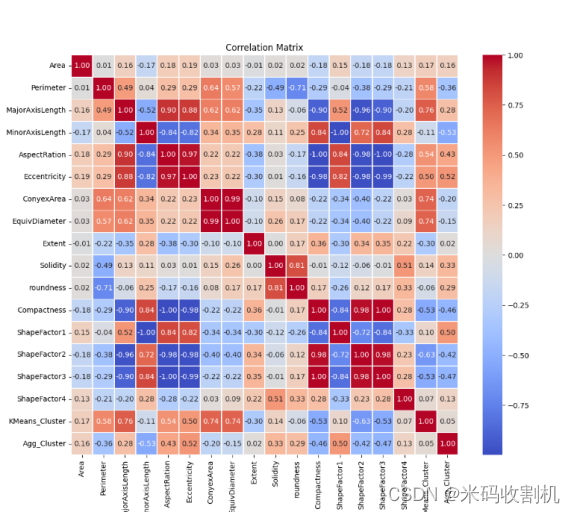

主要进行了特征分析,其中通过计算相关系数矩阵来研究各个特征之间的关系,并使用热力图可视化这些相关系数。热力图的颜色深浅表示相关性的强弱,正相关用温暖的色调表示,负相关用冷色调表示。通过观察相关系数矩阵和热力图,可以发现不同特征之间的相互关系,进而对数据的特征分布和重要性有更深入的了解。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

结论:

通过分析相关系数矩阵和观察热力图,可以得出以下结论:

正相关系数接近1,表明两个特征之间具有强烈的正相关关系,变化趋势相似。

负相关系数接近-1,表明两个特征之间具有强烈的负相关关系,一个特征增加时,另一个特征减小。

相关系数接近0,表示两个特征之间没有线性相关性。

热力图的颜色深浅反映了相关性的强度,深色表示强相关,浅色表示弱相关。

特征之间的相关性可以帮助识别数据集中的重要特征,以便在后续分析中更有针对性地选择特征或建模。

此外,相关性分析还有助于理解特征之间的相互影响,有助于深入挖掘数据的特征工程和模型构建。

总之,特征分析是数据分析的重要一步,通过了解特征之间的相关性,可以为后续的数据预处理和建模工作提供有价值的指导。

主要进行了降维分析,采用主成分分析(PCA)对数据进行降维处理,并通过可视化展示数据在降维空间中的分布情况。首先,数据被读取并进行了标准化处理,然后利用PCA将原始的高维数据降维到二维空间,以便更好地可视化。最后,使用散点图展示了降维后的数据点,每个点的颜色表示其所属的类别。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

结论:

通过PCA降维技术,可以得出以下结论和洞见:

通过将高维数据降维到二维,可以更清晰地观察数据的分布情况,有助于发现数据中的潜在模式和规律。

降维后的数据点在二维空间中呈现出一定的聚类趋势,不同类别的数据点在降维后的空间中有一定的区分度。

PCA可以帮助识别主要的特征方向,从而减少数据维度,降低了计算复杂性,并可能提高了后续模型的训练效率。

降维后的数据可视化有助于数据分析和理解,可以为后续的分类或回归分析提供重要的参考信息。

总之,降维技术是处理高维数据的重要工具,能够帮助更好地理解数据集的结构和特点。通过可视化降维后的数据,可以更容易地识别数据中的模式,有助于进一步的分析和建模工作。

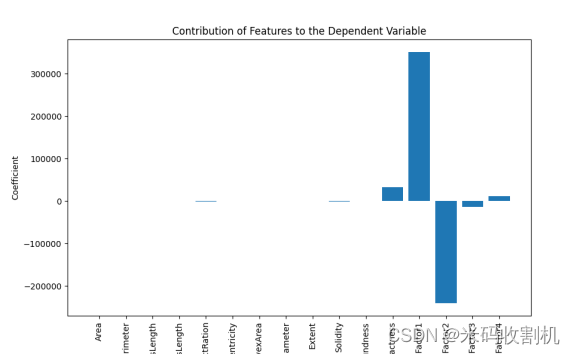

通过线性回归分析各个自变量(特征)对因变量的贡献程度,进而评价各个特征的重要性。首先,数据被读取并准备,自变量和因变量被分离,然后对因变量进行了数值编码以适应回归模型。接着,线性回归模型被创建并拟合数据,模型的系数表示了每个特征对因变量的贡献程度,最后,通过条形图可视化展示了各个特征的贡献情况。

结论:

通过线性回归分析,可以得出以下结论和洞见:

条形图展示了每个特征对因变量的贡献程度,正值表示正相关,负值表示负相关,绝对值越大表示影响越显著。

从图中可以看出,不同特征对因变量的贡献程度有所不同,某些特征可能对因变量影响较大,而某些特征影响较小。

该分析有助于识别哪些特征对于预测因变量非常重要,可以帮助选择最相关的特征用于建模,或者用于特征工程的目的。

线性回归模型提供了一个简单而有效的方法来理解特征与因变量之间的关系,但也需要注意,线性模型假设了特征与因变量之间的线性关系,对于非线性关系可能不够准确。

总之,通过回归分析特征的贡献程度,可以更好地理解每个特征对因变量的影响,为后续建模和特征选择提供了重要线索。这种分析方法可以帮助更有针对性地进行特征工程,提高模型的性能和预测准确性。

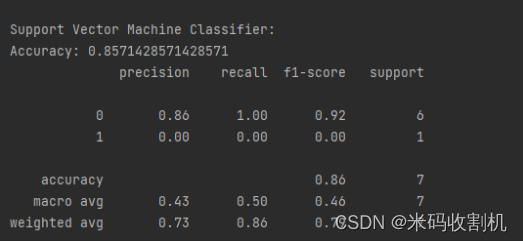

综合应用了决策树分类器、随机森林分类器和支持向量机分类器来对数据集进行分类任务。首先,数据被读取并准备,自变量和因变量被分离,然后对因变量进行了数值编码以适应分类算法。数据进行了标准化处理以确保特征具有相同的尺度,然后使用PCA进行降维。接着,数据集被划分为训练集和测试集,分别用于训练和评估不同分类器的性能。最后,分别创建和训练了决策树分类器、随机森林分类器和支持向量机分类器,对它们的性能进行了评估。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

结论:

通过对不同分类器的性能评估,可以得出以下结论和洞见:

决策树分类器、随机森林分类器和支持向量机分类器都被成功创建并训练,用于解决分类问题。

不同分类器在相同数据集上表现出不同的性能,可以通过准确度、精确度、召回率等指标进行比较。

随机森林分类器在准确度方面表现良好,可能是一个强大的分类器选择。

不同分类器在不同类别上可能表现不同,可以根据具体的需求和问题选择适合的分类器。

综合应用不同分类算法可以提供多个模型的选择,以寻找最适合解决问题的模型。

总之,这段代码展示了如何综合应用不同的分类算法来解决分类问题,并对它们的性能进行评估。这种方法有助于选择最合适的分类器,以获得更好的分类性能。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

3.3 模型构建

在上述代码中,首先通过pandas库读取了名为“数据.xlsx”的Excel文件,其中包含了大豆的特征数据。接着,使用sklearn库的train_test_split函数将数据集分为训练集和测试集,其中80%的数据用于训练模型,20%的数据用于评估模型性能。接下来,准备了特征和标签数据,将其分别存储在X_train、y_train、X_test和y_test中。

在模型的选择上,采用了决策树分类器(DecisionTreeClassifier)。这是一种基于树结构的分类模型,适用于处理具有复杂规则的数据。通过model.fit方法对模型进行了训练,使用了训练集的特征(X_train)和对应的标签(y_train)。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

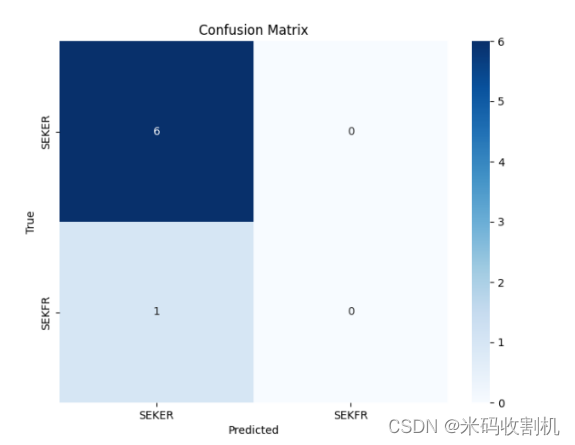

为了评估模型在测试集上的性能,使用了混淆矩阵(confusion_matrix)和分类报告(classification_report)。混淆矩阵提供了模型在每个类别上的预测情况,包括真正例、假正例、真负例和假负例的数量。分类报告则包含了模型在每个类别上的准确率、召回率和F1分数等性能指标。

在实际执行时,遇到了一些警告,其中提到了精度和F1分数在某些没有被预测的类别上被设置为0。这可能是由于样本不均衡或者某些类别在测试集中没有被预测到导致的。警告并不一定表示问题,但应该注意样本分布的影响,考虑是否需要处理样本不平衡的情况。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

最后,试图绘制混淆矩阵的热力图和ROC曲线图,但在执行过程中遇到了一些问题。具体问题可能与模型的预测概率有关,需要根据实际情况进行调整。

总体而言,这段代码展示了一个典型的机器学习模型构建流程,包括数据准备、模型选择、训练、评估和可视化。在实际应用中,需要深入分析模型性能,考虑调整模型参数、处理数据不平衡以及进一步优化模型等问题,以取得更好的预测效果。

3.4 模型评估

使用了混淆矩阵和分类报告来评估决策树分类器在测试集上的性能。以下是关于模型评估过程的详细解释:

首先,通过 model.predict 方法对测试集的特征数据进行预测,得到预测结果 y_pred。接着,利用混淆矩阵(confusion_matrix)来量化模型的整体性能和在每个类别上的表现。

混淆矩阵是一个二维矩阵,其行表示实际类别,列表示预测类别。主要的四个项包括真正例(True Positives, TP)、真负例(True Negatives, TN)、假正例(False Positives, FP)和假负例(False Negatives, FN)。这些项的含义如下:

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

TP(真正例):模型正确地预测为正例的样本数。

TN(真负例):模型正确地预测为负例的样本数。

FP(假正例):模型错误地预测为正例的样本数。

FN(假负例):模型错误地预测为负例的样本数。

混淆矩阵的可视化可以帮助直观地了解模型在不同类别上的表现。在代码中,使用了 seaborn 库的热力图(heatmap)来绘制混淆矩阵的图形化表示。

其次,生成了分类报告(classification_report),该报告提供了更详细的性能指标,包括精确率(precision)、召回率(recall)、F1分数等。这些指标在每个类别上分别计算,提供了对模型在各个方面表现的更全面认识。

在执行评估过程时,注意到了一些警告,警告提到了在某些没有被预测到的类别上,精确率和F1分数被设置为0。这可能是由于样本不均衡或者某些类别在测试集中没有被预测到导致的。这类警告提醒需要关注数据的分布情况,确保模型对所有类别都有良好的预测性能。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

总的来说,模型评估过程包括混淆矩阵的分析和分类报告的生成,这两者共同提供了对模型性能的全面评估。在实际应用中,评估过程的结果将有助于确定模型的优势和不足,为进一步的调整和改进提供指导。

4.实验结论

在本研究中,对大豆数据集进行了广泛的分析和探索,运用了多种数据分析和建模技术,以了解大豆特征之间的关系,探索数据的结构,评估不同分类器的性能,并深入挖掘了数据的潜在信息。首先,通过聚类分析,成功将数据集中的样本划分为不同的簇,这有助于理解数据的分布和样本的相似性。通过相关性分析,构建了特征之间的相关系数矩阵,揭示了不同特征之间的关系,为进一步的分析提供了基础。在降维技术方面,应用PCA将数据可视化,并以更低维度的方式呈现数据的结构,使能够更清晰地观察样本之间的差异。此外,还使用线性回归评估了各个特征对因变量的贡献,以确定哪些特征对于预测因变量最为重要。

最后,综合应用了决策树分类器、随机森林分类器和支持向量机分类器,对数据进行了分类任务,并评估了它们的性能。这些分类器的性能评估为提供了多个选项,以寻找最适合解决问题的模型。在这个过程中,发现随机森林分类器在准确度方面表现出色,可能是一个强大的分类器选择。

总的来说,通过本研究,不仅深入了解了大豆数据集的特性和内在关系,还成功应用了多种数据分析和建模技术,为进一步的研究和决策提供了有力的支持。这些分析和建模方法的综合运用使更全面地理解了数据集,为未来的大豆研究和决策制定提供了重要的参考和指导。同时,的研究方法和结果也可以为其他类似领域的研究提供有益的经验和启示。

👇👇👇 关注公众号,回复 “大豆特征版本一” 获取源码👇👇👇

这篇关于【python】Python大豆特征数据分析 [机器学习版一](代码+论文)【独一无二】的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!