本文主要是介绍NLP-Good Turning平滑,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

1.遇见的问题

2.Good Turning平滑

3.实验数据

1.遇见的问题

这个平滑方法在语言模型里面应用较多。由于我们的词典库中,单词量非常大, 语料中基本上不会完全出现所有的词,因此,如何预测出现新词的概率?

2.Good Turning平滑

首先定义一个N(c):出现c次的单词的个数

比如N(1)=4,意思就是,出现1次的单词的个数为4。

那么对于没有出现过的单词,它们下次出现的概率,是所有出现次数为1的单词的数量,除以出现的单词总数。即P = N(1) / N

以此类推,对于出现过的单词,由于没出现的单词占据了一些概率,因此计算方式也发生了变化:

如下图所示:

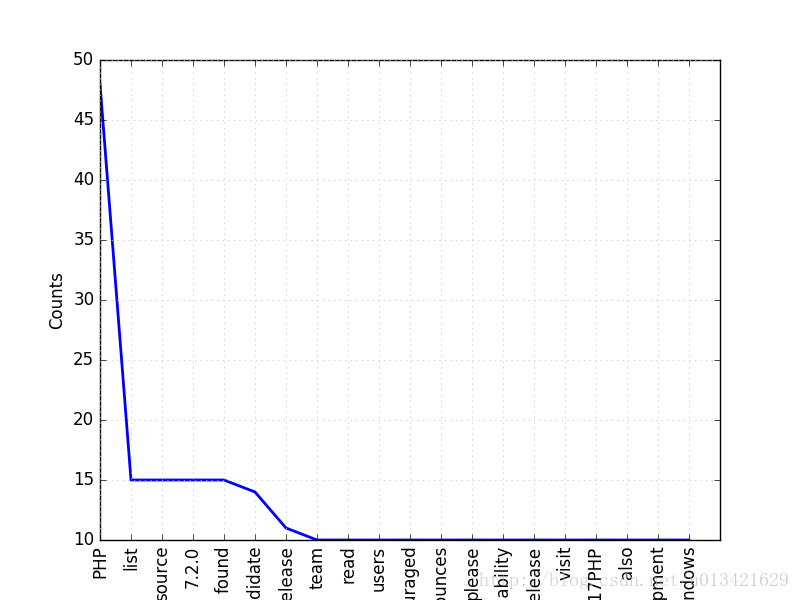

3.实验数据

根据实际的实验数据,生成了如下表格:

每一列分别是:单词出现次数,对应次数的单词出现的数量,通过Good Turning计算的出现的概率,实际测试出现的概率。

可以看出,该平滑方法预测的概率相当准确。缺点是我们计算的时候会依赖于下一个数据,而下一个数据可能没有,可以使用机器学习拟合曲线,补充数据。

这篇关于NLP-Good Turning平滑的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!