本文主要是介绍李宏毅机器学习入门笔记——第五节,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

类神经网络训练不起来的问题解决方式

标准化

对于 error surface 比较崎岖,难以训练的问题,就是可以使用batch normalization。对于不同的变量维度而言,如果差值比较大的时候,存在将预测的结果变大,导致训练的方向不理想。

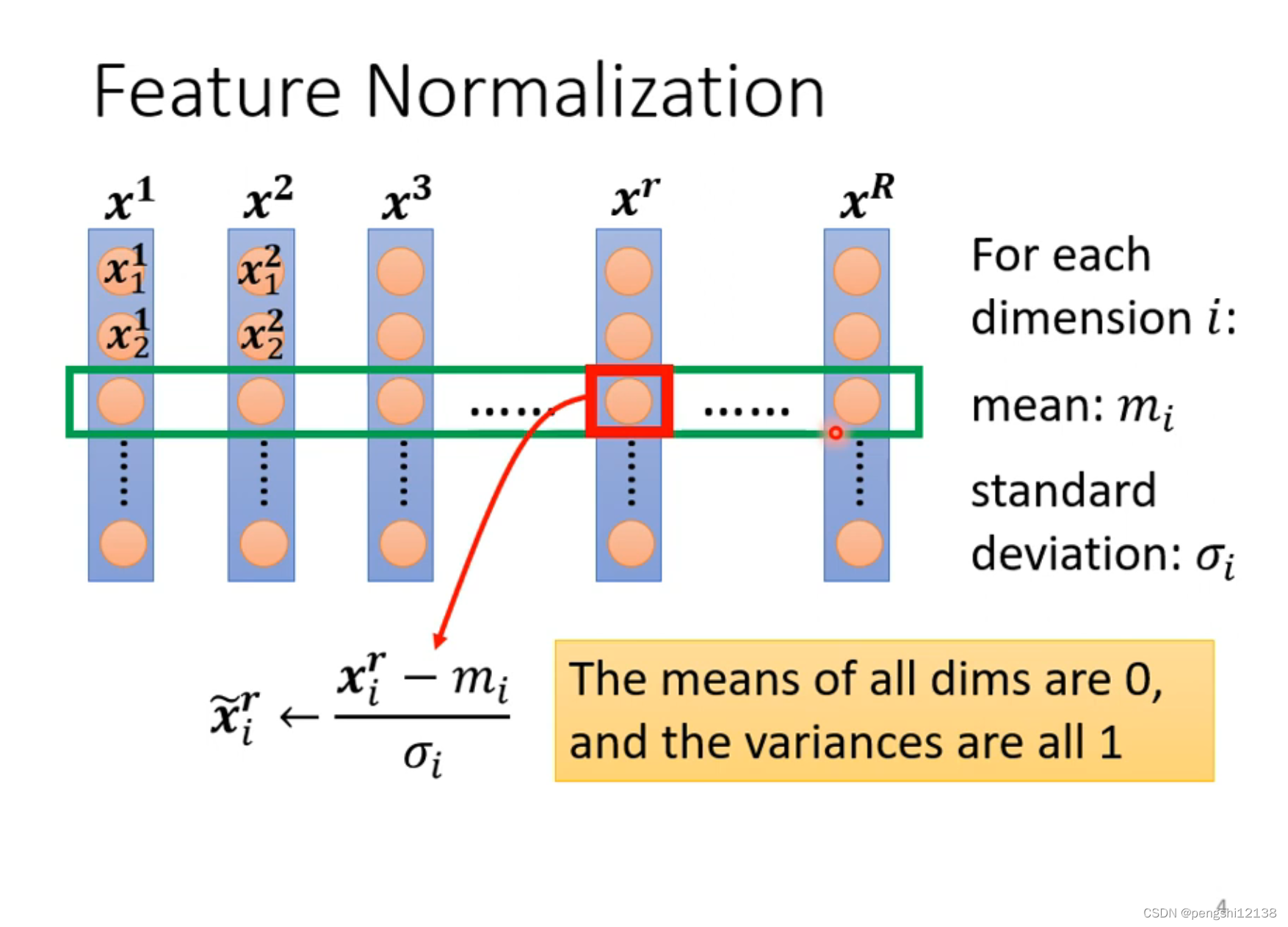

对于不同变量的同一纬度使用归一化操作,即是标准化操作。

要注意的是变量的每一个维度代表一个维度。

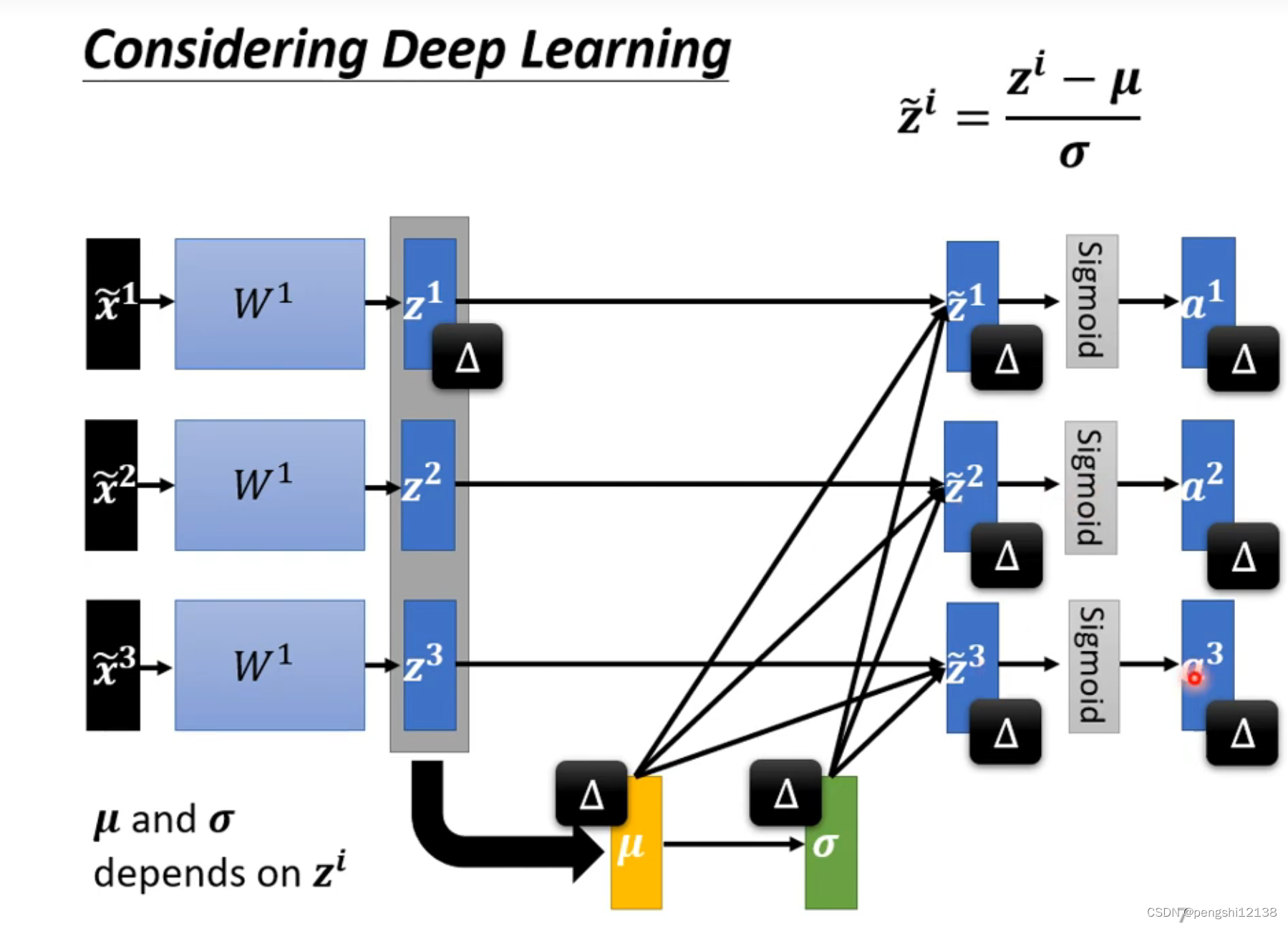

对于每个神经网络层都可以增加标准化层。其中要注意的是层的前后顺序。

当神经网络输入的变量考虑多个输入的时候,对于标准化层,能够通过计算输入的所有变量的标准差和平均值,进行所有的变量进行标准化操作。就是俗称的batch normalization。batch表示就是批量的输入,需要考虑的就是网络的大小。

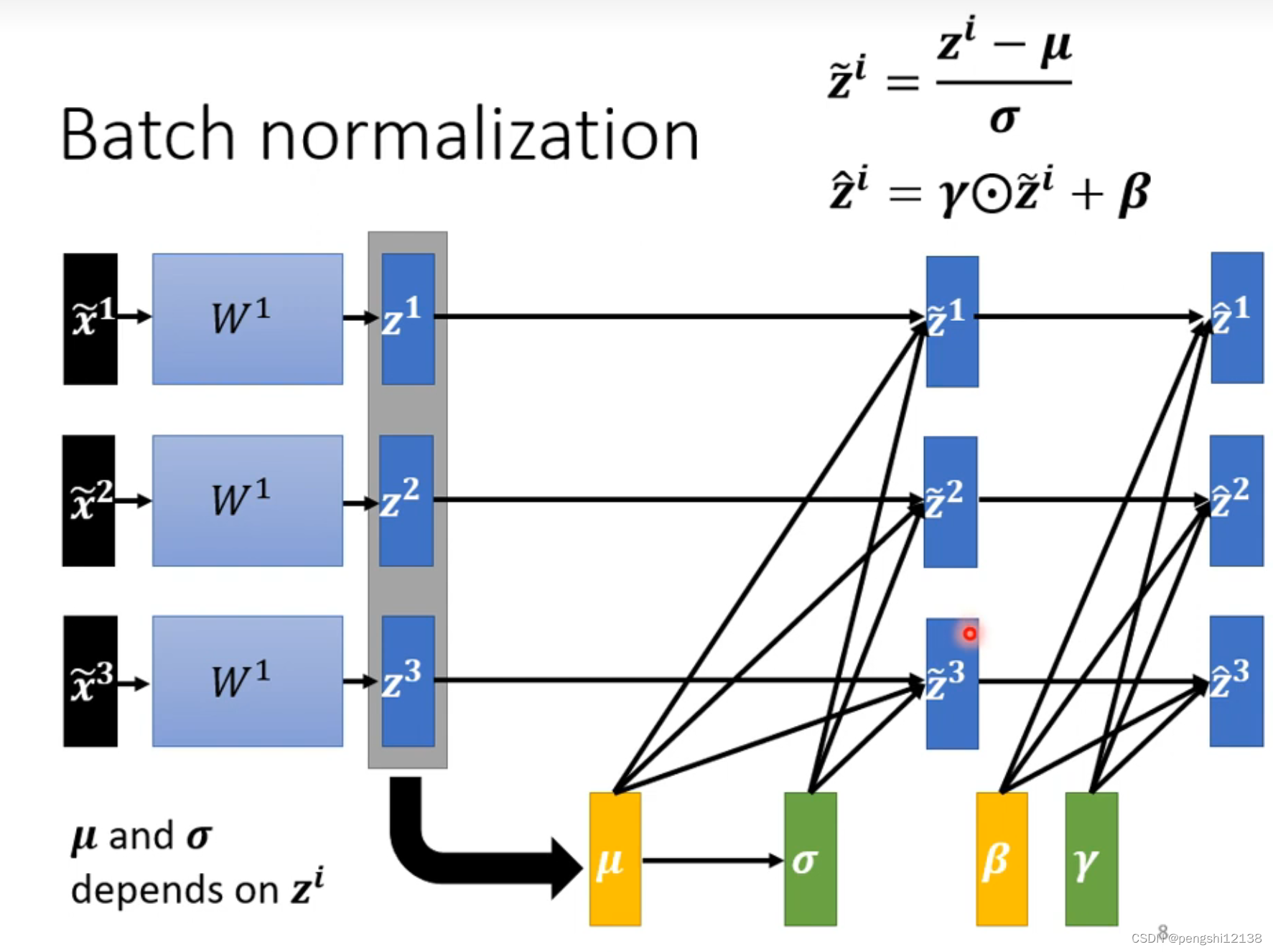

使用多两个额外的参数,是network的参数,因为之前的标准化操作,使得对应的输出值平均为0,但是往往希望平均不是0,不影响对应的模型,所以添加这个两个变量,使对应的均值不是0,主要是看模型的训练,可能是均值0,可能不是。

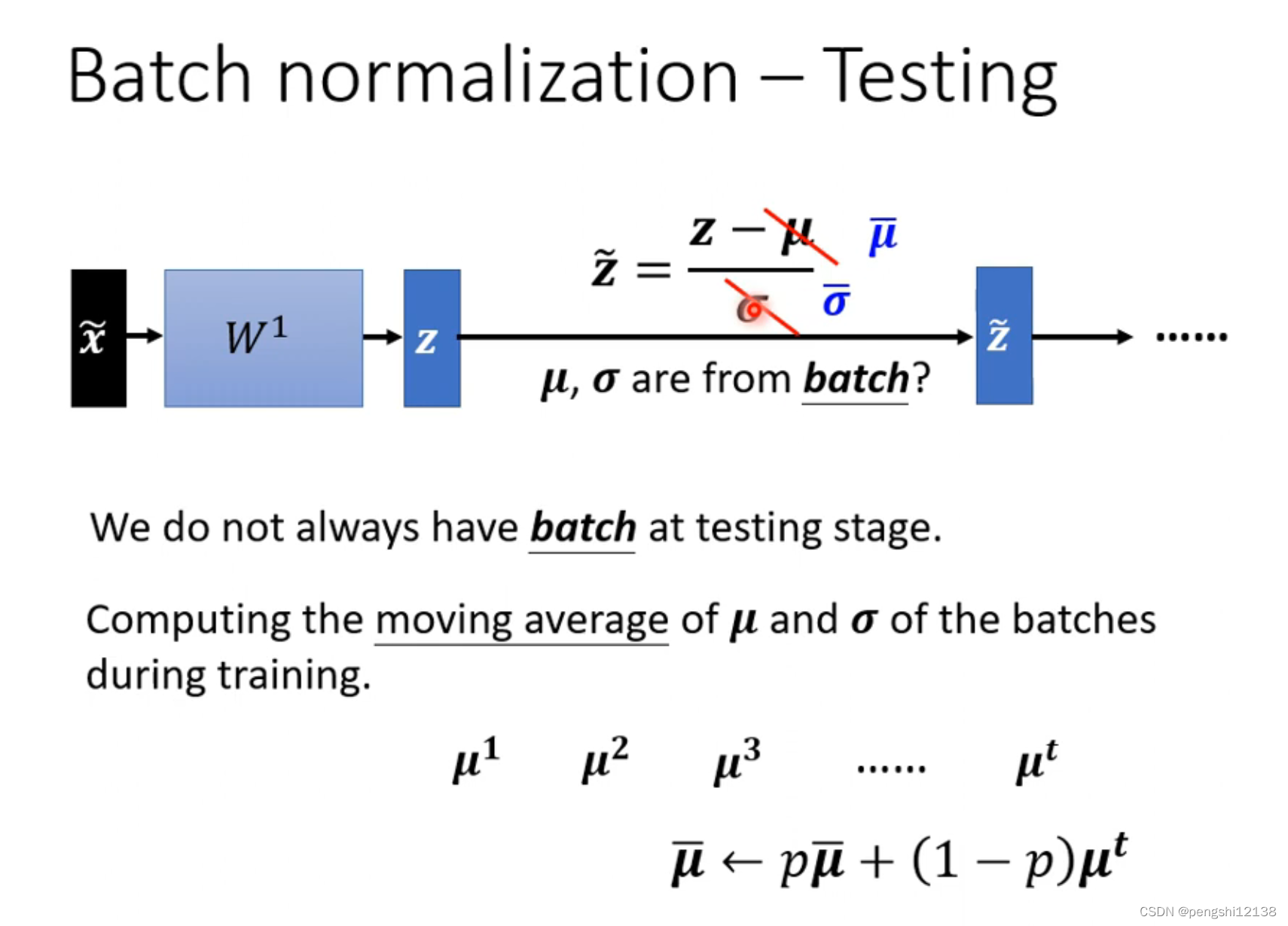

需要考虑对应的另一个问题,因为标准化是batch数量,但是在test过程中,就会存在输入的数量是1个情况。所以test解决方式就是累计计算的过程。通过train的时候计算得出的方差和均值,进行计算。

transformer (对应的作业5)

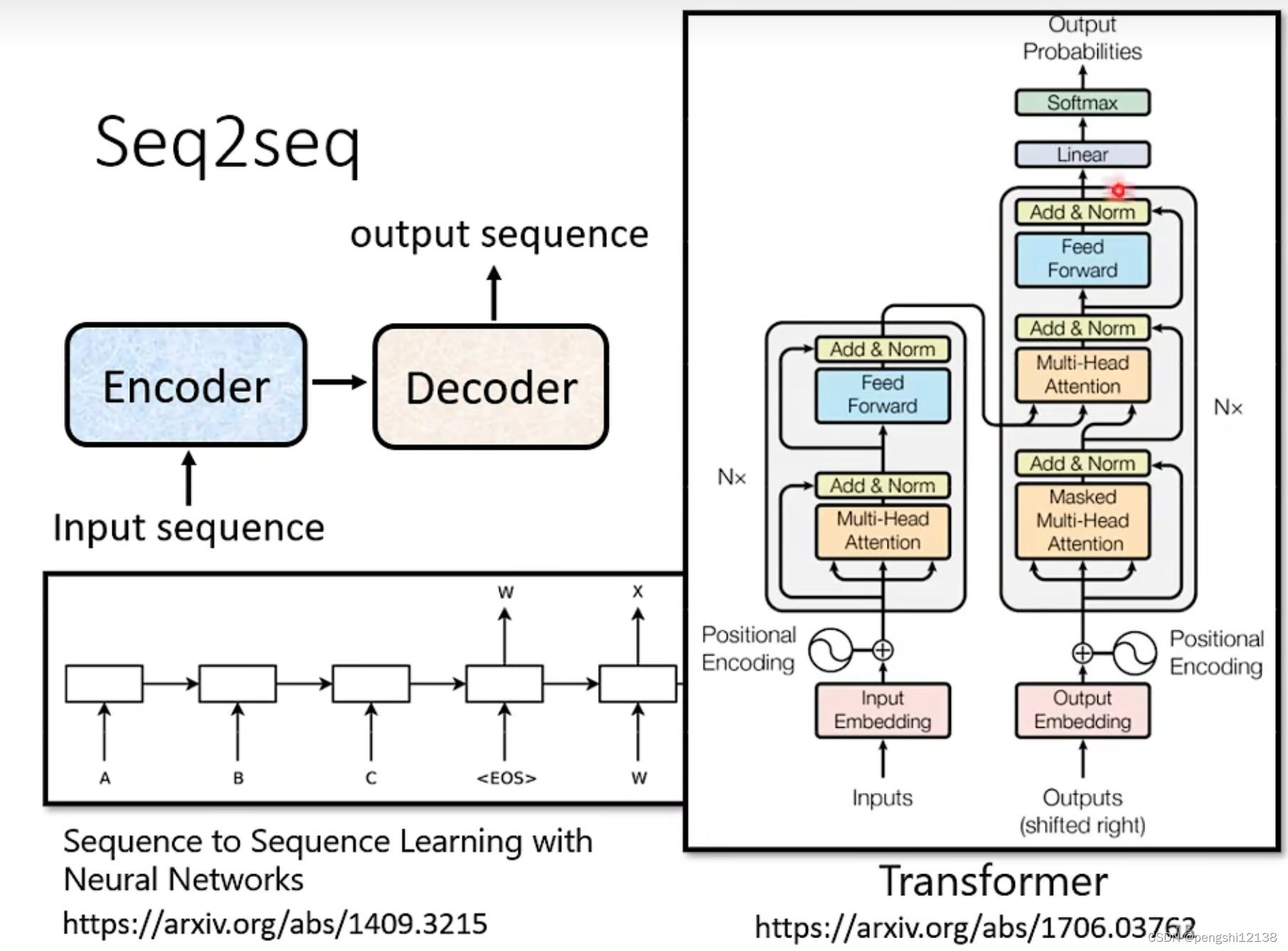

transformer就是变形金刚。其实就是一个sequence to sequence的模型。

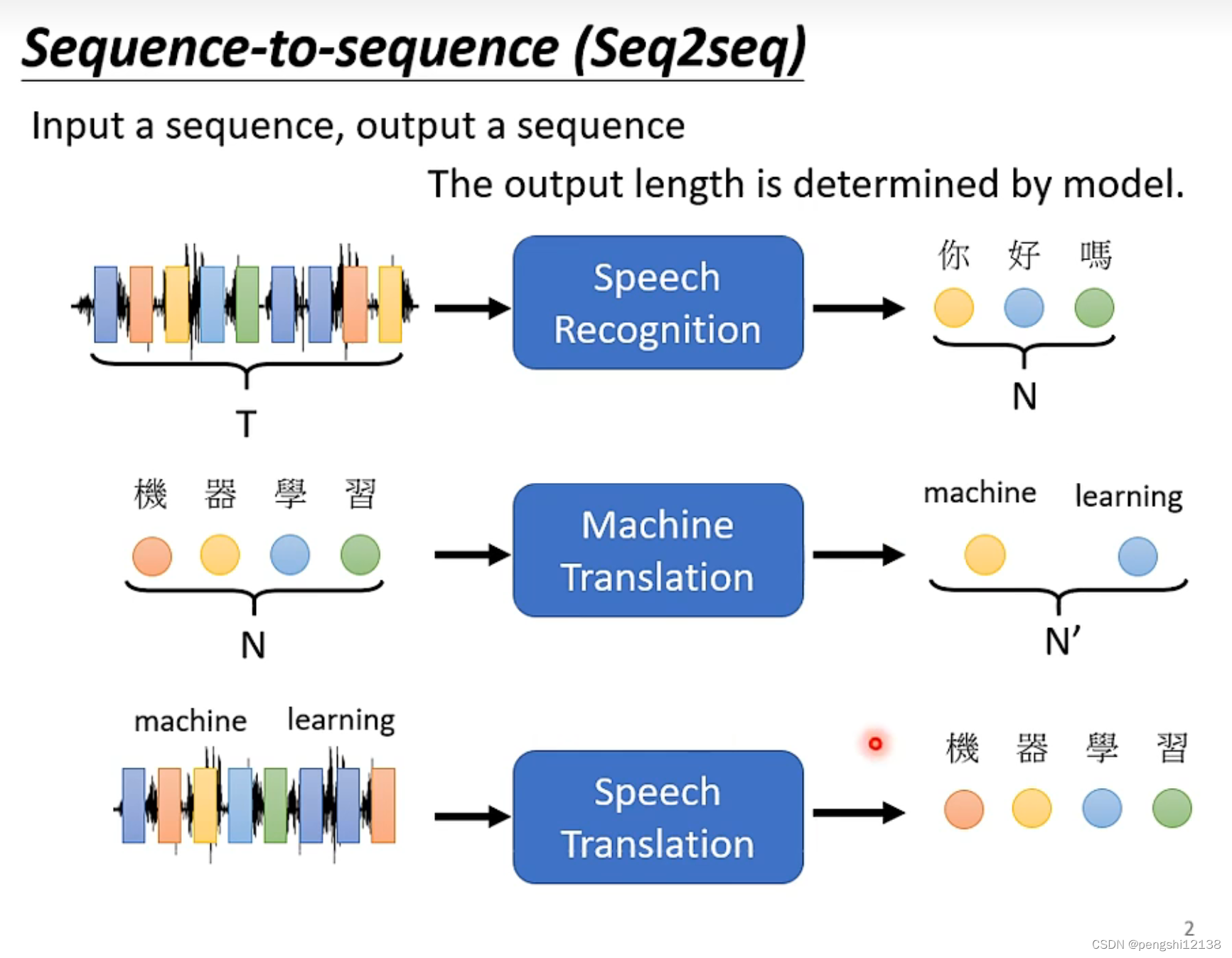

对于多个输入变为多个输出的过程,例如语音识别文字或则和机器翻译的过程都是不对等的输入输出的模型。

大量的应用在自然语言应用上。

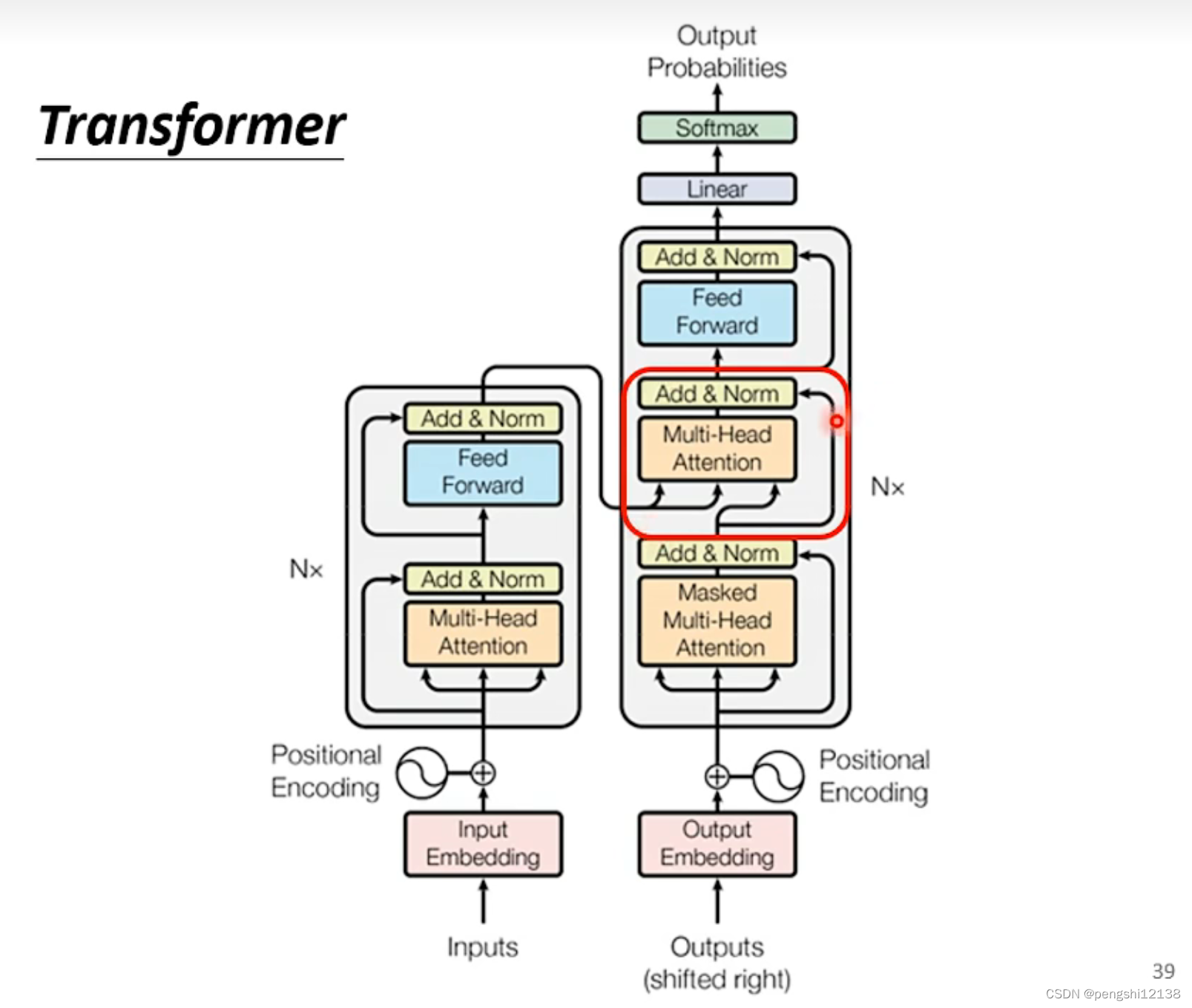

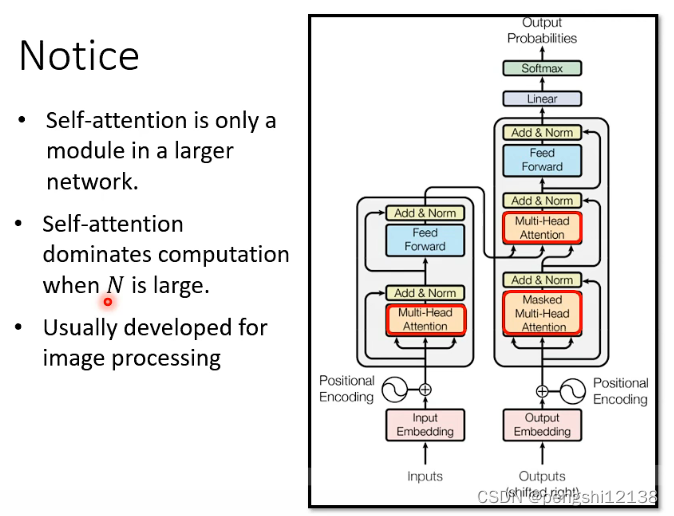

模型对应的描述图。

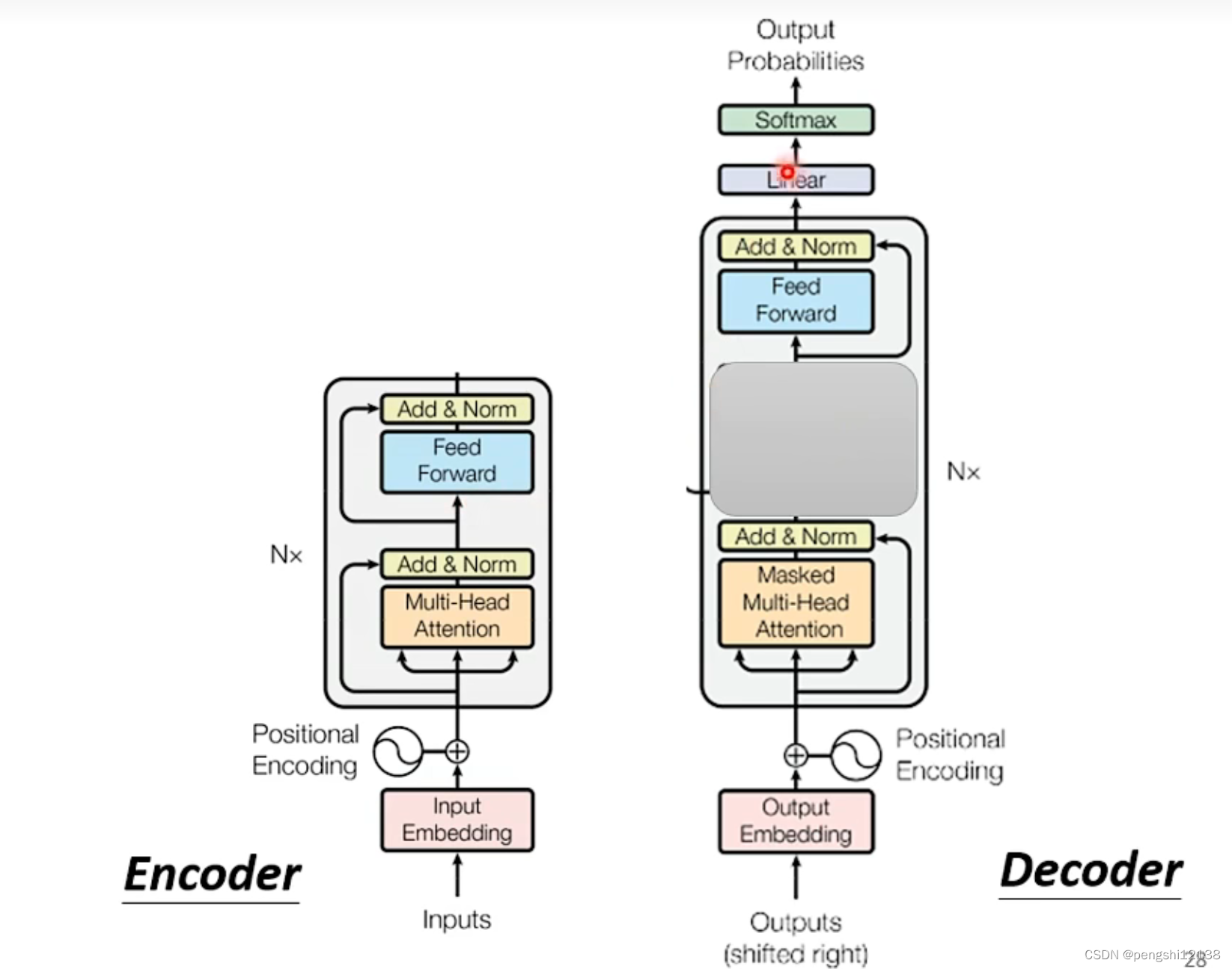

其中对应的层里面self-attention层的处理有右边所示,其中对应的部分就是encoder部分。encoder所做的部分就是输入的变量输出对应的同等数量的输出,放入decoder。

对于decoder的部分来说有如下。按照语音识别来说,decoder就是对于输入的变量进行查询对应的字典的所有单词的概率。将对应的识别的第一次字再扔入进行识别配合语音encoder的识别,识别第二个,以此类推。

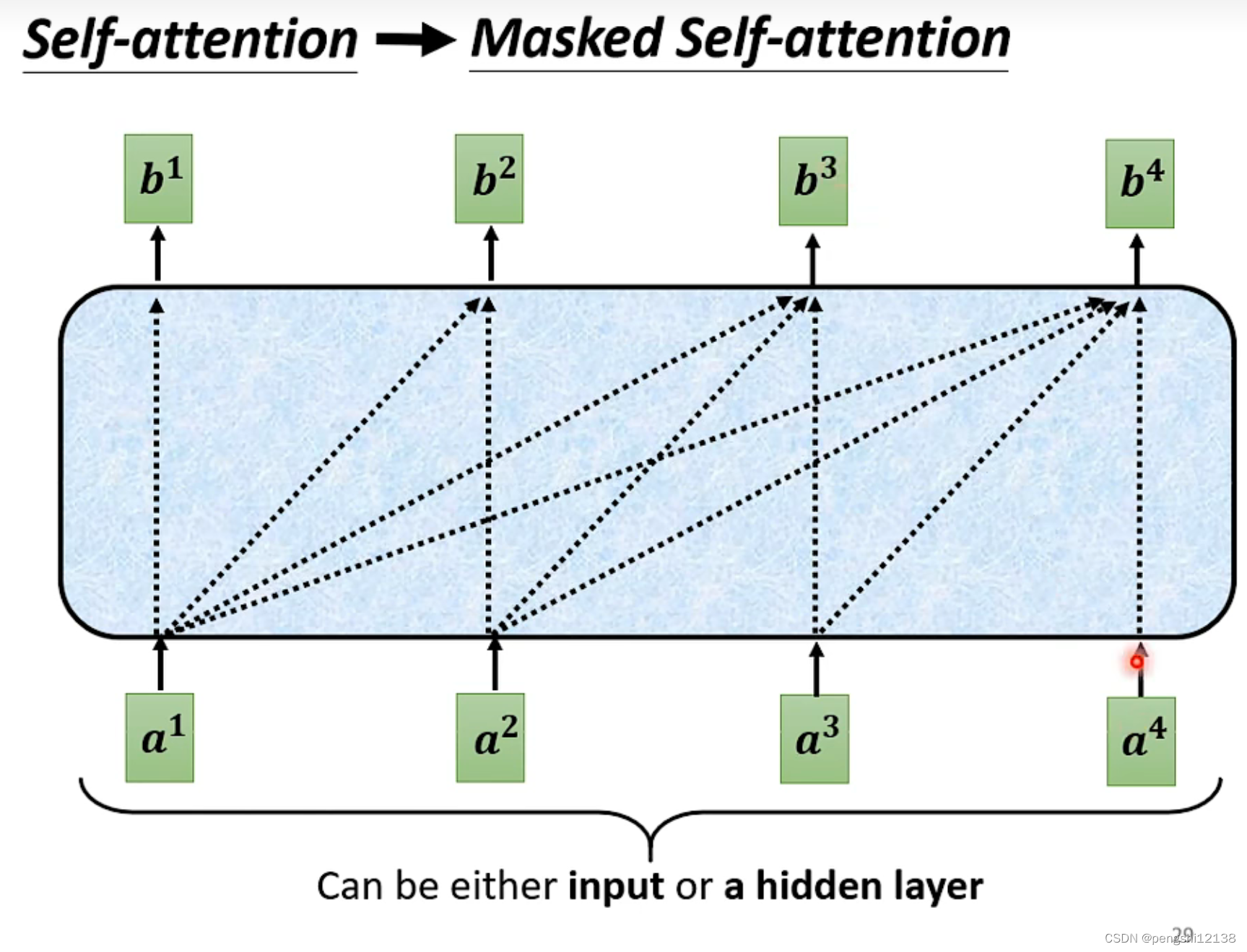

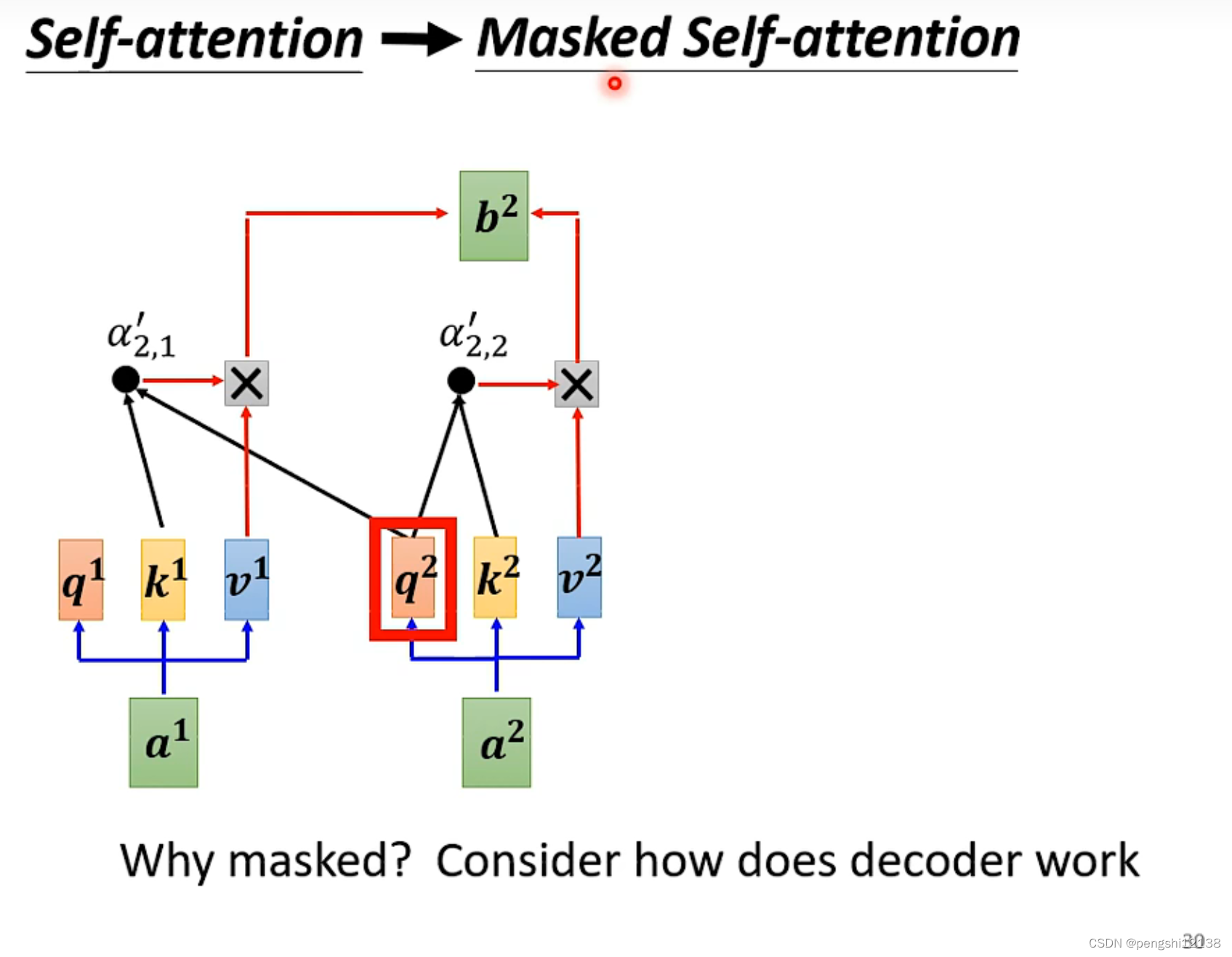

具体两个之间的差别如下,只是decoder中间加上了一个self-attention的部分。

但是对于这个self-attention不一样的是,他是单向的

考虑左边的东西,也就是语音识别的单向。

其中对于字典内部除了对应的所有中文字以外,还应该有begin和end的两个单词,进行训练,进行语音识别工作的开始和结束的标志。

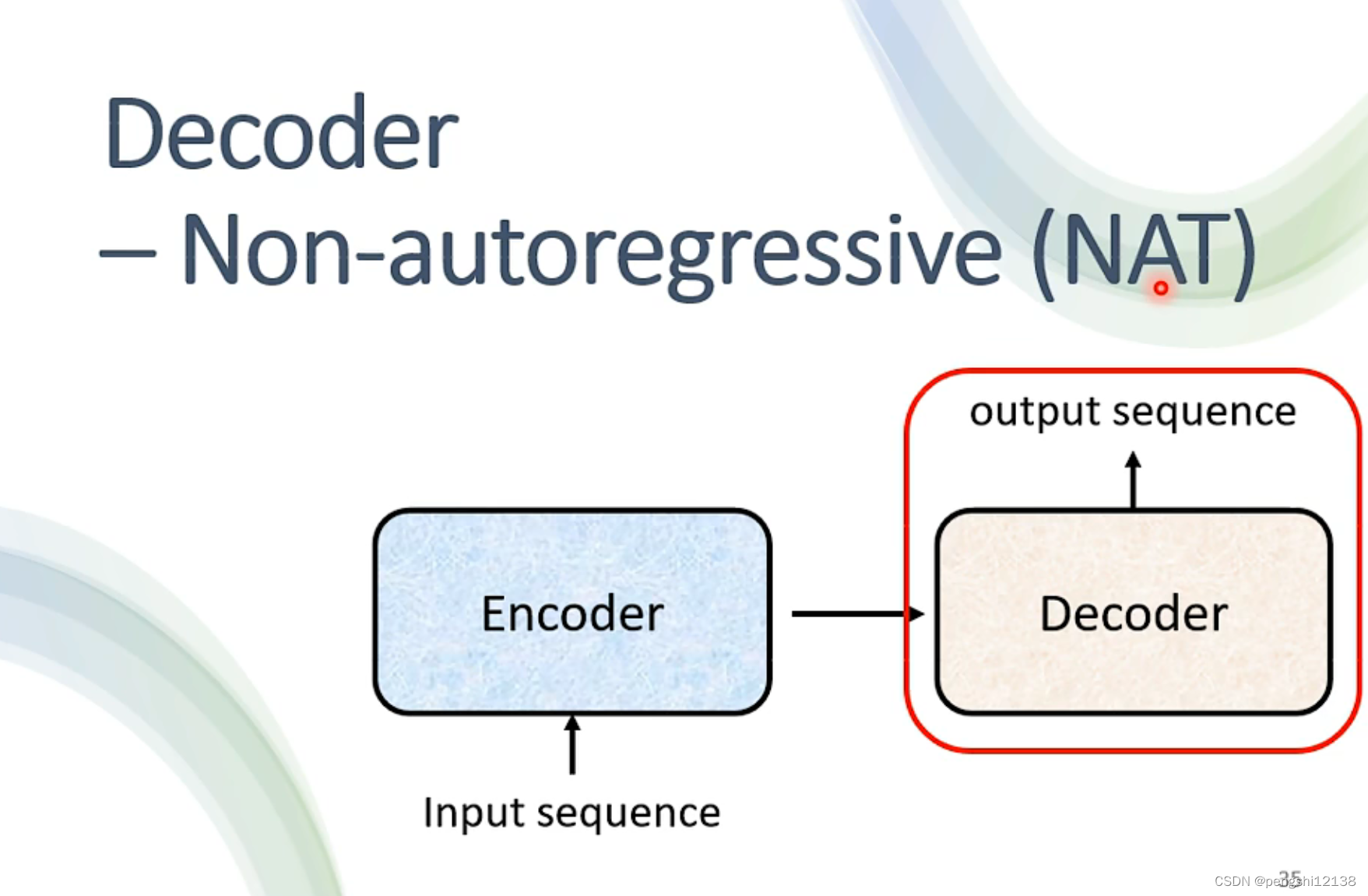

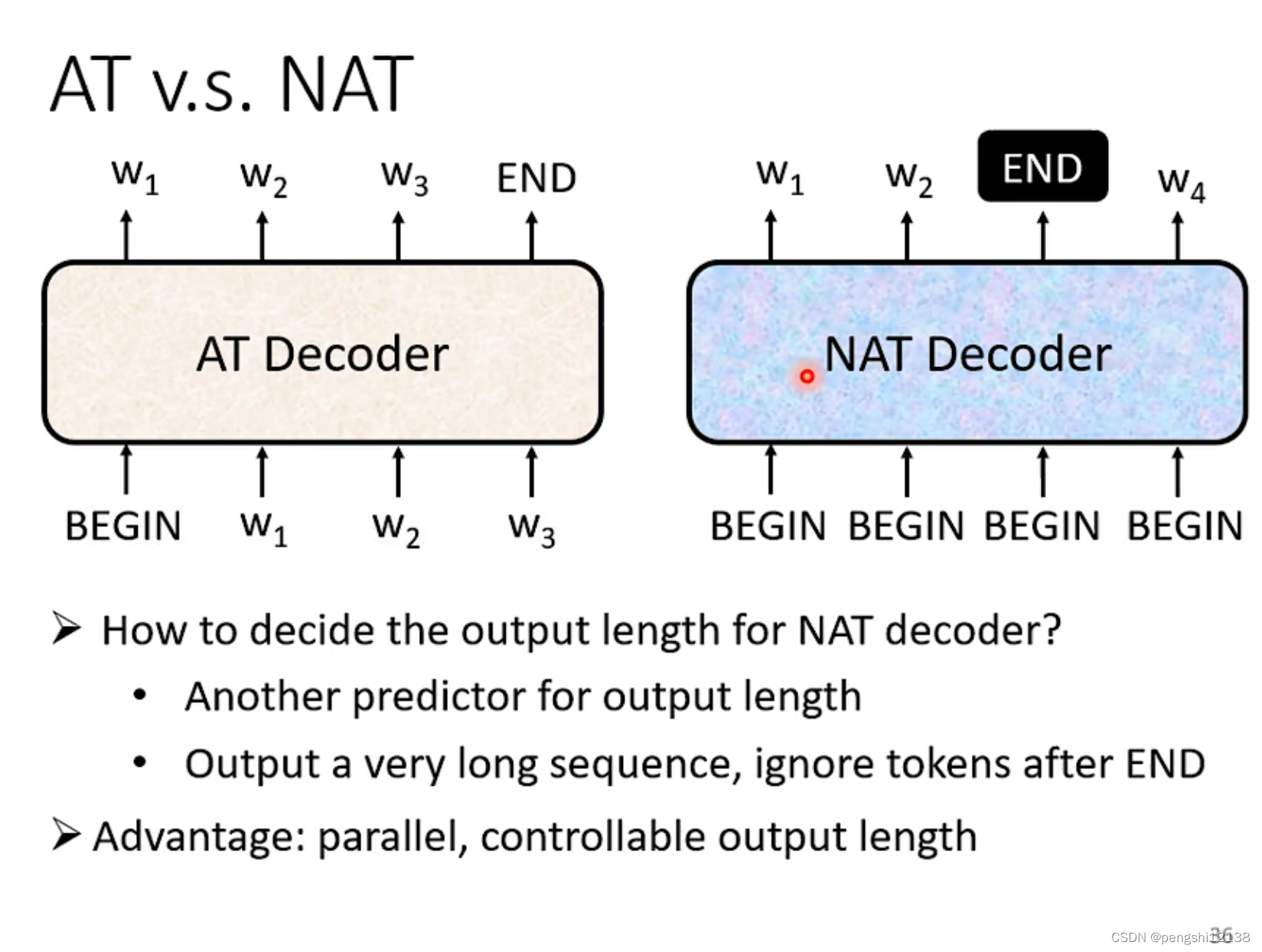

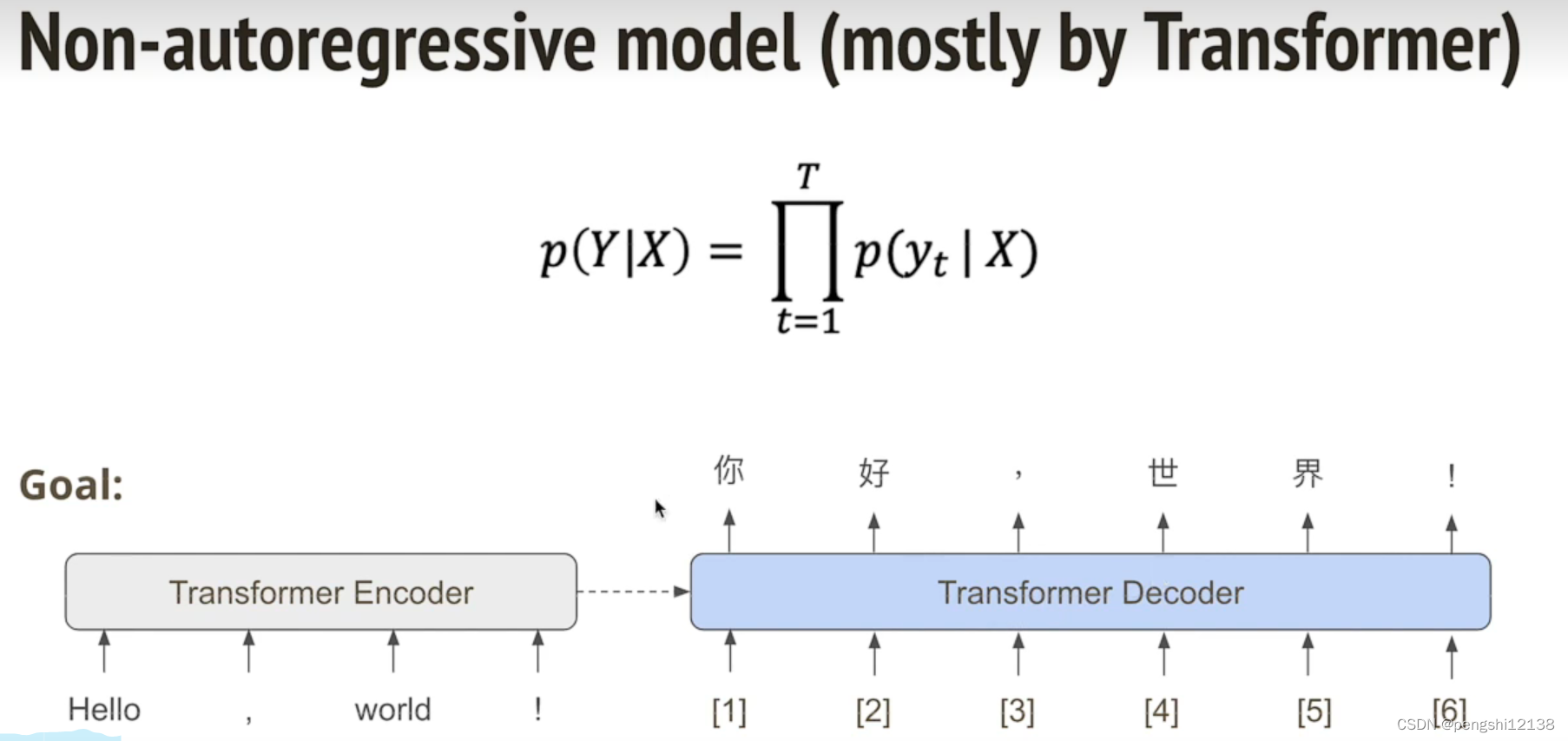

NAT

NAT可以进行平行的计算过程,但是对于识别而言永远差于AT。

Transformer

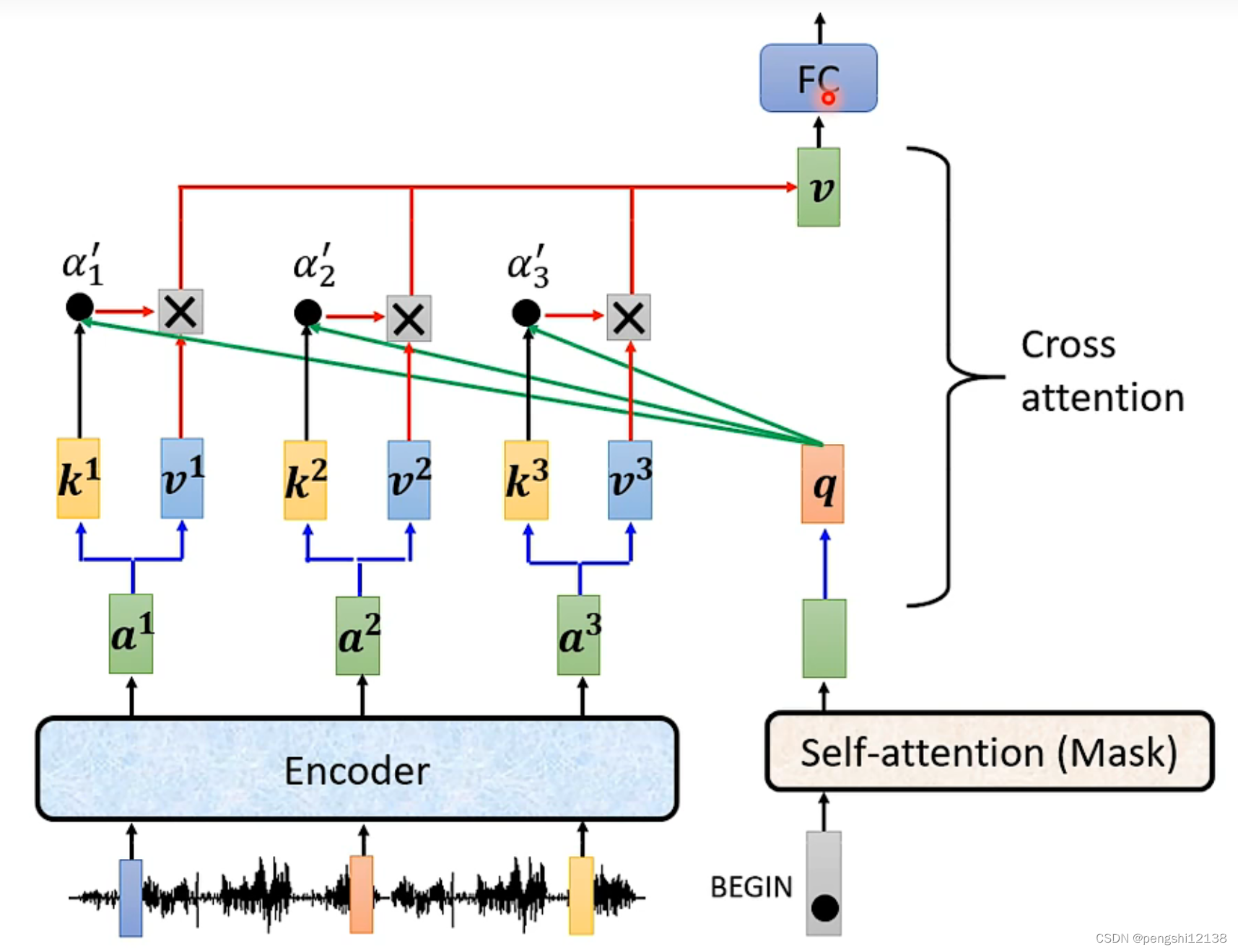

cross attention运作,就是上图红色框的部分,将encoder和decoder的部分交汇一起,进行训练过程,其中q是输出结果,将q进行扔入再次计算的。

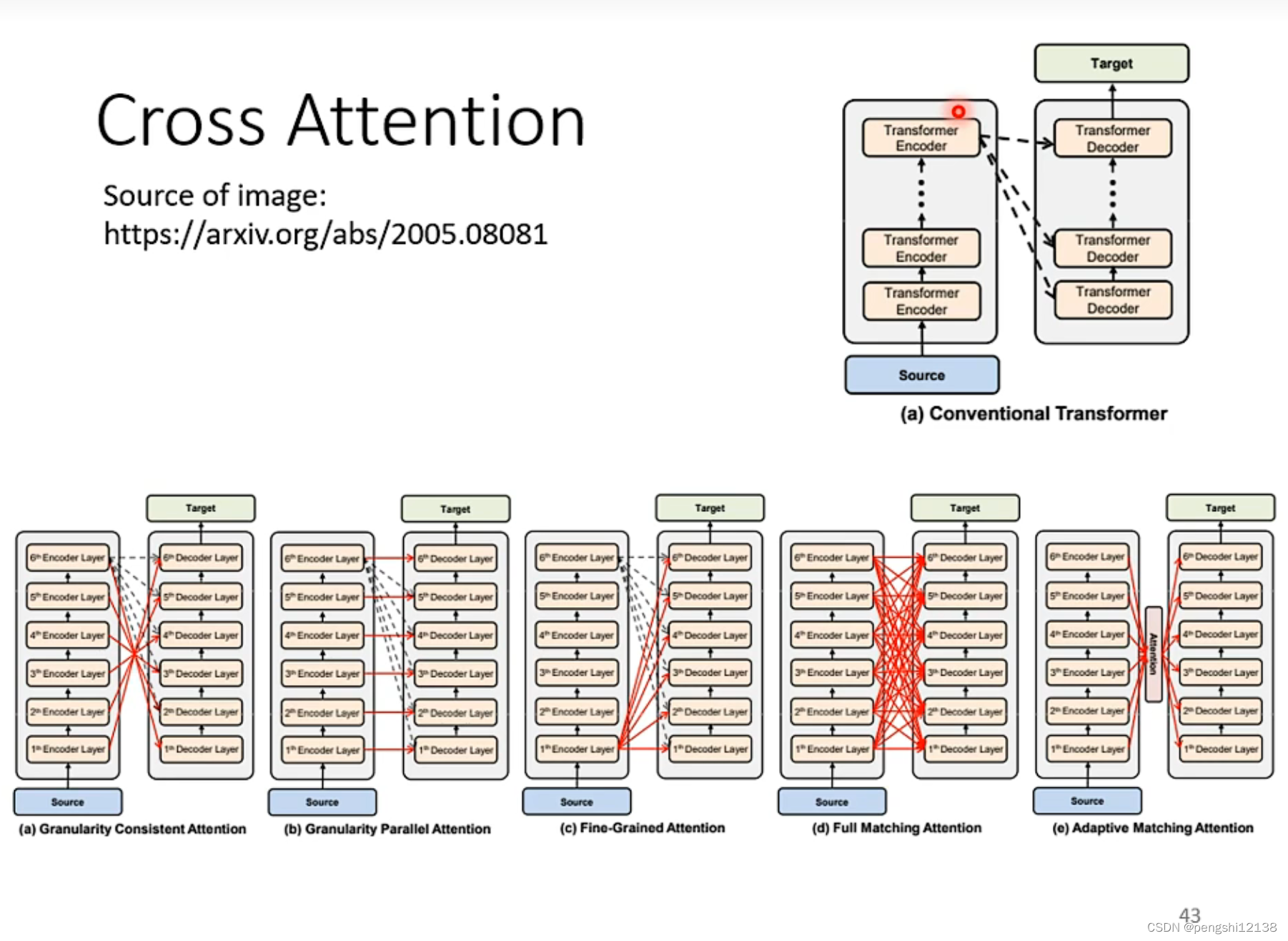

对于cross attention很早就有了,比transformer更早。

不一定要从encoder的第一次进行decoder,可以从多个encoder层上进行计算。

transformer train训练

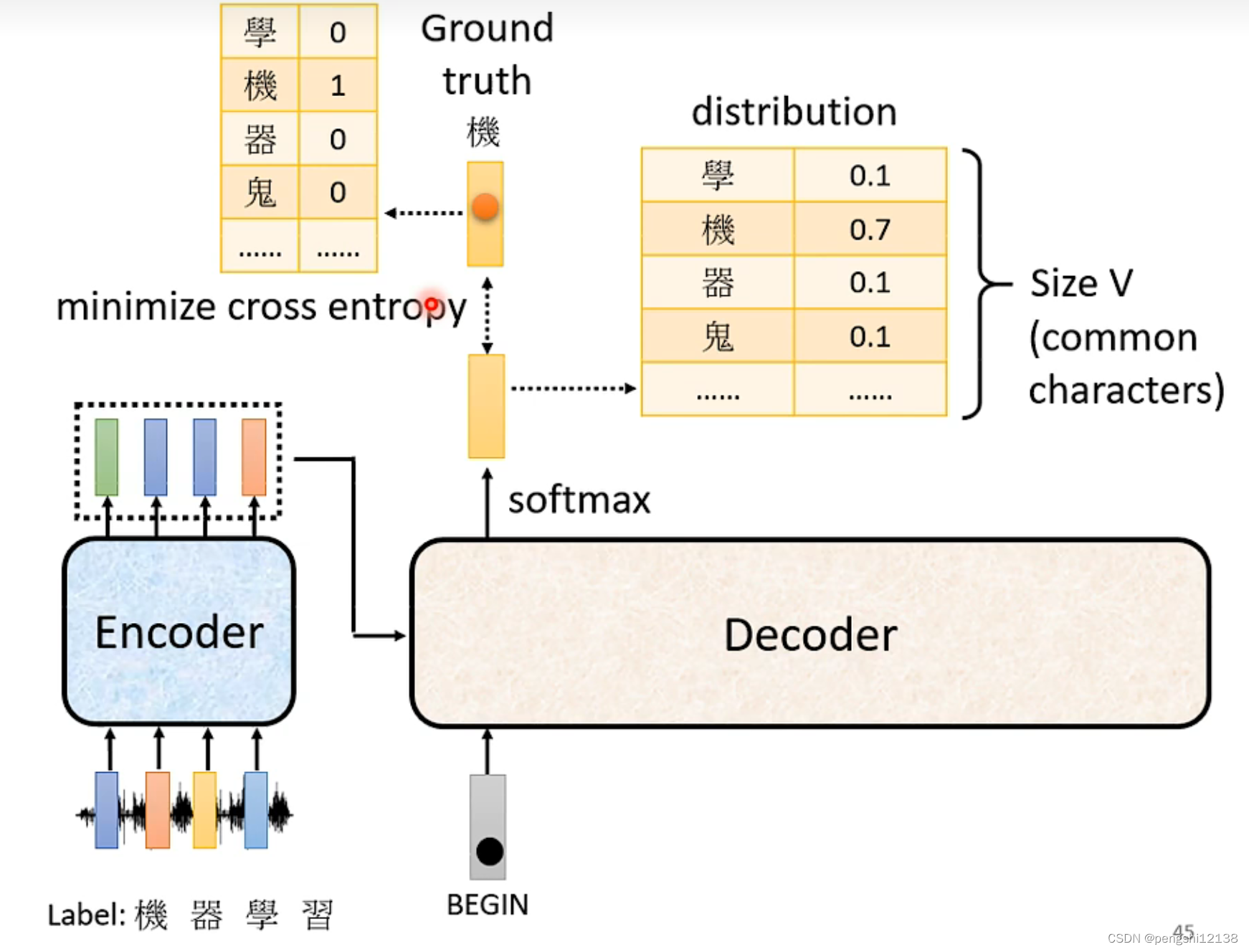

和分类的过程很相似,其实就是通过众多字典的概率不同计算最大最可能的字。

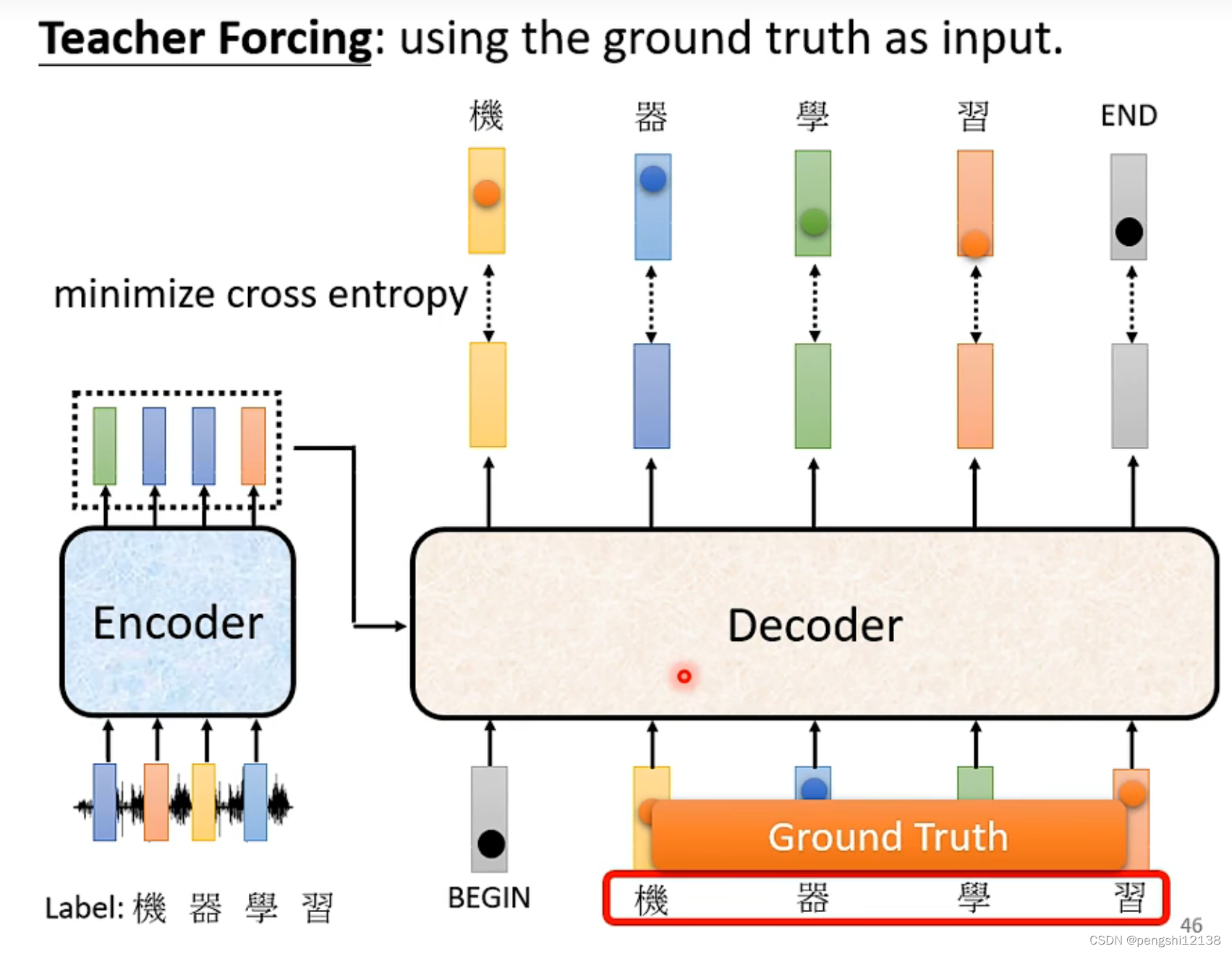

对于decoder训练我们可以通过输入真实值进行训练。

对于训练的时候看的是 cross entropy,但是实际测试的时候看的bleu score。

但是在测试的时候,由于是单向计算的问题,就存在前一个结果是错的,影响到后面的结果。所以在训练的时候可以添加一些错误的结果进行噪声训练。

各式各样的attention

前面我们已经讲了self-attention,现在讲一下attention

注意的是self-attention是一个大型网络的模块,当内部输入参数量很大的时候,主要的计算量就在self-attention

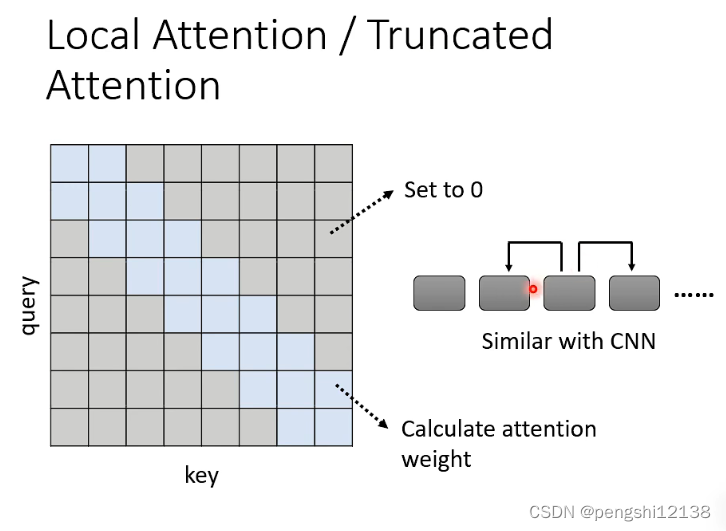

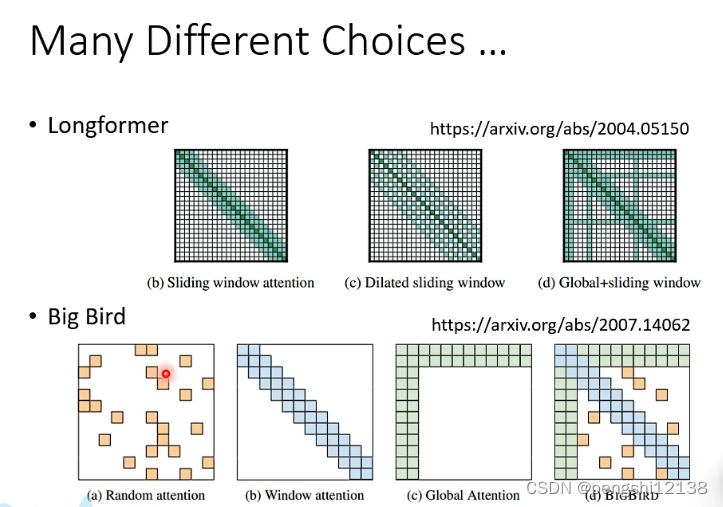

对于输入参数,存在相邻关联的参数进行注意力机制

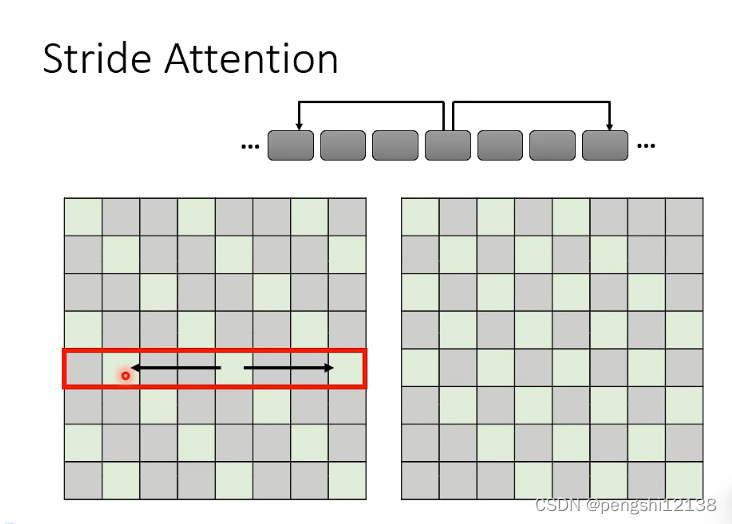

可以使用跨步注意,相关固定步长参数相互关联

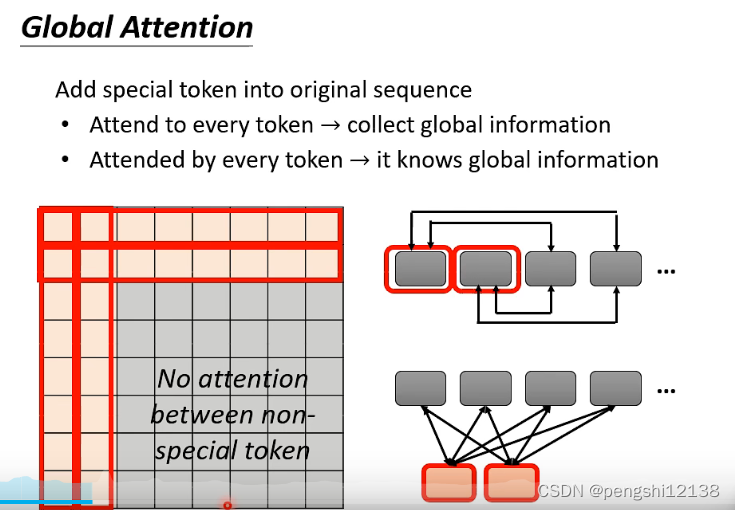

全局attention,定义多个non特殊的注意参数具有共同的特殊参数

使用的时候,将多种的attention进行关联起来进行模型训练

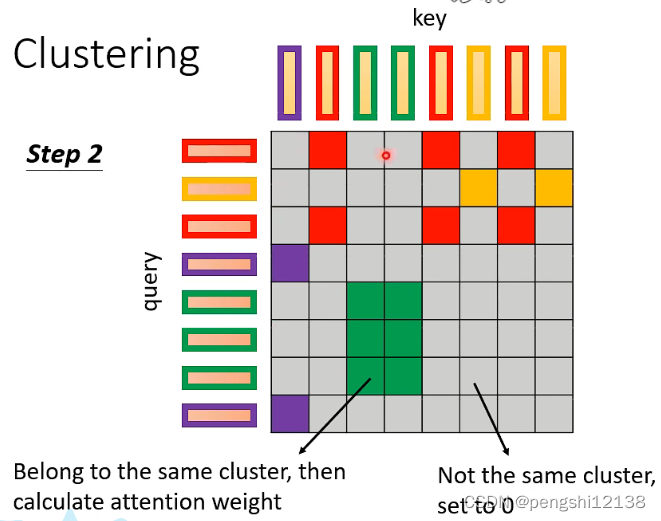

这里将相关的attention进行聚类,同一类的进行相关联

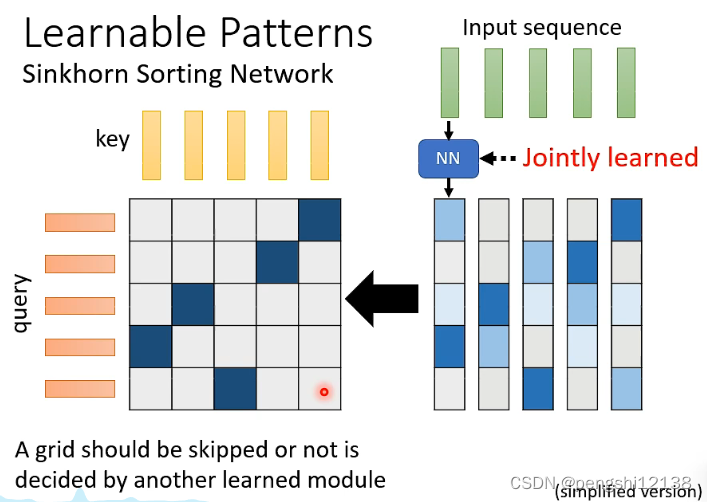

使用nn网络进行key的快速分类

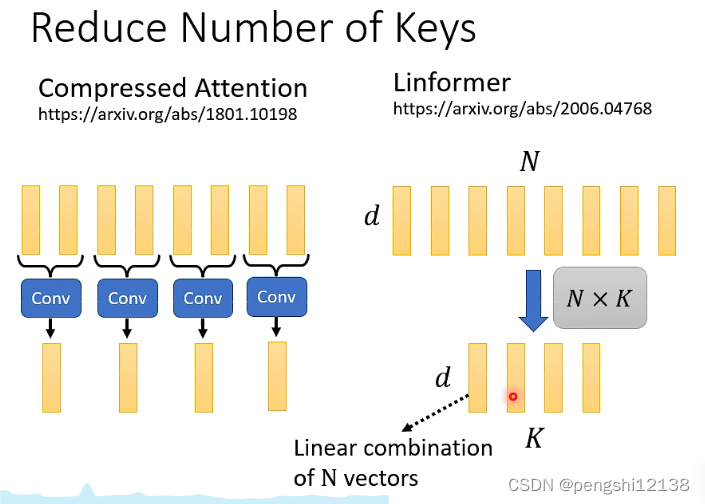

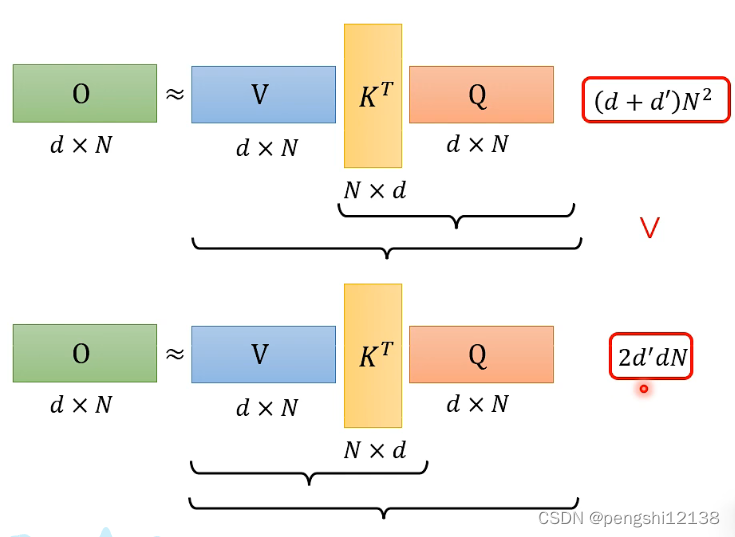

还有就是可以使用key的压缩加速运算

减少key参数的两种方式如上。

为了减少计算量,通过将self-attention中的步骤进行链式计算,将计算步骤进行合理的排序的矩阵计算

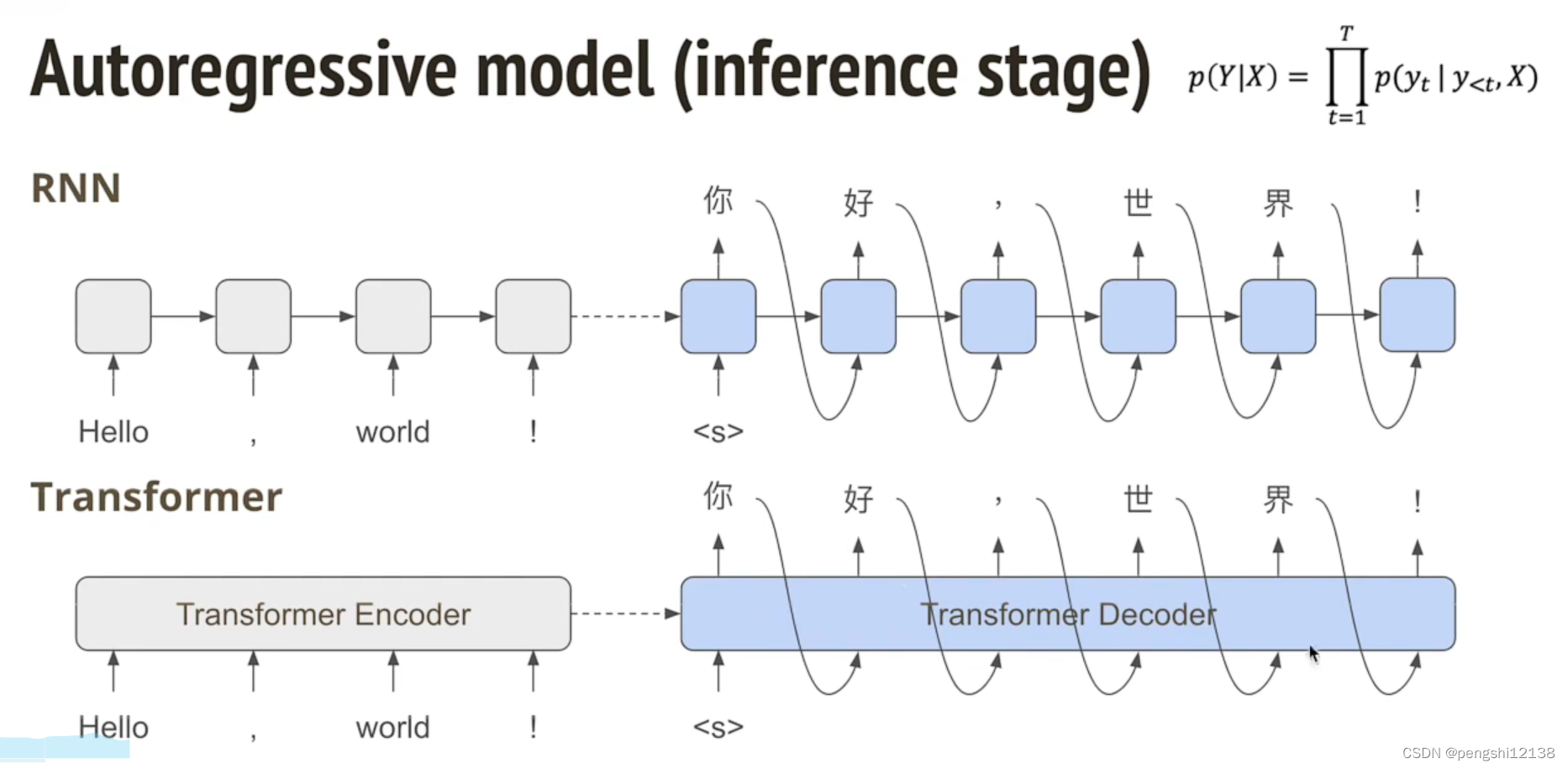

Non-Autoregressive model

自回归的模型如上,需要单个一次次迭代输入

非自回归的模型,可以进行平行计算,快速输出结果

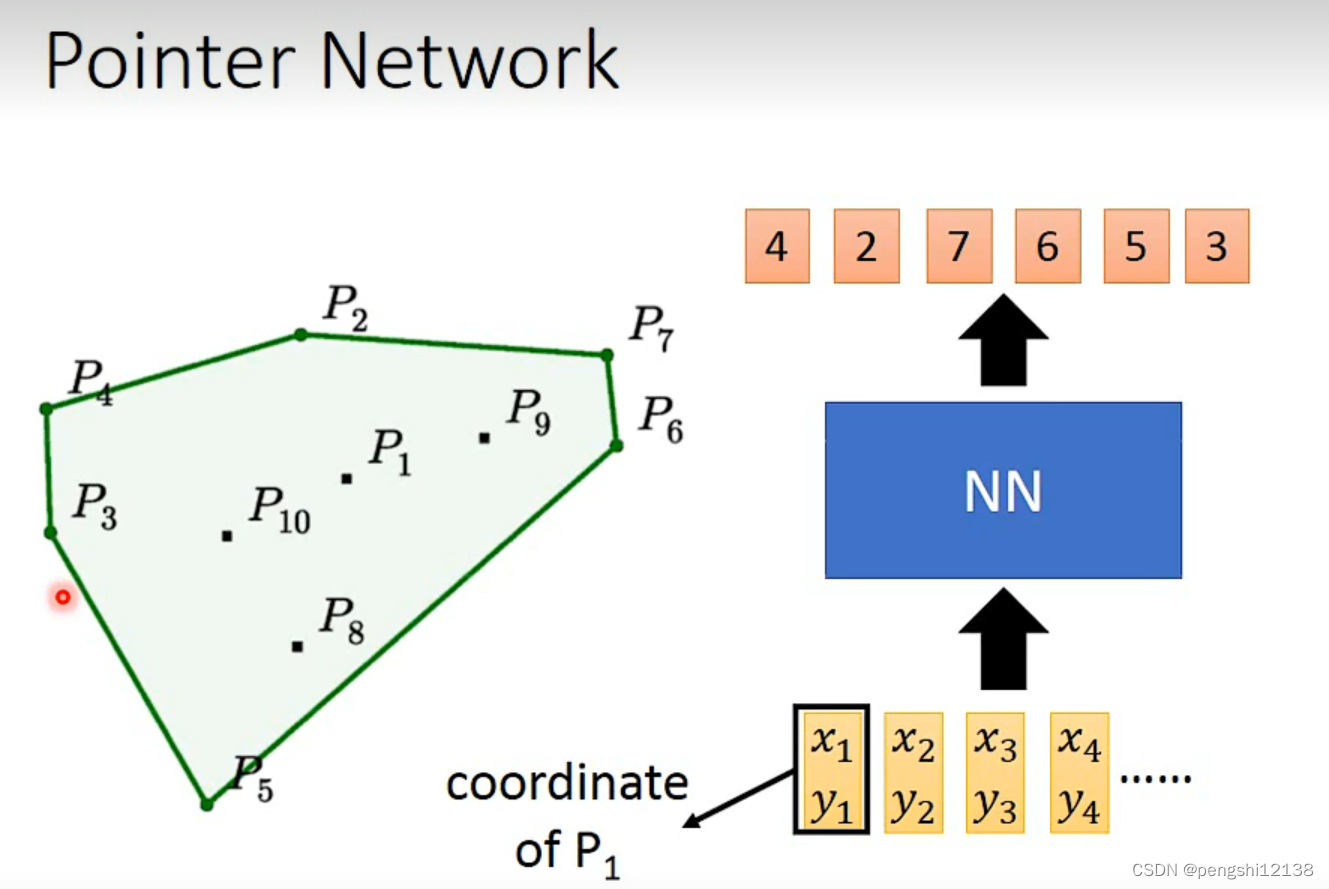

Pointer Network

寻找关联的点串联起来,将相关的点包含进去

这篇关于李宏毅机器学习入门笔记——第五节的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!