本文主要是介绍LLMChain使用初探 -- OLLaMA+LangChain搭建本地大模型,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

LLMChain是一个简单的链,接受一个提示模板,使用用户输入格式化它并从LLM返回响应。

其中,prompt_template是一个非常关键的组件,可以让你创建一个非常简单的链,它将接收用户输入,使用它格式化提示,然后将其发送到LLM。

1. 配置OLLaMA

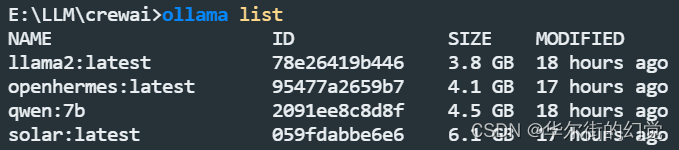

在使用LLMChain之前,需要先配置OLLaMA,OLLaMA可以运行本地大语言模型,我下载了llama2、openhermes、solar、qwen:7b

1.1 安装

ollama官网 https://ollama.com/

windows直接下载 - 无脑安装即可

1.2 下载模型

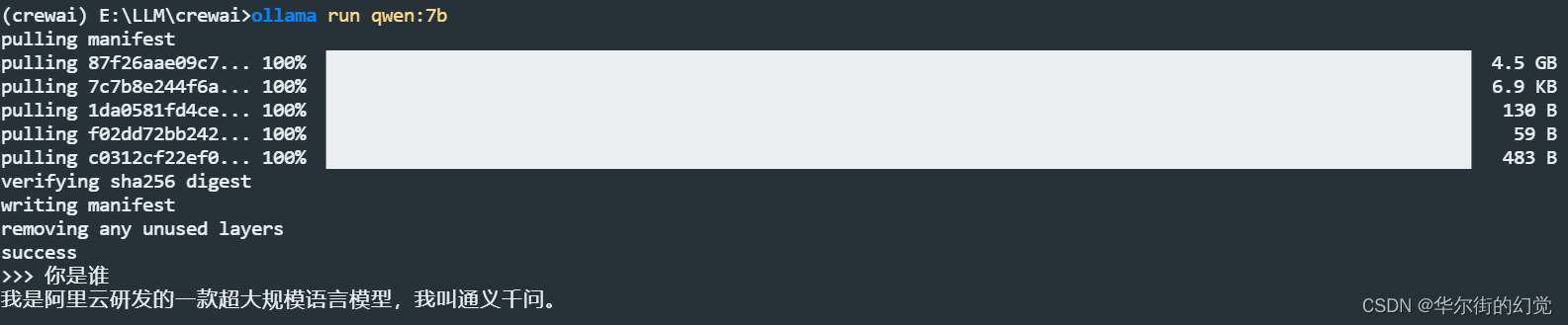

以通义千问模型为例:

# ollama run 模型名

ollama run qwen:7b

模型名见 https://ollama.com/library

2. langchain

实现目标:创建LLM链。假设我们想要创建一个公司名字

英文版

from langchain.prompts import PromptTemplate

from langchain.chains import LLMChain

from langchain.llms import Ollamaprompt_template = "What is a good name for a company that makes {product}?"ollama_llm = Ollama(model="qwen:7b")

llm_chain = LLMChain(llm = ollama_llm,prompt = PromptTemplate.from_template(prompt_template)

)

print(llm_chain("colorful socks"))

中文版

from langchain.prompts import PromptTemplate

from langchain.chains import LLMChain

from langchain.llms import Ollamaprompt_template = "请给制作 {product} 的公司起个名字,只回答公司名即可"ollama_llm = Ollama(model="qwen:7b")

llm_chain = LLMChain(llm = ollama_llm,prompt = PromptTemplate.from_template(prompt_template)

)

print(llm_chain("袜子"))

# print(llm_chain.run("袜子")) # 加个.run也可

输出:{'product': '袜子', 'text': '"袜界精品"'}

print(llm_chain.predict("袜子"))

输出:袜梦工坊

run和 predict的区别是

- llm_chain.

run:结合 输入{product} 和 大模型输出内容一起输出 - llm_chain.

predict:只给出大模型输出内容

这篇关于LLMChain使用初探 -- OLLaMA+LangChain搭建本地大模型的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!