本文主要是介绍一文读懂:GPU最强“辅助“HBM到底是什么?,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

各位ICT的小伙伴们大家好呀。

我是老猫。

今天我们聊聊GPU背后的女人,不对,是背后的大赢家-HBM。

那么,HBM究竟是什么呢?为何在AI时代如此火热?下面我们就一一道来。

▉ HBM到底为何方神圣?

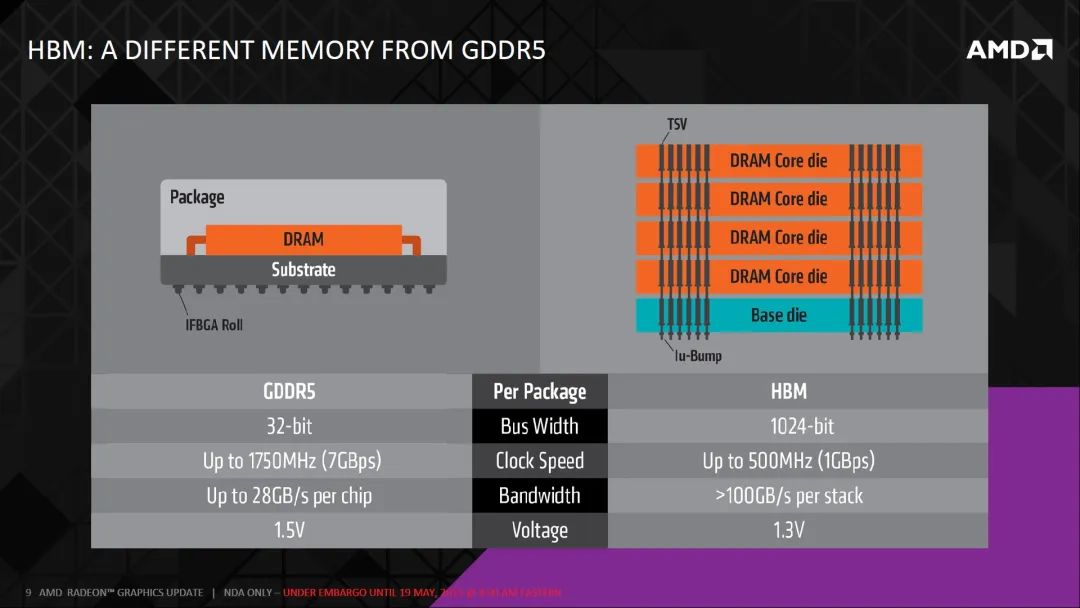

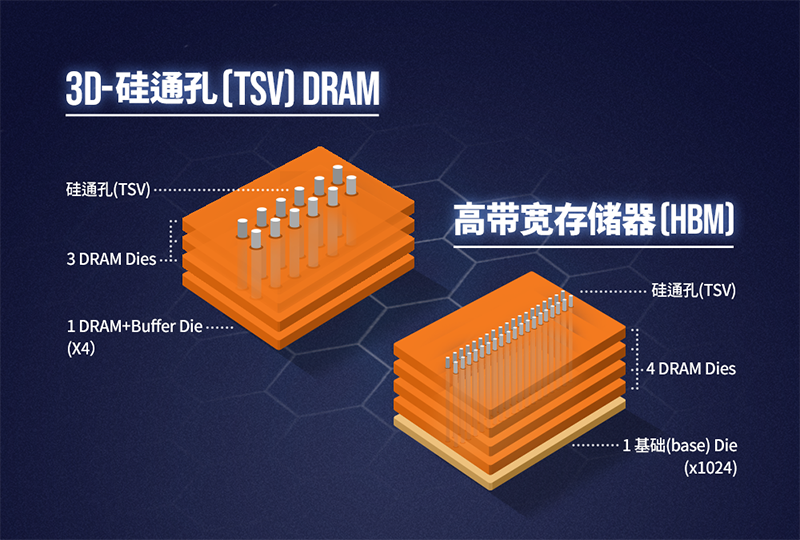

HBM全称为High Bandwidth Memory,直接翻译即是高带宽内存,是一款新型的CPU/GPU内存芯片。其实就是将很多个DDR芯片堆叠在一起后和GPU封装在一起,实现大容量、高位宽的DDR组合阵列。

打个比喻,就是传统的DDR就是采用的"平房设计"方式,HBM则是"楼房设计"方式,从而可实现了更高的性能和带宽。

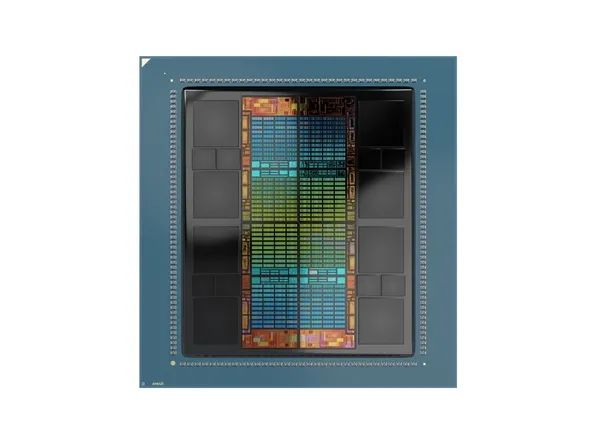

如上图,我们以AMD最新发布MI300X GPU芯片布局为例,中间的die是GPU,左右两侧的4个小die就是DDR颗粒的堆叠HBM。目前,在平面布局上,GPU现在一般常见有2/4/6/8四种数量的堆叠,立体上目前最多堆叠12层。

可能会说,HBM跟DDR不就是"平房"和"楼房"的区别吗?这也叫创新?

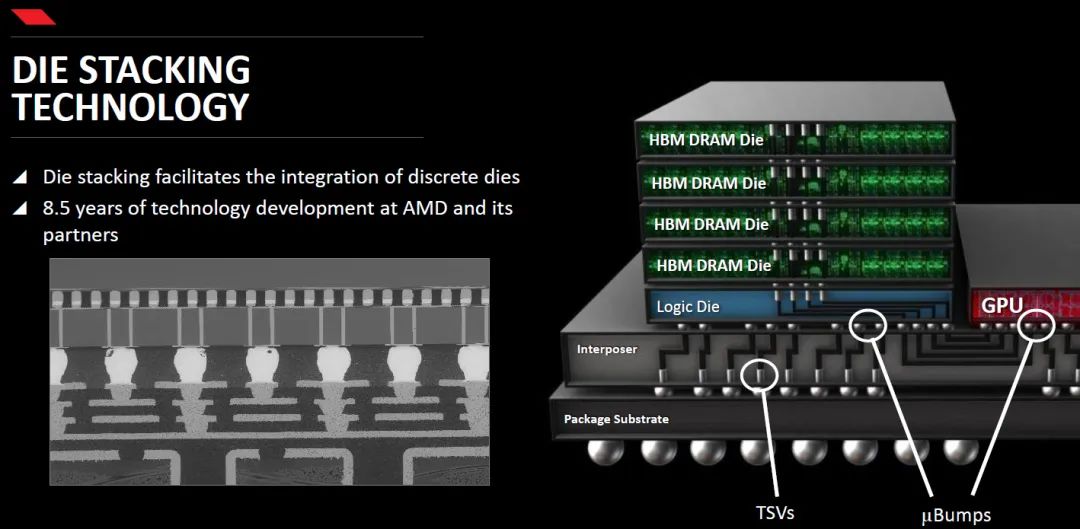

其实想要实现HBM生产并没有说起来这么简单,大家想想,建一个楼房可要比建一个平房要困难很多,从底层地基到布线都需要重新设计。HBM的构建像楼房一样,将传输信号、指令、电流都进行了重新设计,而且对封装工艺的要求也高了很多。

如上图右侧,DRAM通过堆叠的方式,叠在一起,Die之间用TVS方式连接;DRAM下面是DRAM逻辑控制单元, 对DRAM进行控制;GPU和DRAM通过uBump和Interposer(起互联功能的硅片)连通;Interposer再通过Bump和 Substrate(封装基板)连通到BALL;最后BGA BALL 连接到PCB上。

HBM堆栈通过中介层紧凑而快速地连接,HBM具备的特性几乎和芯片集成的RAM一样,可实现更多的IO数量。同时HBM重新调整了内存的功耗效率,使每瓦带宽比GDDR5高出3倍还多。也即是功耗降低3倍多!另外,HBM 在节省产品空间方面也独具匠心,HBM比GDDR5节省了 94% 的表面积!使游戏玩家可以摆脱笨重的GDDR5芯片,尽享高效。

鉴于技术上的复杂性,HBM是公认最能够展示存储厂商技术实力的旗舰产品。

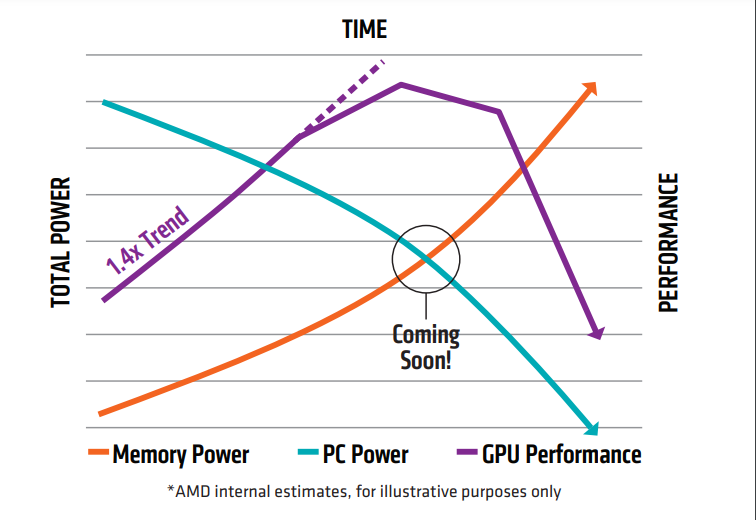

▉ 为什么需要HBM?

HBM的初衷,就是为了向GPU和其他处理器提供更多的内存。

这主要是因为随着GPU 的功能越来越强大,需要更快地从内存中访问数据,以缩短应用处理时间。例如,AI和视觉,具有巨大内存和计算和带宽要求。

为了减小“内存墙”的影响,提升内存带宽一直是存储芯片聚焦的关键问题。

半导体的先进封装为克服阻碍高性能计算应用程序的内存访问障碍提供了机会,内存的延迟和密度都是可以在封装级别解决的挑战。基于对先进技术和解决方案开展的研究,内存行业在新领域进行了更深入的探索。

为了克服这些挑战,半导体封装设计人员采用了异构集成路线,以在更靠近处理器的位置包含更多内存。而HBM就为现代处理器和嵌入式系统当前面临的内存障碍问题提供了解决方案。这些存储器为系统设计人员提供了两个优势:一是减少组件占用空间和外部存储器要求;二是更快的内存访问时间和速率。

叠起来之后,直接结果就是接口变得更宽,其下方互联的触点数量远远多于DDR内存连接到CPU的线路数量。因此,与传统内存技术相比,HBM具有更高带宽、更多I/O数量、更低功耗、更小尺寸。

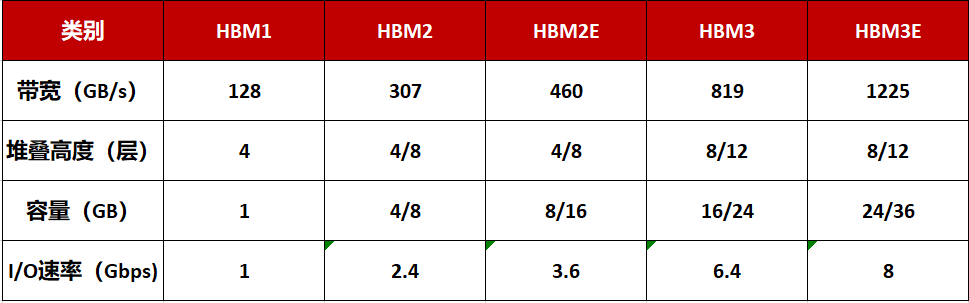

目前,HBM产品以HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发,最新的HBM3E是HBM3的扩展版本。

HBM每一次更新迭代都会伴随着处理速度的提高。引脚(Pin)数据传输速率为1Gbps的第一代HBM,发展到其第五产品HBM3E,速率则提高到了8Gbps,即每秒可以处理1.225TB的数据。也就是说,下载一部长达163分钟的全高清(Full-HD)电影(1TB)只需不到1秒钟的时间。

当然,存储器的容量也在不断加大:HBM2E的最大容量为16GB,目前,三星正在利用其第四代基于EUV光刻机的10nm制程(14nm)节点来制造24GB容量的HBM3芯片,此外8层、12层堆叠可在HBM3E上实现36GB(业界最大)的容量,比HBM3高出50%。

此前SK海力士、美光均已宣布推出HBM3E芯片,皆可实现超过1TB/s的带宽。

同时,三星也宣布HBM4内存将采用更先进的芯片制造和封装技术,虽然HBM4的规格尚未确定,但有消息称业界正寻求使用2048位内存接口,并使用FinFET晶体管架构来降低功耗。三星希望升级晶圆级键合技术,从有凸块的方式转为无凸块直接键合。因此,HBM4的成本可能会更高。

▉ HBM的发展史

如同闪存从2D NAND向3D NAND发展一样,DRAM也是从2D向3D技术发展,HBM也由此诞生。

在最初, HBM是通过硅通孔(Through Silicon Via, 简称"TSV")技术进行芯片堆叠,以增加吞吐量并克服单一封装内带宽的限制,将数个DRAM裸片像摩天大厦中的楼层一样垂直堆叠,裸片之间用TVS技术连接。

从技术角度看,HBM使得DRAM从传统2D转变为立体3D,充分利用空间、缩小面积,正契合半导体行业小型化、集成化的发展趋势。HBM突破了内存容量与带宽瓶颈,被视为新一代DRAM解决方案,业界认为这是DRAM通过存储器层次结构的多样化开辟一条新的道路,革命性提升DRAM的性能。

在HBM的诞生与发展过程中,AMD和SK海力士可谓功不可没。据了解,AMD在2009年就意识到DDR的局限性并产生开发堆叠内存的想法,后来其与SK海力士联手研发HBM。

2013年,经过多年研发后,AMD和SK海力士终于推出了HBM这项全新技术,还被定为了JESD235行业标准,HBM1的工作频率约为1600 Mbps,漏极电源电压为1.2V,芯片密度为2Gb(4-hi),其带宽为4096bit,远超GDDR5的512bit。

除了带宽外,HBM对DRAM能耗的影响同样重要。此外,由于GPU核心和显存封装在了一起,还能一定程度上减轻散热的压力,原本是一大片的散热区域,浓缩至一小块,散热仅需针对这部分区域,原本动辄三风扇的设计,可以精简为双风扇甚至是单风扇,变相缩小了显卡的体积。

在当时,无论是AMD和SK海力士,还是媒体和众多玩家,都认定了这才是未来的显存。第一代HBM面世商用后,SK海力士与三星即开始了一场你追我赶的竞赛。

2016年1月,三星宣布开始量产4GB HBM2 DRAM,并在同一年内生产8GB HBM2 DRAM;2017年下半年,被三星赶超的SK海力士开始量产HBM2;2018年1月,三星宣布开始量产第二代8GB HBM2"Aquabolt"。

2018年末,JEDEC推出HBM2E规范,以支持增加的带宽和容量。当传输速率上升到每管脚3.6Gbps时,HBM2E可以实现每堆栈461GB/s的内存带宽。此外,HBM2E支持最多12个DRAM的堆栈,内存容量高达每堆栈24GB。与HBM2相比,HBM2E具有技术更先进、应用范围更广泛、速度更快、容量更大等特点。

2019年8月,SK海力士宣布成功研发出新一代"HBM2E";2020年2月,三星也正式宣布推出其16GB HBM2E产品"Flashbolt",于2020年上半年开始量产。

2020年,另一家存储巨头美光宣布加入到这一赛场中来。

美光在当时的财报会议上表示,将开始提供HBM2内存/显存,用于高性能显卡,服务器处理器产品,并预计下一代HBMNext将在2022年底面世。但截至目前尚未看到美光相关产品动态。

2022年1月,JEDEC组织正式发布了新一代高带宽内存HBM3的标准规范,继续在存储密度、带宽、通道、可靠性、能效等各个层面进行扩充升级。JEDEC表示,HBM3是一种创新的方法,是更高带宽、更低功耗和单位面积容量的解决方案,对于高数据处理速率要求的应用场景来说至关重要,比如图形处理和高性能计算的服务器。

2022年6月量产了HBM3 DRAM芯片,并将供货英伟达,持续巩固其市场领先地位。随着英伟达使用HBM3 DRAM,数据中心或将迎来新一轮的性能革命。

2023年,NVIDIA 发布H200芯片,是首款提供HBM3e内存的GPU,HBM3e是目前全球最高规格的HBM内存,由SK海力士开发,将于明年上半年开始量产。

2023年12月,AMD发布最新MI300X GPU芯片,2.5D硅中介层、3D混合键合集一身的3.5D封装,集成八个5nm工艺的XCD模块,内置304个CU计算单元,又可分为1216个矩阵核心,同时还有四个6nm工艺的IOD模块和256MB无限缓存,以及八颗共192GB HBM3高带宽内存。

从HBM1到HBM3,SK海力士和三星一直是HBM行业的领军企业。但比较可惜的是,AMD却在2016年发布完产品后完全转向,近乎放弃了HBM。唯一仍然保留HBM技术的是用于AI计算的加速卡。

起了个大早,赶了个晚集,是对AMD在HBM上的最好概括。既没有凭借HBM在游戏显卡市场中反杀英伟达,反而被英伟达利用HBM巩固了AI计算领域的地位,白白被别人摘了熟透甜美的桃子。

▉ HBM的竞争格局?

由生成式AI引发对HBM及相关高传输能力存储技术的需求,HBM成为存储巨头在下行行情中对业绩的重要扭转力量,这也是近期业绩会上的高频词。

调研机构TrendForce集邦咨询也指出,预估2023年全球HBM需求量将年增近六成,来到2.9亿GB,2024年将再增长三成。2023年HBM将处于供不应求态势,到2024年供需比有望改善。

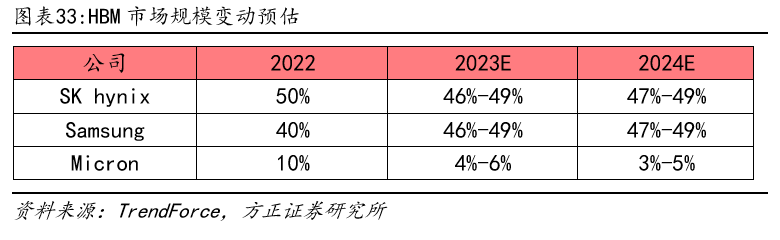

但是HBM在整体存储市场占比较低,目前还不是普及性应用的产品。目前似乎竞争都局限在SK海力士、三星和美光这三家企业之间。

目前,在HBM的竞争格局中,SK海力士是技术领先并拥有最高市场份额的公司,其市占率为50%。紧随其后的是三星,市占率约为40%,而美光占据了大约10%的市场份额。

根据预测,到23年,海力士的市场份额有望提升至53%,而三星和美光的市场份额将分别为38%和9%。

在下游厂商主要包括CPU/GPU制造商,例如英特尔、英伟达和AMD。由于HBM是与GPU封装在一起的,因此HBM的封装通常由晶圆代工厂完成。

反观到我们国内,由于起步较晚,目前HBM相关产业链布局相对较小,只有一些企业涉及封测领域。但是这也意味着,在信息安全的今天,HBM具有更大的成长空间。

目前,在国内涉及HBM产业链的公司主要包括雅克科技、中微公司、和拓荆科技等公司。其中,雅克的子公司UP Chemical是SK海力士的核心供应商,为其提供HBM前驱体。

在HBM工艺中,ALD沉积(单原子层沉积)起着重要作用。拓荆科技就是国内主要的ALD供应商之一,公司的PEALD产品用于沉积SiO2、SiN等介质薄膜,在客户端验证中都取得了令人满意的结果。

而TSV技术(硅通孔技术)也是HBM的核心技术之一,中微公司是TSV设备的主要供应商。硅通孔技术用于连接硅晶圆两面,并与硅衬底和其他通孔绝缘的电互连结构。它能够通过硅基板实现硅片内部的垂直电互联,是实现2.5D和3D先进封装的关键。

随着HBM堆叠DRAM裸片数量逐步增加到8层和12层,HBM对DRAM材料的需求将呈倍数级增长。同时,HBM前驱体的单位价值也将出现倍数级增长,这为前驱体市场带来了全新的发展机遇。

▉ HBM的未来应用前景

随着AI大模型、智能驾驶等新技术的崛起,人们对高带宽的内存的需求越来越多。

首先,AI服务器的需求会在近两年爆增,如今在市场上已经出现了快速的增长。AI服务器可以在短时间内处理大量数据,GPU可以让数据处理量和传输速率的大幅提升,让AI服务器对带宽提出了更高的要求,而HBM基本是AI服务器的标配。

除了AI服务器,汽车也是HBM值得关注的应用领域。汽车中的摄像头数量,所有这些摄像头的数据速率和处理所有信息的速度都是天文数字,想要在车辆周围快速传输大量数据,HBM具有很大的带宽优势。

另外,AR和VR也是HBM未来将发力的领域。因为VR和AR系统需要高分辨率的显示器,这些显示器需要更多的带宽来在 GPU 和内存之间传输数据。而且,VR和AR也需要实时处理大量数据,这都需要HBM的超强带宽来助力。

此外,智能手机、平板电脑、游戏机和可穿戴设备的需求也在不断增长,这些设备需要更先进的内存解决方案来支持其不断增长的计算需求,HBM也有望在这些领域得到增长。并且,5G 和物联网 (IoT) 等新技术的出现也进一步推动了对 HBM 的需求。

并且,AI的浪潮还在愈演愈烈,HBM今后的存在感或许会越来越强。据semiconductor-digest预测,到2031年,全球高带宽存储器市场预计将从2022年的2.93亿美元增长到34.34亿美元,在2023-2031年的预测期内复合年增长率为31.3%。

▉ HBM需要克服的问题

1:HBM需要较高的工艺从而导致大幅度提升了成本。

针对更大数据集、训练工作负载所需的更高内存密度要求,存储厂商开始着手研究扩展Die堆叠层数和物理堆叠高度,以及增加核心Die密度以优化堆叠密度。

但就像处理器芯片摩尔定律发展一样,当技术发展到一个阶段,想要提升更大的性能,那么成本反而会大幅提升,导致创新放缓。

2:产生大量的热,如何散热是GPU极大的挑战。

行业厂商需要在不扩大现有物理尺寸的情况下增加存储单元数量和功能,从而实现整体性能的飞跃。但更多存储单元的数量让GPU的功耗大幅提升。新型的内存需要尽量减轻内存和处理器之间搬运数据的负担。

▉ 最后总结:

随着人工智能、机器学习、高性能计算、数据中心等应用市场的兴起,内存产品设计的复杂性正在快速上升,并对带宽提出了更高的要求,不断上升的宽带需求持续驱动HBM发展。相信未来,存储巨头们将会持续发力、上下游厂商相继入局,让HBM得到更快的发展和更多的关注。

这篇关于一文读懂:GPU最强“辅助“HBM到底是什么?的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!