本文主要是介绍Android中MediaMuxer和MediaCodec用例 - audio+video,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

http://blog.csdn.net/jinzhuojun/article/details/32163149

在Android的多媒体类中,MediaMuxer和MediaCodec算是比较年轻的,它们是JB 4.1和JB 4.3才引入的。前者用于将音频和视频进行混合生成多媒体文件。缺点是目前只能支持一个audio track和一个video track,而且仅支持mp4输出。不过既然是新生事物,相信之后的版本应该会有大的改进。MediaCodec用于将音视频进行压缩编码,它有个比较牛X的地方是可以对Surface内容进行编码,如KK 4.4中屏幕录像功能就是用它实现的。

注意它们和其它一些多媒体相关类的关系和区别:MediaExtractor用于音视频分路,和MediaMuxer正好是反过程。MediaFormat用于描述多媒体数据的格式。MediaRecorder用于录像+压缩编码,生成编码好的文件如mp4, 3gpp,视频主要是用于录制Camera preview。MediaPlayer用于播放压缩编码后的音视频文件。AudioRecord用于录制PCM数据。AudioTrack用于播放PCM数据。PCM即原始音频采样数据,可以用如vlc播放器播放。当然了,通道采样率之类的要自己设,因为原始采样数据是没有文件头的,如:

vlc --demux=rawaud --rawaud-channels 2 --rawaud-samplerate 44100 audio.pcm

回到MediaMuxer和MediaCodec这两个类,它们的参考文档见http://developer.android.com/reference/android/media/MediaMuxer.html和http://developer.android.com/reference/android/media/MediaCodec.html,里边有使用的框架。这个组合可以实现很多功能,比如音视频文件的编辑(结合MediaExtractor),用OpenGL绘制Surface并生成mp4文件,屏幕录像以及类似Camera app里的录像功能(虽然这个用MediaRecorder更合适)等。

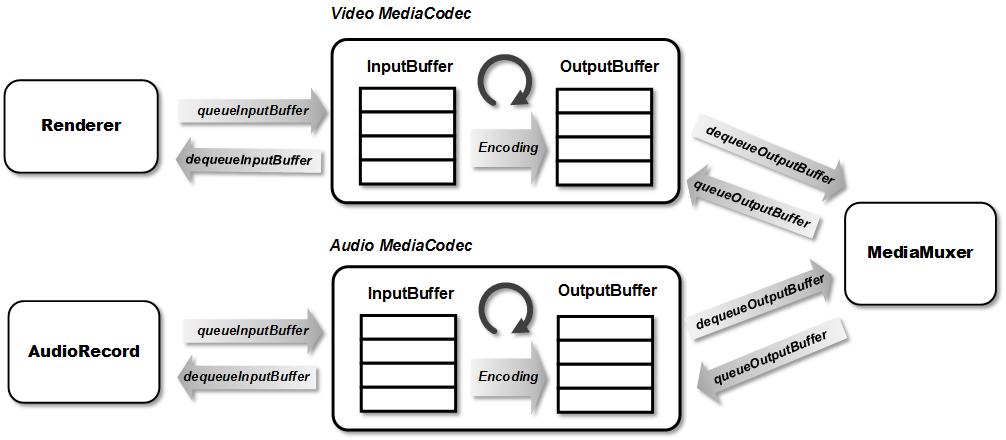

这里以一个很无聊的功能为例,就是在一个Surface上画图编码生成视频,同时用MIC录音编码生成音频,然后将音视频混合生成mp4文件。程序本身没什么用,但是示例了MediaMuxer和MediaCodec的基本用法。本程序主要是基于两个测试程序:一个是Grafika中的SoftInputSurfaceActivity和HWEncoderExperiments。它们一个是生成视频,一个生成音频,这里把它们结合一下,同时生成音频和视频。基本框架和流程如下:

首先是录音线程,主要参考HWEncoderExperiments。通过AudioRecord类接收来自麦克风的采样数据,然后丢给Encoder准备编码:

这里也可以设置AudioRecord的回调(通过setRecordPositionUpdateListener())来触发音频数据的读取。offerAudioEncoder()里主要是把audio采样数据送入音频MediaCodec的InputBuffer进行编码:

下面,参考Grafika-SoftInputSurfaceActivity,并加入音频处理。主循环大体分四部分:

第1部分是准备工作,除了video的MediaCodec,这里还初始化了audio的MediaCodec:

第2部分进入主循环,app在Surface上直接绘图,由于这个Surface是从MediaCodec中用createInputSurface()申请来的,所以画完后不用显式用queueInputBuffer()交给Encoder。drainVideoEncoder()和drainAudioEncoder()分别将编码好的音视频从buffer中拿出来(通过dequeueOutputBuffer()),然后交由MediaMuxer进行混合(通过writeSampleData())。注意音视频通过PTS(Presentation time stamp,决定了某一帧的音视频数据何时显示或播放)来同步,音频的time stamp需在AudioRecord从MIC采集到数据时获取并放到相应的bufferInfo中,视频由于是在Surface上画,因此直接用dequeueOutputBuffer()出来的bufferInfo中的就行,最后将编码好的数据送去MediaMuxer进行多路混合。

注意这里Muxer要等把audio track和video track都加入了再开始。MediaCodec在一开始调用dequeueOutputBuffer()时会返回一次INFO_OUTPUT_FORMAT_CHANGED消息。我们只需在这里获取该MediaCodec的format,并注册到MediaMuxer里。接着判断当前audio track和video track是否都已就绪,如果是的话就启动Muxer。

总结来说,drainVideoEncoder()的主逻辑大致如下,drainAudioEncoder也是类似的,只是把video的MediaCodec换成audio的MediaCodec即可。

第3部分是结束录制,发送EOS信息,这样在drainVideoEncoder()和drainAudioEncoder中就可以根据EOS退出内循环。第4部分为清理工作。把audio和video的MediaCodec,MediaCodec用的Surface及MediaMuxer对象释放。

最后几点注意:

1. 在AndroidManifest.xml里加上录音权限,否则创建AudioRecord对象时铁定失败:

<uses-permission android:name="android.permission.RECORD_AUDIO"/>

2. 音视频通过PTS同步,两个的单位要一致。

3. MediaMuxer的使用要按照Constructor -> addTrack -> start -> writeSampleData -> stop 的顺序。如果既有音频又有视频,在stop前两个都要writeSampleData()过。

Code references:

Grafika: https://github.com/google/grafika

Bigflake: http://bigflake.com/mediacodec/

HWEncoderExperiments:https://github.com/OnlyInAmerica/HWEncoderExperiments/tree/audioonly/HWEncoderExperiments/src/main/java/net/openwatch/hwencoderexperiments

Android test:http://androidxref.com/4.4.2_r2/xref/cts/tests/tests/media/src/android/media/cts/

http://androidxref.com/4.4.2_r2/xref/pdk/apps/TestingCamera2/src/com/android/testingcamera2/CameraRecordingStream.java

这篇关于Android中MediaMuxer和MediaCodec用例 - audio+video的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!