本文主要是介绍MobileNet V1论文阅读和代码解析,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

论文阅读

代码解析

论文阅读

1.前言

自从AlexNet在2012年获得ImageNet冠军以来,卷积神经网络在计算机视觉中随处可见。为了获得更高的准确率,现在的趋势是让网络越来越深,越来越复杂。然而这些改进会影响到网络的大小和速度。在很多现实世界的应用中,比如机器人,自动驾驶,增强现实等,需要图像识别任务在有限的计算资源平台上做出及时的反应。

这篇论文描述了一个很高效的网络模型和两个超参数,来实现比较小的模型去满足手机和嵌入式设备的需求。

其实最近已经开始有一些论文对小而高效的论文感兴趣了。很多不同的尝试但是都可以总结为要么压缩预训练网络要么直接训练小型的网络。而这篇文章是要设计一种网络架构能够适应不同的资源限制。MobileNet主要关注的是优化延迟,而其他很多文章主要考虑网络大小而不考虑速度。

2.MobileNet结构

2.1 Depthwise Separable Convolution

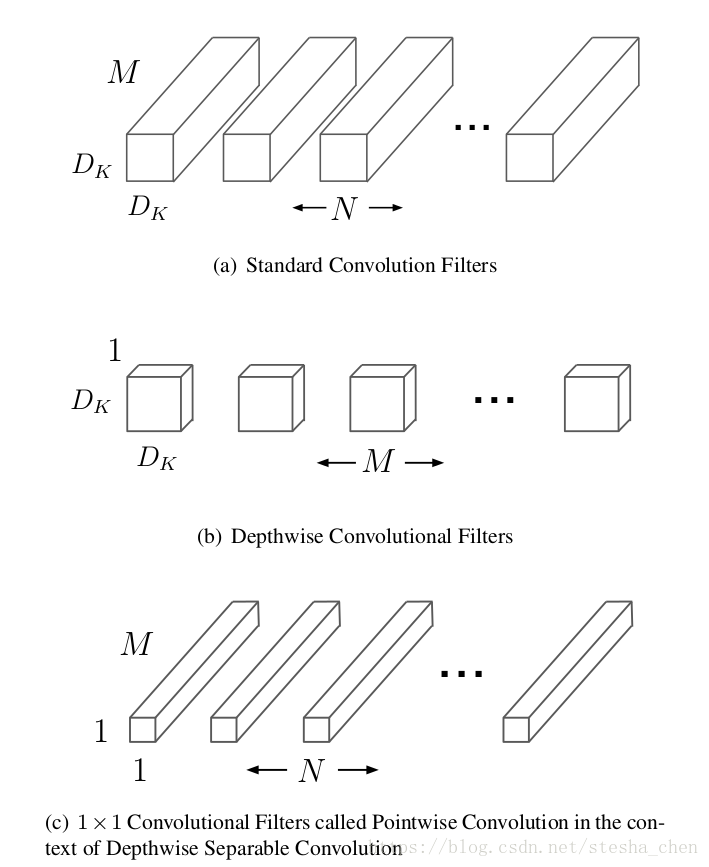

MobileNet的基础是Depthwise Separable Convolution(深度可分离卷积),这种卷积是将卷积进行了分解,分解成了一个depthwise convolution和一个1x1的卷积叫做pointwise convolution。Depthwise卷积是对input的每一个channel有一个filter,Pointwise卷积是对depthwise计算出来的结果进行1x1的卷积运算。标准的卷积运算是一步中就包含了filter计算和合并计算,然后直接将输入变成一个新的尺寸的输出。Depthwise separable convolution是将这个一步的操作分成了两层,一层做filter计算,一层做合并计算。这种分解的方式极大的减少了计算量和模型的大小。

先对上图的输入输出尺寸做一些说明。输入是尺寸为,输出的尺寸为

,

是输入的长宽,

是输入的channel(可以认为是depth),假设输出长宽不变

也是输出的长宽,

是输出的channel。

图(a)是标准的卷积运算需要的filter。对于标准的卷积计算方式,需要尺寸为的kernel,

是kernel的长宽。所以计算次数会是

图(b)是Depthwise卷积计算需要的filter。计算过程是将input的每一个channel都分开,为每一个channel设置一个kernel,因此需要个kernel,将每一个kernel和对应的channel进行卷积

这篇关于MobileNet V1论文阅读和代码解析的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!