本文主要是介绍莫烦强化学习视频笔记:第一节 1.1 什么是强化学习,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

目录

1. 如何学习?

2. 强化学习有哪些算法?

我们人类在进行学习时,总是从一开始什么都不知道,经过不断的尝试与纠错,最终获得正确解决问题方法的过程,这就可以看作一个强化学习过程。

实际,强化学习的例子很多:

- Alpha-Go在围棋场上战胜人类的高手 Alpha-Go 百度百科

- 让计算机学习如何玩一些经典的游戏,如Atari游戏:

这些都是让计算机不断地尝试并学习行为准则,以赢得围棋棋局或者在打砖块游戏中得到高分。

1. 如何学习?

想象此刻有一个虚拟的老师正在教计算机如何学习,但是他只能够为你的行为打分。那么如何通过这些分数来学习呢?很简单,通过记住高分、低分分别对应的行为,在学习中避免低分行为,在行为中总结经验。此特性可以称为分数导向性。

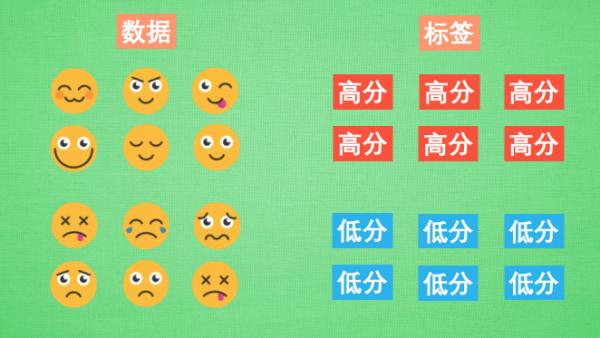

更进一步的,在监督学习中,我们在一开始就能够获得数据和标签。在强化学习中,我们也需要得到数据和标签,但是一开始并没有数据和标签,是通过一次次与环境交互产生行为,并获得对应的标签,再学习哪些数据能够对应上哪些标签,通过学习这种规律,来获取能够获得高分的行为。如下面这个例子:

- 实际上,一开始是一张空白的桌子(很像Windows纸牌游戏的桌子😅),只有数据和标签两个部分。我们的目的是尽量做一些开心的表情,以获得更高的分数。

- 我们不断做表情(假设我们不知道什么表情是开心的(高分)或伤心的(低分)),“虚拟老师”会告诉我们你的表情是低分还是高分(也就是标签),这样我们就会获得很多数据和标签啦。

- 我们通过大量做表情得到标签并从中获取一定的规律,你经过惨痛教训后,会发现做🙂就会高分,做😟就会低分。

- 你为了获得高分,就会一直做🙂。

2. 强化学习有哪些算法?

强化学习的算法有很多种,例如:

- 通过价值选行为:Q-Learning、Sarsa学习(这两种都是用表格的方式,也就是数据离散)、DQN(Deep Q Network 使用神经网络)

- 直接选行为:Policy Gradients(策略梯度)

- 想象环境并从中学习(这个真的🐂🍺了,环境都没有的):基于模型的强化学习(Model Based RL)

这篇关于莫烦强化学习视频笔记:第一节 1.1 什么是强化学习的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!