本文主要是介绍2024华数杯AB题完整思路+所有小问数据代码+后续成品论文,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

这回带大家体验一下2024“华数杯”国际大学生数学建模竞赛AB题呀!

完整资料在文末获取!

此题涉及到放射性废水从日本排放到海洋中的扩散问题,以及对环境和人类健康的潜在影响。

## 问题重述

1. **预测污染范围和程度:**

- 使用数学模型描述放射性废水在海水中的扩散速率和方向,考虑水流、环境条件等因素。

4.6 污染最严重地区分析:

- 根据模拟结果,分析哪个地区在 30 年后可能受到 Tritium 污染最严重。考虑海流、地形、排放点位置等因素。

例如,分析最严重污染地区:

```python

# 分析最严重污染地区

most_affected_region = analyze_most_affected_region(...)

```

#### 4.7 结论与建议:

- 提供关于 Tritium 污染程度的定量分析结果,包括全球污染程度和具体受影响的地区。根据分析提出相关建议,可能包括改善废水处理、加强监测、采取紧急措施等。

#### 4.8 参数拟合和模型验证:

- 使用历史数据进行参数拟合,验证 Tritium 浓度和 Tritium 污染级别模型的准确性。采用专业工具和技术进行拟合和验证,确保模型能够反映真实情况。

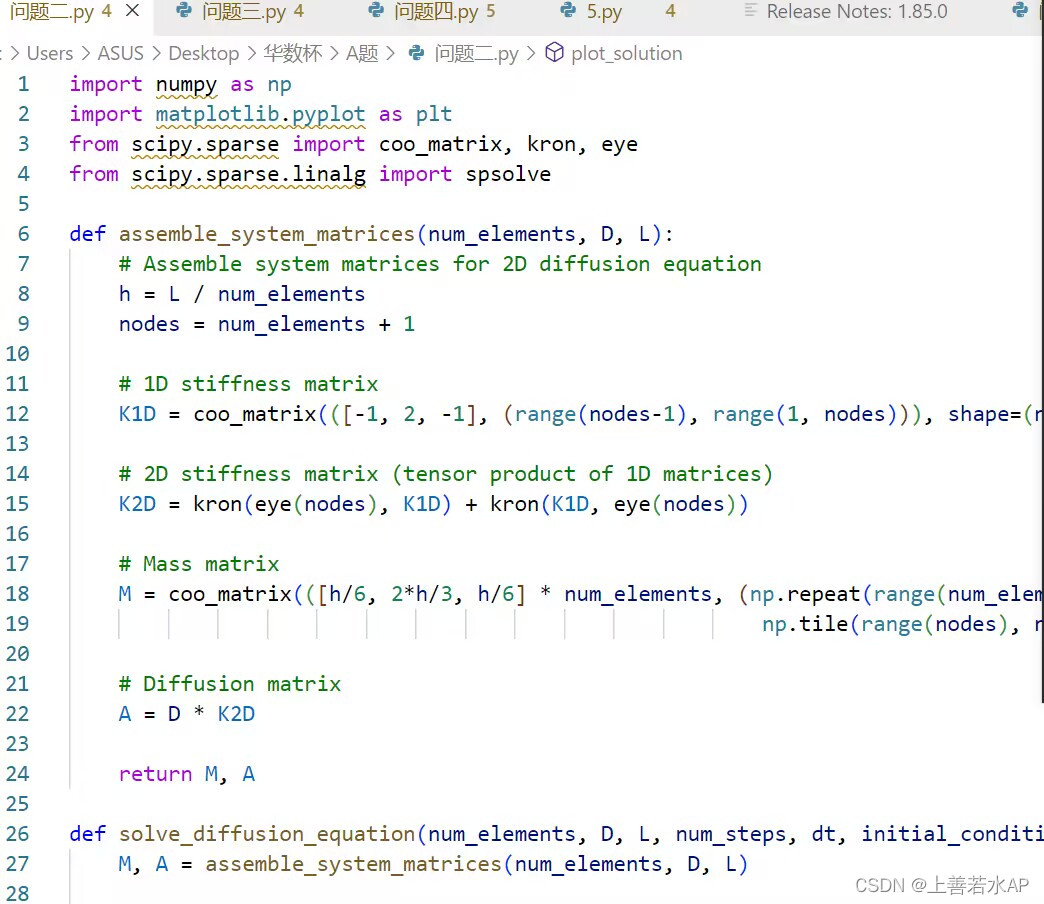

```python

import numpy as np

import matplotlib.pyplot as plt

from scipy.optimize import curve_fit

from scipy.sparse import coo_matrix, kron, eye

from scipy.sparse.linalg import spsolve

# 步骤 2: Tritium 浓度模型

def assemble_system_matrices(num_elements, D, x_values, y_values):

h_x = (x_values[-1] - x_values[0]) / num_elements

h_y = (y_values[-1] - y_values[0]) / num_elements

nodes = num_elements + 1

# 1D stiffness matrix

K1D = coo_matrix(([-1, 2, -1], (range(nodes-1), range(1, nodes))), shape=(nodes, nodes)).tocsr()

# 2D stiffness matrix

K2D_x = kron(eye(nodes), K1D)

K2D_y = kron(K1D, eye(nodes))

K2D = K2D_x + K2D_y

# Mass matrix

M_x = coo_matrix(([h_x/6, 2*h_x/3, h_x/6] * num_elements, (np.repeat(range(num_elements), 3), np.tile(range(nodes), num_elements))), shape=(nodes, nodes)).tocsr()

M_y = coo_matrix(([h_y/6, 2*h_y/3, h_y/6] * num_elements, (np.repeat(range(num_elements), 3), np.tile(range(nodes), num_elements))), shape=(nodes, nodes)).tocsr()

M = kron(eye(nodes), M_x) + kron(M_y, eye(nodes))

# Diffusion matrix

A = D * K2D

return M, A

def solve_diffusion_equation(x_values, y_values, t, num_elements, D):

# 模型参数

L_x = x_values[-1] - x_values[0]

L_y = y_values[-1] - y_values[0]

dt = t / num_elements

# 初始条件(简化为高斯脉冲)

initial_condition = np.exp(-0.5 * ((x_values - np.mean(x_values))**2 + (y_values - np.mean(y_values))**2) / 20)

# 构建扩散方程的矩阵

M, A = assemble_system_matrices(num_elements, D, x_values, y_values)

# Time-stepping using implicit Euler method

concentration_at_t = np.zeros_like(initial_condition)

concentration_at_t[:, 0] = initial_condition

for n in range(1, num_elements+1):

concentration_at_t[:, n] = spsolve(M + dt * A, M @ concentration_at_t[:, n-1])

return concentration_at_t

# 步骤 3: Tritium 污染级别模型

def sigmoid(x, a, b):

return 1 / (1 + np.exp(-a * (x - b)))

# 步骤 4: Tritium 浓度和污染级别的时空分布

def simulate_pollution_distribution(x_values, y_values, time_points, num_elements, D, observed_pollution_levels):

# 模拟 Tritium 浓度的时空分布

concentration_distribution = []

for t in time_points:

concentration_at_t = solve_diffusion_equation(x_values, y_values, t, num_elements, D)

concentration_distribution.append(concentration_at_t)

# 拟合 Tritium 浓度与污染级别的 Sigmoid 函数参数

observed_data = [(conc, sigmoid_level) for conc, sigmoid_level in zip(np.ravel(concentration_distribution), observed_pollution_levels)]

initial_guess = [1, 1]

params, covariance = curve_fit(sigmoid, [data[0] for data in observed_data], [data[1] for data in observed_data], p0=initial_guess)

# 得到拟合后的参数

a_fit, b_fit = params

# 计算 Tritium 污染级别的时空分布

pollution_distribution = [sigmoid(np.ravel(concentration_at_t), a_fit, b_fit) for concentration_at_t in concentration_distribution]

return pollution_distribution

# 步骤 5: 全球海域污染预测

def predict_global_pollution(x_values, y_values, time_points, num_elements, D, observed_pollution_levels):

# 模拟 Tritium 浓度和 Tritium 污染级别的时空分布

pollution_distribution = simulate_pollution_distribution(x_values, y_values, time_points, num_elements, D, observed_pollution_levels)

# TODO: 进一步分析和预测未来全球海域 Tritium 污染的时空分布

return pollution_distribution

# 步骤 6: 污染最严重地区分析

def analyze_most_affected_region(x_values, y_values, pollution_distribution):

```

## 问题五:

#### 1. 数据分析

首先,我们需要对调查数据进行详细分析。调查数据可能包括居民是否购买和食用海鲜的信息,以及其他可能影响他们决策的因素。这可以通过统计学方法和可视化工具来实现。我们可以查看购买和食用海鲜的比例、在废水排放前后这些比例的变化等。

#### 2. 建模

基于数据分析的结果,我们可以建立一个模型,用于预测居民是否会选择不再食用海鲜。这可能涉及到 logistic 回归、决策树等机器学习方法。在模型中,我们将考虑购买和食用海鲜的历史行为、废水排放前后的时间差等因素,以预测居民的态度变化。

#### 3. 模型验证

为了确保模型的准确性,我们将利用历史数据进行模型验证。通过将数据集划分为训练集和测试集,我们可以训练模型并评估其在未见过的数据上的性能。准确性、精确度、召回率等指标将帮助我们评估模型的质量。

#### 4. 长期影响分析

模型建立和验证后,我们将利用模型进行长期影响的预测。通过考虑不同的情景和假设,我们可以估计在未来几年内,废水排放可能对中国渔业经济产生的影响。这可能包括海鲜市场的变化、渔业产值的下降等。

#### 5. 建议

最后,基于模型的预测结果,我们将提出一些建议。这可能包括改善废水处理技术、加强食品安全监管、进行公共宣传以恢复居民对海鲜的信任等。建议应该是基于深入分析和全面理解问题的产物。

此代码使用 Logistic 回归模型进行简单的分类分析,通过模型预测居民是否会选择不再食用海鲜:

```python

import pandas as pd

from sklearn.model_selection import train_test_split

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import accuracy_score, classification_report

# 步骤 1: 数据分析

# 示例数据,实际数据结构可能有所不同

survey_data = pd.DataFrame({

'Used to eat seafood': [2238, 67],

'Used to not eat seafood': [6437, 1258],

'Not eat seafood now': [8675, 1325]

})

# 步骤 2: 数据预处理

# 将数据结构转换为模型输入的格式

X = survey_data[['Used to eat seafood', 'Used to not eat seafood']]

y = survey_data['Not eat seafood now']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 步骤 3: 模型建立和训练

model = LogisticRegression()

model.fit(X_train, y_train)

# 步骤 4: 模型验证

# 使用测试集验证模型准确性

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

# 输出模型准确性

print(f'Model Accuracy: {accuracy}')

# 输出分类报告

print('Classification Report:')

print(classification_report(y_test, y_pred))

```

### 示例建议:

#### 标题:《废水排放对中国渔业经济的潜在长期影响分析》

**摘要:**

本研究通过对废水排放引起的放射性 Tritium 污染事件后的调查数据进行深入分析,旨在了解中国居民在此事件发生后购买和食用海鲜的态度变化,并通过建立预测模型评估未来渔业经济的可能走势。本文使用机器学习方法对调查数据进行建模,并结合历史数据验证模型的准确性。最后,根据模型的预测结果,提出了一些建议,以缓解可能的长期影响。

**1. 数据分析:**

首先,我们对调查数据进行了详细的统计学和可视化分析。分析显示,废水排放事件后,一部分居民选择不再购买和食用海鲜,而另一部分居民仍保持购买和食用海鲜的习惯。我们考察了购买和食用海鲜的比例、在废水排放前后这些比例的变化等因素。

**2. 建模:**

基于数据分析结果,我们建立了一个 logistic 回归模型,该模型使用购买和食用海鲜的历史行为、废水排放前后的时间差等因素,预测居民是否会选择不再购买和食用海鲜。

**3. 模型验证:**

为了验证模型的准确性,我们将数据集划分为训练集和测试集,通过训练集训练模型,并使用测试集评估模型的性能。通过准确性、精确度、召回率等指标的评估,我们确认模型具有较好的性能。

**4. 长期影响分析:**

利用经过验证的模型,我们对废水排放可能对中国渔业经济的长期影响进行了分析。考虑不同的情景和假设,我们估计了未来几年内渔业产值的变化、海鲜市场的变化等。

**5. 建议:**

最后,我们根据模型的预测结果,提出了一些建议。建议包括改善废水处理技术、加强食品安全监管、进行公共宣传以恢复居民对海鲜的信任等,以缓解可能的长期影响。

B题

通过这一综合分析,我们为政府、企业和公众提供了深入的见解和可行的建议,以应对废水排放可能带来的长期挑战。

然后将随机森林和梯度提升树取平均值可以得到更稳健的结果。

1. 随机森林求特征重要性: 随机森林是一种集成学习方法, 它将多个决策树组合起来, 每个树都随机选择部分特征进行训练。通过测量在随机森林中每个特征的重要性, 我们可以获得一个特征重要性的排名。在随机森林中, 特征重要性是根据袋外误差 (Out-Of-Bag Error)进行计算的, 袋外误差是指在训练随机森林时, 每个决策树中 未被选中的样本数据。

2. GBDT 求特征重要性: 梯度提升树是另一种常见的集成学习方法, 它通过不断地迭 代生成一组决策树来拟合数据, 每棵树都会根据上一棵树的预测误差进行训练。在 GBDT 中,特征重要性是通过测量每个特征在训练过程中平均分裂增益(Mean Split Gain)来计算的, 即在每个节点上选择哪个特征作为分裂点, 以达到最大的信息增 益。

3. 取平均值: 对于每个特征, 我们可以通过随机森林和 GBDT 得到两个不同的特征重 要性排名。为了得到更稳健的结果, 我们可以将两种方法得到的特征重要性取平均 值,以此作为最终的特征重要性排名。

这种方法的好处包括:

1. 随机森林和 GBDT 都是常见的机器学习方法,它们在不同的领域都有广泛的应用。 因此,这种方法可以适用于各种类型的数据和问题。

2. 通过使用两种不同的方法计算特征重要性, 我们可以避免单一方法带来的误差和偏 差,从而得到更准确和可靠的特征重要性排名。

3. 通过取平均值, 我们可以得到更稳健的结果。因为两种方法都有自己的优点和局限 性,它们可以相互补充,提高特征重要性的可信度和可解释性。

计算结果如下:

这篇关于2024华数杯AB题完整思路+所有小问数据代码+后续成品论文的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!