本文主要是介绍【网络爬虫】使用Python披露采集Up主视频详情信息,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、问题

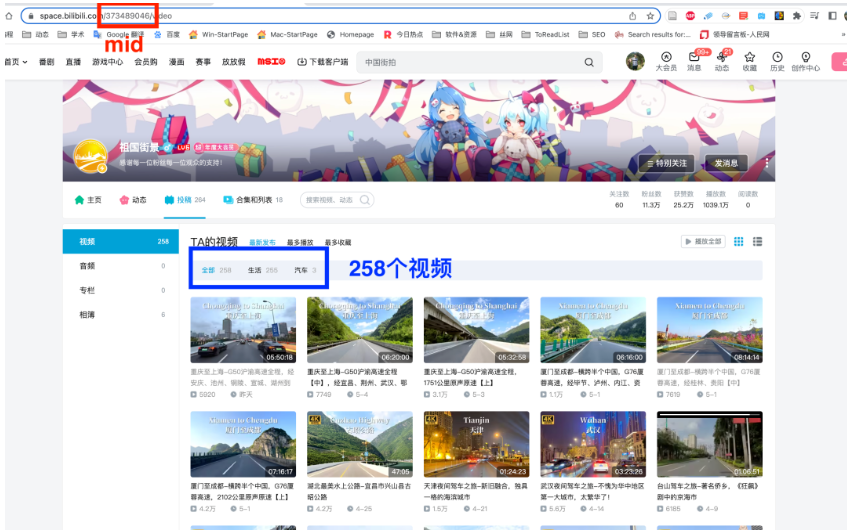

看到一个B站账号-祖国街景,使用行车记录仪记录中国城市,同时该账号还有youtube账号(中国街景), 感觉视频的评论和弹幕可以用来做城市形象方面的数据分析。

但是需要有每个视频的Bvid才能采集。今天要分享的内容是如何获取某Up主的所有视频对应的Bvid等信息 。完整的爬虫撰写步骤:

- 发现网址规律,获得批量url

- 对某个url发起成功的访问

- 解析该url对应的网页数据

- 存储到csv

- 对所有url, 重复步骤2-4

为了减少工作量, 我就简单分析下网址规律,直接上代码。

二、网址规律

要获取某Up主视频Bvid等信息,只需要获得视频列表mid值,如下图。

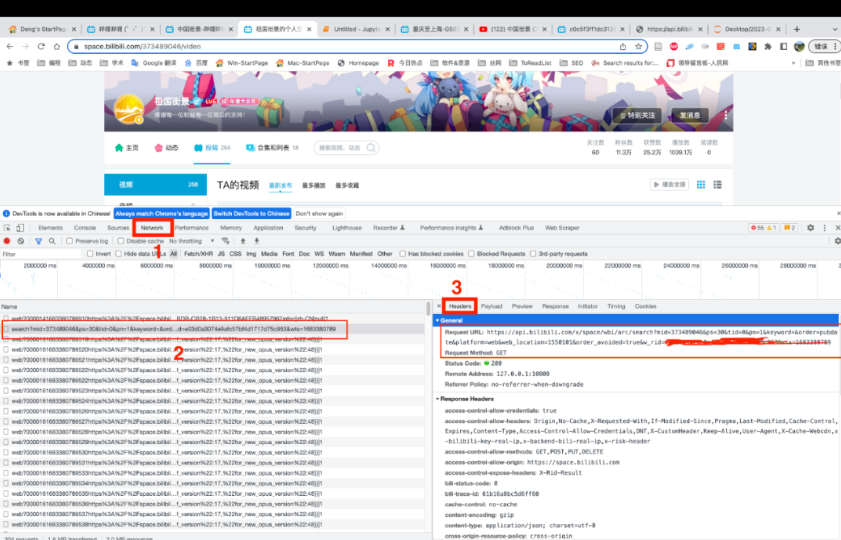

找网址规律的方法是打开开发者工具Network面板, 在当前网页刷新, 按照截图标号顺序点击鼠标, 得到网址规律(下方截图红3)。剔除了对结果影响不大的参数,最终得到网址规律模板 template 。

template = 'https://api.bilibili.com/x/space/wbi/arc/search?mid={mid}&ps=30&pn={page}'

三、 爬虫代码

下方代码只需要改变 Up 主 mid 值,其他地方不要改动。我设置了限速,每秒访问一次, 直接运行代码,假设Up主有 9 页, 程序大概运行 9s 左右。

import requests

import csv

import timeheaders = {"user-agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/112.0.0.0 Safari/537.36"}

template = 'https://api.bilibili.com/x/space/wbi/arc/search?mid={mid}&ps=30&pn={page}'#只需更改这个参数,就能爬视频列表信息

mid = '373489046'with open('{mid}_infos.csv'.format(mid=mid), 'w', encoding='utf-8', newline='') as csvf:fieldnames = ['comment', 'typeid', 'play', 'pic', 'subtitle', 'description', 'copyright', 'title', 'review', 'author', 'mid', 'created', 'length', 'video_review', 'aid', 'bvid', 'hide_click', 'is_pay', 'is_union_video', 'is_steins_gate', 'is_live_playback', 'meta', 'is_avoided', 'attribute']writer = csv.DictWriter(csvf, fieldnames=fieldnames)writer.writeheader()url = template.format(mid=mid, page=1)resp = requests.get(url, headers=headers)record_num = resp.json()['data']['page']['count']max_page = int(record_num/30)+1for page in range(1, max_page+1):print('正在爬Up主第 {} 页'.format(page))url = template.format(mid=mid, page=page)resp = requests.get(url, headers=headers)vlist = resp.json()['data']['list']['vlist']for video in vlist:writer.writerow(video)time.sleep(1)

Run

正在爬Up主第 1 页正在爬Up主第 2 页正在爬Up主第 3 页正在爬Up主第 4 页正在爬Up主第 5 页正在爬Up主第 6 页正在爬Up主第 7 页正在爬Up主第 8 页正在爬Up主第 9 页

四、导入数据

获取到Up主「祖国街景」的258个视频信息,含有的字段

comment 评论数

typeid 视频类型(猜测)

play 播放次数

pic 封面图链接

subtitle 副标题

description 视频描述

copyright 是否原创(猜测)

title 视频标题

review 评论数

author Up主昵称

mid Up主mid

created 创建时间(时间戳)

length 视频时长

video_review 是否原创(猜测)

aid 视频aid号

bvid 视频Bvid号

hide_click 未知

is_pay 是否付费

is_union_video 是否为联合制作

is_steins_gate 未知

is_live_playback 是否为直播回放

meta 视频元信息(含投币量、喜欢数、分享数)

is_avoided 未知

attribute 未知

import pandas as pddf = pd.read_csv('373489046_infos.csv')df.head()

#视频数量

len(df)

Run

259

#前5个内容

df['title'].tolist()[:5]

Run

['“800公里”时速(8倍速)从厦门开2000公里的车到成都是什么样的体验?','重庆至上海-G50沪渝高速全程,经安庆、池州、铜陵、宣城、湖州到达上海【下】','重庆至上海-G50沪渝高速全程【中】,经宜昌、荆州、武汉、鄂州、黄石','重庆至上海-G50沪渝高速全程,1751公里原声原速【上】','厦门至成都-横跨半个中国,G76厦蓉高速,经毕节、泸州、内江、资阳【下】']

#视频元信息(含投币量、喜欢数、分享数)

df['meta'].tolist()[:5]

Run

["{'id': 124822, 'title': '高速公路', 'cover': 'https://archive.biliimg.com/bfs/archive/634c1b4659e6958cba47322cca344a69f8121f34.jpg', 'mid': 373489046, 'intro': '', 'sign_state': 0, 'attribute': 140, 'stat': {'season_id': 124822, 'view': 1835970, 'danmaku': 14479, 'reply': 7495, 'favorite': 21838, 'coin': 10240, 'share': 5473, 'like': 40496, 'mtime': 1683437054, 'vt': 6497104, 'vv': 0}, 'ep_count': 38, 'first_aid': 253218067, 'ptime': 1683417600, 'ep_num': 0}","{'id': 124822, 'title': '高速公路', 'cover': 'https://archive.biliimg.com/bfs/archive/634c1b4659e6958cba47322cca344a69f8121f34.jpg', 'mid': 373489046, 'intro': '', 'sign_state': 0, 'attribute': 140, 'stat': {'season_id': 124822, 'view': 1835970, 'danmaku': 14479, 'reply': 7495, 'favorite': 21838, 'coin': 10240, 'share': 5473, 'like': 40496, 'mtime': 1683437054, 'vt': 6497104, 'vv': 0}, 'ep_count': 38, 'first_aid': 253218067, 'ptime': 1683417600, 'ep_num': 0}","{'id': 124822, 'title': '高速公路', 'cover': 'https://archive.biliimg.com/bfs/archive/634c1b4659e6958cba47322cca344a69f8121f34.jpg', 'mid': 373489046, 'intro': '', 'sign_state': 0, 'attribute': 140, 'stat': {'season_id': 124822, 'view': 1835970, 'danmaku': 14479, 'reply': 7495, 'favorite': 21838, 'coin': 10240, 'share': 5473, 'like': 40496, 'mtime': 1683437054, 'vt': 6497104, 'vv': 0}, 'ep_count': 38, 'first_aid': 253218067, 'ptime': 1683417600, 'ep_num': 0}","{'id': 124822, 'title': '高速公路', 'cover': 'https://archive.biliimg.com/bfs/archive/634c1b4659e6958cba47322cca344a69f8121f34.jpg', 'mid': 373489046, 'intro': '', 'sign_state': 0, 'attribute': 140, 'stat': {'season_id': 124822, 'view': 1835970, 'danmaku': 14479, 'reply': 7495, 'favorite': 21838, 'coin': 10240, 'share': 5473, 'like': 40496, 'mtime': 1683437054, 'vt': 6497104, 'vv': 0}, 'ep_count': 38, 'first_aid': 253218067, 'ptime': 1683417600, 'ep_num': 0}","{'id': 124822, 'title': '高速公路', 'cover': 'https://archive.biliimg.com/bfs/archive/634c1b4659e6958cba47322cca344a69f8121f34.jpg', 'mid': 373489046, 'intro': '', 'sign_state': 0, 'attribute': 140, 'stat': {'season_id': 124822, 'view': 1835970, 'danmaku': 14479, 'reply': 7495, 'favorite': 21838, 'coin': 10240, 'share': 5473, 'like': 40496, 'mtime': 1683437054, 'vt': 6497104, 'vv': 0}, 'ep_count': 38, 'first_aid': 253218067, 'ptime': 1683417600, 'ep_num': 0}"]

这篇关于【网络爬虫】使用Python披露采集Up主视频详情信息的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!