本文主要是介绍AlexNet(fashion-mnist),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

前言

AlexNet相较于LeNet-5具有更深的网络结构,采用relu激活函数。

AlexNet

参数更多,计算量更大,计算速度更慢,精度更高。

net=nn.Sequential(nn.Conv2d(1,96,kernel_size=11,stride=4,padding=1),nn.ReLU(),nn.MaxPool2d(kernel_size=3,stride=2),nn.Conv2d(96,256,kernel_size=5,padding=2),nn.ReLU(),nn.MaxPool2d(kernel_size=3,stride=2),nn.Conv2d(256,384,kernel_size=3,padding=1),nn.ReLU(),nn.Conv2d(384,384,kernel_size=3,padding=1),nn.ReLU(),nn.Conv2d(384,256,kernel_size=3,padding=1),nn.ReLU(),nn.MaxPool2d(kernel_size=3,stride=2),nn.Flatten(),nn.Linear(6400,4096),nn.ReLU(),nn.Dropout(p=0.5),nn.Linear(4096,4096),nn.ReLU(),nn.Dropout(p=0.5),nn.Linear(4096,10)

)

这篇关于AlexNet(fashion-mnist)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

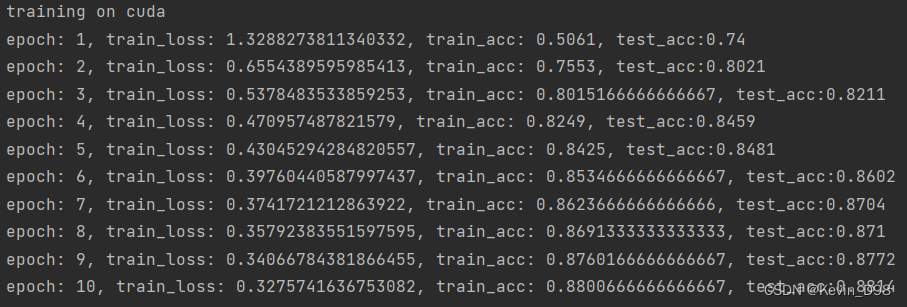

![[总结] Alexnet](https://i-blog.csdnimg.cn/blog_migrate/15f7857b6e0127fdc3320c444ed9766f.png)