本文主要是介绍论文笔记End-to-end flow correlation tracking with spatial-temporal attention,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文笔记End-to-end flow correlation tracking with spatial-temporal attention

- 1. 标题及来源

- 2. 阅读目的

- 3. 领域

- 4. 拟解决的问题

- 5. 提出的方法

- 5.1 算法概要

- 5.2 Spatial-temporal attention module

- 6. 结果

- 6.1 OTB-2013实验结果

- 6.2 OTB-2015实验结果

- 6.3 VOT-2015实验结果

- 6.4 VOT-2016实验结果

- 6.5 消融实验

- 7. 改进&存在的问题

- 8. 可借鉴的点

- 9. 知识补充

- 9.1 Hadamard Product(哈达玛积)

- 9.2 bilinear interpolation(双线性插值)

- 9.3 cosine similarity(余弦相似度)

- 9.4 光流(optical flow)

- 9.5 RoI Pooling和RoI Align

- 9.6 基于相关滤波的目标跟踪

1. 标题及来源

End-to-end flow correlation tracking with spatial-temporal attention, CVPR 2018

2. 阅读目的

1. 了解他人如何将时序信息加入到网络中

2. spatial-temporal attention(时空注意力机制)

3. 领域

Object tracking

4. 拟解决的问题

1. 将时序信息加入到网络中来解决遮挡问题和形变问题

5. 提出的方法

5.1 算法概要

该算法分为两个分支。

在Current Branch中,使用Feature Net提取当前帧的特征 ψ ( z ) \psi(z) ψ(z)

在Historical Branch中,

- 前T帧i都和第t-1帧做光流计算,

- 用光流wrap第i帧的特征,

- 把这些特征融合到一起,形成一个比较好的特征

- 将融合后的特征通过spatial-temporal attention模块重新定义权重,形成新的特征 ψ ( x ) \psi(x) ψ(x)

- 将 ψ ( z ) 和 ψ ( x ) \psi(z)和\psi(x) ψ(z)和ψ(x)输入到CF层获得响应值最大的点,这个就是待跟踪的目标

5.2 Spatial-temporal attention module

spatial attention

作者对前i帧的加权融合提出了一种新的加权策略

简单来讲,就是衡量第 i 帧的特征和t-1帧像不像,像的话就给一个比较大的权值,不像就给一个比较小的权值

temporal attention

实际上就是通道注意力机制,即对各特征通道进行加权,重新定义每个特征通道的权重。对于激活程度较大、贡献度较大的通道给予大的权重;对于激活程度较小、贡献度较小的通道给予小的权重

6. 结果

6.1 OTB-2013实验结果

在success plots of OPE中,FlowTrack的AUC score是0.689,超过了VOT2016的冠军CCOT,并且超过了另外一个使用flow information的算法SINT+

在Precision plots of OPE中,FlowTrack的得分是0.921,也超过了CCOT和SINT+。

效果能得到提升主要归功于丰富的光流信息

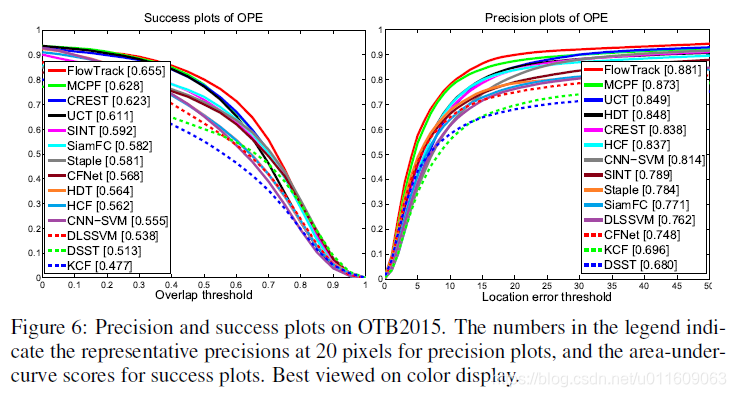

6.2 OTB-2015实验结果

从图中可以发现FlowTrack算法的效果是最好的

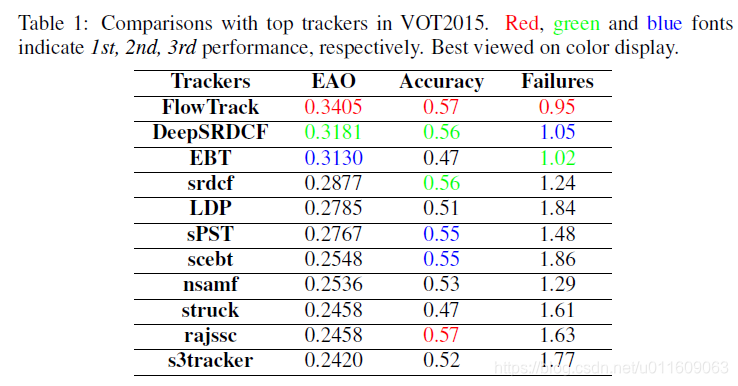

6.3 VOT-2015实验结果

6.4 VOT-2016实验结果

6.5 消融实验

decay:fuse the wraped feature maps by decaying with time

从表中可以发现,

- 当加入flow后,算法的提升效果都超过了6%

- 端到端训练的必要性:当使用fix flow时,除了在OTB2015数据集上,算法的效果得到了提升,但是在其它数据集上的效果都下降了。

- flow aggregation的有效性:对比decay与FlowTr可以发现,VOT2015和VOT2016上的EAO提升了3%个点

- temporal attention进一步提升了效果

7. 改进&存在的问题

1. 算法的速度较慢,只有在TITAN X上只有12fps

2. 算法的效果并不能超过级联RPN(CVPR2019)

8. 可借鉴的点

1. spatial-temporal attention机制

详见5.2

2. 光流的融合方式

取最近的T帧,然后将这T帧提取分别与第t-1帧计算光流,然后将这T帧的光流融合在一起,使用注意力机制,对每一帧赋予不同的权重

9. 知识补充

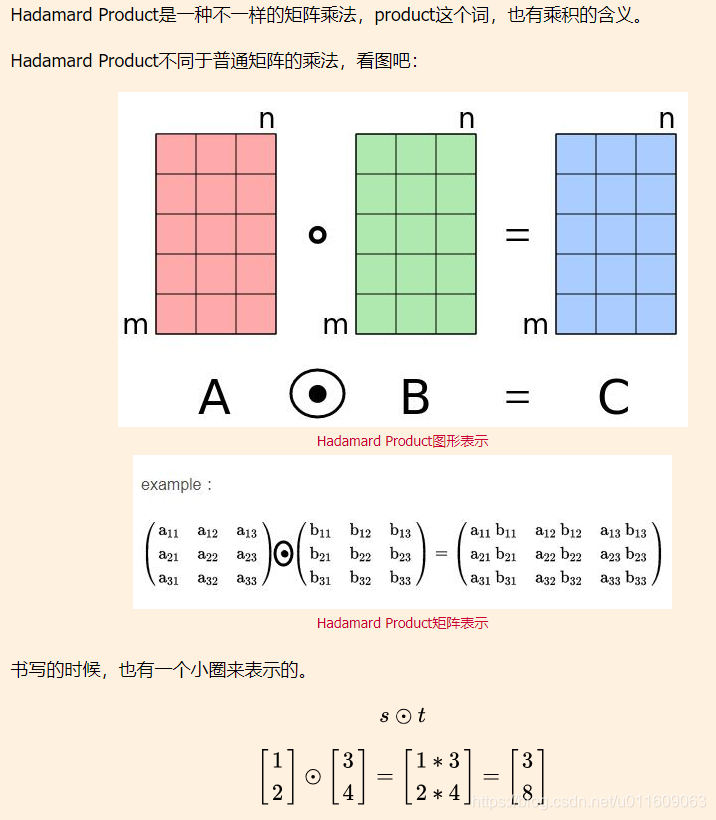

9.1 Hadamard Product(哈达玛积)

Hadamard Product:矩阵中对应位置相乘

参考资料:https://www.maixj.net/misc/hadamard-product-19256

9.2 bilinear interpolation(双线性插值)

参考资料:https://blog.csdn.net/xbinworld/article/details/65660665

9.3 cosine similarity(余弦相似度)

余弦相似度:两个向量之间夹角的余弦值

s i m i l a r i t y = c o s ( θ ) = A ⋅ B ∣ ∣ A ∣ ∣ ∣ ∣ B ∣ ∣ similarity = cos(\theta) = \frac{A \cdot B}{||A|| \ ||B||} similarity=cos(θ)=∣∣A∣∣ ∣∣B∣∣A⋅B

参考资料:https://www.jianshu.com/p/fb4b38eb452d

9.4 光流(optical flow)

参考资料:https://blog.csdn.net/yushupan/article/details/78823548

9.5 RoI Pooling和RoI Align

参考资料:https://www.cnblogs.com/wangyong/p/8523814.html

9.6 基于相关滤波的目标跟踪

参考资料:https://blog.csdn.net/qq_34919792/article/details/89893433

这篇关于论文笔记End-to-end flow correlation tracking with spatial-temporal attention的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!