本文主要是介绍python机器学习之支持向量机——探索核函数在不同数据集上的表现,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

探索核函数在不同数据集上的表现

核函数:

** 导入所需要的库和模块**

import numpy as np

import matplotlib.pyplot as plt

from matplotlib.colors import ListedColormap

from sklearn import svm#from sklearn.svm import SVC 两者都可以

from sklearn.datasets import make_circles, make_moons, make_blobs,make_classification创建数据集,定义核函数的选择

n_samples = 100datasets = [make_moons(n_samples=n_samples, noise=0.2, random_state=0),make_circles(n_samples=n_samples, noise=0.2, factor=0.5, random_state=1),make_blobs(n_samples=n_samples, centers=2, random_state=5),#分簇的数据集make_classification(n_samples=n_samples,n_features = 2,n_informative=2,n_redundant=0, random_state=5)#n_features:特征数,n_informative:带信息的特征数,n_redundant:不带信息的特征数]Kernel = ["linear","poly","rbf","sigmoid"]#四个数据集分别是什么样

for X,Y in datasets:plt.figure(figsize=(5,4))plt.scatter(X[:,0],X[:,1],c=Y,s=50,cmap="rainbow")

我们总共有四个数据集,四种核函数,我们希望观察每种数据集下每个核函数的表现。以核函数为列,以图像分布为行,我们总共需要16个子图来展示分类结果。而同时,我们还希望观察图像本身的状况,所以我们总共需要20个子图,其中第一列是原始图像分布,后面四列分别是这种分布下不同核函数的表现。

构建子图

nrows=len(datasets)

ncols=len(Kernel) + 1fig, axes = plt.subplots(nrows, ncols,figsize=(20,16))

开始进行子图循环

nrows=len(datasets)

ncols=len(Kernel) + 1fig, axes = plt.subplots(nrows, ncols,figsize=(20,16))#第一层循环:在不同的数据集中循环

for ds_cnt, (X,Y) in enumerate(datasets):#在图像中的第一列,放置原数据的分布ax = axes[ds_cnt, 0]if ds_cnt == 0:ax.set_title("Input data")ax.scatter(X[:, 0], X[:, 1], c=Y, zorder=10, cmap=plt.cm.Paired,edgecolors='k')ax.set_xticks(())ax.set_yticks(())#第二层循环:在不同的核函数中循环#从图像的第二列开始,一个个填充分类结果for est_idx, kernel in enumerate(Kernel):#定义子图位置ax = axes[ds_cnt, est_idx + 1]#建模clf = svm.SVC(kernel=kernel, gamma=2).fit(X, Y)score = clf.score(X, Y)#绘制图像本身分布的散点图ax.scatter(X[:, 0], X[:, 1], c=Y,zorder=10,cmap=plt.cm.Paired,edgecolors='k')#绘制支持向量ax.scatter(clf.support_vectors_[:, 0], clf.support_vectors_[:, 1], s=50,facecolors='none', zorder=10, edgecolors='k')# facecolors='none':透明的#绘制决策边界x_min, x_max = X[:, 0].min() - .5, X[:, 0].max() + .5y_min, y_max = X[:, 1].min() - .5, X[:, 1].max() + .5#np.mgrid,合并了我们之前使用的np.linspace和np.meshgrid的用法#一次性使用最大值和最小值来生成网格#表示为[起始值:结束值:步长]#如果步长是复数,则其整数部分就是起始值和结束值之间创建的点的数量,并且结束值被包含在内XX, YY = np.mgrid[x_min:x_max:200j, y_min:y_max:200j]#np.c_,类似于np.vstack的功能Z = clf.decision_function(np.c_[XX.ravel(), YY.ravel()]).reshape(XX.shape)#填充等高线不同区域的颜色ax.pcolormesh(XX, YY, Z > 0, cmap=plt.cm.Paired)#绘制等高线ax.contour(XX, YY, Z, colors=['k', 'k', 'k'], linestyles=['--', '-', '--'],levels=[-1, 0, 1])#设定坐标轴为不显示ax.set_xticks(())ax.set_yticks(())#将标题放在第一行的顶上if ds_cnt == 0:ax.set_title(kernel)#为每张图添加分类的分数 ax.text(0.95, 0.06, ('%.2f' % score).lstrip('0'), size=15, bbox=dict(boxstyle='round', alpha=0.8, facecolor='white')#为分数添加一个白色的格子作为底色, transform=ax.transAxes #确定文字所对应的坐标轴,就是ax子图的坐标轴本身, horizontalalignment='right' #位于坐标轴的什么方向)plt.tight_layout()

plt.show()

性核函数和多项式核函数在非线性数据上表现会浮动,如果数据相对线性可分,则表现不错,如果是像环形数据那样彻底不可分的,则表现糟糕。在线性数据集上,线性核函数和多项式核函数即便有扰动项也可以表现不错,可见多项式核函数是虽然也可以处理非线性情况,但更偏向于线性的功能。

sigmoid 核函数明显不如rbf,对扰动项也比较弱,所以他功能比较弱小,很少被用到。

rbf,高斯径向基核函数基本在任何数据集上都表现不错,属于比较万能的核函数。

探索核函数的优势和缺陷

但其实rbf和poly都有自己的弊端,我们使用乳腺癌数据

集作为例子来展示一下:

from sklearn.datasets import load_breast_cancer

from sklearn.svm import SVC

from sklearn.model_selection import train_test_split

import matplotlib.pyplot as plt

import numpy as np

from time import time

import datetimedata = load_breast_cancer()

X = data.data

y = data.targetX.shape

np.unique(y)plt.scatter(X[:,0],X[:,1],c=y)

plt.show()Xtrain, Xtest, Ytrain, Ytest = train_test_split(X,y,test_size=0.3,random_state=420)Kernel = ["linear","poly","rbf","sigmoid"]for kernel in Kernel:time0 = time()clf= SVC(kernel = kernel, gamma="auto"# , degree = 1, cache_size=10000#使用计算的内存,单位是MB,默认是200MB).fit(Xtrain,Ytrain)print("The accuracy under kernel %s is %f" % (kernel,clf.score(Xtest,Ytest)))print(time()-time0)

Kernel = ["linear","rbf","sigmoid"]for kernel in Kernel:time0 = time()clf= SVC(kernel = kernel, gamma="auto"# , degree = 1, cache_size=5000).fit(Xtrain,Ytrain)print("The accuracy under kernel %s is %f" % (kernel,clf.score(Xtest,Ytest)))print(time()-time0)

可以发现poly()这个函数带的话根本运行不起来。所以只能抛去poly,。

把degree参数调整为1,多项式核函数应该也可以得到不错的结果。

Kernel = ["linear","poly","rbf","sigmoid"]for kernel in Kernel:time0 = time()clf= SVC(kernel = kernel, gamma="auto", degree = 1, cache_size=5000).fit(Xtrain,Ytrain)print("The accuracy under kernel %s is %f" % (kernel,clf.score(Xtest,Ytest)))print(time()-time0)

观察数据异常否

import pandas as pd

data = pd.DataFrame(X)

data.describe([0.01,0.05,0.1,0.25,0.5,0.75,0.9,0.99]).T#描述性统计

#从mean列和std列可以看出严重的量纲不统一

#从1%的数据和最小值相对比,90%的数据和最大值相对比,查看是否是正态分布或偏态分布,如果差的太多就是偏态分布,谁大方向就偏向谁

#可以发现数据大的特征存在偏态问题

#这个时候就需要对数据进行标准化

将数据标准化

from sklearn.preprocessing import StandardScaler

X = StandardScaler().fit_transform(X)#将数据转化为0,1正态分布

data = pd.DataFrame(X)

data.describe([0.01,0.05,0.1,0.25,0.5,0.75,0.9,0.99]).T#均值很接近,方差为1了

标准化完毕后,再次让SVC在核函数中遍历,此时我们把degree的数值设定为1,观察各个核函数在去量纲后的数

据上的表现:

Xtrain, Xtest, Ytrain, Ytest = train_test_split(X,y,test_size=0.3,random_state=420)Kernel = ["linear","poly","rbf","sigmoid"]for kernel in Kernel:time0 = time()clf= SVC(kernel = kernel, gamma="auto", degree = 1, cache_size=5000).fit(Xtrain,Ytrain)print("The accuracy under kernel %s is %f" % (kernel,clf.score(Xtest,Ytest)))print(time()-time0)

可以观察到,所有核函数的运算时间都大大地减少了,尤其是对于线性核来说,而多项式核函数居然变成了计算最快的。其次,rbf表现出了非常优秀的结果。经过我们的探索,我们可以得到的结论是:

- 线性核,尤其是多项式核函数在高次项时计算非常缓慢

- rbf和多项式核函数都不擅长处理量纲不统一的数据集

所以,SVM执行之前,非常推荐先进行数据的无量纲化。

取与核函数相关的参数:degree & gamma & coef0

(学习曲线)来试试看高斯径向基核函数rbf的参数gamma在乳腺癌数据集上的表现:

score = []

gamma_range = np.logspace(-10, 1, 50) #返回在对数刻度上均匀间隔的数字

for i in gamma_range:clf = SVC(kernel="rbf",gamma = i,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))print(max(score), gamma_range[score.index(max(score))])

plt.plot(gamma_range,score)

plt.show()

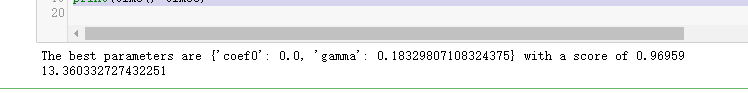

使用网格搜索来共同调整三个对多项式核函数有影响的参数

from sklearn.model_selection import StratifiedShuffleSplit#用于支持带交叉验证的网格搜索

from sklearn.model_selection import GridSearchCV#带交叉验证的网格搜索time0 = time()gamma_range = np.logspace(-10,1,20)

coef0_range = np.linspace(0,5,10)param_grid = dict(gamma = gamma_range,coef0 = coef0_range)

cv = StratifiedShuffleSplit(n_splits=5, test_size=0.3, random_state=420)#将数据分为5份,5份数据中测试集占30%

grid = GridSearchCV(SVC(kernel = "poly",degree=1,cache_size=5000,param_grid=param_grid,cv=cv)

grid.fit(X, y)print("The best parameters are %s with a score of %0.5f" % (grid.best_params_,

grid.best_score_))

print(time()-time0)

重要参数C

使用网格搜索或学习曲线来调整C的值。

#调线性核函数

score = []

C_range = np.linspace(0.01,30,50)

for i in C_range:clf = SVC(kernel="linear",C=i,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))

print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()#换rbf

score = []

C_range = np.linspace(0.01,30,50)

for i in C_range:clf = SVC(kernel="rbf",C=i,gamma = 0.012742749857031322,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()#进一步细化

score = []

C_range = np.linspace(5,7,50)

for i in C_range:clf = SVC(kernel="rbf",C=i,gamma =

0.012742749857031322,cache_size=5000).fit(Xtrain,Ytrain)score.append(clf.score(Xtest,Ytest))print(max(score), C_range[score.index(max(score))])

plt.plot(C_range,score)

plt.show()

我们找到了乳腺癌数据集上的最优解:rbf核函数下的98.24%的准确率。当然,我们还可以使用交叉验证来改进我们的模型,获得不同测试集和训练集上的交叉验证结果。

这篇关于python机器学习之支持向量机——探索核函数在不同数据集上的表现的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!