本文主要是介绍[深度学习从入门到女装]Attention U-Net: Learning Where to Look for the Pancreas,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文地址:Attention U-Net: Learning Where to Look for the Pancreas

这是一篇使用attention模块对U-Net进行改进,从而进行医学图像分割的论文

这个attention模块其实给我感觉特别像SENet里边对每个channel进行权重加权的模块,只不过这篇文章是对feature map中每个pixel进行加权,以达到突出显著特征的作用

改进后的U-Net如图所示

attention模块用在了skip connection上,原始U-Net只是单纯的把同层的下采样层的特征直接concate到上采样层中,改进后的使用attention模块对下采样层同层和上采样层上一层的特征图进行处理后再和上采样后的特征图进行concate

attention模块

F代表哪一层的channel数,通俗来看就是使用下采样层同层的特征图和上采样层上一层的特征图进行一个pixel权重图的构建,然后再把这个权重图对下采样层同层的特征图进行处理,得到进行权重加权的特征图

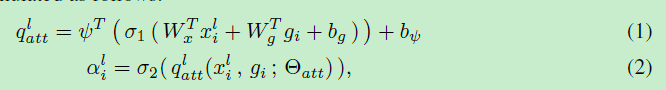

使用公式来表达就是:

下采样层同层的特征图,进行1*1*1卷积运算得到

上采样层上一层的特征图,进行1*1*1卷积运算得到

将上两步得到的特征图和

进行相加后在进行ReLu得到

(

),

为ReLU激活函数

随后在使用1*1*1卷积运算得到

最后对进行sigmoid激活函数得到最终的attention coeffficients(

)

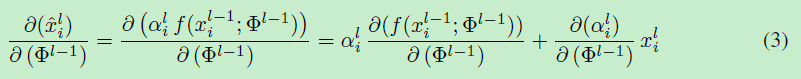

梯度传导过程如下:

这篇关于[深度学习从入门到女装]Attention U-Net: Learning Where to Look for the Pancreas的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!