本文主要是介绍5.4.0Spark和Hive集成(Derby),希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Spark和Hive集成(Derby)

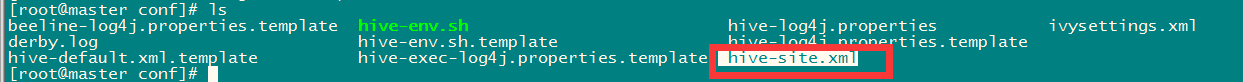

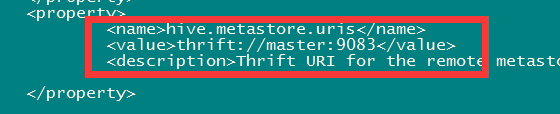

一、 更改Hive安装目录conf下的hive-site.xml文件

<property><name>hive.metastore.uris</name><value>thrift://master:9083</value><description>Thrift URI for theremote metastore. Used by metastore client to connect to remotemetastore.</description>

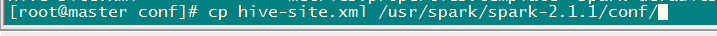

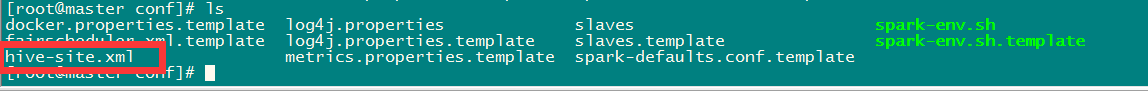

</property>二、 将hive-site.xml文件拷贝到spark安装目录conf下

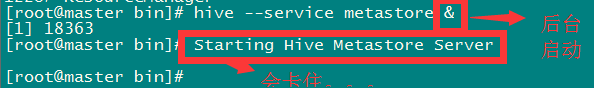

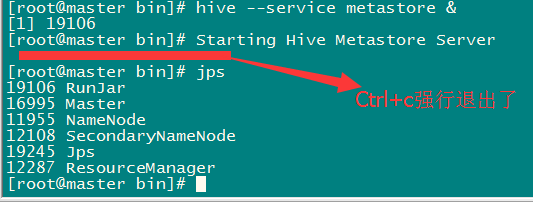

cp hive-site.xml/usr/spark/spark-2.1.1/conf/三、 启动元数据

启动会卡住。不知道什么原因。。。不过不影响整合。

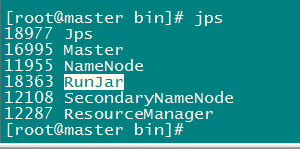

四、 查看进程

有一个RunJar

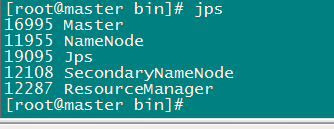

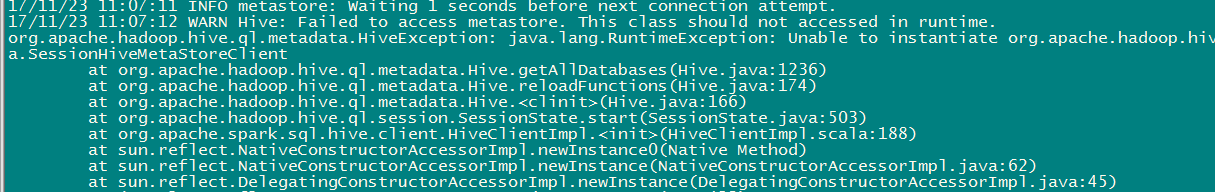

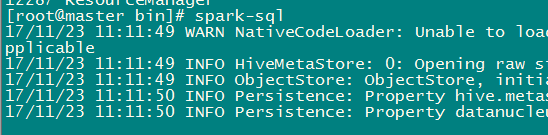

五、 如果没有启动元数据启动spark-sql会报错

六、 在hive安装目录的bin目录下启动spark-sql测试

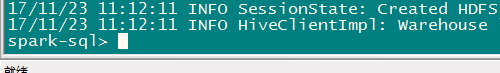

启动成功:

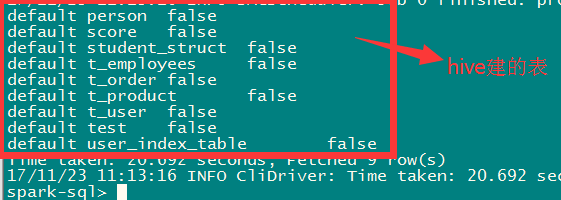

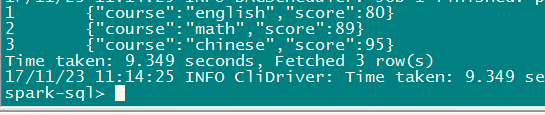

七、 测试查询

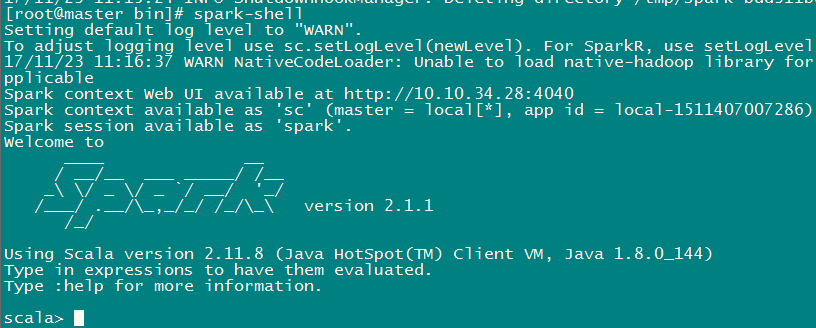

show tables;select * from test;八、 启动spark-shell

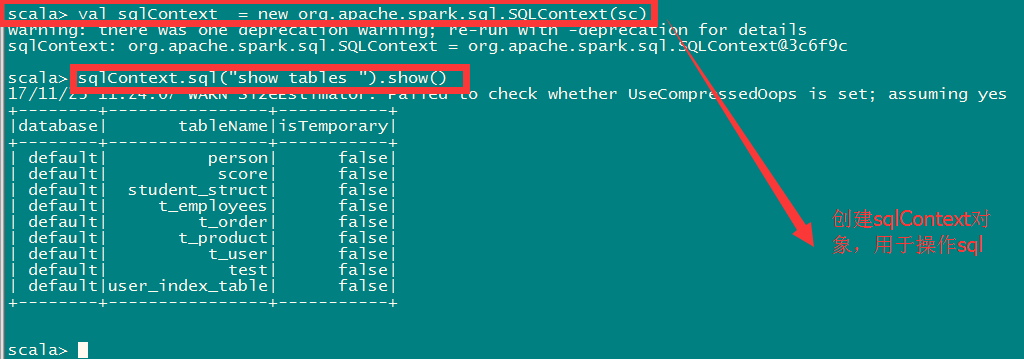

九、 使用spark-shell查询

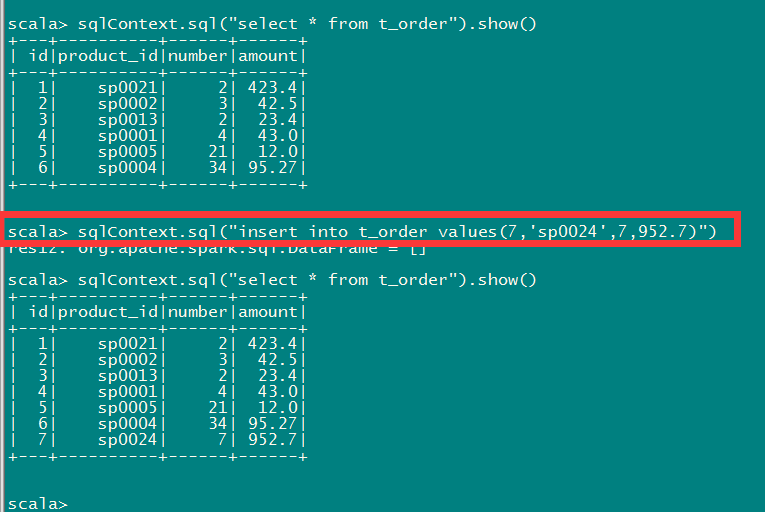

1. 增加数据

更新操作,hive默认只支持INSERT,不支持UPDATE DELETE

这篇关于5.4.0Spark和Hive集成(Derby)的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!