本文主要是介绍OpenAI承认ChatGPT变懒惰,正在修复该问题,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

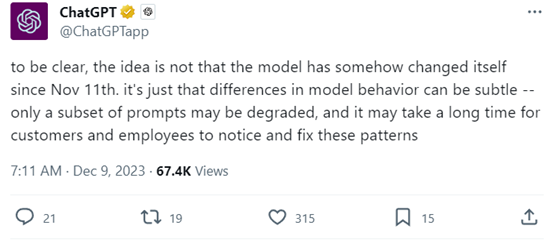

OpenAI旗下的官方ChatGPT账号在社交平台表示,已经收到了大量用户关于GPT-4变懒惰的反馈。

这是因为自11月11日以来,OpenAI就没有更新过该模型。当然这不是故意的,大模型的行为是不可预测的,正在研究修复该问题。

外界猜测,OpenAI可能是为了节省算力资源以及减少非法内容的输出,限制了GPT-4的部分功能。

GPT-4变懒惰的报道

该账号进一步指出,GPT-4并不是从11 月 11 日开始懒惰的,很可能已经持续了很长一段时间。模型的部分功被降级,日常使用很难觉察到。

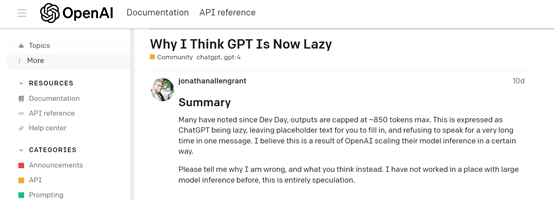

事实上,在OpenAI的官方开发者论坛中,已经有不少用户抱怨GPT-4变懒惰的问题。

一位名叫Jonathan的用户表示,自OpenAI的开发者大会之后,ChatGPT的输出上限是850个tokens,表现的非常懒惰。

在回答内容的时候,经常会空出一些占位符文本让用户自己来回答,并且在一条消息中很长时间拒绝回答内容。

关于ChatGPT的懒惰行为,Jonathan从技术层面进行了猜测:1)这种带空位符的回复模式,OpenAI可能正在测试新的推理方法。

2)OpenAI 正在托管许多不同上下文大小的模型,不想在一些没用且无聊的问题上浪费AI算力。

3)OpenAI内部的主网络在不同语境的 GPT4 中是相同的,这导致他们有了 gpt-4-4k、gpt-4-8k、gpt-4-16k......gpt-4-120k 等模型,所有这些模型都共享相同的 RLHF核心(人类反馈强化学习)和其他的私密数据。

4)在完成调用之前,每个模型会对每个输入进行850-1024个推理步骤。这使得 OpenAI 可以一次性更新模型的批次,而不是在调用发生时按需更新。

这种模式可以节省从 CPU 到 GPU再到CPU的运行时间。

5)为了在 850-1024 个推理步骤内正确地向用户返回简明扼要的内容,OpenAI额外训练了一个RLHF核心网络,以便在简单问题时进行调用,以减少模型遍历节省算力资源。

总体来说,Jonathan的核心猜测就是,OpenAI主要是为了节省庞大的算力支出,才使得ChatGPT变得越来越懒惰。

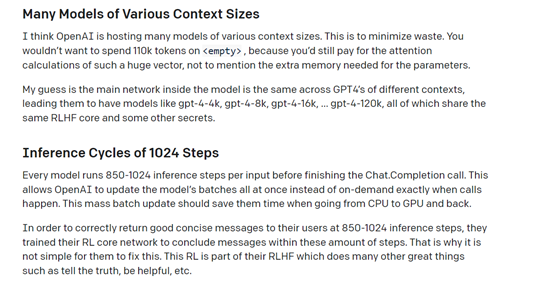

一位名叫Matt用户在社交平台分享了ChatGPT变懒的证据,同时也验证了Jonathan在技术层面的猜测。

ChatGPT在回答问题时,只会回答部分内容,剩下的留给用户自己来想。

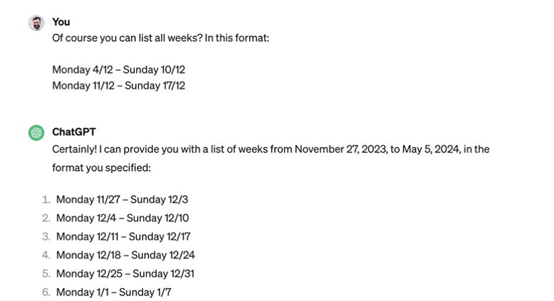

例如,向ChatGPT提问,列出从现在到 2024 年 5 月 5 日的所有周末。

ChatGPT回答:我可以为你提供从现在到 2024 年 5 月 5 日之间的周数,但我无法为每一周列出详尽的清单。不过,我可以给你一个粗略的估计。

假设当前日期是 2023 年 11 月 27 日。从现在到 2024 年 5 月 5 日,大约有 24 周。

如果您需要更精确的计算,可以使用日期计算器或编程工具来计算两个特定日期之间的周数。

用户:你当然可以列出所有的星期?用这种格式:周一 4/12 - 周日 10/12 周一 11/12 - 周日 17/12。

ChatGPT:当然我可以按照你指定的格式展示日期,提供2023年11月27日至2024年5月5日的周数列表。然后加上详细的日期。

也就是说,需要“哄着”ChatGPT才能让它回答更具体的内容。只用模糊的问题,让其回答海量内容已经不太可能了,这个问题在编程领域也比较明显。

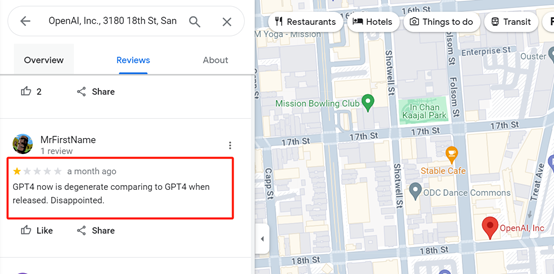

此外,在谷歌的APP商店中,最近ChatGPT也收到了不少1星的评分。就连OpenAI在谷歌地图的公司地址,也有人打一颗星,原因就是因为ChatGPT变懒惰了,可见此次情况的严重性。

本文素材来源ChatGPT社交平台、OpenAI开发论坛、网络,如有侵权请联系删除

这篇关于OpenAI承认ChatGPT变懒惰,正在修复该问题的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!