本文主要是介绍【深度学习技巧】超参数寻找--最合适的学习速率,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文名称:Cyclical Learning Rates for Training Neural Networks

论文地址:https://arxiv.org/abs/1506.01186

简介:这篇论文主要描述了一种调整深度学习中的学习速率的策略,并提出了CLR(看论文标题)方法来动态的调整学习速率,介绍如何找到动态学习速率的上下界,加速网络模型的训练和收敛;

论文精华

关键信息提取

1.论文使用了ResNets,Stochastic Depth networks,DenseNets在cifar-10和cifar-100数据集验证;还使用了AlexNet,GoogLeNet在ImageNet数据集验证;

2.论文主要论证了变化的学习速率在训练期间是很有用的,因此提议使用周期性的变化学习速率代替固定速率;

3.使用CLR(Cyclical Learning Rate)方法的收益和其他方法对比图见下图(在底部论文附图中Figure1)

4.提及了论文发表的时候,一大堆自适应学习速率优化方法的出现,但都有不足,最后说了下自己的CLR方法更像SGDR方法,并且计算比自适应学习速率的性能消耗低;

5.CLR本质是观察,增加学习速率也许带来的短周期负面效果和长周期的正面效果;这种观察导致无须做范围性的学习速率改变,也好于采用逐步固定或者指数减少方法;

6.论文使用了三角学习策略,设定了最大值和最小值,并在其中对学习速率进行循环改变;

7.Figure1中的红色曲线时cifar10的训练曲线,设置了最小0.001,最大0.006的学习速率;

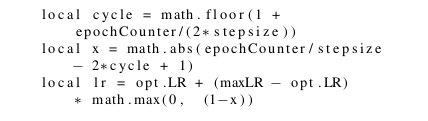

8.给出了计算公式,见Figure3.

9.介绍了其他论文讨论的三角法策略:

a)triangular2 ,和三角策略相似,但每一个循环结束后,最大学习速率都会变为原来的一半;

b)exp_range ,学习速率有最大最小边界,边界值乘上一个指数衰减因子;

10.一个很重要的问题,如何估计一个不错的循环长度值呢?

答案:已知的,一个cicle = 2个stepsize的长度(三角一上一下),循环长度和stepsize可以很轻松的从一个批次的迭代次数中计算出来,eg:cifar10有50000张训练图片,batchsize是100,那么迭代一次的数量为iter = 50000 / 100 = 500,实验经验表明,将stepsize设置为iter的2 - 10倍那么准确率就会非常稳定,举个例子设置stepsize = 8 * epoch比设置stepsize = 2 * epoch会好一点;

11.另一个很重要的问题,如何估计合理的最大最小边界值?

答案:LR range Test(效果看Figure4),意思为先跑几个批次,使得学习速率从低到高线性增加.具体的则举例如何使用Caffe来完成三角策略测量范围,设置base_lr为最小值,设置max_lr的最大值,设置max_iter和stepsize为同样的迭代值,运行后学习速率就会在最小界限到最大界限的过程线性增加,接下来,测量准确率并选择学习速率,关注学习速率开始增加,缓慢,抖动,甚至变得相反的过程,选出起始增加和结束增加的两点值来作为base_lr和max_lr. Figure4.中显示了结果,合理的选择了收敛的起点,使得base_lr=0.001,并选择了max_lr为0.006,因为这一点准确率开始下降了.

12.文章提到了使用固定的学习速率,准确率低于使用CLR方法;

13.表示CLR搭配自适应学习优化器可以用更少的迭代更快获得较高的准确率(但我看论文中,准确率会比仅使用自适应优化器会低一些,个人感觉CLR更适合非自适应的优化器),作者还验证了几种自适应优化器搭配CLR,其中Nesterov+CLR的组合要好与Adam+CLR和仅使用Adam;

论文附图

Figure1.上图展现了对比CLR方法和其他方法的效果,这是在cifar-10上的表现,其他方法多是在70000次迭代之后才达到81%的正确率,而CLR方法25000次迭代就到了相同的正确率效果;

上图展现了三角学习速率策略;

Figure3.三角学习策略公式(opt.LR指代了最低学习速率,epoch_Counter是训练批次计数(实际上是epoch中的iter),lr是最后计算的学习速率,stepsize为一次批次训练的迭代数或者时迭代数的一半(后面论文建议使用迭代数的两倍或者十倍,效果更好),maxLR是最大学习速率,计算结果就是在maxLR和opt.LR中间变动;

Figure4.Classification accuracy as a function of increasing learning rate for 8 epochs (LR range test).

代码实现:

实现了论文提到的三角策略triangular policy,以及三角策略的两个变种:triangular2 policy和 exp_range policy:

def produce_lr():stepsize = 1000baselr = 0.001maxlr = 0.006maxlr_2 = 0.006maxlr_exp = 0.006gamma = 0.9998lr_trend_triangular = list()lr_trend_triangular2 = list()lr_trend_exp_range = list()#triangularfor iter in range(1, 10000):lr = clr(iter,stepsize,baselr,maxlr)lr_trend_triangular.append(lr)#triangular2for iter in range(1, 10000):if iter % 2000 == 0:maxlr_2 = (maxlr_2 + baselr) /2.lr = clr(iter,stepsize,baselr,maxlr_2)lr_trend_triangular2.append(lr)#exp_rangefor iter in range(1, 10000):lr = clr(iter,stepsize,baselr,maxlr_exp)lr_trend_exp_range.append(lr)maxlr_exp *= gammaplt.figure(1)plt.plot(lr_trend_triangular)plt.figure(2)plt.plot(lr_trend_triangular2)plt.figure(3)plt.plot(lr_trend_exp_range)

学习速率的变化图分别如下:

triangular policy:

triangular2 policy:

exp_range policy:

结果:

目前为止,个人使用过triangular policy方法进行训练,对论文提到的效果进行了验证,结果较为满意,虽然我无法确定训练批次一定会有效减少,但至少可以相信,此种策略,可以有效的减少深度学习训练过程中,出现局部滞留的可能性,这种三角策略的学习速率调整法,有点像优化器中的momentum,带冲量,可理解为上升趋势为带冲量;

同时发现此种方法的一些瑕疵,将训练过程分为前中后三个时期,此种方法在中后期时,表现不稳定,因为升到较大的学习速率时,会导致误差增大,因此也就解释了论文中误差曲线比起其他传统方法,多次出现三角坡度的原因;当训练进行到后期的时候,需要更小的学习速率进行模型调整, 那么也就同时符合了论文提到的其他两种变种triangular2和exp_range,从论文最后的验证来看,exp_range应该是当训练网络较深的时候,更加适合的调整学习速率的方法;

同时参考了一位同仁的博客:

【1】https://blog.csdn.net/weixin_43896398/article/details/84762886#commentBox

这篇关于【深度学习技巧】超参数寻找--最合适的学习速率的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!