本文主要是介绍产品解读 | 数据服务平台:KDP,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

一、KDP 是什么?

KDP 是一款面向 AIoT 场景的数据服务平台——以一体多模的大数据基础平台作为基座,提供 OLTP、OLAP、HTAP、时序、图、全文检索、宽表等多种数据存储和计算服务;此外,还提供上层数据集成、数据开发、数据治理、数据共享、数据可视化、智能 BI等功能,致力于满足企事业单位数据湖、数据仓库等多样需求,助力企业激活数据价值,赋能上层应用建设,打造行业知识中心,提供知识构建能力,支撑行业资产构建。

二、KDP 核心理念

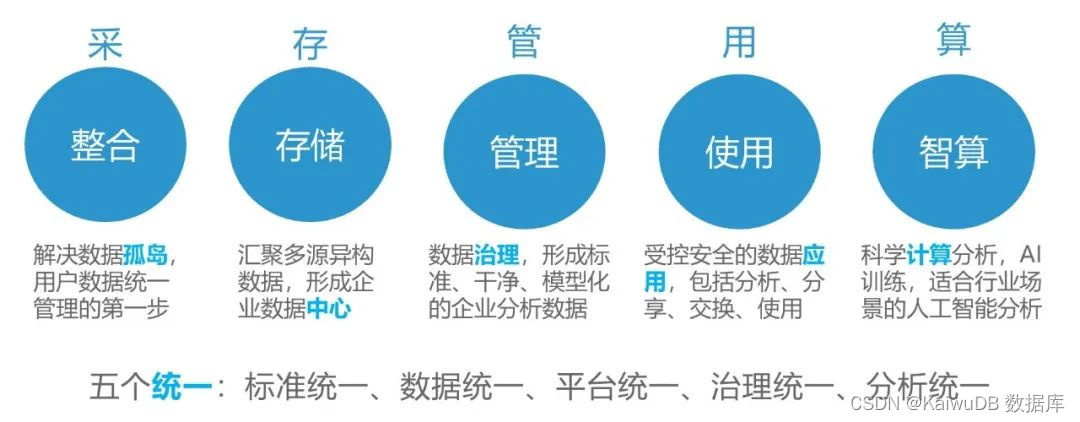

伴随企业信息化建设的不断发展,数据也呈现多元化演变趋势,数据分析和决策逐渐成为企业数据管理的重点。然而,由于早期信息系统建设缺乏统一业务规划,伴随着业务的持续,信息标准不统一、数据冗余、数据孤岛分享难、数据录入质量低、数据价值难挖掘等瓶颈问题已日益凸显。

随着政策对现代企业数字化建设的要求和规范,以及当前大数据背景下对于数据私密性和安全性的要求,如何建立数据采集、清洗、治理、存储、管理、共享、使用等充分闭环的数据生态,保证数据处理能力与管理水平成为关键问题。

KDP 提供数据采集、数据集成、数据治理、数据科学、数据服务、数据可视化于一体的“一站式”数据服务。以“数据”为主线,从各个业务异构数据源为出发点,实现数据迁移、数据清洗、数据采集、数据治理等目标,构建以规范、引导、流程化为特色的“数据资源管理中心”,并在新一轮的技术发展下,更新数据底层架构,确保管理好数据的同时为用户提供高效稳定的大数据能力,同时对数据前端应用做好集成、计算,改变传统分散零碎的方式提供数据化服务,帮助用户充分聚焦数据价值。

三、KaiwuDB 核心功能

#1 通用数据集成、支持物联网数据采集分析

-

多源异构数据集成,支持多种异构数据源连接;

-

兼容多种通信协议,例如:MQTT、Modbus、CoAP、HTTP、RS-232、RS-485 等,支持设备直连及订阅方式采集数据;支持用户自定义协议;

#2 湖仓一体的数据底座

-

多模存储大数据底座,高效能低延迟的实时湖仓;

#3 数据治理:数据资产管理、分析、运营、安全

-

数据治理,全链路数据监控,形成高质量数据资产;

-

权限、加密、分级分类等手段保障数据安全性;

#4 基于数据支撑的科学计算

-

功能强大且高效易用的数据科学平台,具备交互式算法与模型开发、训练及管理能力;

#5 数据可视化

-

自助式探索型分析、电子表格、驾驶舱大屏,将经验变为数据;

#6 架构灵活,信创适配,实施经验

-

云边端协同,高扩展性;

-

全面支持国产 CPU 芯片和国产操作系统;

-

内置行业标准体系、算法、模型、知识库等,快速构建数据生态。

四、写在最后

为能够更好地挖掘“沉睡”中海量数据的深层价值,降低单位数据存储成本,KaiwuDB 推出“组合拳”打法 —“KaiwuDB+KDP(数据服务平台)组合解决方案”。

KDP 提供了广泛的设备采集协议兼容性,并通过简单的页面配置,将各类设备数据导入 KaiwuDB,帮助企业构建全面的数据资产库。此方案基于就地计算和流式计算等核心技术,支持多层级、多维度数据的深入分析,能够实时统计和分析物联网设备产生的大量数据。这为管理层提供了科学的决策依据,帮助企业优化生产流程,提高生产效率,最终实现成本降低和效益增加。

“KaiwuDB+KDP(数据服务平台)组合解决方案”以 KaiwuDB 分布式数据库体系为依托,以 KDP 强大数据分析算力实现释放数据价值最大化,支撑上层 SaaS 应用开发平台建设,更加智能化地分析决策,有效推动业务稳步前进。

从中国制造新基建到十四五规划政策主基调,数字化转型已成为我国重要的发展战略,面对持续的数字化和智能化产生诸多的数据管理和分析需求,KaiwuDB 始终坚持探索如何更好地挖掘并释放数据中的新价值。

未来,KaiwuDB 将力争覆盖不同业务场景下数据从采集、处理、计算、分析到应用的全生命周期业务需求,盘活数据资产,真正做到“让数据会说话”,更好地实现数据智能以及产业价值的提升。

这篇关于产品解读 | 数据服务平台:KDP的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!