本文主要是介绍Deep Learning 最优化方法之AdaGrad,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

本文是Deep Learning 之 最优化方法系列文章的AdaGrad方法。主要参考Deep Learning 一书。

整个优化系列文章列表:

Deep Learning 之 最优化方法

Deep Learning 最优化方法之SGD

Deep Learning 最优化方法之Momentum(动量)

Deep Learning 最优化方法之Nesterov(牛顿动量)

Deep Learning 最优化方法之AdaGrad

Deep Learning 最优化方法之RMSProp

Deep Learning 最优化方法之Adam

先上结论:

1.简单来讲,设置全局学习率之后,每次通过,全局学习率逐参数的除以历史梯度平方和的平方根,使得每个参数的学习率不同2.效果是:在参数空间更为平缓的方向,会取得更大的进步(因为平缓,所以历史梯度平方和较小,对应学习下降的幅度较小)3.缺点是,使得学习率过早,过量的减少4.在某些模型上效果不错。

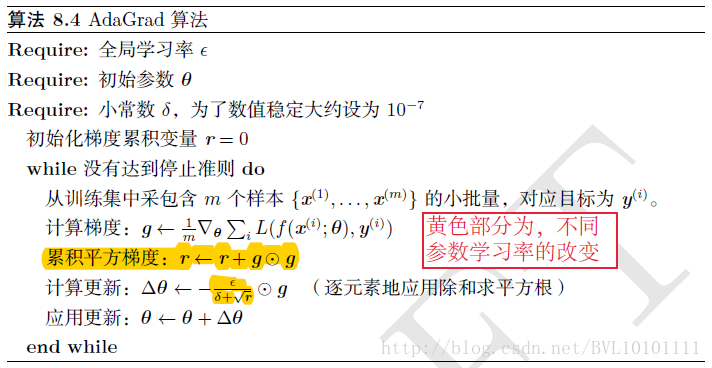

具体见算法:

这篇关于Deep Learning 最优化方法之AdaGrad的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!