本文主要是介绍Resilient Backpropagation,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Resilient Propagation (RPROP, 弹性传播) 对不同的问题都能用同一套参数, 而且收敛速度比 Backpropagation 快. 它对权重的修改不是正比于梯度 , 而是由梯度和上一轮梯度的符号决定, 如果两轮梯度符号相同, 修改值就乘以 1.2 (弹性加速), 如果两轮梯度符号相反, 修改值就乘以 -0.5 (弹性减速). Manhattan 相似于 RPROP 但弱一点可以忽略.

由于弹性传播需要多个 example 才能训练, 所以它算一种 Batch Training 算法.

作者:luikore

链接:https://www.zhihu.com/question/41521461/answer/95642943

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

这篇关于Resilient Backpropagation的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!

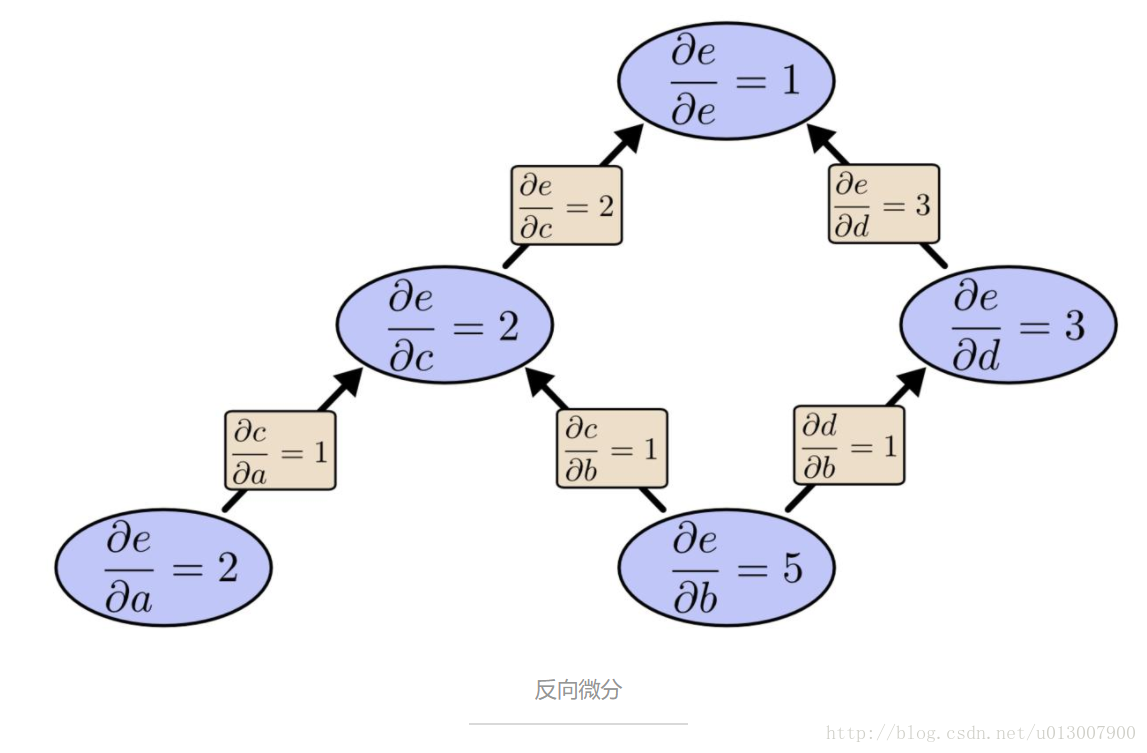

![[机器学习入门] 李宏毅机器学习笔记-8(Backpropagation;反向传播算法)](https://img-blog.csdn.net/20170605235847174?watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvc291bG1lZXRsaWFuZw==/font/5a6L5L2T/fontsize/400/fill/I0JBQkFCMA==/dissolve/70/gravity/SouthEast)