本文主要是介绍激励机制相关论文的阅读,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

论文题目:An Incentive Mechanism of Incorporating Supervision Game for Federated Learning in Autonomous Driving(基于监督博弈的自动驾驶联邦学习激励机制)【使用仿真】

期刊:IEEE Transactions on Intelligent Transportation Systems

作者:Yuchuan Fu, Changle Li, F. Richard Yu, Tom H. Luan, Pincan Zhao

时间:2023

解决问题:(对于FL来说)确保知识的安全性,处理参与者的懒惰行为以及实施更为有效的激励

如何解决:

- 首先提出了一种分层的区块链支持的FL架构,该架构利用区块链的不可变和透明特性,实现知识和交易信息的安全存储和共享,并具有可扩展性。(也就是FLchain)

- 然后,在综合评价模型质量和参与者声誉的基础上,提出了一种与监督博弈相结合的激励机制,以吸引高质量的参与者。(考虑到FL过程中参与者的成本和惰性)

- 激励机制在FL中得到了广泛的研究,主要基于博弈论,拍卖理论,合同理论和匹配理论。博弈论可以模拟不同参与者的互动决策。

创新点:

- 处理参与者的懒惰行为,并实施有效的激励。

- 在克服中心服务器故障问题的同时,提高了系统的可信度和可扩展性。

- 研究并建立了自动驾驶中FL的监督博弈模型,推导出了有激励和无激励的纳什均衡。

- 考虑到用户本地训练模型的私密性、数据感知和计算的成本以及参与者的惰性,我们提出了一种结合监督博弈的激励机制。考虑了当地模式的质量和声誉来设计激励机制。

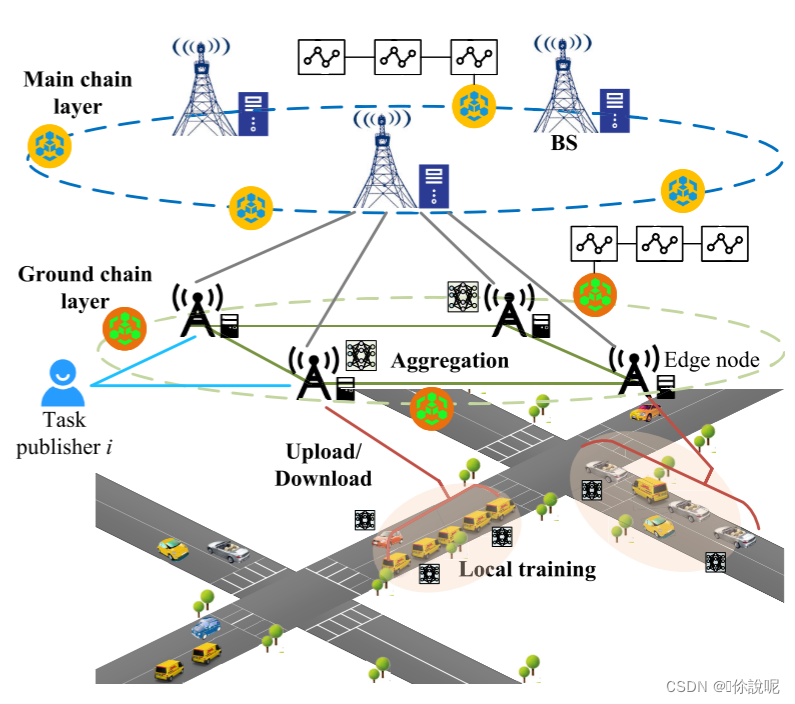

联邦学习架构

具体而言,该架构包含区块链两层,即主链层和地链层,主要用于解决单个区块链系统资源有限的问题,实现存储隔离和隐私保护

- 每个任务发布者(TP)将机器学习任务(例如,对象识别、自动驾驶)到附近的边缘节点。然后,边缘节点将学习任务广播到适当的CAV。

- 具有合适数据和计算能力的合法CAV可以加入学习任务,并使用自己收集的数据作为FL训练集来训练局部模型。每轮局部模型更新被发送到附近的边缘节点。

- 在地链层,可以通过预先选择的边缘节点建立联盟链,记录参与者上传的本地更新、奖励交易和参与者的信誉。在模型满足TP的精度要求之前,边缘节点将聚合的全局模型返回给TP。然后,任务发布者将根据参与者的贡献分配相应的奖励。同时,任务发布者评估参与者的模型质量和训练行为,更新信誉值,并将其存储在地面链中。

- 在每次迭代之后,参与者的信誉被记录为上传到区块链的交易。用于存储参与者信誉的区块链在不同的TP之间共享,以选择可靠的参与者进行FL任务。

- 考虑到边缘节点的位置和通信范围以及不同的功能,在地链层中可能存在多个子链。因此,为了有效监控子链的行为,避免单个区块链的资源有限,所有子链都应该在一段时间后锚定到主链上。

激励机制

我们认为参与者CAV n在FL过程中连续两次不受TP监督,可以享受TP给予的额外激励。为了控制成本,激励部分应小于参与FL的原始奖励。一般来说,FL参与者上传的本地模型的质量会影响全局模型的性能。此外,参与者的声誉也会影响参与者的行为和所提供数据的质量。高声誉的参与者更有可能高质量地完成FL任务。

首先,参与者的信誉值与他们为参与FL任务而上传的本地模型的质量有关,包括由当前和过去完成的FL任务上传的模型。其次,当参与者不断提供高质量的本地模型时,声誉值的增长率会逐渐降低。相反,声誉值的下降会增加,这可以鼓励参与者尽量不提供低质量的模型。因此,Sigmoid函数可以用来构建参与者信誉更新模型。

本文利用每轮上传的局部模型ln与该CAV参与FL时对应的全局模型g之间的相似度来反映模型质量,这种相似度可以用余弦相似度算法来计算。

在重复博弈后,参与者懒惰的概率接近0。根据福克定理,在重复博弈中,在满足局中人理性约束的前提下,纳什均衡状态可以维持。因此,在本文中,由于激励机制的作用,CAV参与FL的懒惰概率将逐渐降低,直到接近0,从而实现TP和参与者之间的合作。

论文题目:A Game Theory-Based Incentive Mechanism for Collaborative Security of Federated Learning in Energy Blockchain Environment(基于博弈论的能源区块链环境下联邦学习协同安全激励机制)

期刊:IEEE Internet of Things Journal

作者:Yunhua He, Mingshun Luo, Bin Wu, Limin Sun, Yongdong Wu

时间:2023

解决问题:传统的FL依赖于中央服务器,参与方并不完全可信。在能源区块链环境下,FL还面临能源部门发起的数据中毒攻击,此外,进行检查模型的监管委员会可以发起欺骗性攻击。

如何解决:本文提出了一种基于博弈论的能量区块链环境下FL协同安全激励机制,该机制能够有效地阻止节点在FL迭代训练中采取恶意行为。

- 首先,我们提出了一种能源区块链环境下的FL模型,该模型能够保护隐私,实现协同安全。

- 考虑到博弈论可以用来分析参与者的策略,我们构建了一个以能源部门和监事会为参与者的博弈模型,设计了基于博弈论的激励机制,并通过智能合约的方式实现。

创新点:

- 提出了一种能源区块链环境下的协同安全FL模型,能源部门和监管委员会参与其中,其中区块链记录上传模型以防止恶意节点拒绝,并使用部署的智能合同来保护FL迭代中的协同安全。

- 提出了一种基于博弈论的能源区块链环境下FL协同安全激励机制,即使模型检测算法的准确率较低,也能在迭代训练中阻止节点采取恶意行为。证明了其激励机制可以将博弈模型引向一个实现多方协同安全的网元。

我们认为博弈论可以用来分析FL中各个节点的策略及其相互作用,通过博弈分析,参与者可以学习和预测彼此的行为,然后基于纳什均衡(NE)分析制定最优响应策略。为此,我们提出并部署了一种基于博弈论的能源区块链环境下的FL激励机制,以实现能源部门与监管委员会之间的协同安全。从能源主管部门和监管委员会的角度,构建了一个博弈模型:在一次FL迭代中,能源部门是否发起中毒攻击,监管委员会是否发起欺骗攻击。我们还设计了一个激励机制,导致游戏模型的NE,实现协同安全。

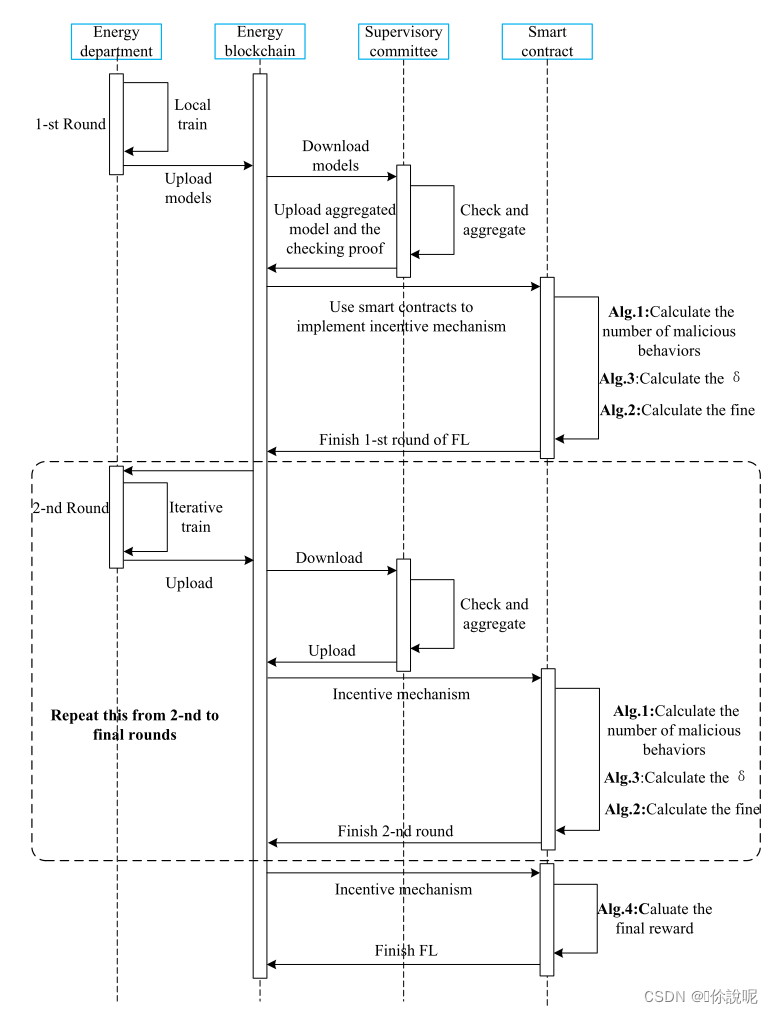

能源区块链中的FL模型

- 能源区块链:能源区块链以联合体区块链作为任务发布者、能源部门和监事会之间交互的底层技术。此外,区块链通过部署智能合约来实施激励机制,减少节点的恶意行为。

- 任务发布者:任务发布者负责模型的初始化,下载最终的聚合模型。

- 能源部:能源部负责使用本地能源数据和加密模型的迭代训练模型。

- 监管委员会:监管委员会负责检查模型、聚合模型、协同解密模型。

联盟区块链的预授权节点和范围内共识可以降低恶意节点出现的可能性[33],委员会机制可以降低模型在FL中聚合时的中心化风险。此外,上传模型采用同态加密算法保证梯度的隐私性,并通过智能合约实现激励机制,阻止能源部门和监管委员会采取恶意行为,实现FL的协同安全。这里使用的同态加密算法是CKKS算法。我们选择CKKS,因为部分同态加密不满足在梯度聚合期间同时执行加法和乘法运算的要求。全同态加密中的其他方案不满足用十进制数计算的要求,并且环面上的全同态加密目前招致显著的开销。CKKS算法允许在全同态加密下进行浮点计算,这与FL在能源区块链环境中的计算要求相一致。

具体来说,我们提出的能源区块链环境下的FL流程如下:

1)任务发布者发布训练任务,并将初始模型发送到能源区块链;

2)参加培训的能源部门ei从区块链下载初始模型;

3)能源部门ei使用本地能源隐私数据来训练模型;

4)能源部门ei使用同态加密算法对训练后的模型进行加密,并上传到区块链,然后将训练成本ri,n发送到智能合约;

5)监事会cj从区块链下载加密模型;

6)监督委员会cj对模型进行校验,并将相关可验证的校验证明上传到区块链,然后将校验成本sj,n发送给智能合约;

7)监事会集合模型;

8)监事会协同解密聚合模型;

9)监督委员会将更新后的模型上传到区块链;

10)部署在能源区块链上的智能合约实现激励机制,包括计算每个节点采取的恶意行为数量,计算每个节点的利润和罚款等;

11)重复2-10,直到模型损失函数收敛,任务发布者从区块链下载最终的训练模型。

激励机制

在FL中,能源部门和监管委员会共同努力,根据所采取的措施,他们不仅影响自己的利益,而且还影响FL中其他参与者的利益。为此,我们建立了一个以能源主管部门和监管部门为博弈方的博弈模型。设FL中的总轮数为N,并且n ∈ 1,2,3,.,N.能量部门的集合为E,当ei ∈ E在第n轮迭代中选择策略αi,n = 1时,ei将正常训练模型,当策略αi,n = 0时,它将发起数据中毒攻击。还考虑监督委员会的集合为C,当cj ∈ C选择策略βj,n = 1时,cj ∈ C将检验模型,当选择策略βj,n = 0时,cj ∈ C将发起欺骗攻击。然后定义了能源部门ei和监管委员会cj在第n次迭代中的收益。

在我们的能量区块链FL模型中,智能合约在每一轮中都会使用Alg.1来记录θi的次数,这是ei被检出发起数据中毒攻击的次数,µj的次数,这是cj被检出发起欺骗攻击的次数,以及训练轮的总数T。FL共有k1能源部门和k2监督委员会参与。如Alg.1所示。当能源区块链开始FL时,监督委员会将检查区块链上所有上传的模型。如果检测到数据中毒攻击,ei的恶意行为数量将增加1(第2行-第8行)。智能合约还检查区块链上的可验证的校验证明,如果发现cj没有校验模型,则cj的恶意行为计数µj增加1(第10行-第16行)。同时,智能合约将根据上传的聚合模型确定并记录迭代次数(第18行-第23行)。

论文题目:Incentive Mechanism Design for Joint Resource Allocation in Blockchain-based Federated Learning(基于区块链的联邦学习中联合资源分配的激励机制设计)

期刊:arXiv:2202.10938v1 [cs.CR]

作者:Zhilin Wang, Qin Hu, Ruinian Li, Minghui Xu, and Zehui Xiong

时间:2022 Feb 18

解决问题:由于每个客户的计算资源有限,因此需要仔细解决将计算资源分配给培训和挖掘的问题。

如何解决:

- 在本文中,我们设计了一种激励机制,为每个客户分配适当的训练和挖掘报酬,然后客户将根据这些报酬使用两阶段Stackelberg博弈来确定分配给每个子任务的计算量。

- 在分析了模型所有者(MO)(即BCFL任务发布者)和客户的效用之后,我们将博弈模型转化为两个优化问题,依次求解这两个优化问题,得到了MO和客户的最优策略。

- 此外,考虑到每个客户的局部训练相关信息可能不为他人所知的事实,我们将博弈模型扩展为不完全信息场景的解析解。

创新点:

- 将BCFL资源分配问题建模为两阶段Stackelberg博弈,以帮助MO决定为每个客户端分配多少奖励用于训练和挖掘,并帮助客户端确定每个子任务中相应的计算能力,通过最大化其各自的效用。·

- 为了保持整个BCFL系统的稳定性和可持续性,我们设计了一个公平的奖励分配方案,根据客户在培训过程中的贡献来计算奖励。

- 考虑到实际应用场景中设备的训练相关信息可能不为他人所知,进一步研究了不完全信息情况下的资源分配机制,并推导出相应的最优解。·

论文题目:FAIR-BFL: Flexible and Incentive Redesign for Blockchain-based Federated Learning(FAIR-BFL:基于区块链的联邦学习的灵活和激励的重新设计)

期刊:Proceedings of the 51st International Conference on Parallel Processing

作者:Rongxin Xu, Shiva Raj Pokhrel, Qiujun Lan, Gang Li

时间:2022

解决问题:普通的基于区块链的联邦学习(BFL)的一个问题是它的功能不能以动态的方式满足采用者的需求。此外,普通的基于区块链的联邦学习(BFL)依赖于无法验证的客户端自我报告的贡献,如数据大小,因为出于隐私考虑,FL不允许检查客户端的原始数据。

如何解决:设计和评估了一种新的BFL框架,并解决了普通的BFL中发现的挑战,具有更大的灵活性和激励机制,称为FAIR-BFL。将普通BFL向灵活性和有效激励转变的过程中,还存在三个挑战。

- 紧密耦合区块链和FL

- 定义块的数据范围

- 基于贡献的激励

创新点:

- FAIR-BFL通过模块化设计提供了前所未有的灵活性,允许采用者以动态的方式根据业务需求调整其功能。

- 考虑了BFL量化每个客户对全球学习过程的贡献的能力。这种量化为在联合客户端之间分配奖励提供了一个合理的度量,并有助于发现可能毒害全局模型的恶意参与者。

论文题目:A Comprehensive Survey of Incentive Mechanism for Federated Learning(联邦学习激励机制综述)

期刊:arXiv:2106.15406v1 [cs.LG]

作者:Rongfei Zeng, Chao Zeng, Xingwei Wang, Bo Li, and Xiaowen Chu

时间:27 Jun 2021

解决问题:在学习过程中如果没有足够的训练数据和其他资源,性能将恶化。因此,激励更多的参与者通过支付联邦学习来贡献他们宝贵的资源是至关重要的。

如何解决:

- 激励机制在近两年引起了人们极大的兴趣,一些令人印象深刻的研究如雨后春笋般涌现。在这些结果中,詹发表了一项关于FL激励机制的代表性调查,他们将现有研究归纳为三类,即:客户的贡献、声誉和资源分配。

- 与此相比,本文对激励机制进行了另一种审视,其独特的理解、全面的分类、创新的总结视角以及对未来研究的不同见解。具体来说,我们确定了联邦学习中的激励问题,然后为各种方案提供了一个分类。随后,从主要技术角度对现有的激励机制进行了总结,如Stackelberg博弈、拍卖、契约理论、Shapley值、强化学习、区块链等。

这两项相辅相成的调查为感兴趣的读者提供了一个系统和全面的总结。

创新点:提出了一个全面的调查联邦成员学习的激励计划,确定了联邦学习中的激励问题,为各种方案提供了一个分类,从主要技术角度对现有的激励机制进行了总结。

以往的激励方案大多以激励相容性(IC)、个体理性(IR)、公平性、帕累托效率(PE)、抗合谋性(CR)和预算平衡(BB)为目标,这些也是FL中激励机制的重点。

- 激励相容性(IC):当所有参与者都如实地申报他们的贡献和成本类型是最优的时,激励机制具有IC的性质。换句话说,报告伪造信息不会使恶意玩家的收入受益。

- 个体理性(IR):只有当所有参与者都有非负利润时,激励机制才具有IR属性,即,πi ≥ 0,对i.IR表明,当FL的报酬低于其成本时,候选人会犹豫是否加入FL。

- 公平性:一些预定义的公平性函数,如贡献公平性、遗憾分配公平性和期望公平性,被最大化,然后激励机制实现公平的属性。公平是FL可持续合作的关键。·

- 帕累托效率(PE):当社会剩余(也称为社会福利)最大化时,激励机制具有PE属性,它评估联邦学习的整体利润。

- 抗共谋(CR):一个激励机制具有CR性质,如果没有一个参与者的子组可以通过合谋进行欺诈活动获得更高的利润。

- 预算余额(BB):一个方案是BB当且仅当参与者的支付总额不超过模型所有者或全局服务器给出的预算。

- 在FL中,我们认为,激励机制应该有额外的要求,绩效改善(PI),这一特定要求源于高质量参与者在FL中的表现优于许多参与者的现象。

FL中的激励机制最终应该在模型精度、训练速度、通信开销、计算成本等方面提高FL的性能。

从技术角度总结了最先进的激励机制。具体来说,我们分别介绍了,Stackelberg博弈,拍卖,合同,强化学习,区块链和其他技术的方案。

Shapley值

- 合作博弈理论中的Shapley值被FL的激励机制广泛采用,特别是用于贡献评价和利润分配。由于单个参与者的数据量与全局模型的精度之间不存在显式的线性关系,因此使用数据量的度量来直接评估其对每个参与者的贡献是不合理的。在此基础上,从效用和对协同培训的影响的角度,采用Shapley值来评估贡献。

- Song等人考虑到FL的特点,提出了两种基于梯度的方法来有效地计算不同企业参与者组合的模型效用。第一种方法称为基于一轮重建的算法,收集FL训练中的所有局部梯度,并在训练后重建所有模型以计算边缘贡献。另一种方法利用Shapley值的可加性计算每轮训练的贡献值,然后将它们聚合得到最终结果。这两种方法用局部梯度的额外存储来计算边际贡献,而不需要重新训练每个模型。

Stackelberg博弈

1、谁是领导者和追随者?

- Stackelberg博弈是博弈论中的一种序列模型,通常用于制定不同参与者在销售或采购共同产品时的相互作用,使其更适合FL中的激励设计,在Stackelberg博弈中,存在两类参与者,即,领导者和追随者领导者通过考虑追随者的预期反应将其利润优化。

- Stackelberg博弈是博弈论中的一种序列模型,通常用于制定不同参与者在销售或采购共同产品时的相互作用,使其更适合FL中的激励设计,在Stackelberg博弈中,存在两类参与者,即,领导者和追随者领导者通过考虑追随者的预期反应将其利润优化。

- 大多数研究认为FL生态系统是一个垄断市场,其中单个领导者是模型所有者或云服务器,而追随者是第二阶段进行古诺博弈的多个参与者。

2、FL中的“共同产品”是什么?

- Feng认为模型所有者使用移动的设备提供的学习服务,模型所有者在具有多个领导者的Stackelberg博弈的低层中充当单个跟随者

- Sarikaya采用Stackelberg博弈模型来激励多个工人的CPU供应,以减少具有完全同步SGD的FL中领导者的给定预算的本地培训时间。

- 类似地,Ding考虑了由计算速度,启动计算时间和分布式编码机器学习中的成本区分的多维产品。为了加速NE解的计算,他们巧妙地将多维特征转化为单一度量。其他令人印象深刻的产品包括本地培训准确性和数据隐私。

3、如何在完全信息和不完全信息情况下获得网元解决方案?

- 理论上可以在完全信息场景中使用逆向归纳法计算NE解

- 对于具有不完全信息和随机信息的实际情况,Ding发现NE解的计算复杂度随着额外的N(N−1)IC约束而增加[12]。他们不仅提出了最优策略,但也研究了工人的私人信息对NE解决方案的影响。

- Zhan认为参与者之间共享决策信息的假设在现实的物联网应用中并不成立,并且不准确的贡献评估会对激励机制设计产生负面影响。基于这些观察结果,他们提出了一种基于深度强化学习(DRL)的方案,以动态调整玩家的策略,并在信息不完整和贡献测量不明确的情况下优化他们的利润。

- 在最近策略优化(PPO)的DRL方案中,模型所有者分别使用行动者网络和评论者网络来维护其策略和估计值函数。此外,每个边缘节点训练具有高计算开销的复杂DRL模型,并使用离线训练模式在模拟环境中学习其最优策略。

拍卖

拍卖是另一种用于定价、任务分配、节点选择等的有效数学工具,并且它已被广泛用于无线电频谱分配、广告和计算机社区中的带宽分配。拍卖中,存在两种类型的参与者,即,拍卖人和投标人。由全局模型所有者或云服务器提供服务的单个拍卖人协调拍卖过程,而投标人是用各种本地资源和他们的出价响应拍卖人的参与者。拍卖的具体过程可以概括为公告、征集投标、确定赢家人以及其他一些辅助程序,如成交价格、信息披露等。

契约论

契约理论是研究在不同信息水平和利益冲突的情况下,参与者如何构建和发展最优协议的理论。在众多的合同类型中,公共采购合同是激励机制设计中被广泛采用的一种。在公共采购合同中,服务器向参与者提供一个合同菜单,在合同编写时不被告知参与者的私人成本,每个参与者主动选择为其类型设计的选项。公共采购合同具有自我揭示性,在信息不对称的情况下,这种自我揭示性能够促使参与方做出最优的采购安排。相反,由于参与者只能选择一个契约,信息披露的性能取决于契约列表的粒度。

强化学习

强化学习(RL)是一种迷人的深度学习技术,用于在连续的决策场景中接近最优解,其中代理反复观察环境,执行其动作以最大化其目标,并从环境中获得响应(通常称为奖励)。这对于FL中的激励设计是非常合适的。在FL训练中,模型所有者作为Agent执行节点选择或支付分配的动作,以吸引高质量的参与者加入FL的训练。智能体通过反复试验和错误来做出决策,并获得参与者的响应(视为奖励),以实现最佳的训练性能。

区块链

Bao采用区块链技术提供具有信任和激励属性的可审计联邦学习。这是另一项令人印象深刻的工作,为公共区块链上的FL提出了一种经济激励方法。给定轮中的工作者选择上一轮中工作者提交的模型更新,并使用这些模型参数使用本地数据训练自己的模型。每个工人投票前k个模型,智能合约计算工人在上一轮的投票计数。奖金是根据票数分配的。提出了一个承诺方案,以防止恶意参与者简单地复制和报告其他人的输出,并提供了一个激励策略游戏,以激励参与者正确的行为。

论文题目:Blockchain Assisted Decentralized Federated Learning (BLADE-FL) with Lazy Clients(区块链辅助分散联邦学习(BLADE-FL)与懒惰客户端)

期刊:arXiv:2012.02044 [cs.LG]

作者:Jun Li, Yumeng Shao, Ming Ding, Chuan Ma, Kang Wei, Zhu Han, H. Vincent Poor

时间:2 Dec 2020

解决问题:由于懒惰的客户端剽窃他人的训练模型并添加人工噪声来隐藏他们的作弊行为

如何解决:我们首先开发了一个收敛界的损失函数与懒惰的客户端的存在,并证明它是凸的生成块的总数K。然后,我们通过优化K来最小化损失函数来解决凸问题。此外,我们发现的最佳K,懒惰的客户端的数量,和懒惰的客户端使用的人工噪声的功率之间的关系。我们进行了广泛的实验,以评估所提出的框架使用MNIST和时尚MNIST数据集的性能。

创新点:

- 提出了一种新的区块链FL框架,称为BLADE-FL,它具有良好的性能,隐私保护,有效的合作学习。

- 对存在懒惰客户端的损失函数的上界进行理论分析,以评估BLADE-FL的学习性能,并证明它相对于生成的块的总数K是凸的。

- 通过优化K来最小化损失函数来解决凸问题,并进一步发现最佳K,懒惰客户端数量和人工噪声功率之间的关系。

论文题目:Blockchain-Based Federated Learning: Incentivizing Data Sharing and Penalizing Dishonest Behavior(基于区块链的联邦学习:激励数据共享和惩罚不诚实行为)

期刊:IEEE Transactions on Pattern Analysis and Machine Intelligence

作者:Amir Jaberzadeh, Ajay Kumar Shrestha, Faijan Ahamad Khan, Mohammed Afaan Shaikh, Bhargav Dave and Jason Geng

时间:2022

解决问题:数据治理是管理数据的常用方法,但它面临着许多挑战,如数据孤岛,数据一致性,隐私,安全性和访问控制。

如何解决:

- 本文提出了一个综合框架,将联邦学习中的数据信任与星际文件系统、区块链和智能合约相集成,以促进安全和互利的数据共享,同时提供激励、访问控制机制并惩罚任何不诚实的行为。

- 该研究论文还提出了一个分散的联邦学习平台,该平台使多个工作人员能够同时训练模型,同时保持数据隐私和安全性。分散的架构和区块链技术的使用允许工人之间的有效沟通和协调。

- 该平台有可能促进分散的机器学习,并支持各个领域的隐私保护协作。

创新点:

- 论文提出的模型在保证数据共享过程的安全性和公平性的同时,有效地提高了联邦学习模型的准确性。

- 促进分散的机器学习,并支持各个领域的隐私保护协作。

这篇关于激励机制相关论文的阅读的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!