本文主要是介绍nerfstudio/sdfstudio 三维重建使用教程,希望对大家解决编程问题提供一定的参考价值,需要的开发者们随着小编来一起学习吧!

Nerf作为三维重建的未来,最近引起大为广泛的关注。Nerfstudio 提供了一个简单友好的 API,可以简化创建、训练和测试 NeRF 的端到端过程。该库通过模块化每个组件来支持更可解释的 NeRF 实现。通过更多模块化的NeRF,在探索该技术时创造更加用户友好的体验。

更进一步的,构建在强大的nerfstudio之上的SDFStudio 是一个统一的模块化框架,用于神经隐式表面重建,该库提供了三种主要隐式曲面重建方法的统一实现:UniSurf、VolSDF 和 NeuS。SDFStudio 支持各种场景表示,例如 MLP、三平面和多分辨率;特征网格和多点采样策略,例如 UniSurf 中的曲面引导采样和 NeuralReconW 中的体素曲面引导采样。它进一步集成了该领域的最新进展,例如单目线索的利用(MonoSDF)、几何正则化(UniSurf)和多视图一致性(Geo-NeuS)。由于统一和模块化的实现,SDFStudio 可以轻松地将想法从一种方法转移到另一种方法。例如,Mono-NeuS 将 MonoSDF 中的想法应用于 NeuS,而 Geo-VolSDF 将 Geo-NeuS 中的想法应用于 VolSDF。

本文记录根据sdfstudio官方文档教程的操作步骤:

- conda创建环境

conda create --name sdfstudio -y python=3.9 #官方文档为3.8,也可以更高版本

conda activate sdfstudio

python -m pip install --upgrade pip

- 安装torch cuda

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 -f https://download.pytorch.org/whl/torch_stable.html上述两步在正常网络下,不会出现什么问题。

3. 安装tinycudann

该步容易出现问题,最简单的安装是如下指令:

pip install git+https://github.com/NVlabs/tiny-cuda-nn/#subdirectory=bindings/torch

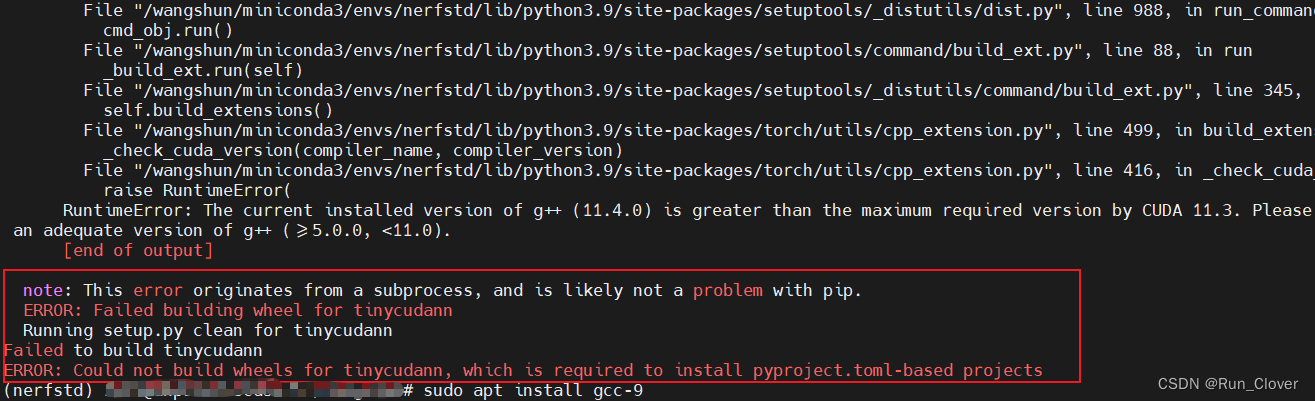

在笔者十多次的测试中,上述指令只有一次顺利通过。其余均出现:

针对该问题,笔者单独写了解决方案。

4. 安装sdfstudio

git clone https://github.com/autonomousvision/sdfstudio.git

cd sdfstudio

pip install --upgrade pip setuptools

pip install -e .

# install tab completion

ns-install-cli

如果前三步执行成功,该步一般不会出现问题。

5. 前四步成功配置好环境,现在开始进行三维重建测试

- 利用官方开源数据

# Download some test data: you might need to install curl if your system don't have that

ns-download-data sdfstudio# Train model on the dtu dataset scan65

ns-train neus-facto --pipeline.model.sdf-field.inside-outside False --vis viewer --experiment-name neus-facto-dtu65 sdfstudio-data --data data/sdfstudio-demo-data/dtu-scan65# Or you could also train model on the Replica dataset room0 with monocular priors

ns-train neus-facto --pipeline.model.sdf-field.inside-outside True --pipeline.model.mono-depth-loss-mult 0.1 --pipeline.model.mono-normal-loss-mult 0.05 --vis viewer --experiment-name neus-facto-replica1 sdfstudio-data --data data/sdfstudio-demo-data/replica-room0 --include_mono_prior True

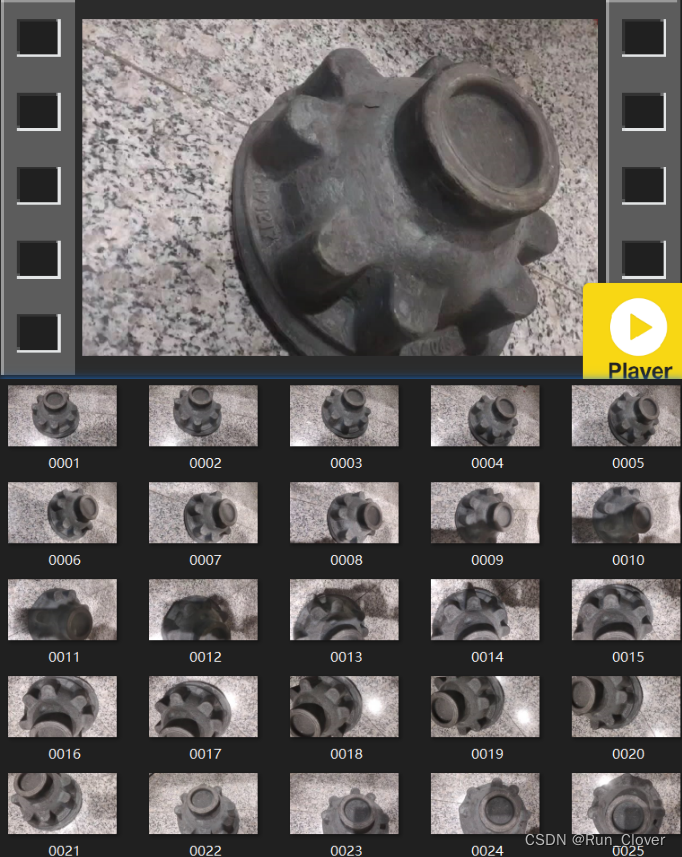

- 个人录制视频,定制数据集

sdfstudio支持视频输入,但笔者测试的图像集,可以利用ffmpeg将上述视频抽帧为图像集:

ffmpeg -i dome.mp4 -r 1 -f image2 dome/%04d.png

6. 转换数据格式

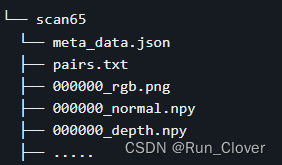

sdfstudio指定了标准的数据模式:

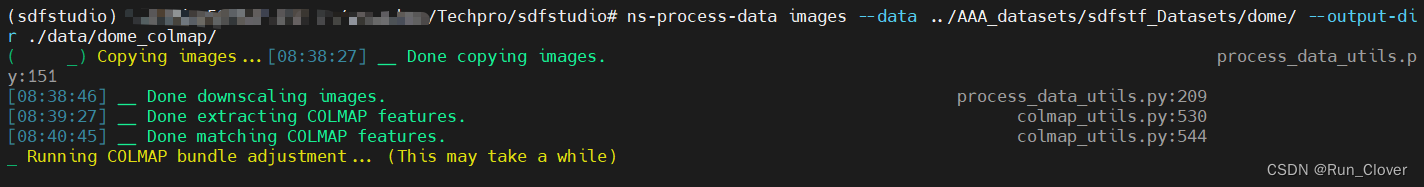

在上述个人定制数据集中,只有rgb图像,可以通过sdfstudio中自带的ns-process-data来进行数据预处理:

ns-process-data images --data ./data/dome/ --output-dir ./data/dome_colmap/

ns-process-data会调用colmap提取匹配特征,构建点云,得到相机位姿,输出transform.json文件。colmap有多种安装方式,最简单指令为:

conda install -c conda-forge colmap

可能需要科学上网,笔者通过该指令安装成功。也可以测试其他方式。ref1 ref2

colmap安装成功后,执行上述指令即可:

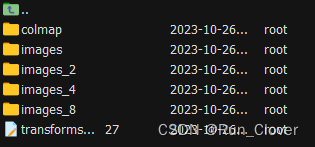

dome_colmap文件夹中为:

上述数据结构还不是sdfstudio指定的结构,还需要进一步处理

7. process_nerfstudio_to_sdfstudio

可以简单的执行下述指令得到可以处理的sdfstudio数据结构:

python scripts/datasets/process_nerfstudio_to_sdfstudio.py --data ./data/dome_colmap/ --output-dir ./data/dome_sdfs/ --data-type colmap --scene-type object该指令输出的结果中缺失标准数据结构中的normal depth。为了得到每个图像的normal和depth,需要安装omnidata

下载源代码和预训练模型:

https://github.com/EPFL-VILAB/omnidata.gitsh ./tools/download_depth_models.sh

sh ./tools/download_surface_normal_models.sh接着在虚拟环境sdfstudio中安装omnidata/omnidata_tools/torch/requirements.txt指定的第三方库,从而保证可以正确执行omnidata中的程序。实际上requirements中要求的库,sdfstudio已经具有,可以通过conda list来考察还缺少哪些库,再逐步安装即可,安装的版本也无需按照requirements中所指定的。

pip install -r requirements.txt # 根据conda list删除已经有的库

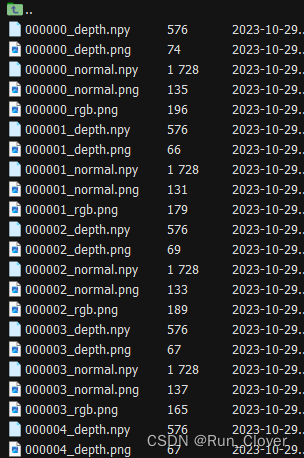

执行下述指令,即可得到带normal depth的数据结构:

python scripts/datasets/process_nerfstudio_to_sdfstudio.py --data ./data/dome_colmap/ --output-dir ./data/dome_sdfs/ --data-type colmap --scene-type object --omnidata-path ../omnidata/omnidata_tools/torch/ --pretrained-models ../omnidata/omnidata_tools/torch/pretrained_models/ --mono-prior # omnidata路径自行调整

如果出现图像尺寸不一致问题,直接将 assert所在的语句注释即可。

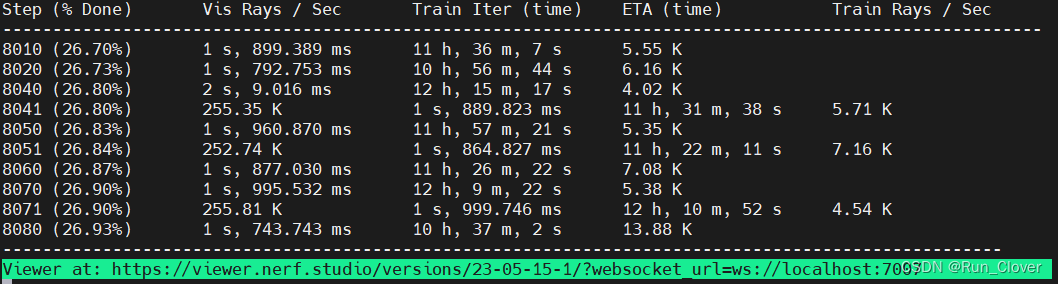

- 开始训练

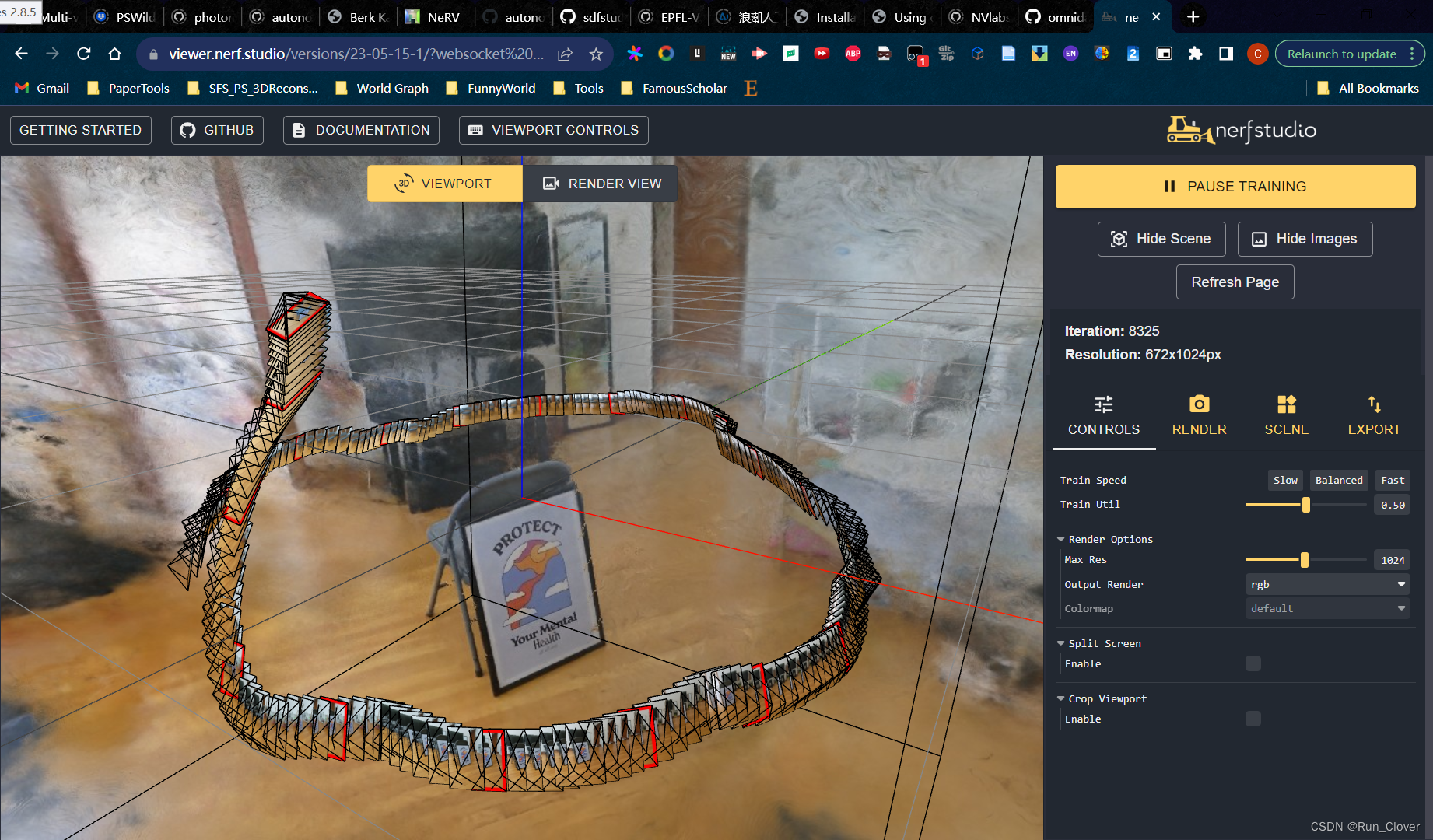

ns-train neus-facto --pipeline.model.sdf-field.inside-outside False --vis viewer sdfstudio-data --data ./data/dome_sdfs/

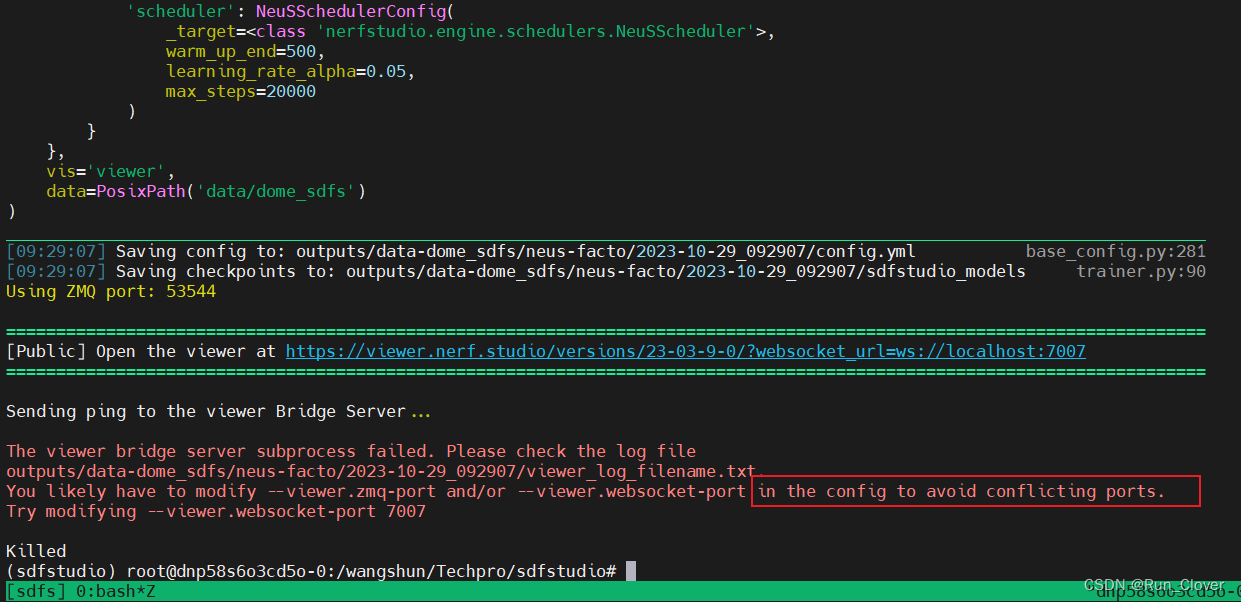

笔者写这篇博客时正在运行nerfstudio中数据,上述训练迭代正是nerfstudio过程,当再执行上述sdfstudio训练时,就会报如下端口冲突错误:

后续可以更改端口,同时执行nerfstudio和sdfstudio。

因为服务器无法打开浏览器,可以通过端口映射,在本地查看训练过程。

ssh -L 7007:localhost:7007 -p port username@IP

笔者训练过程中发现,自己的训练速度远慢于官方文档,官方所用显卡为3090,笔者所用服务器显卡为A100,理论上要更快,背后原因笔者还在排查,欢迎各位批评指正!

- mesh and render

# extract mesh

ns-extract-mesh --load-config outputs/neus-facto-dome/XXX/config.yml --output-path meshes/neus-facto-dome.ply # config.yml路径自行调整,训练结果保存在outputs中# render

ns-render-mesh --meshfile meshes/neus-facto-dome.ply --traj interpolate --output-path renders/neus-facto-dome.mp4 sdfstudio-data --data data/dome_sdfs/

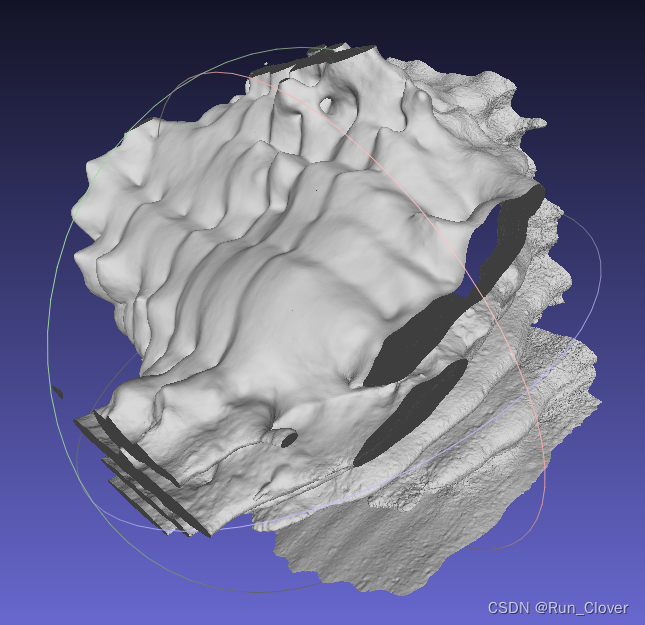

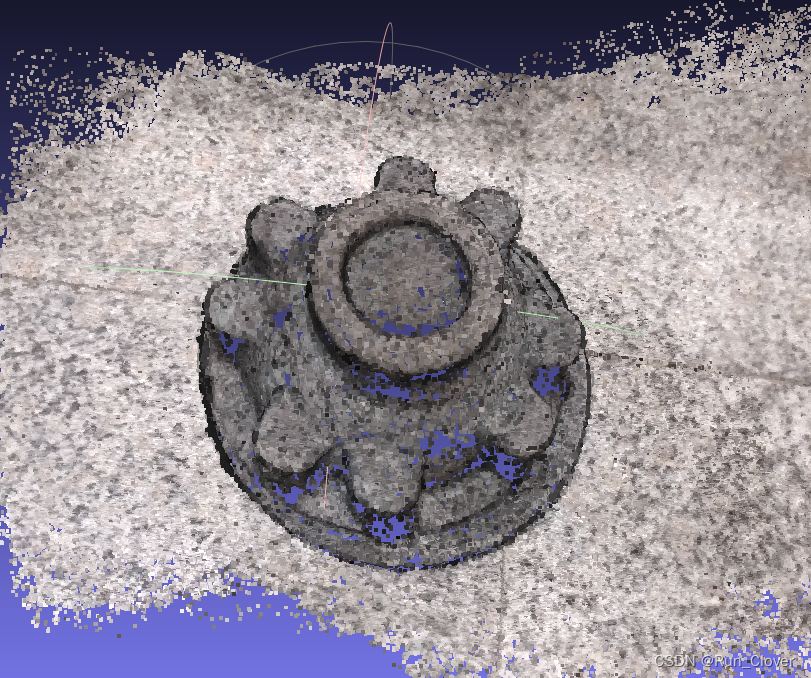

训练得到的dome点云如下,与实际图像大相径庭(一波三折后还是这个结果,一时接受不了):

结果还没有直接利用colmap重建的好:

考虑到基于nerf的训练方法涉及的参数细节较多,后续需要进一步排查原因,欢迎批评指正。

这篇关于nerfstudio/sdfstudio 三维重建使用教程的文章就介绍到这儿,希望我们推荐的文章对编程师们有所帮助!