2019独角兽企业重金招聘Python工程师标准>>>

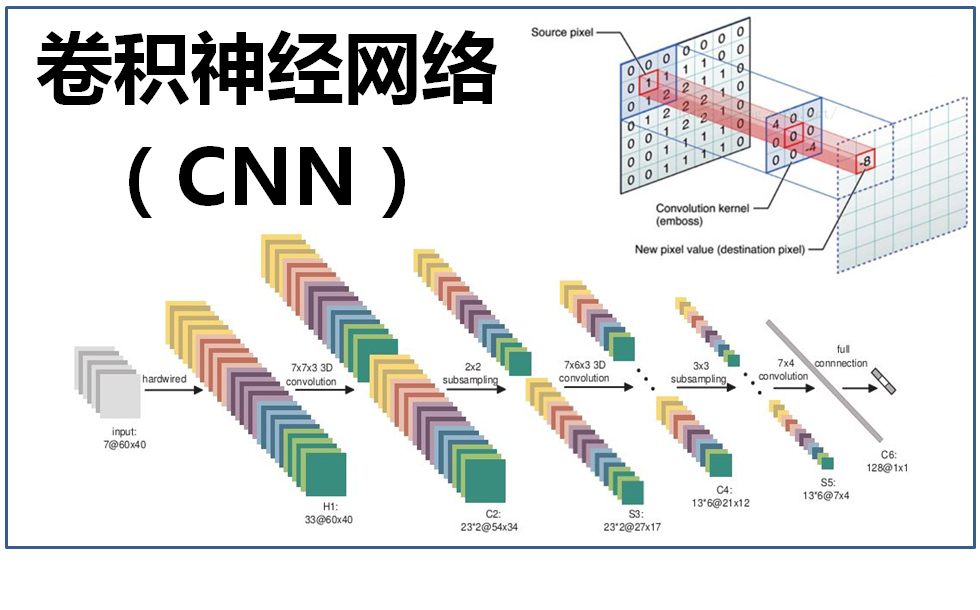

卷积神经网络(CNN)近年来取得了长足的发展,是深度学习中的一颗耀眼明珠。CNN不仅能用来对图像进行分类,还在图像分割(目标检测)任务中有着广泛的应用。CNN已经成为了图像分类的黄金标准,一直在不断的发展和改进。

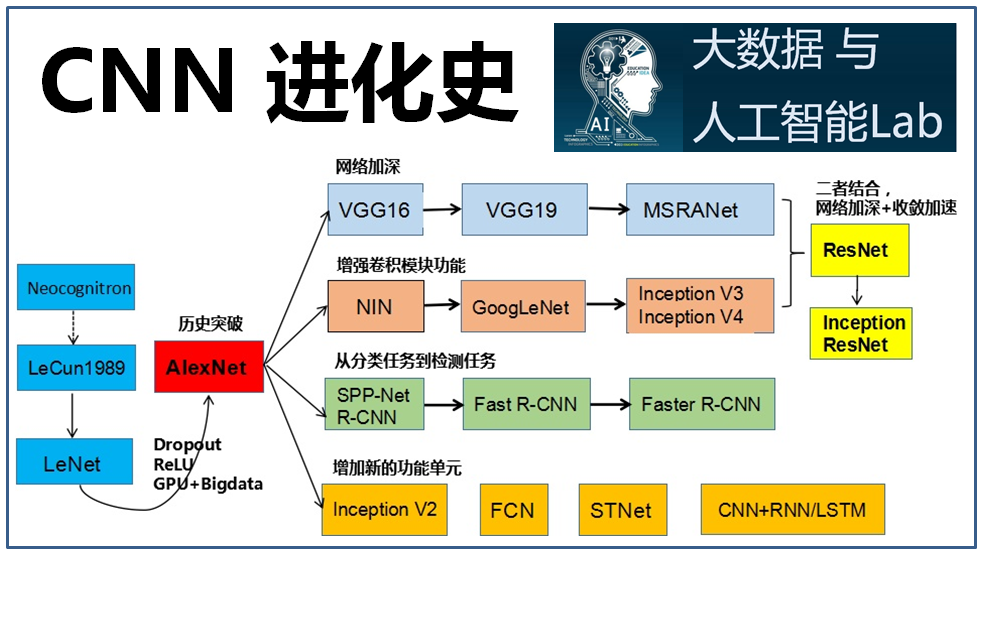

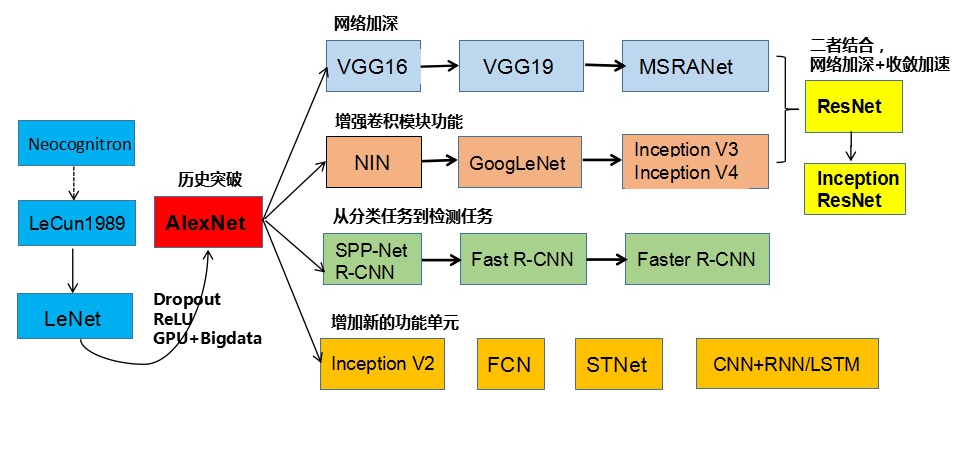

刘昕博士总结了CNN的演化历史,如下图所示:

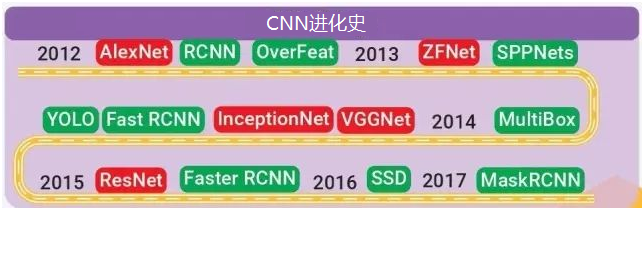

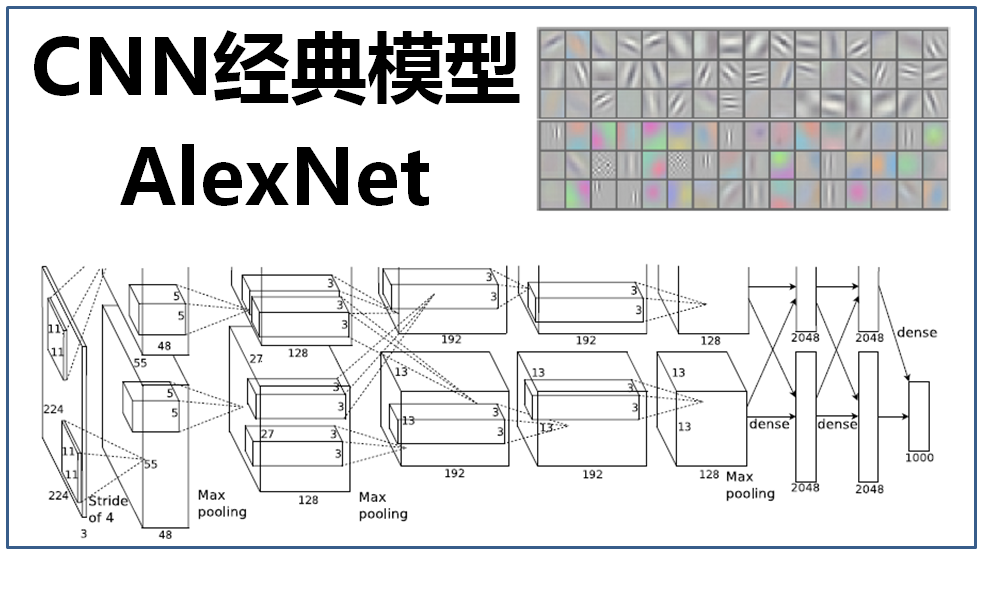

CNN的起点是神经认知机模型,此时已经出现了卷积结构,经典的LeNet诞生于1998年。然而之后CNN的锋芒开始被SVM等模型盖过。随着ReLU、dropout的提出,以及GPU和大数据带来的历史机遇,CNN在2012年迎来了历史突破:AlexNet。随后几年,CNN呈现爆发式发展,各种CNN模型涌现出来。

CNN的主要演进方向如下:

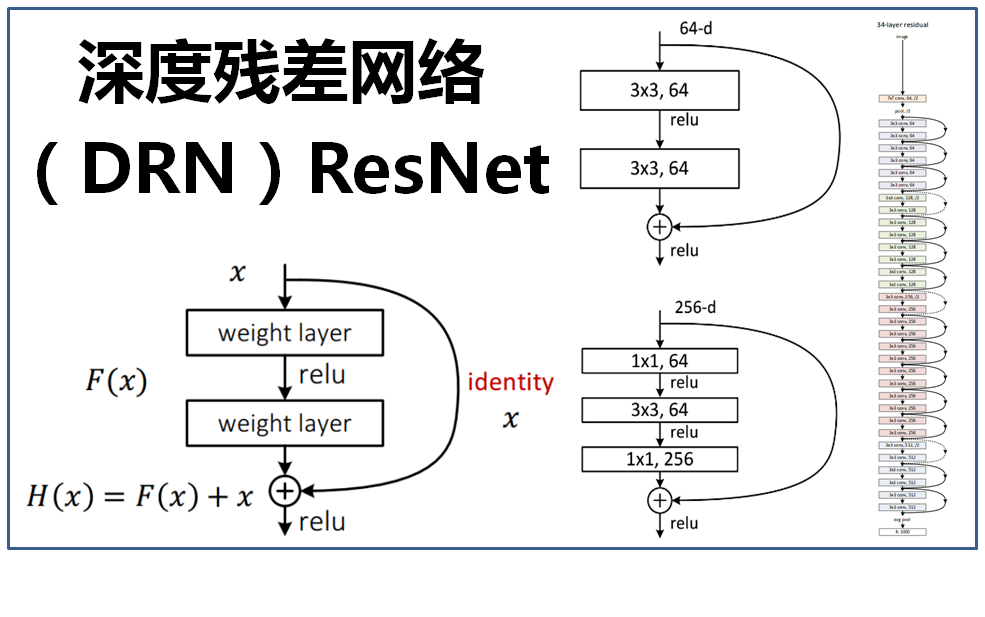

1、网络结构加深

2、加强卷积功能

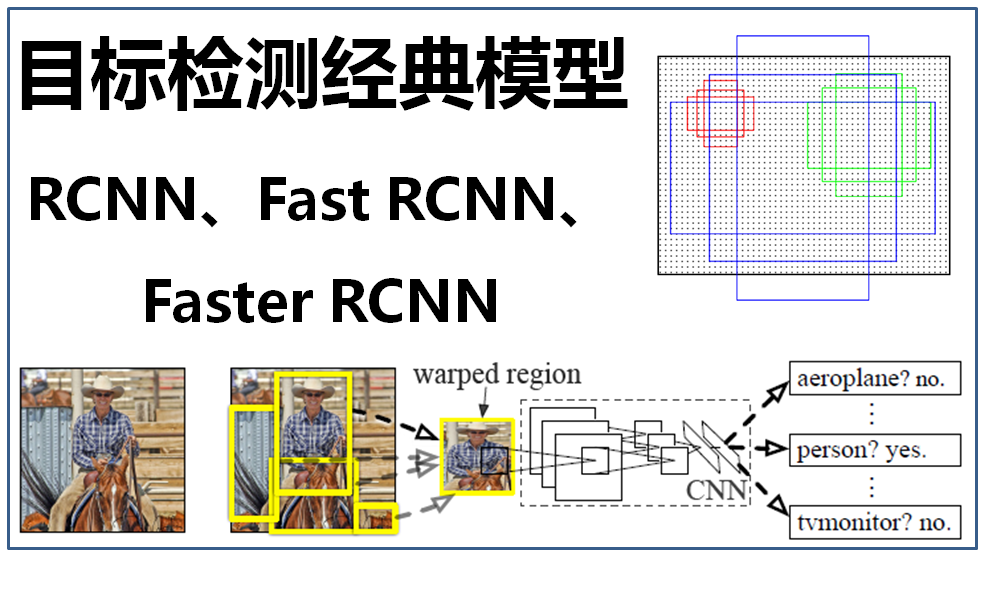

3、从分类到检测

4、新增功能模块

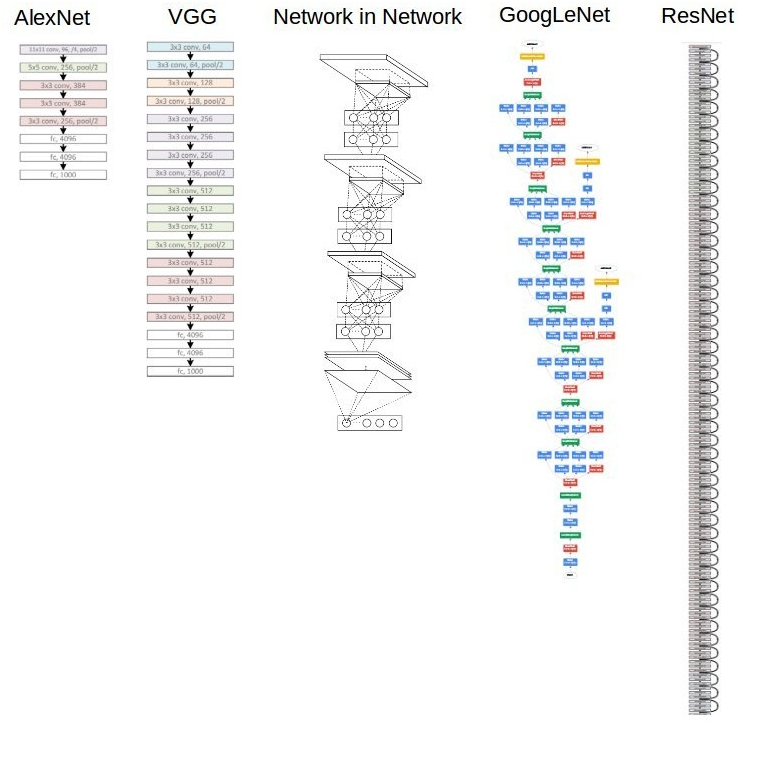

下图是CNN几个经典模型(AlexNet、VGG、NIN、GoogLeNet、ResNet)的对比图,可见网络层次越来越深、结构越来越复杂,当然模型效果也是越来越好:

本博客通过一系列的“大话深度学习”文章,全面详细地介绍了CNN进化史各个阶段的里程碑成果。

1、小白讲卷积:大话卷积神经网络(CNN)

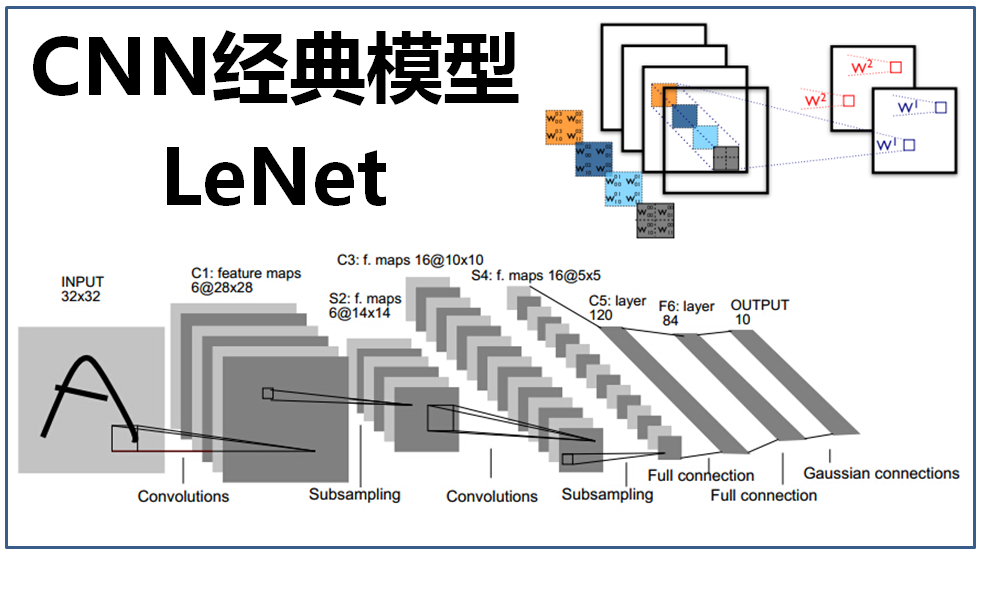

2、卷积初尝试:大话CNN经典模型 LeNet

3、历史の突破:大话CNN经典模型 AlexNet

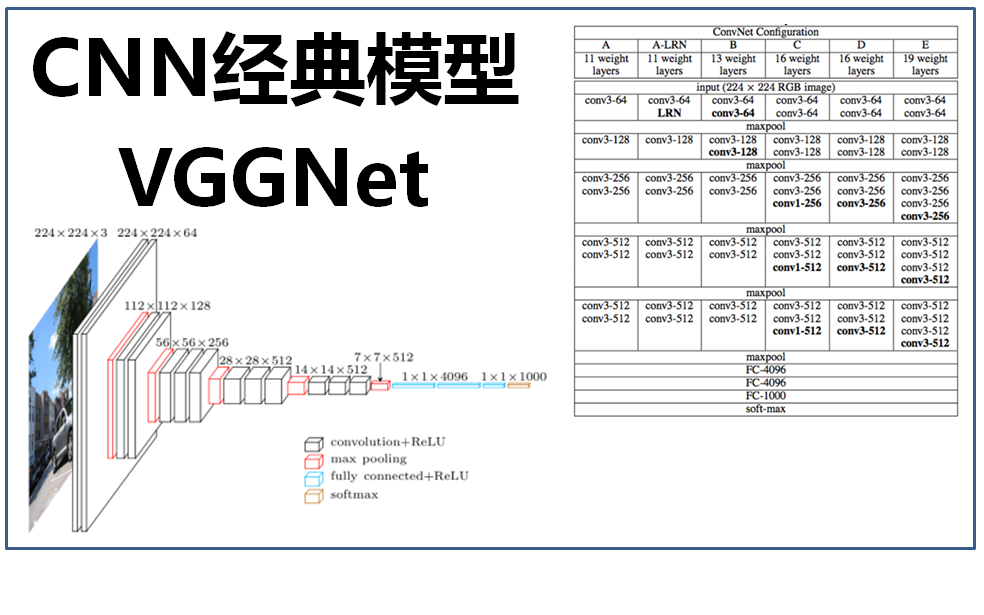

4、网络再加深:大话CNN经典模型VGGNet

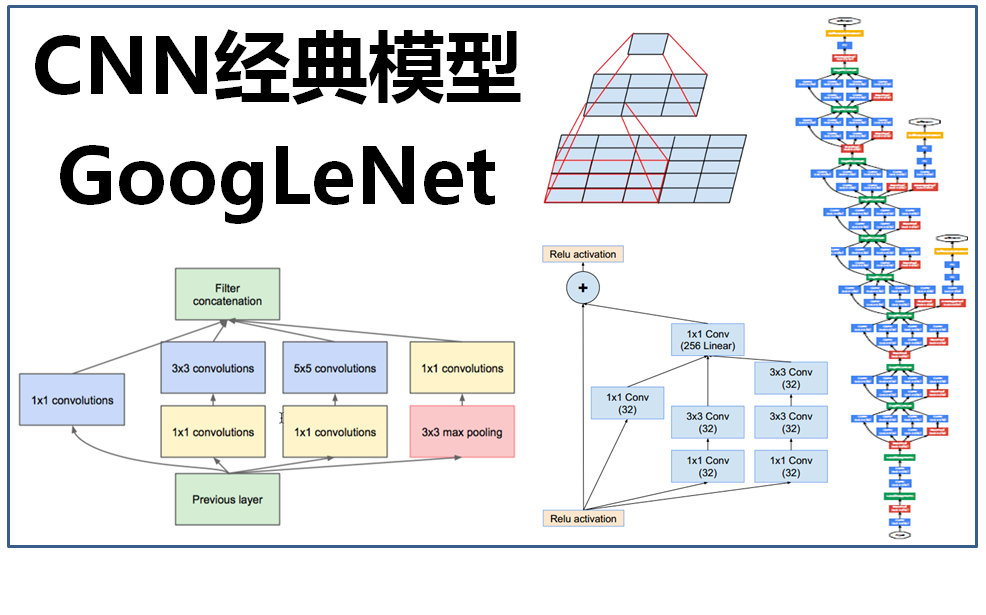

5、增强卷积功能:大话CNN经典模型GoogLeNet

6、从分类到目标检测:大话目标检测模型(R-CNN、Fast R-CNN、Faster R-CNN)

7、网络深度创历史:大话深度残差网络(ResNet)

要真正深入了解学习这些CNN经典模型,最好的办法是仔细阅读相应的论文。欢迎关注公众号“大数据与人工智能Lab”(BigdataAILab),里面收集整理了CNN各种模型的经典论文

关注本人公众号“大数据与人工智能Lab”(BigdataAILab),然后回复“论文”关键字可在线阅读经典论文的内容。